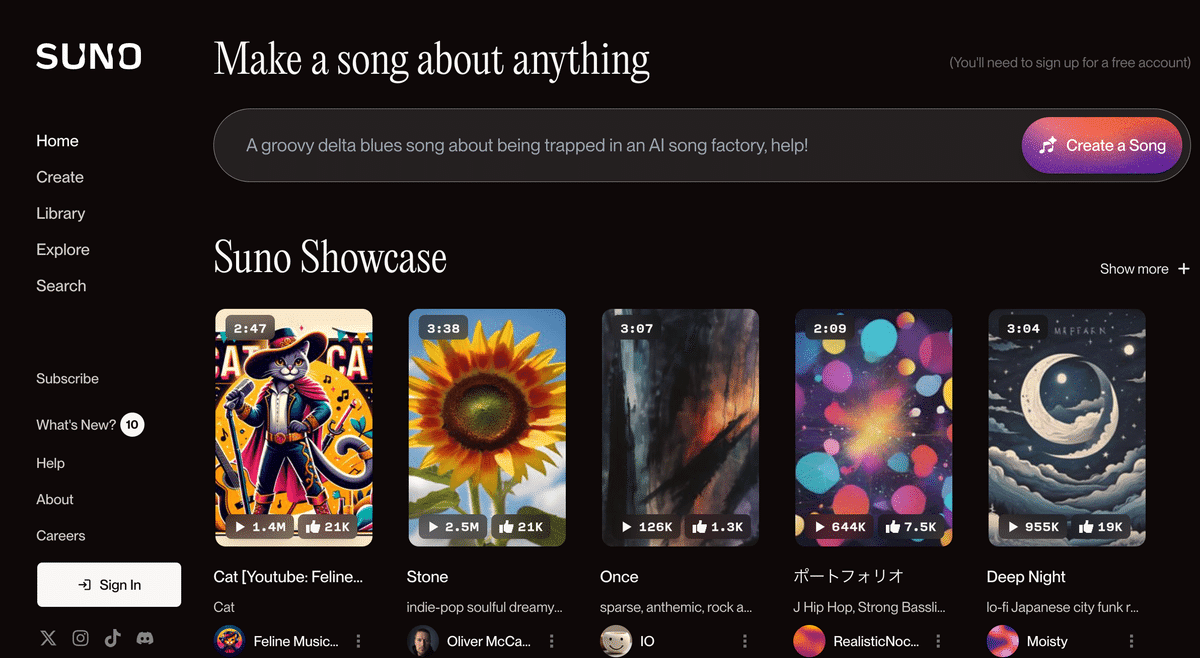

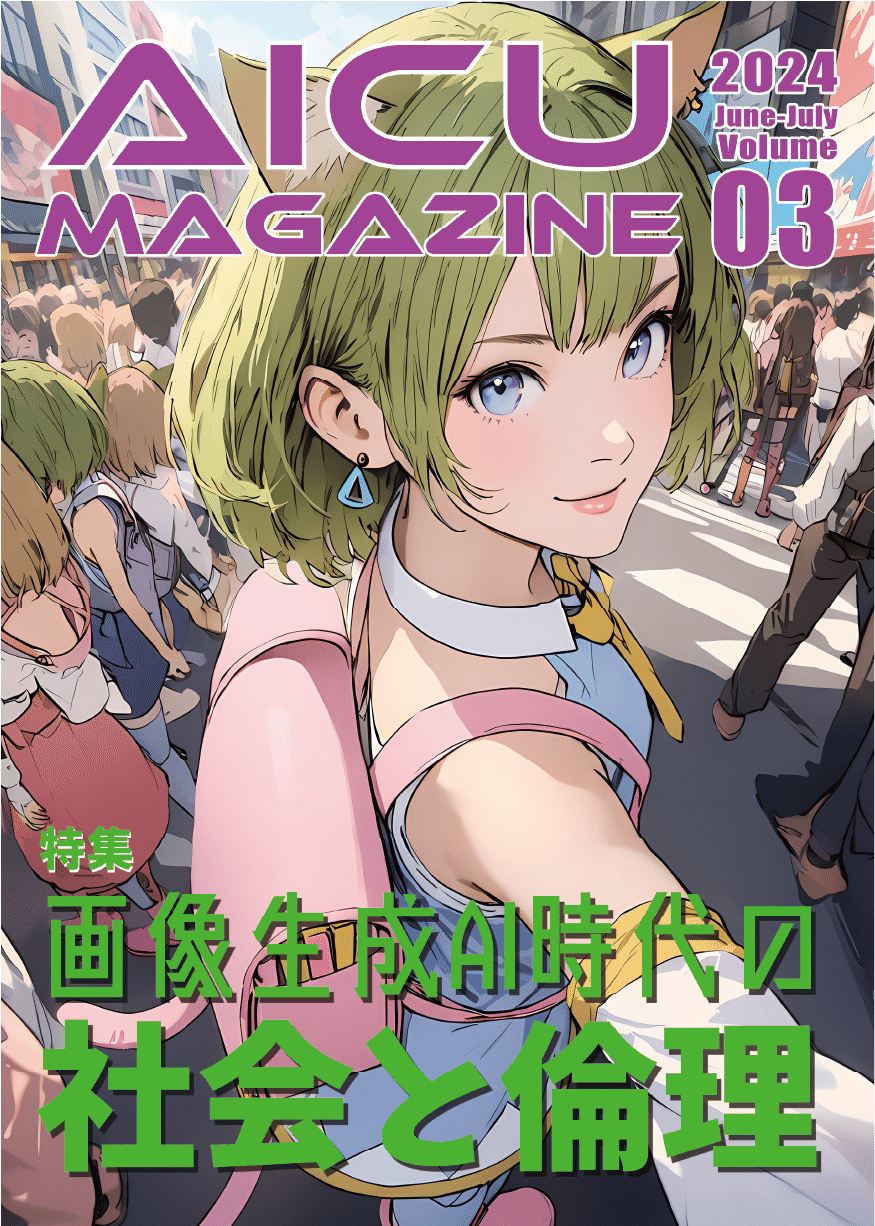

生成AIの常識を覆した「Stable Diffusion」の革命から2年…「つくる人をつくる」AICUが世界を舞台に大型新作をリリース!

クリエイティブAI時代に「つくる人をつくる」をビジョンに活動する生成AIの最先端を走り続けるクリエイターユニオン「AICU」が、Stable Diffusionによる最新・最先端・最高品質の画像生成の基礎から応用までを丁寧に解説するオンライン講座を国際的なラーニングプラットフォーム「コルソ」で開講します!

▼ Coloso講座ページはこちら ▼

https://j.aicu.ai/AICUXColosoJP

「画像生成AIって難しそう…」

そんな風に思っていませんか?

この講座は、AI初心者の方でも安心して学べるよう、AICUが開発した特別なカリキュラムに基づいて構成されています。

ゼロからスタートし、AI初心者から次の一歩を踏み出すことができるカリキュラムを、Colosoで体験してください!

【本講座で得られる3つのメリット】

- AI時代の必須スキル「プロンプトエンジニアリング」を基礎から習得

- 生成AIを使いこなすための「呪文」、プロンプト。高品質、高画質な画像生成が可能になった今、隠されたテクニックは従来とは大きく変わっています。

- 最新の商用利用可能なStability AI API公式サンプルを使って学ぶことで、 Stable Diffusion 3 時代のポテンシャルを最大限に引き出し、思い通りの画像を生成できるようになります。

- 単語の選び方や順番といった基本文法から、シードやスタイルといったAPIならではの制御手法、未知のモデルとの対話テクニックなど、2年分のノウハウを体系的に詰め込んだ、先駆者ならではの『勝ち筋』を、入門者からプロフェッショナルに向けて優しく解説します。

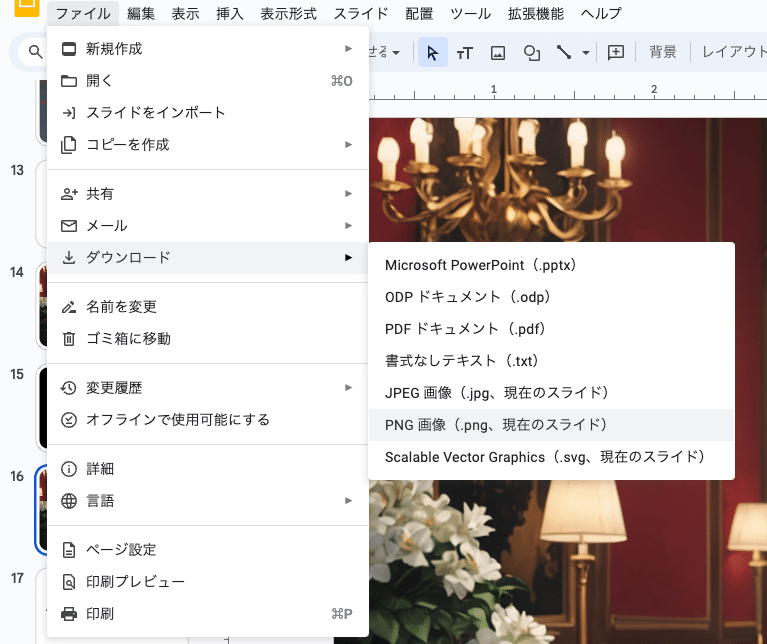

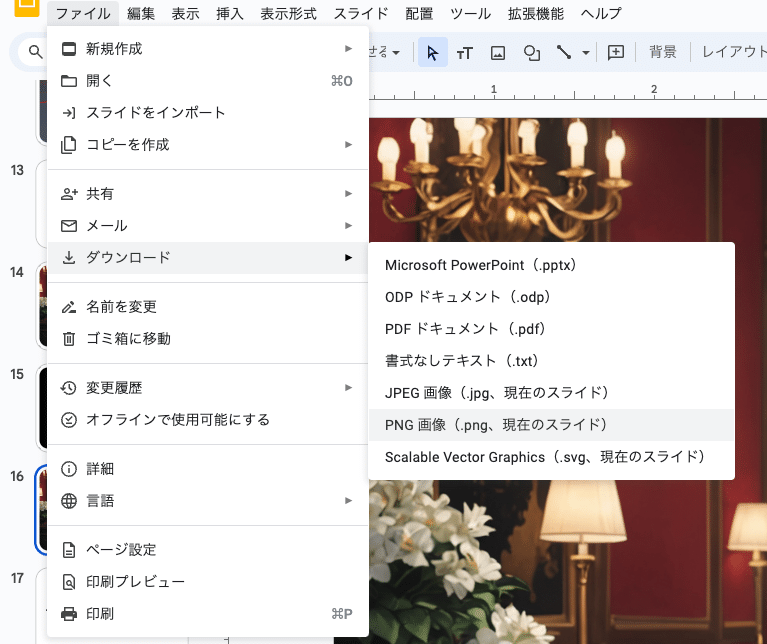

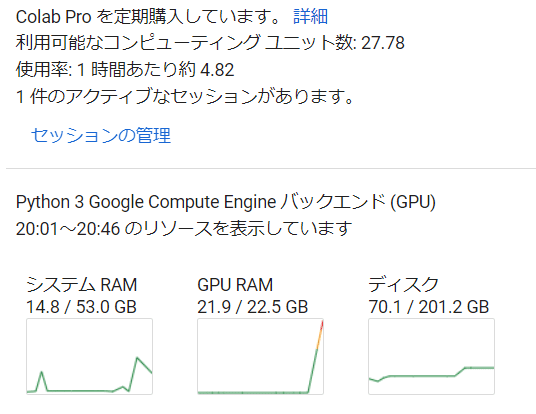

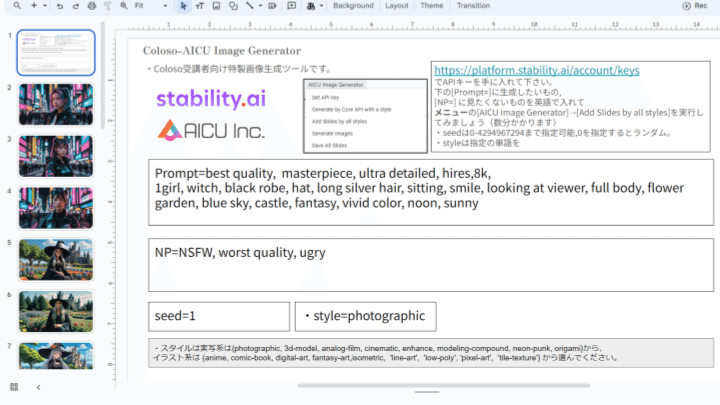

- Google Colab & Slidesで、コードを書かずに実践的なスキルを習得

- Google Colab & Slidesで開発された専用ツールを提供。

- 専門知識不要! 環境構築でつまずくことなく、すぐに実践できます。

- オープンソースなので改造もカンタン。商用も今すぐできます。

- APIとツールを使って制御しながらプロフェッショナルな画像を大量に生成する実用的な解説、サンプル、プロンプト集。

- バーチャルファッションモデル制作や広告バリエーション展開など、 すぐに使える実践的なスキルが身につきます。

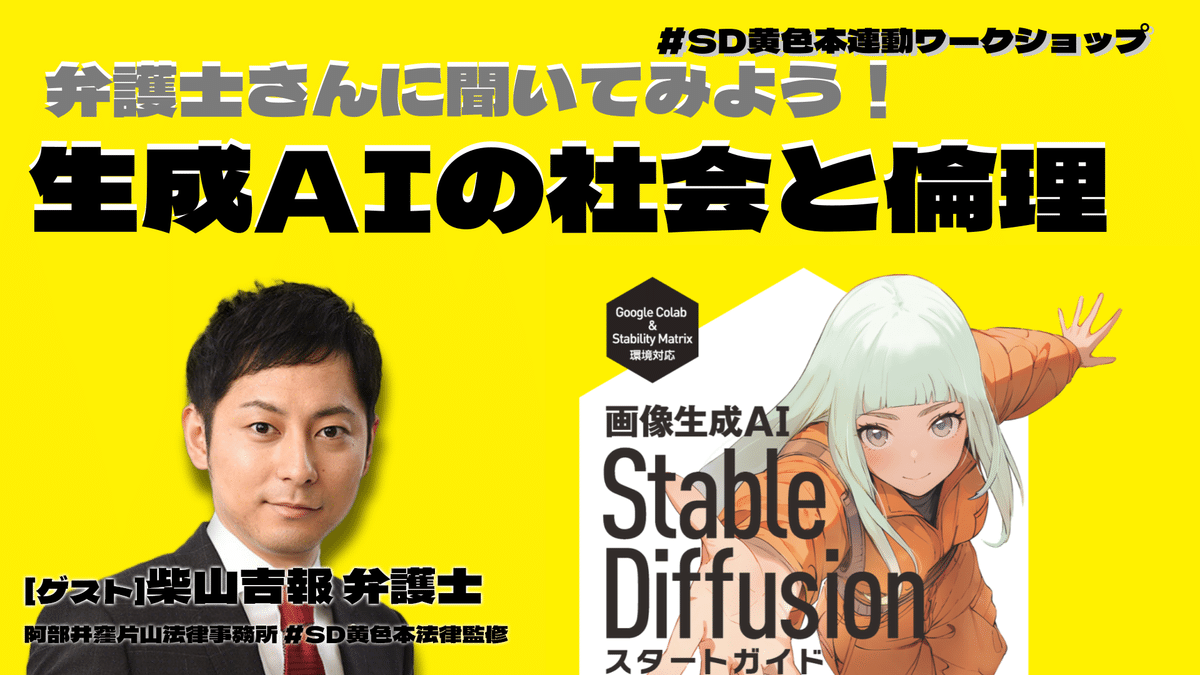

- 生成AI時代に必要な著作権や倫理に関する知識も網羅

- AI作品と著作権、倫理的な問題など、知っておくべき重要な知識を丁寧に解説します。

- 責任あるクリエイターとして、自信を持って活動するための社会基盤としての常識を築きます。

- 生成AIに関するクリエイティブの倫理課題を人に教えられるレベル、サービスやプロダクトを開発し、契約できるレベルまで高めましょう

▼ Coloso講座ページはこちら ▼

https://j.aicu.ai/AICUXColosoJP

【講座内容】

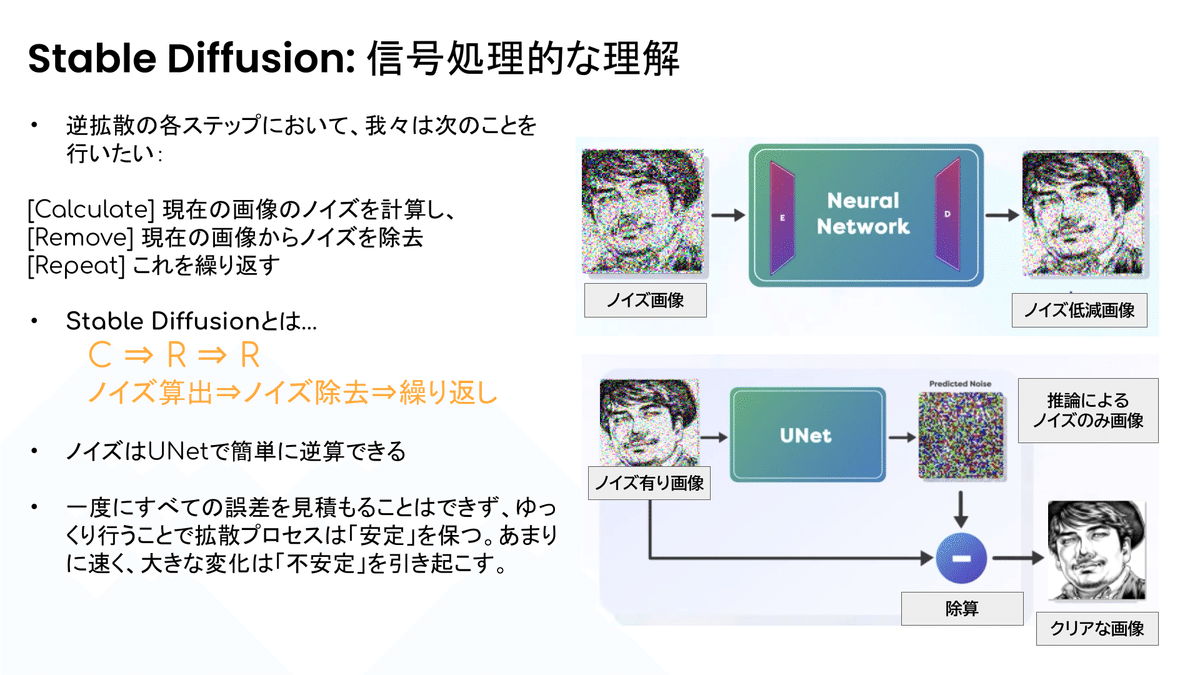

- 生成AIの基礎知識

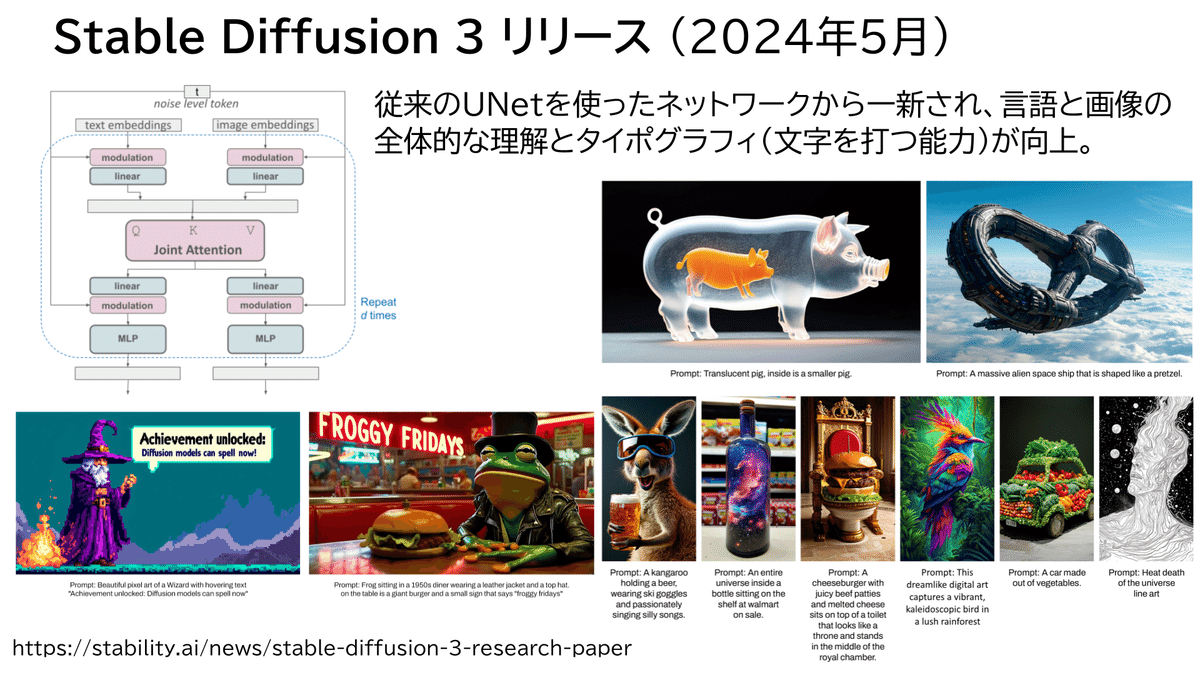

- Stable Diffusion 3の仕組みと特徴

- プロンプトエンジニアリング入門

- Stability AI APIを活用した高度な画像生成

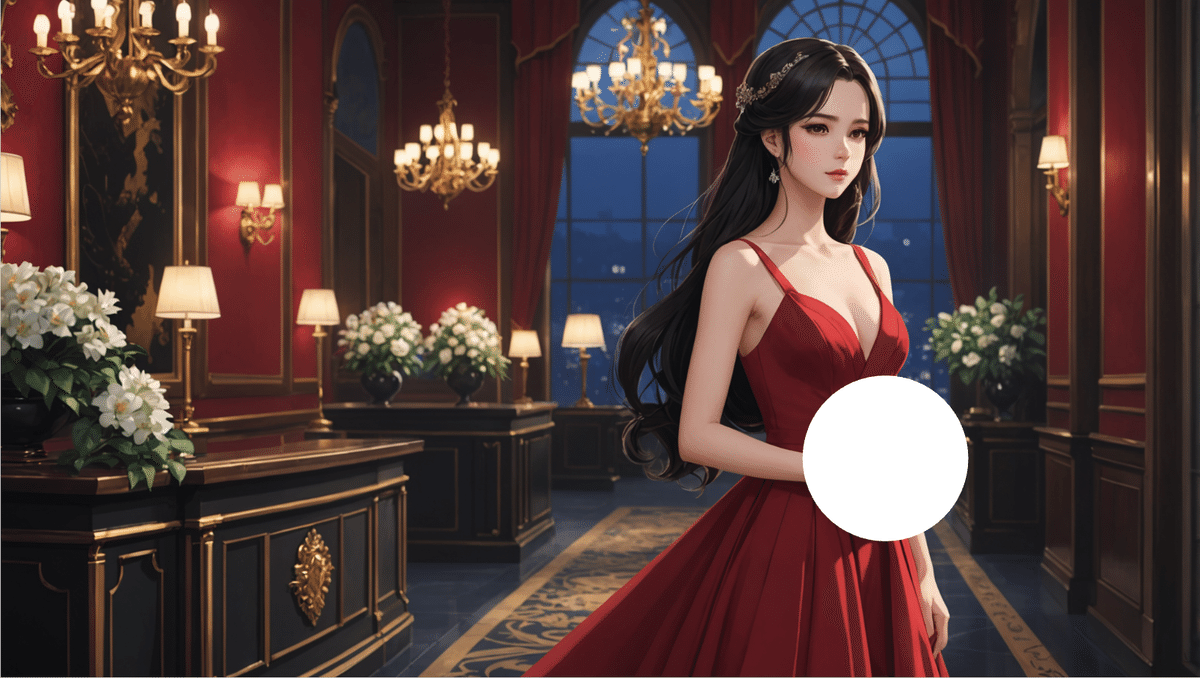

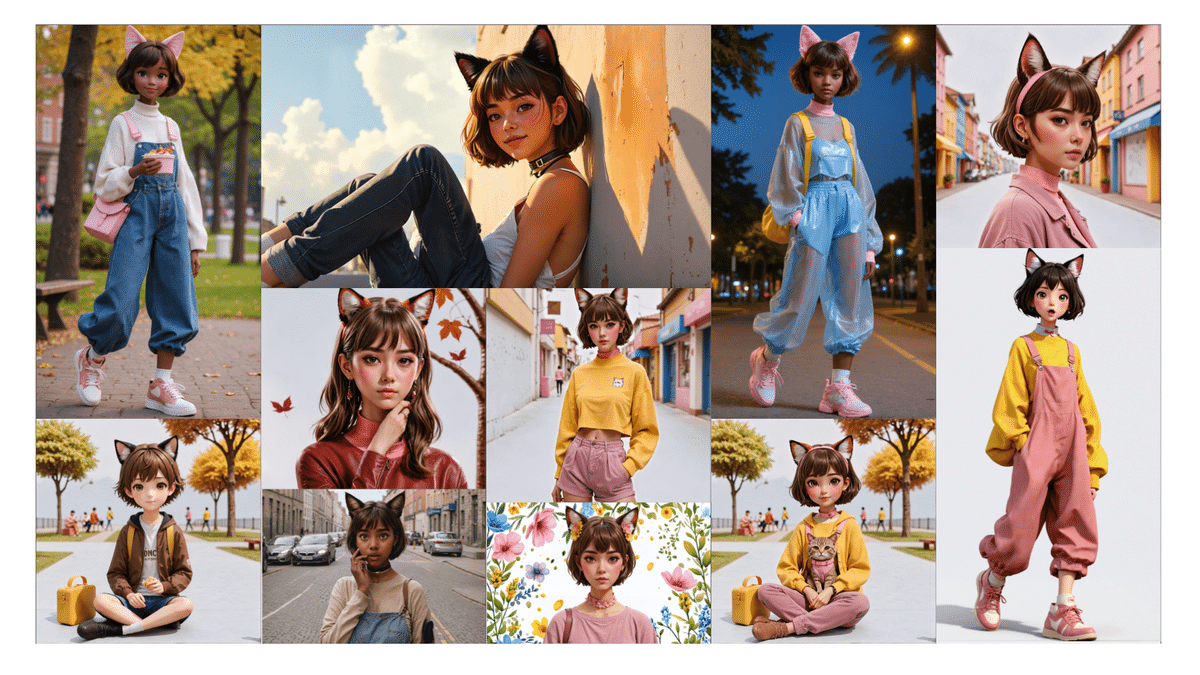

- バーチャルファッションモデルの開発

- AI技術を駆使した広告制作

- AIの活用における倫理と未来予測

使用プログラム

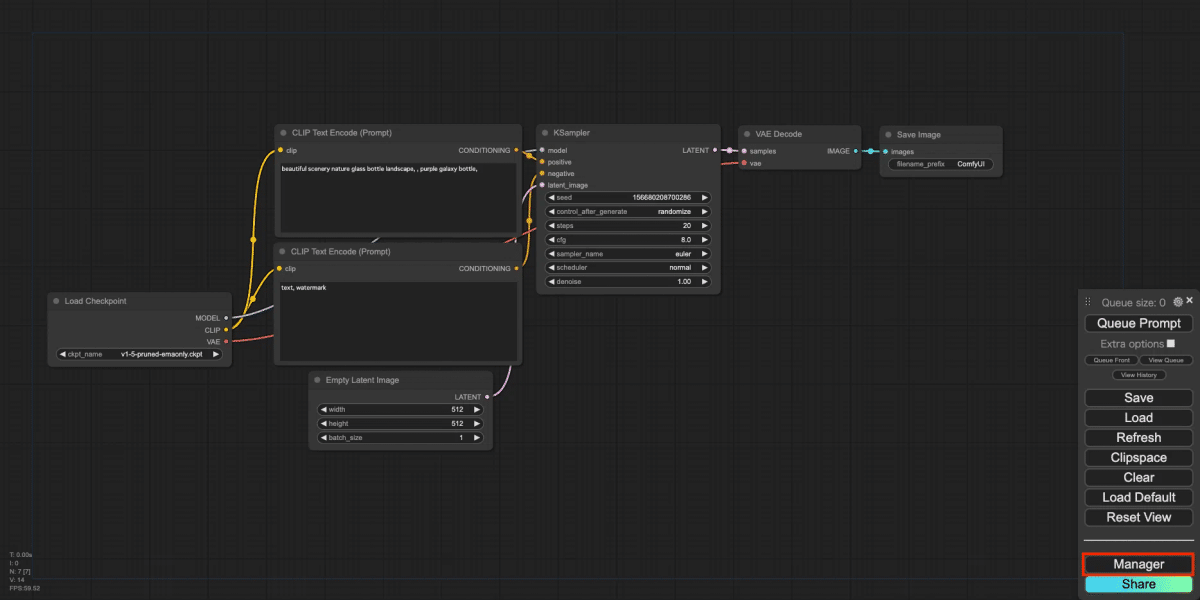

[メインツール]

– Stability AI API

– Google Colab

– Google Workspace

【こんな方におすすめ】

- 画像生成AIに興味があるけど、何から始めればいいか分からない方

- Stable Diffusionをもっと使いこなしたい方

- これからの時代を見据え、AIスキルを身につけておきたい方

- デザイン、アート、広告など、クリエイティブな仕事に携わっている方

- 業務的な画像生成AIを体系的に学ぶ必要が出てきた企業クリエイター

- 新しい技術を学び、自分の可能性を広げたい方

【AICU開発! 本講座だけの特典】

- AICUによる画像生成AIに必要な知識が詰まった講座動画25講を期間制限なしで受講可能

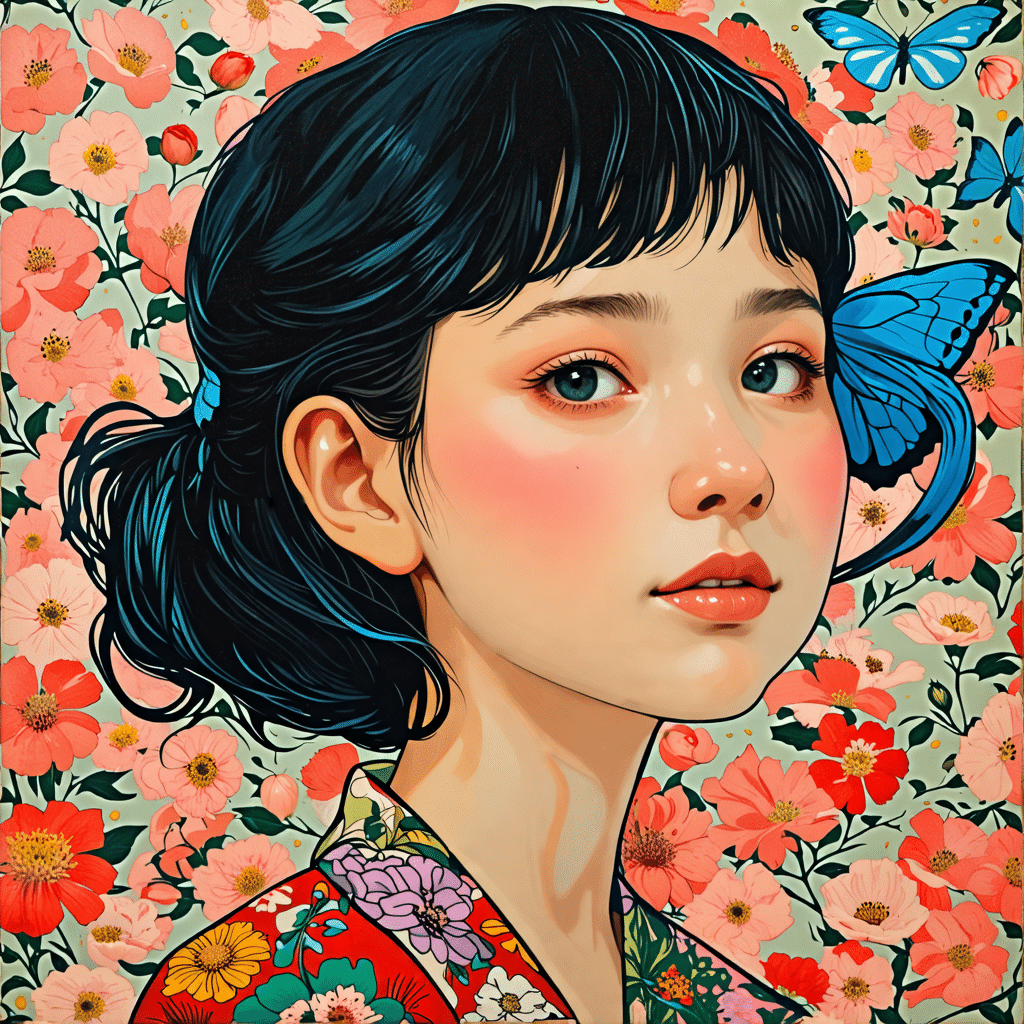

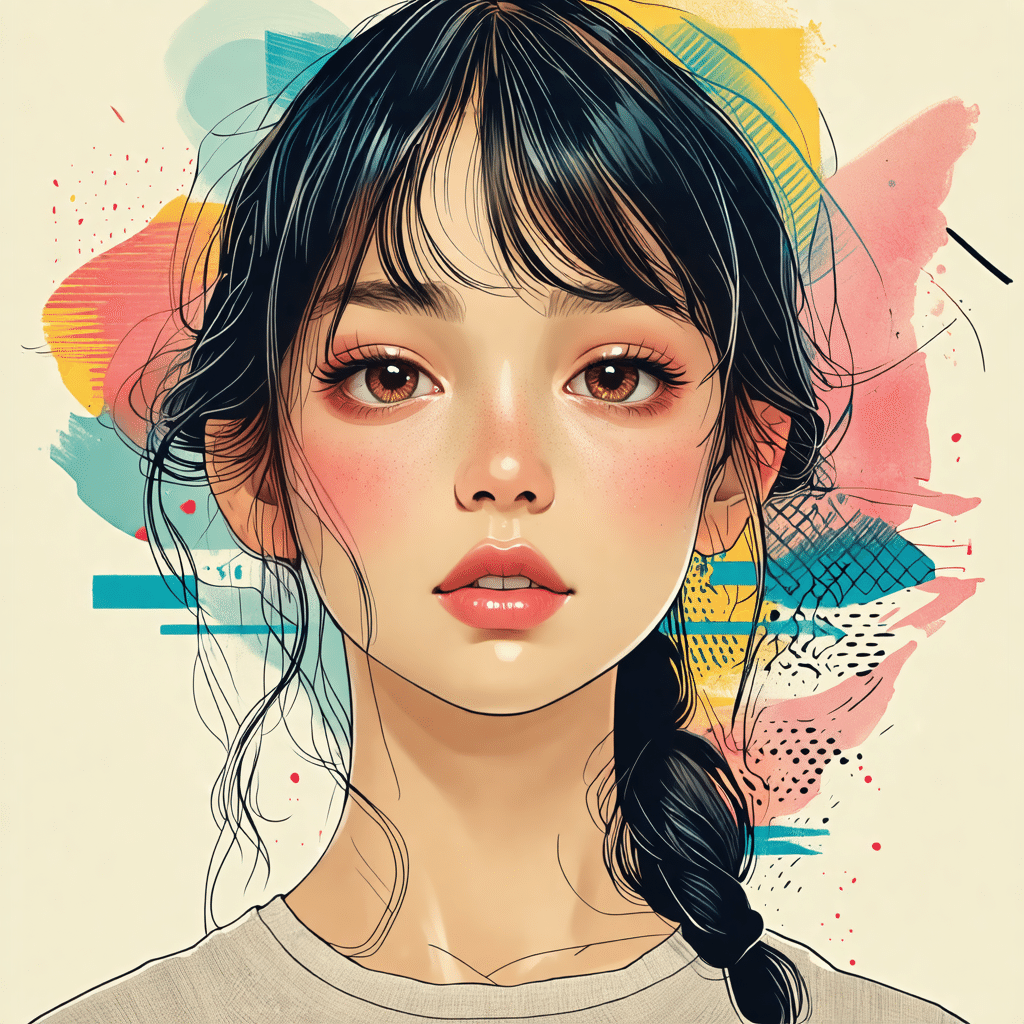

- 講座を通してセミリアルや実写など12点の例題を完成

- 講座内容に関するPDFデータや資料、Google Slidesで使えるツールを提供

- 画像生成プロンプト集を提供

- AICUのノウハウが詰まった講座PDF使用を提供

AICU Inc. は Stability AIと戦略提携を

AICU Inc.(本社Delaware州Dover City, カリフォルニア州サニーベール)は、Stability AI Ltd.(本社London、United Kingdom)とのパートナーシップを発表しました。このパートナーシップは、エンゲージメント・レターを通じて正式に締結されており、持続革新的でオープンなAIDX(AI Driven user eXperience)開発、技術広報を提供するもので、生成AI技術の社会的認知と価値向上と市場開拓を推進するコミュニケーションに重点を置いています。

AICU Inc.は、この提携により、Stability AI Ltd. の生成AI技術の社会的認知と円滑なコミュニケーションのために、advocacy communication service としてコンサルティングサービスと開発者・クリエイター支援・技術広報・PoC開発・クリエイターユニオン構築に協力します。

2024/1/22 AICU Inc. プレスリリースより

https://prtimes.jp/main/html/rd/p/000000007.000133647.html

https://corp.aicu.ai/ja/stability-ai

【講師紹介】

- 白井 暁彦:生成AIクリエイティブ「AICU」代表、デジタルハリウッド大学大学院特任教授

- RUNO.:生成AIクリエイター

AIの波に乗り遅れるな!

今すぐ予約して、未来を創造する力を手に入れよう!

▼ Coloso講座ページはこちら ▼

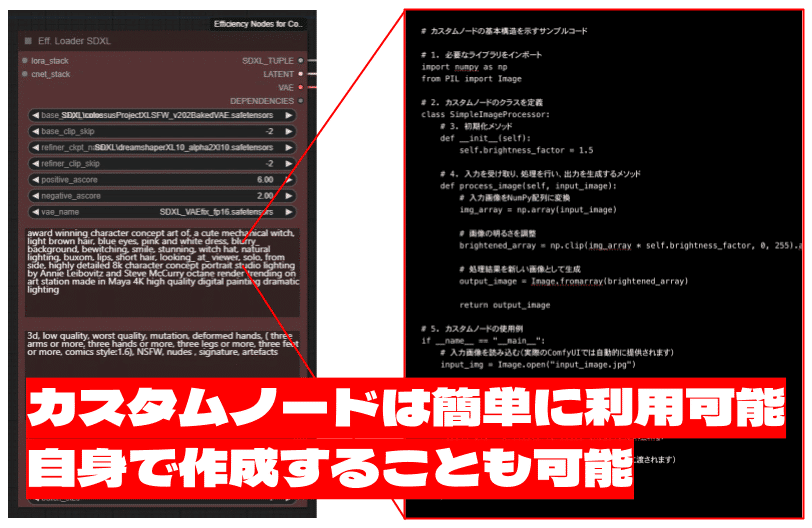

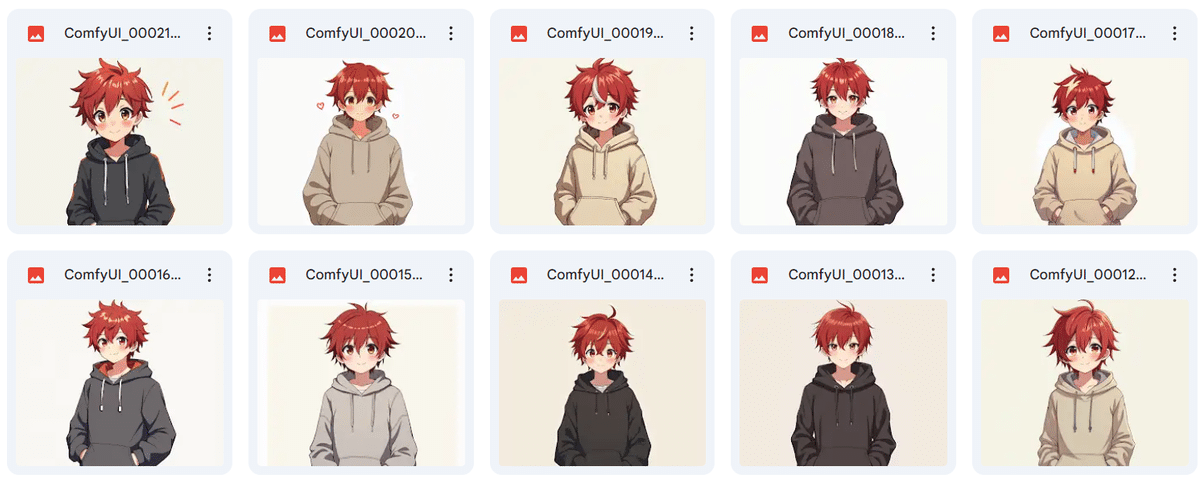

カリキュラム

カリキュラム内容から一部を紹介します!

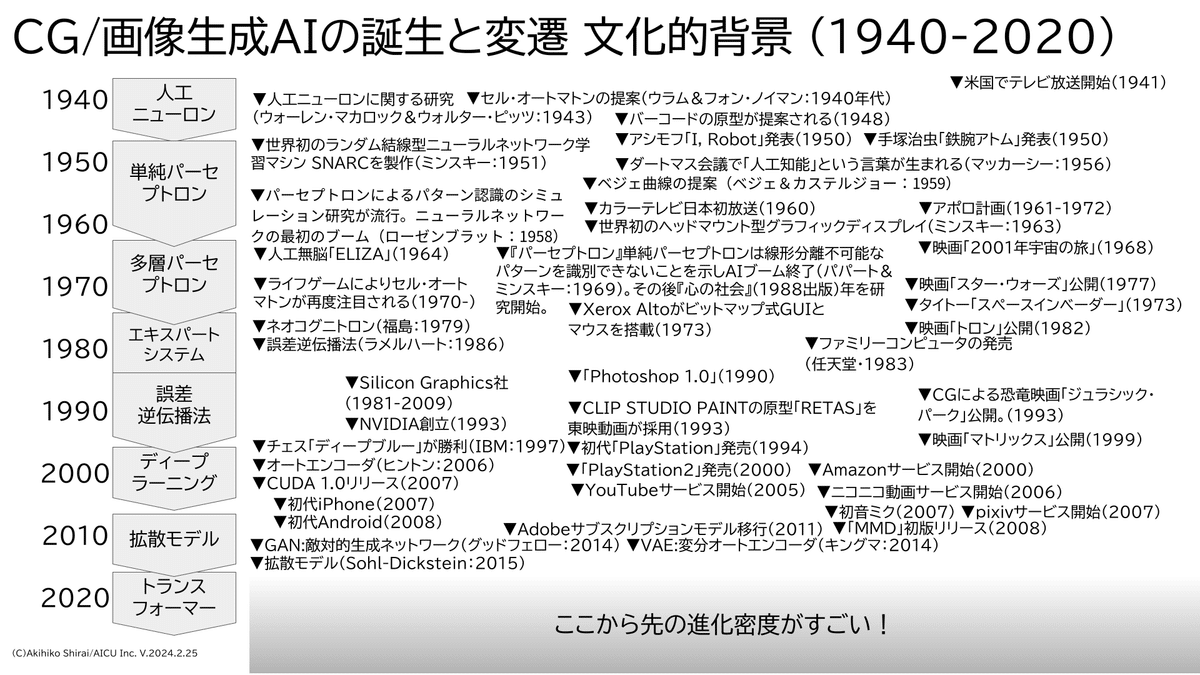

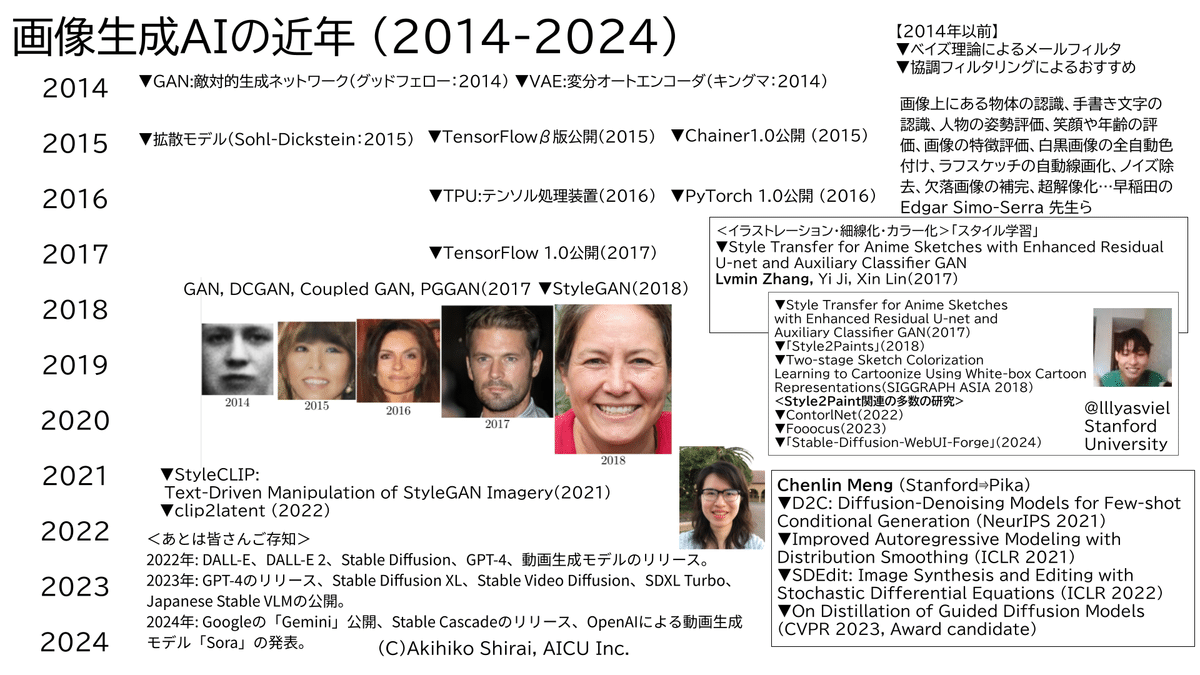

SECTION 01:画像生成AIの歴史と現在、今後の価値

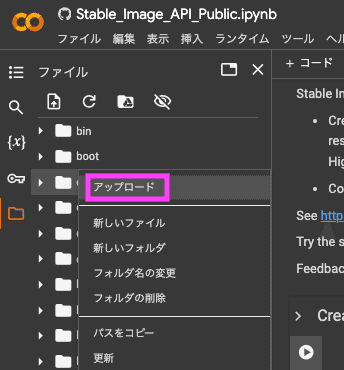

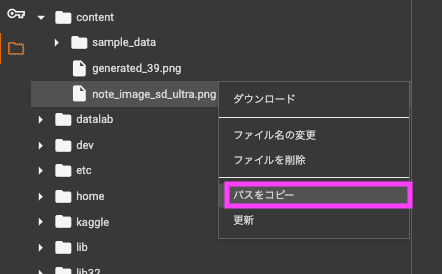

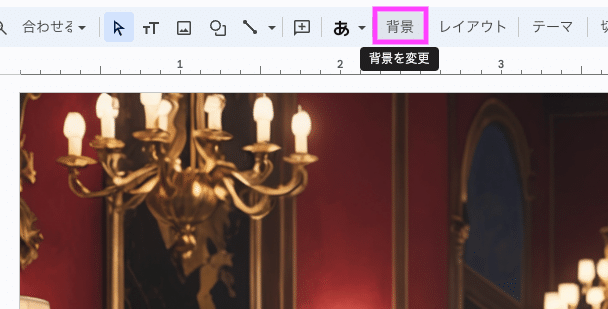

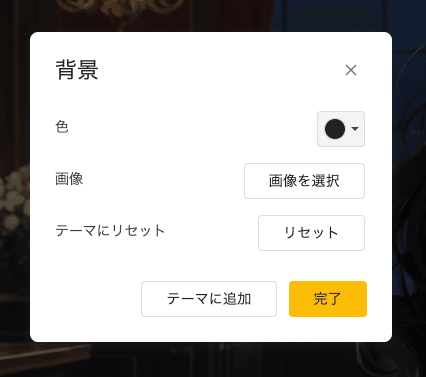

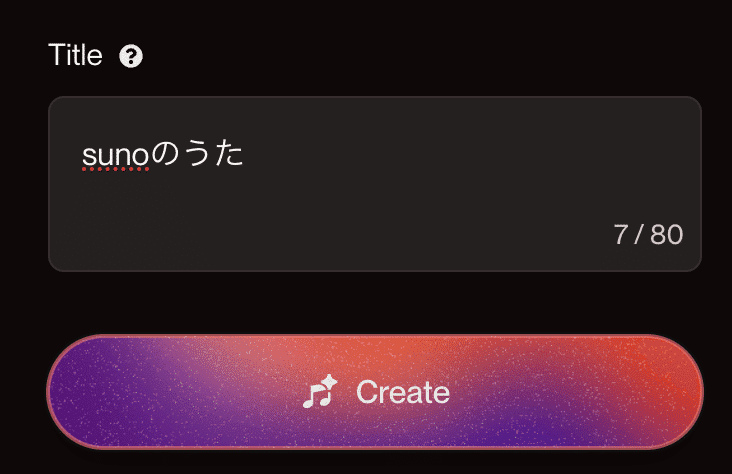

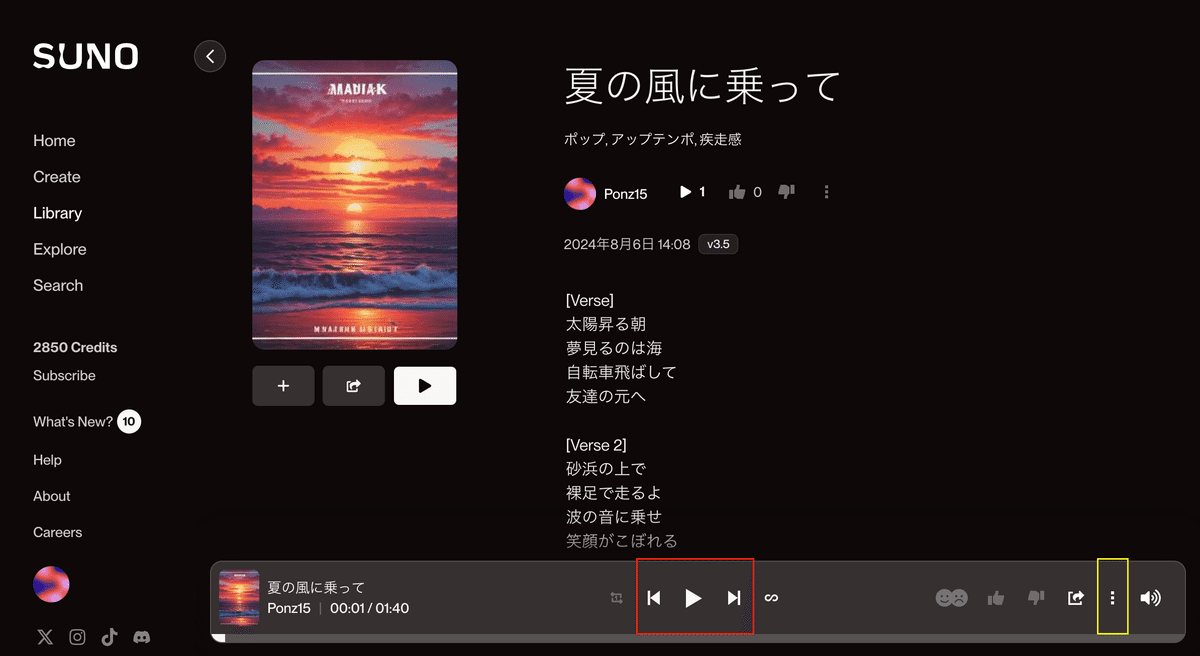

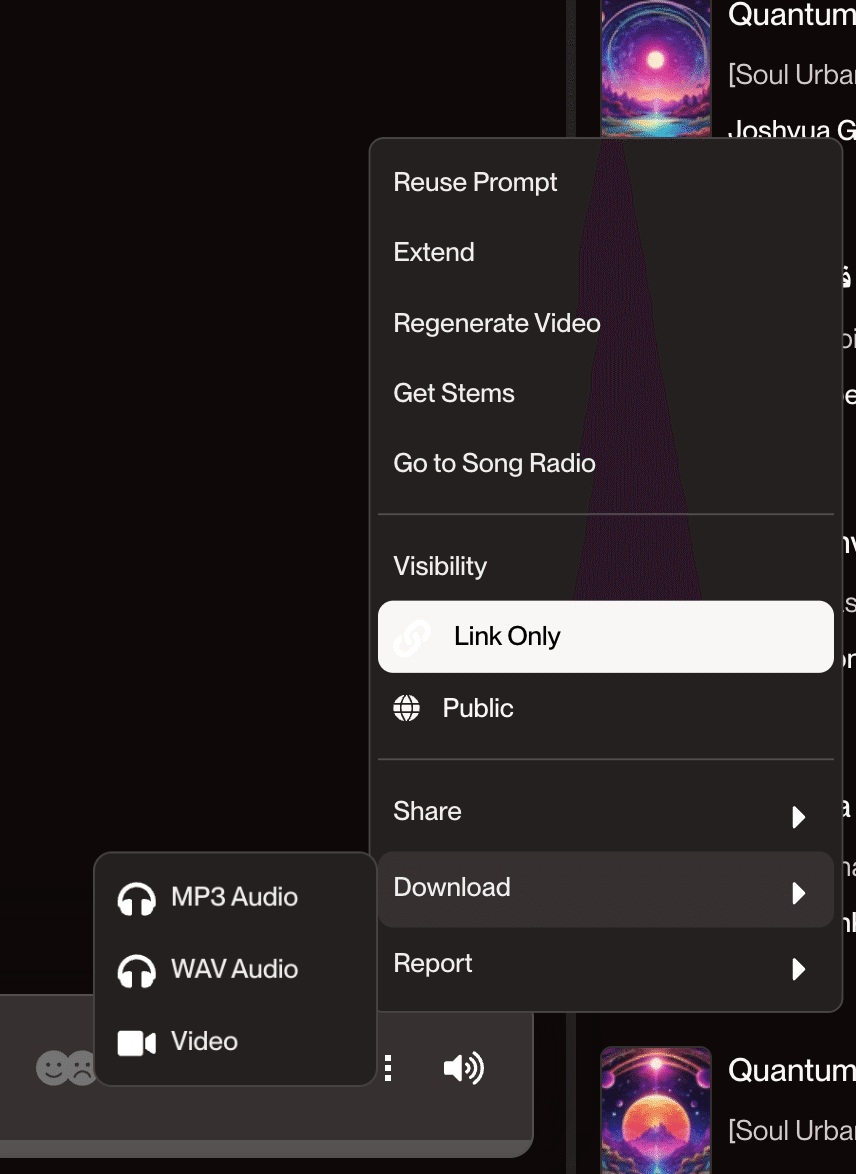

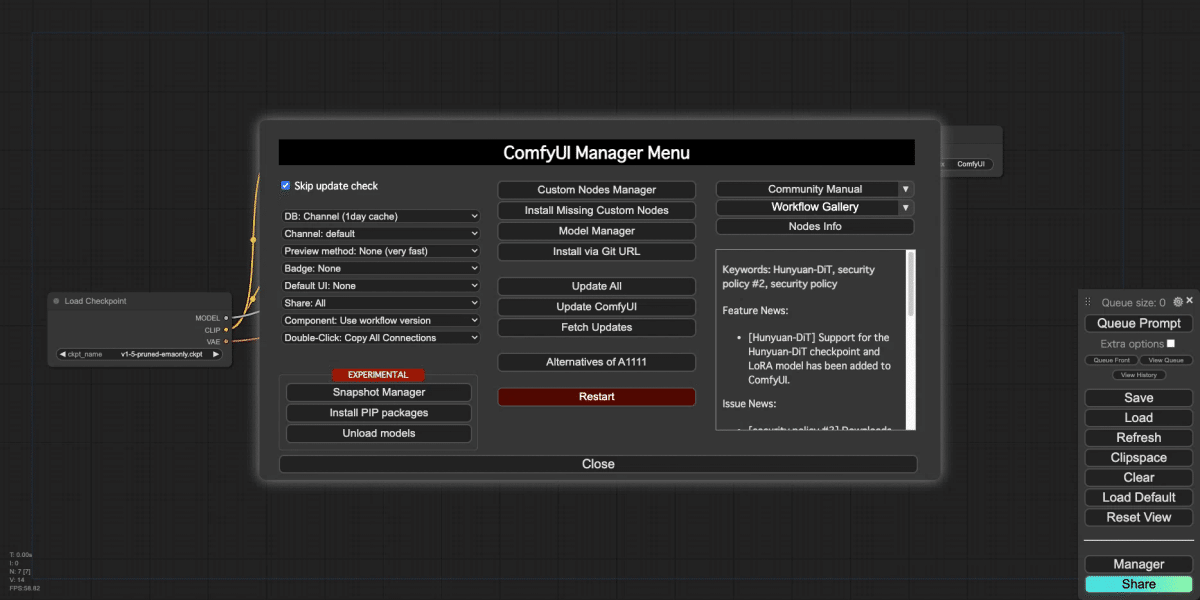

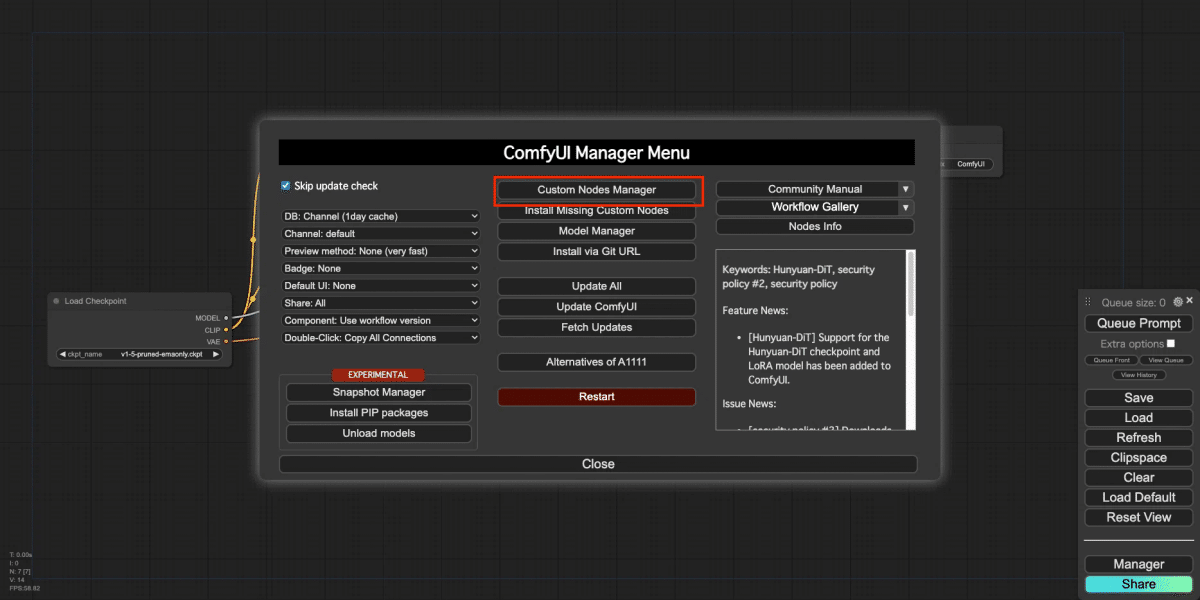

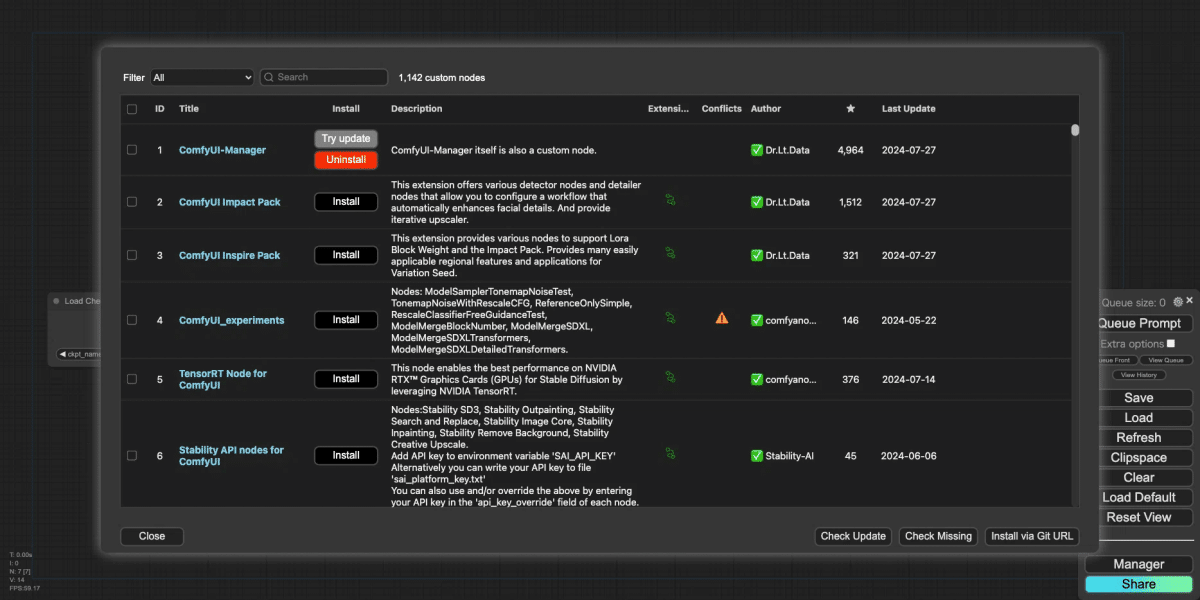

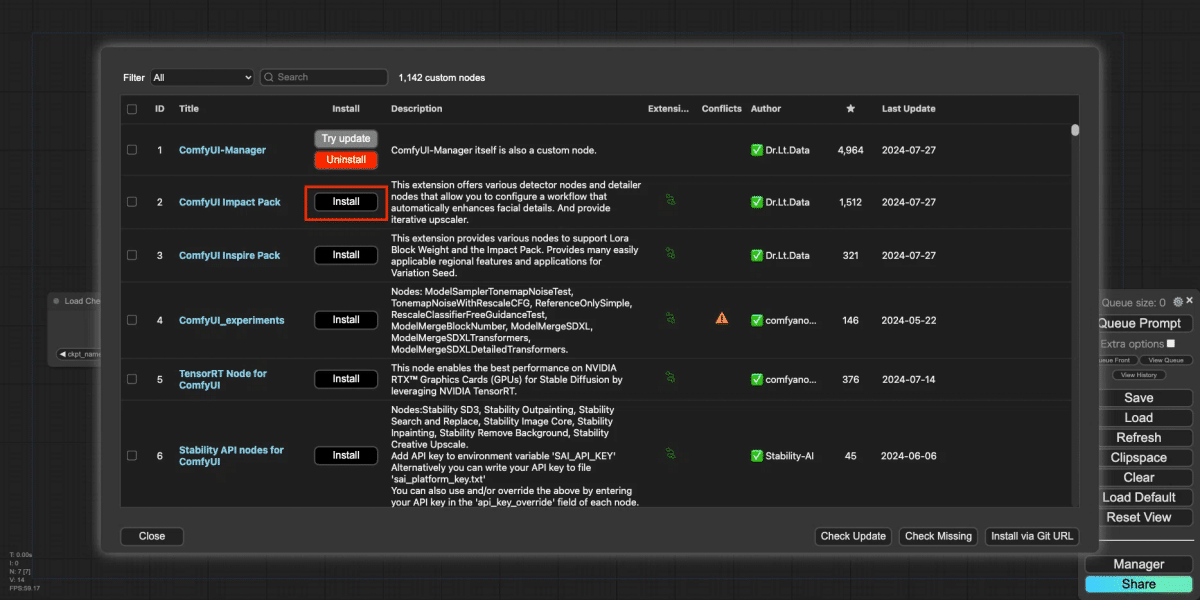

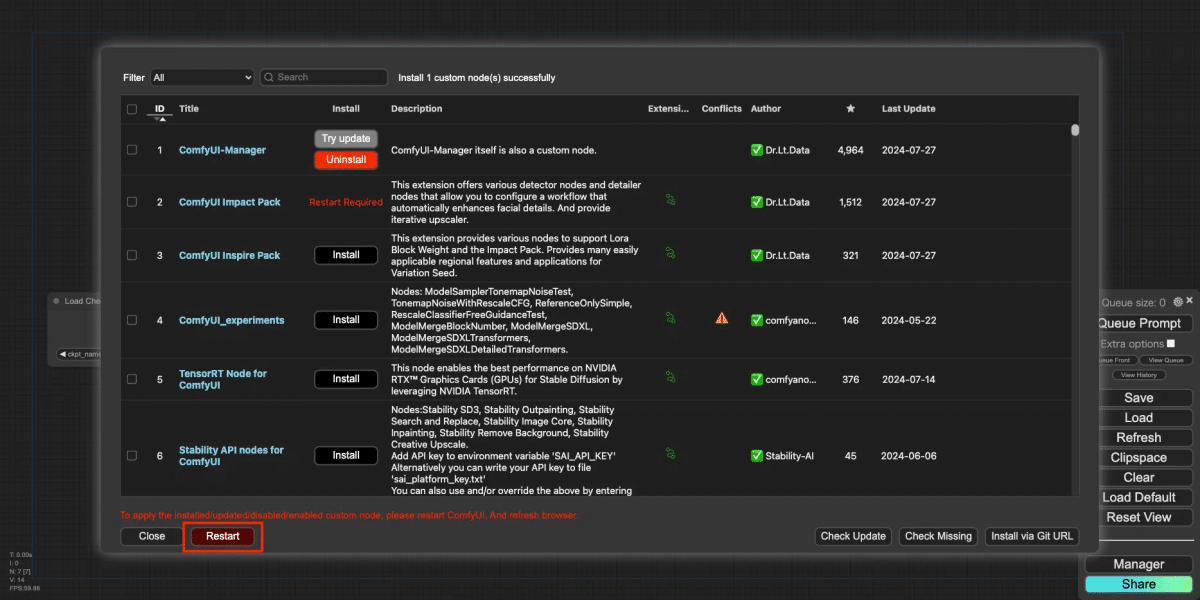

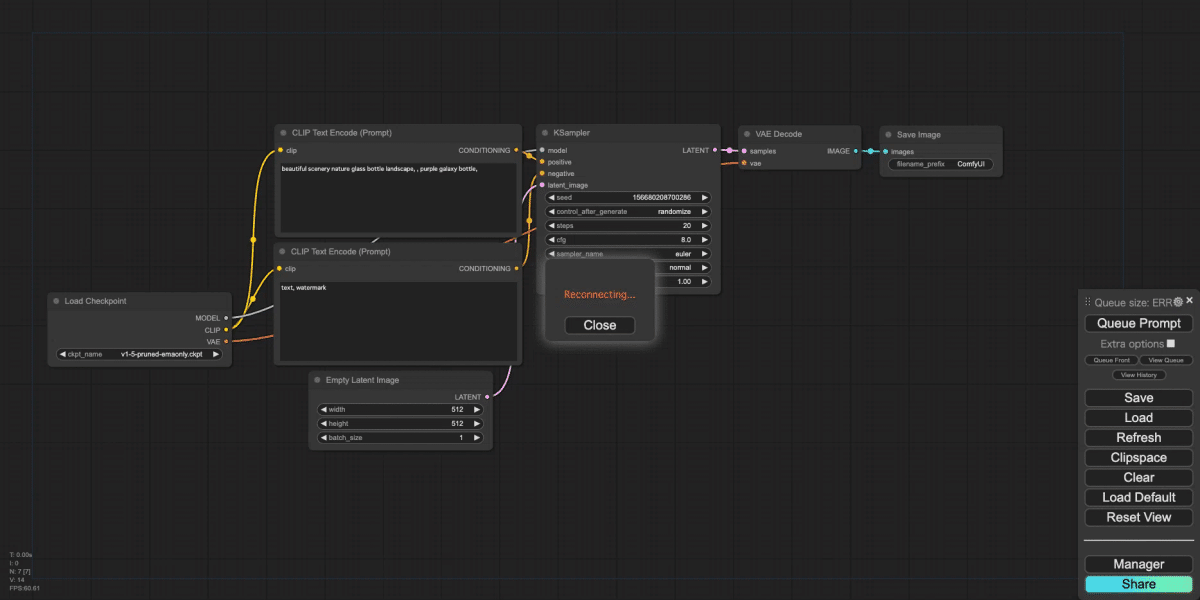

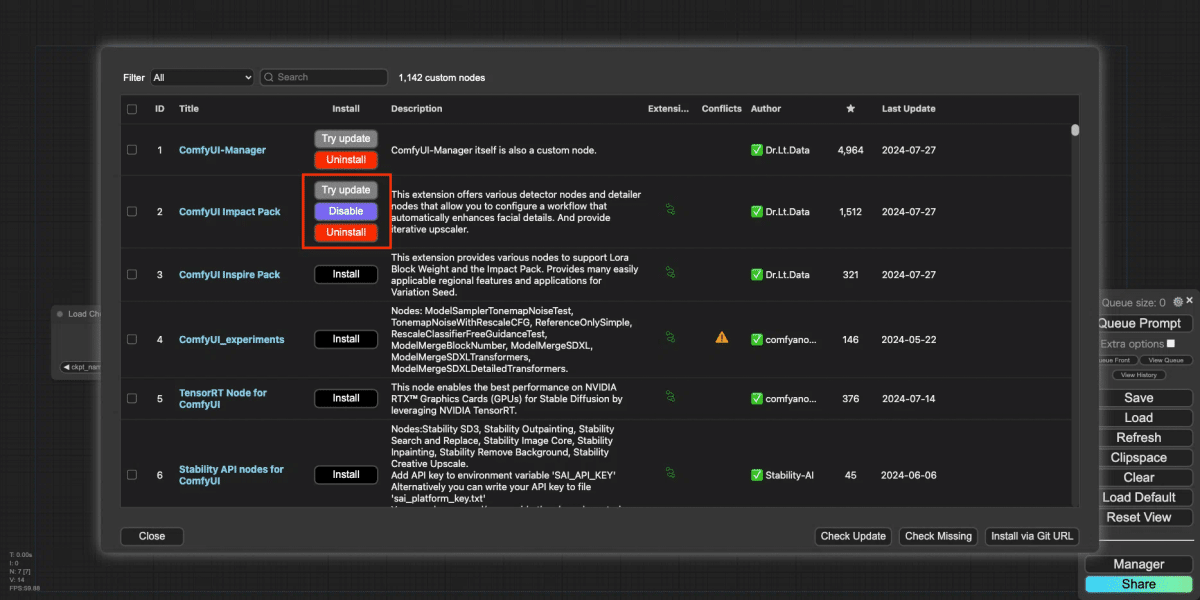

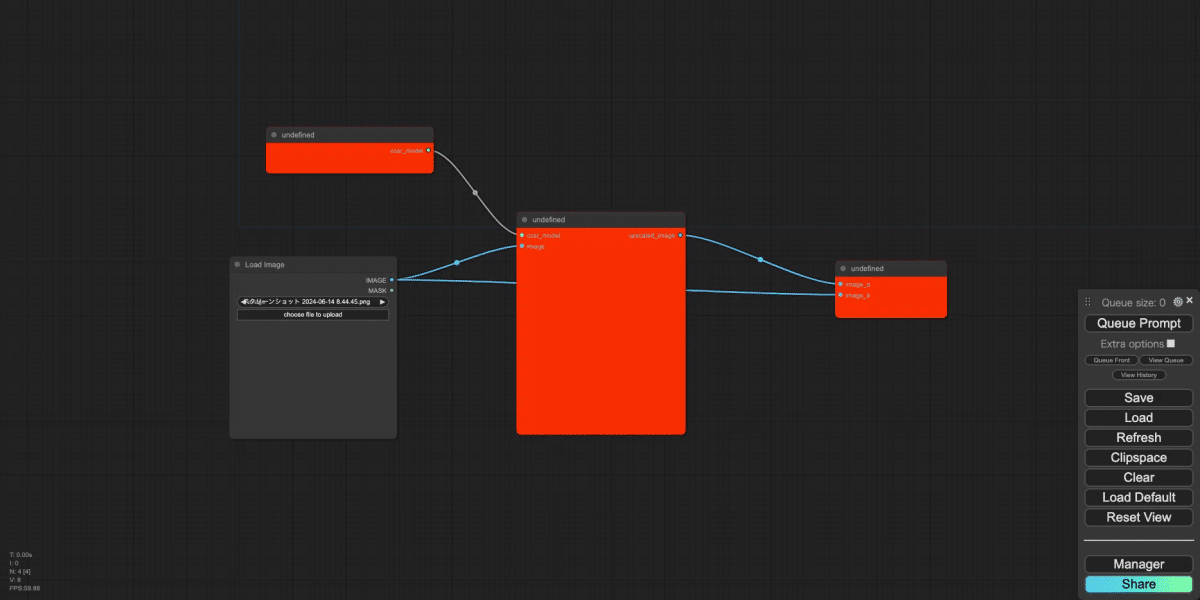

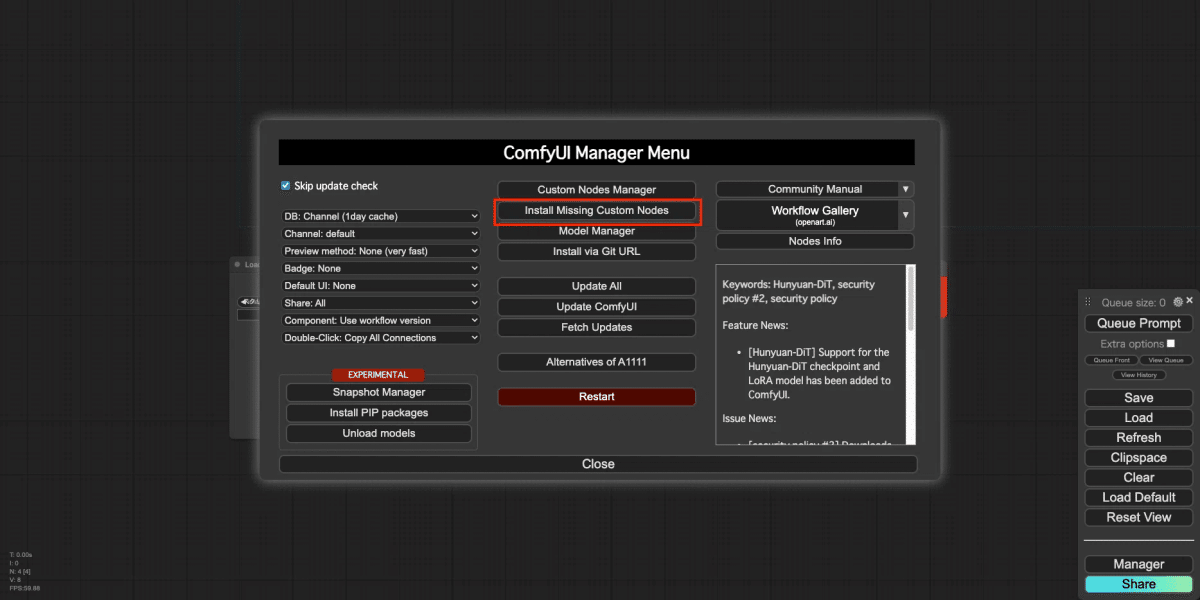

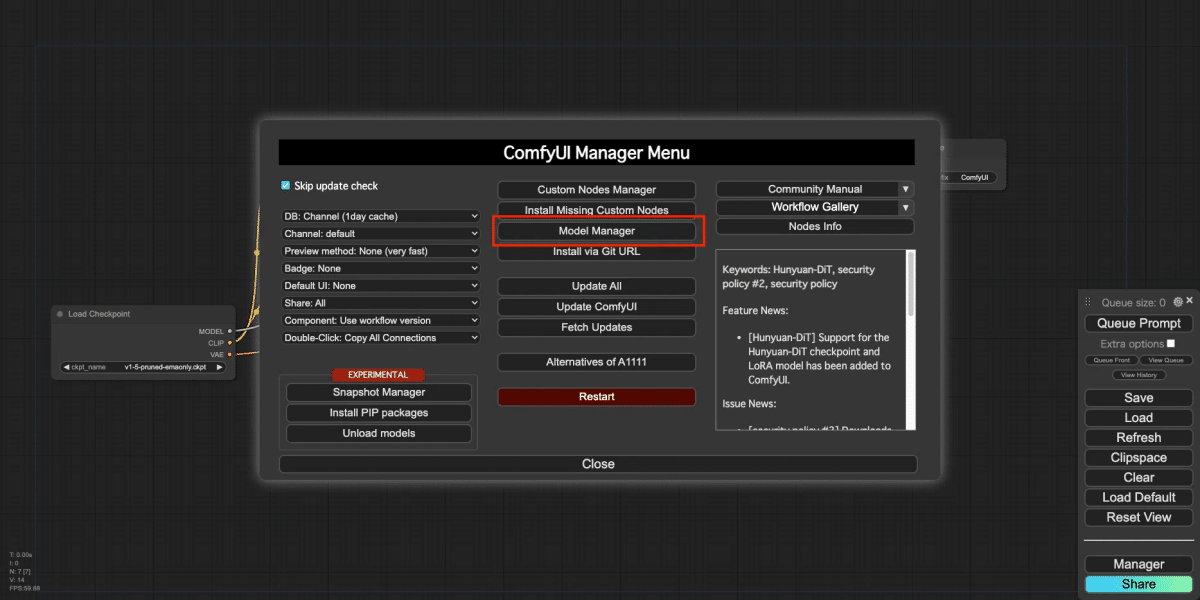

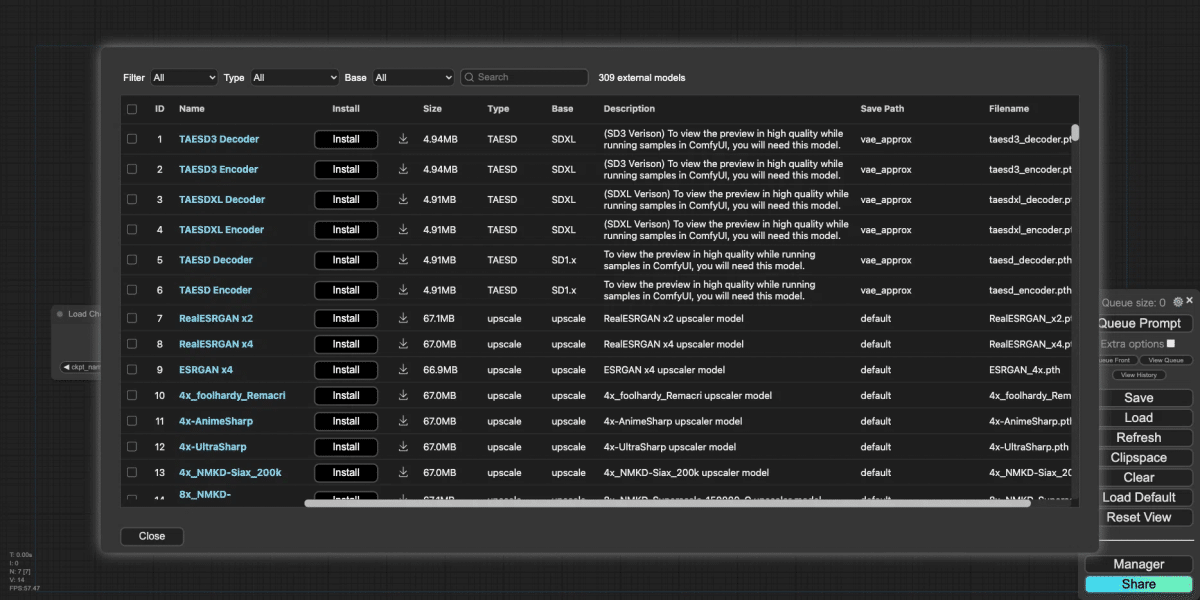

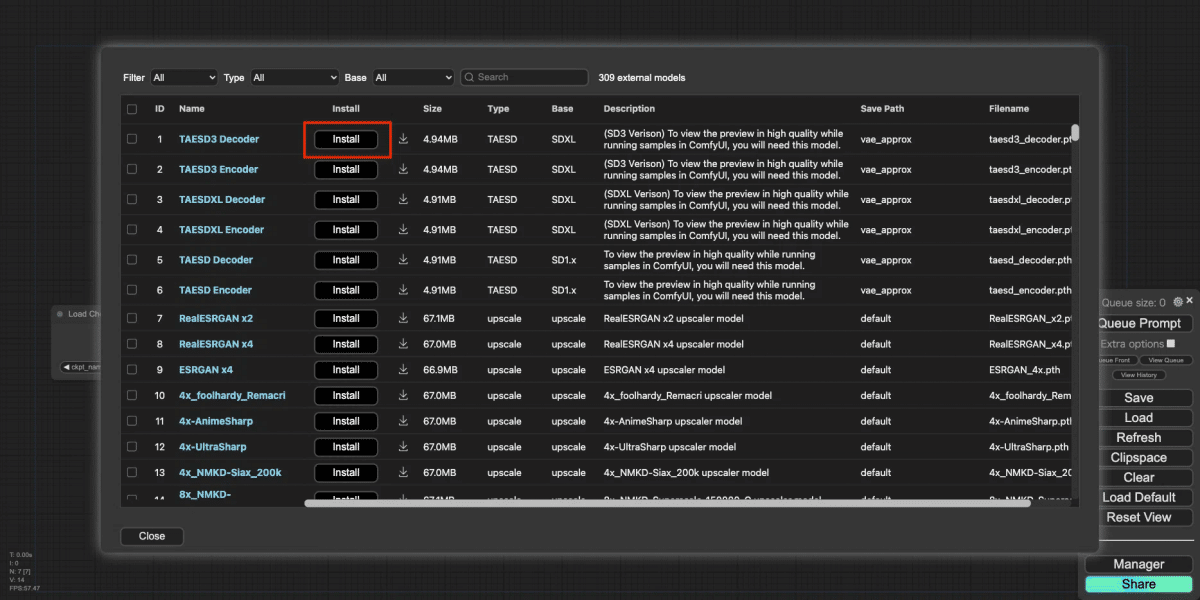

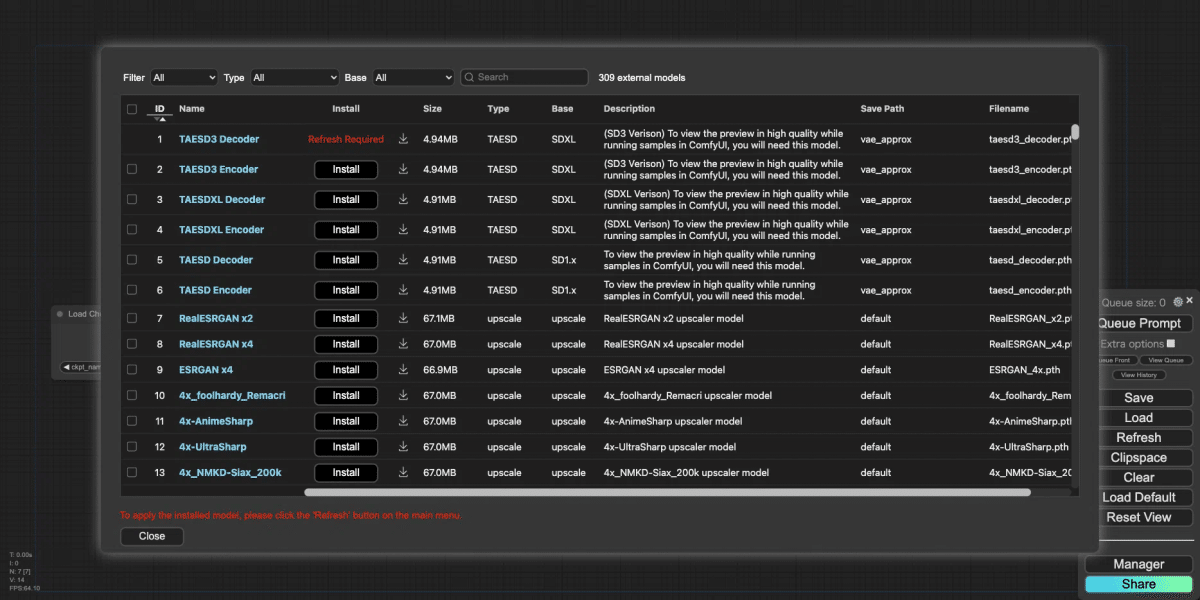

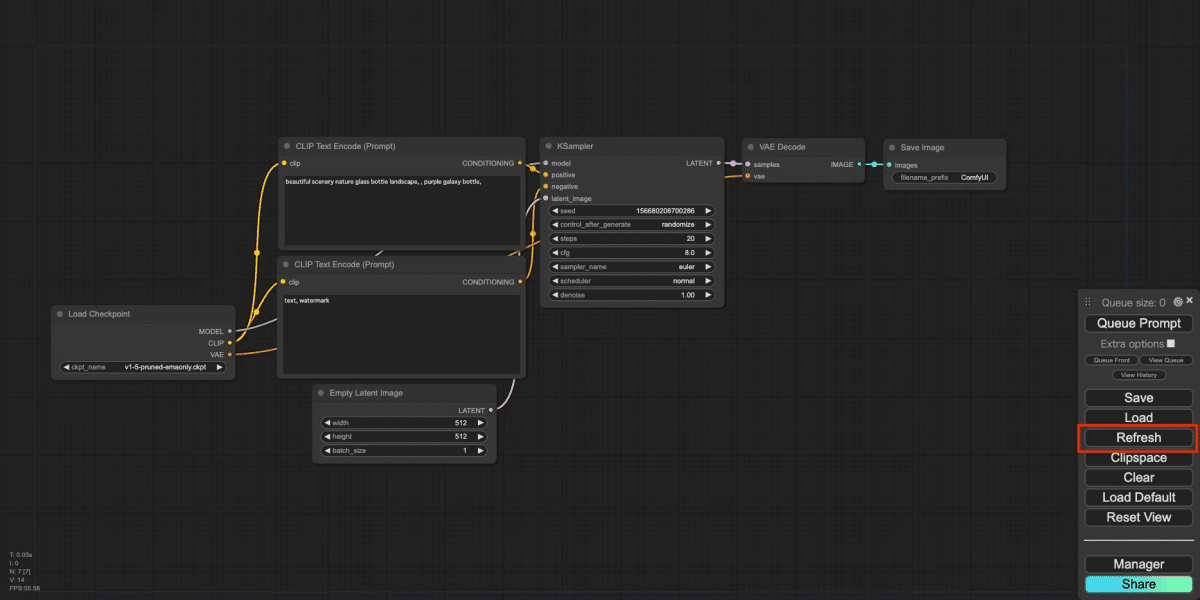

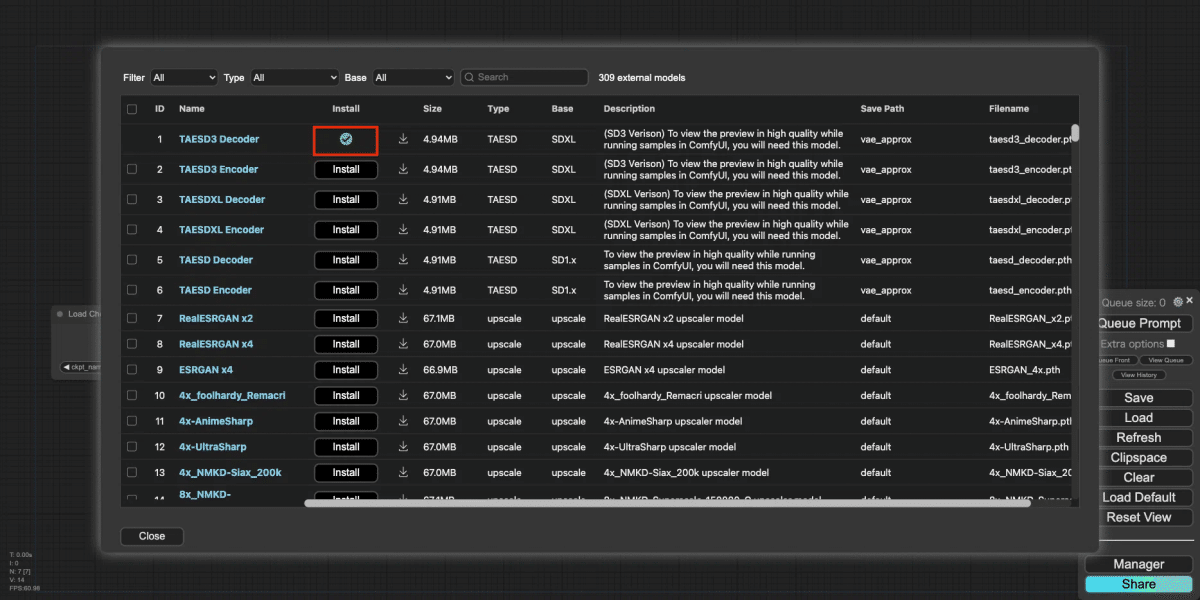

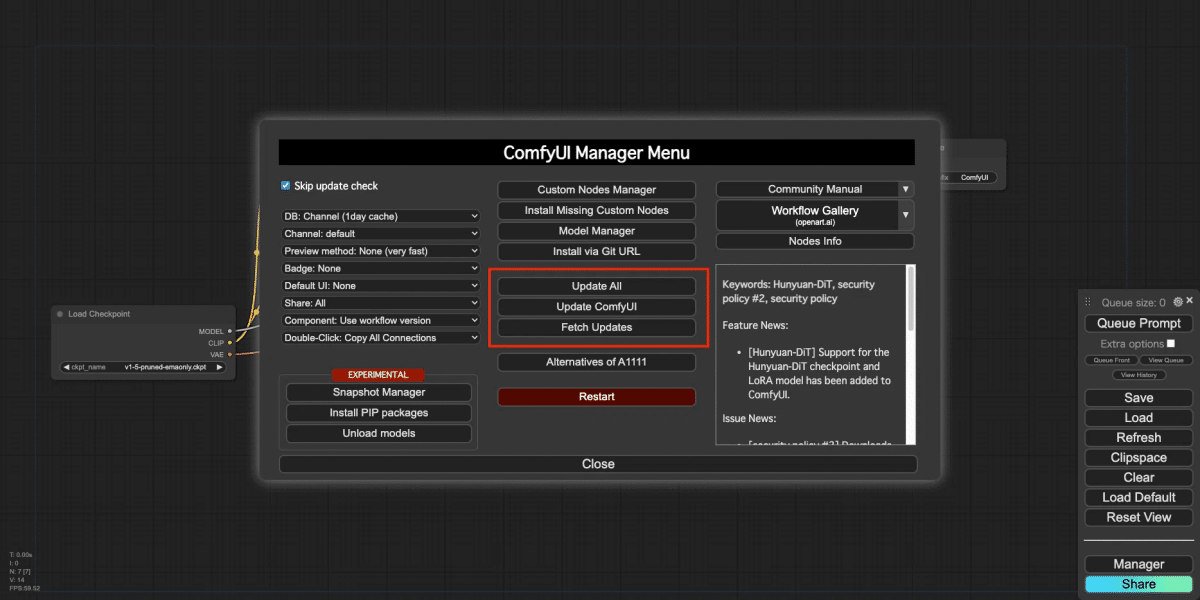

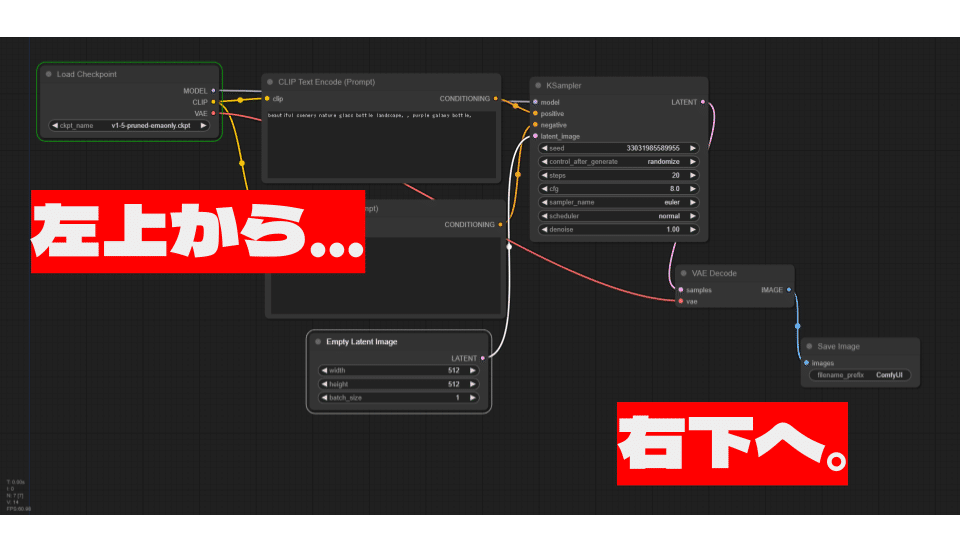

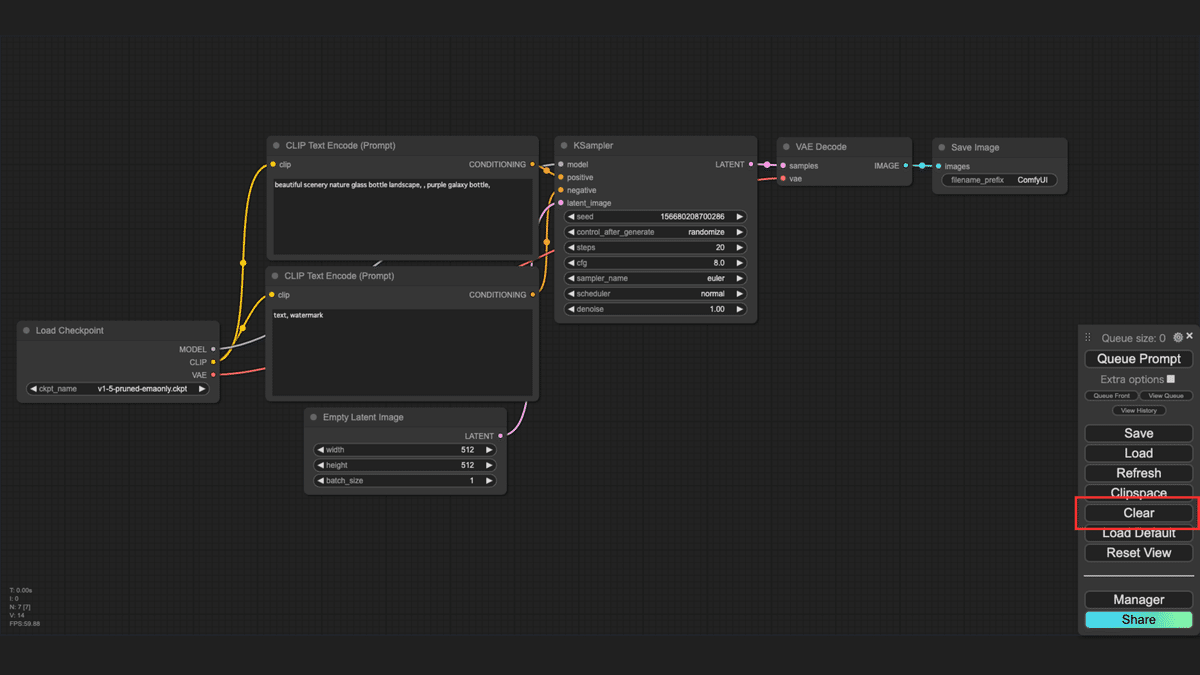

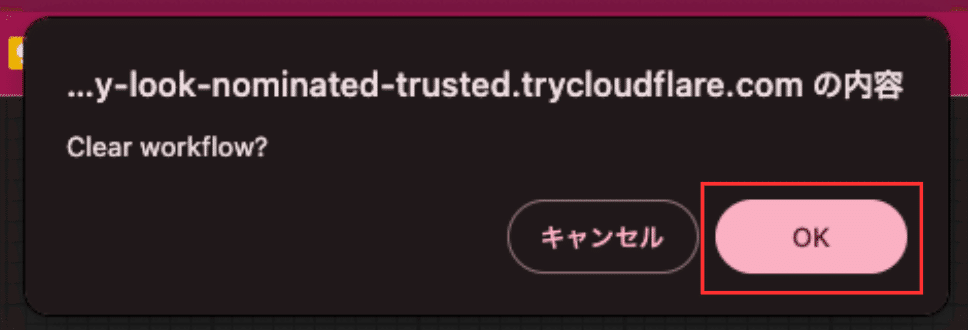

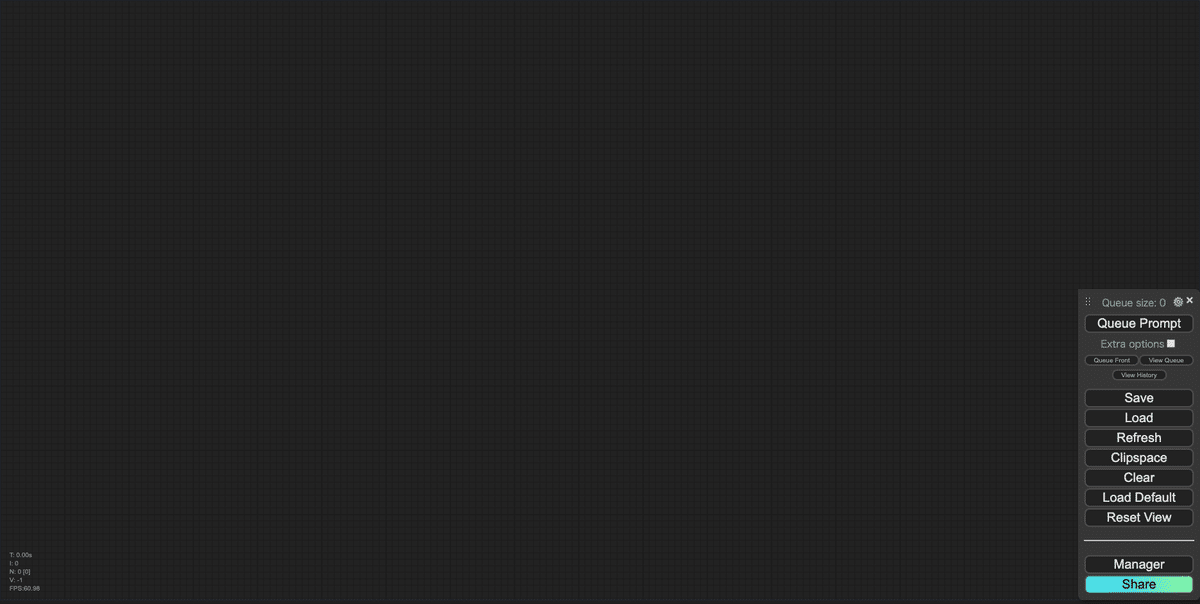

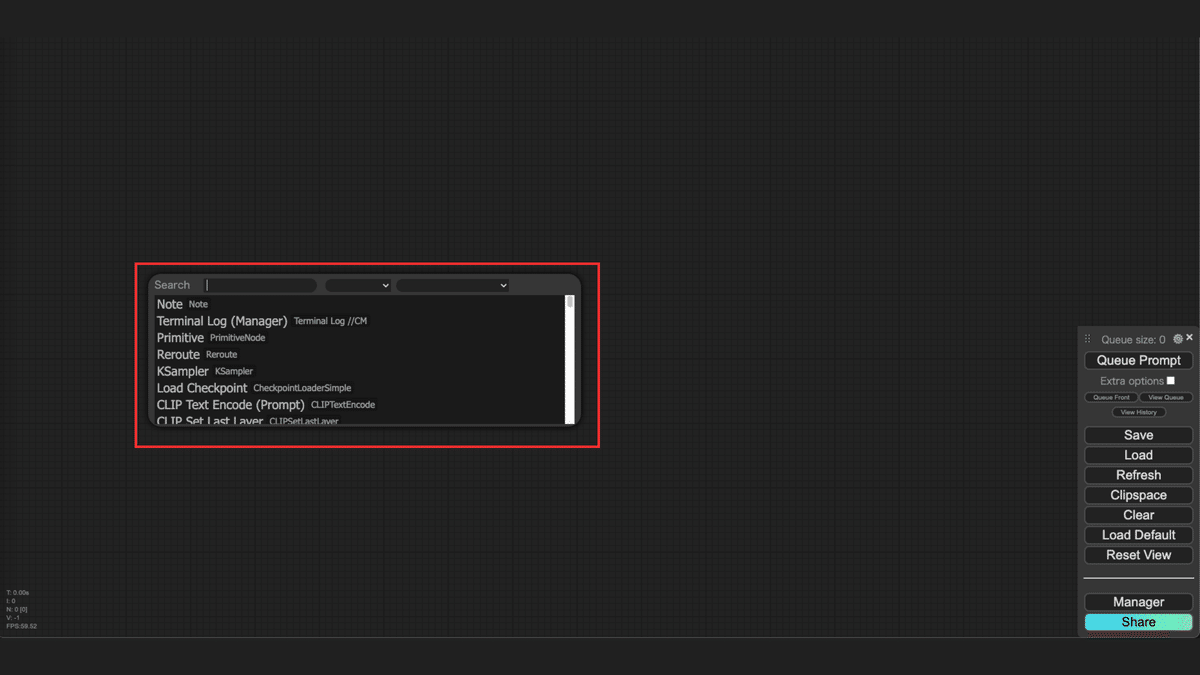

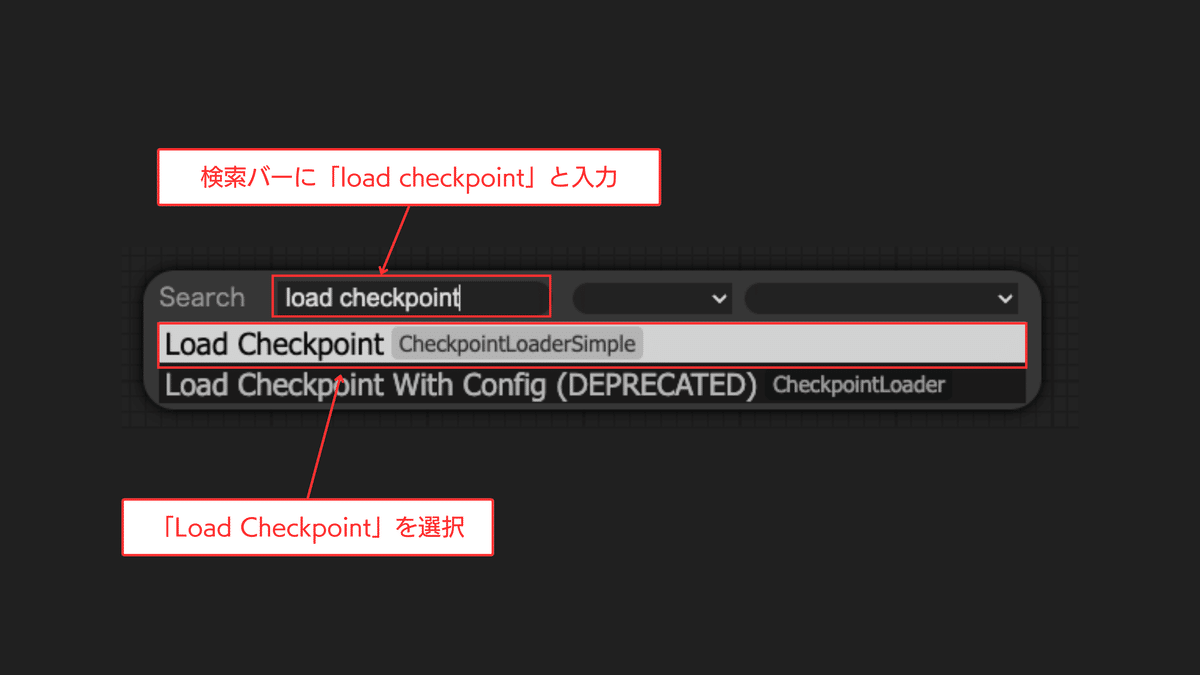

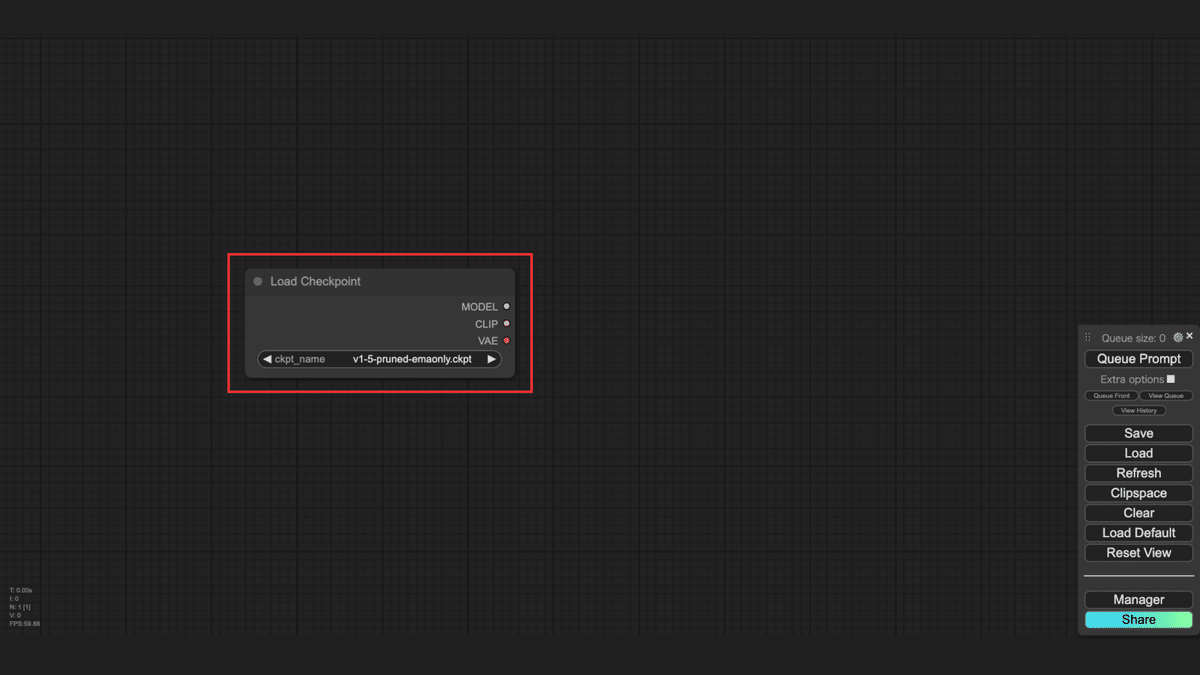

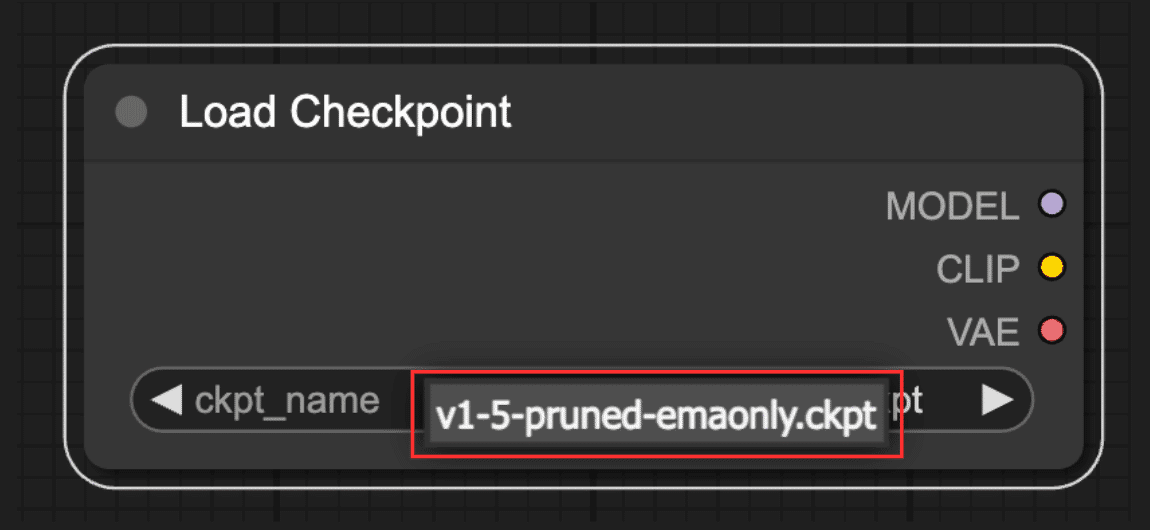

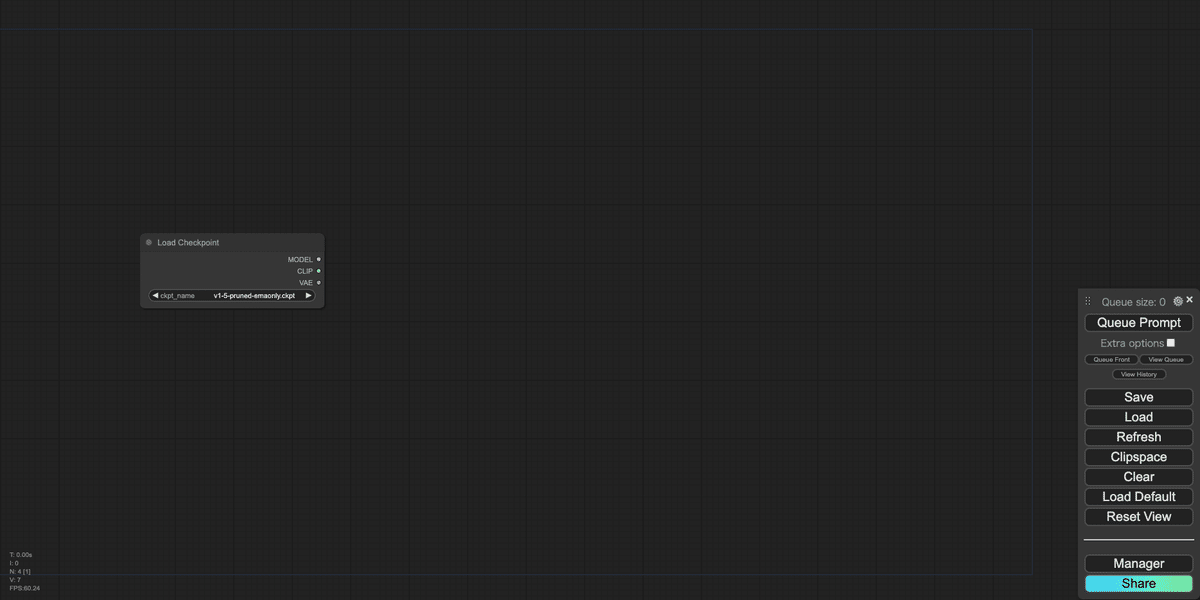

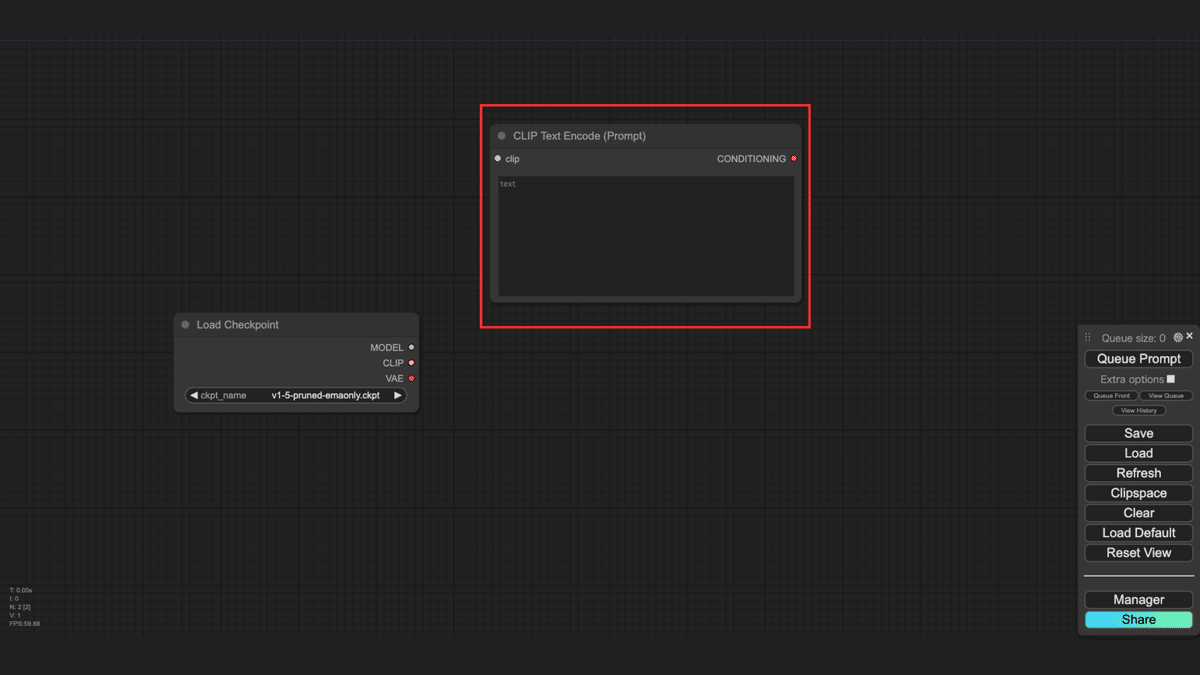

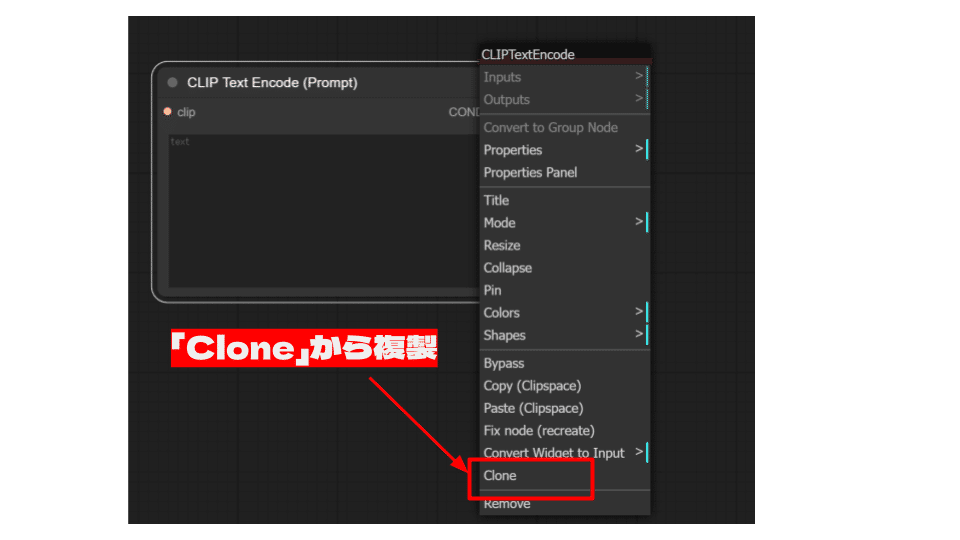

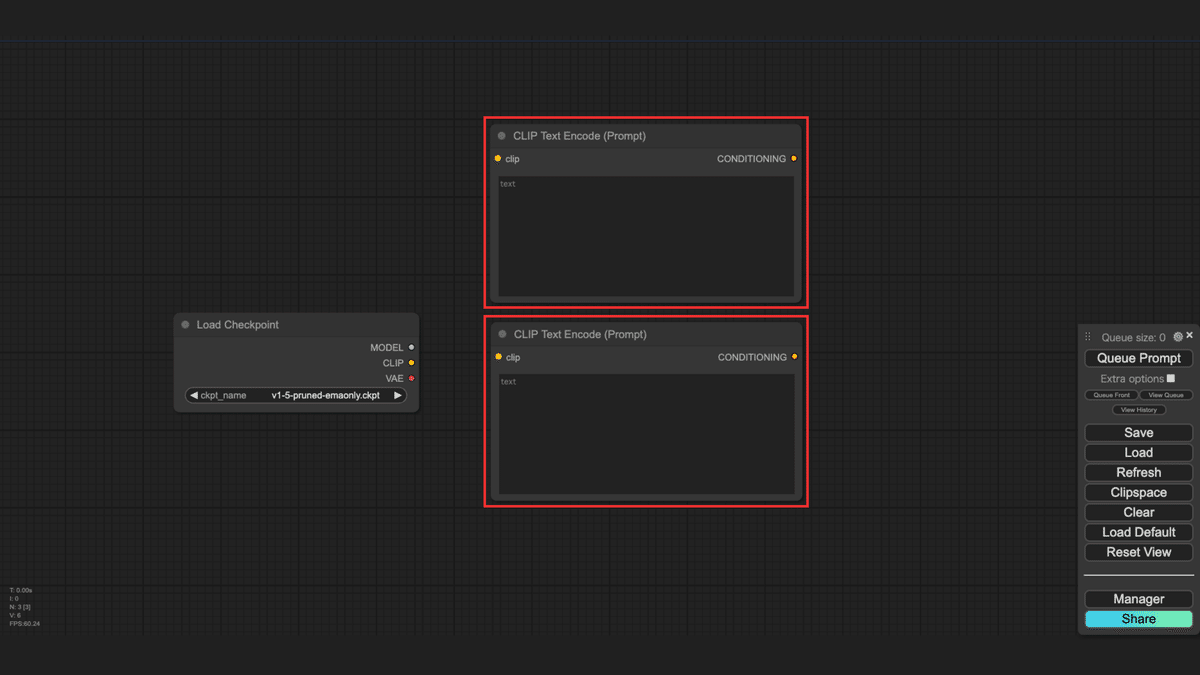

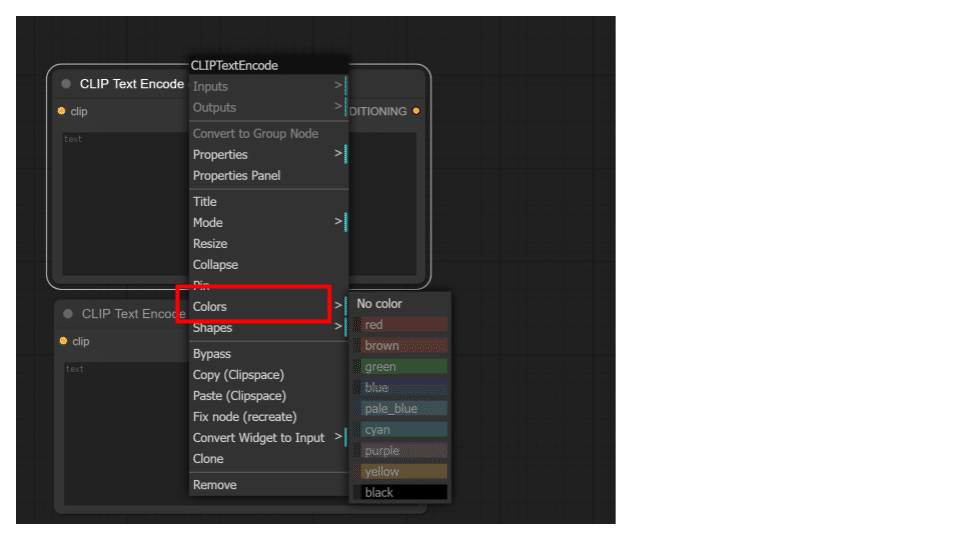

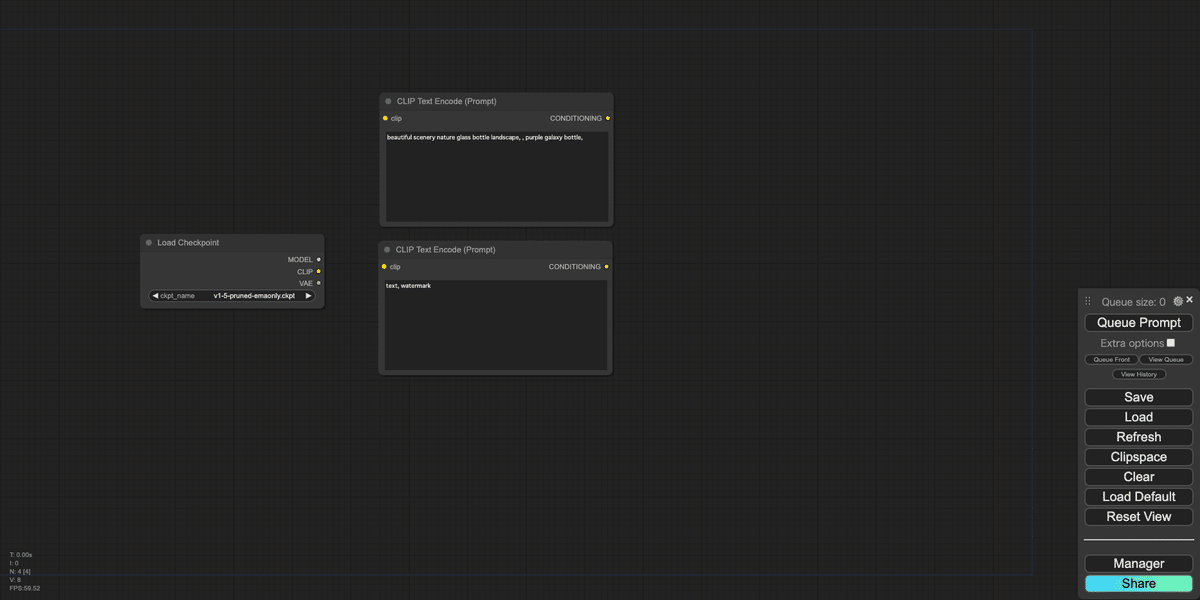

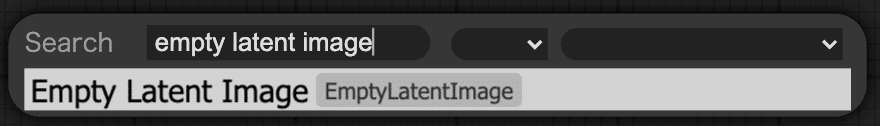

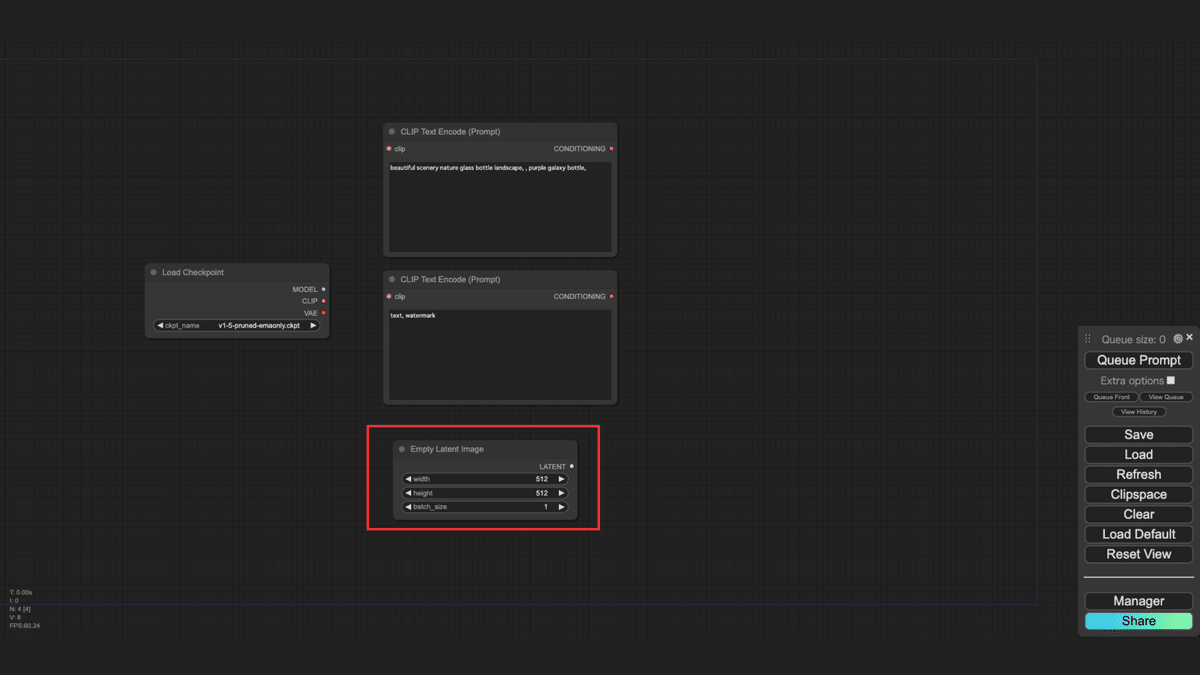

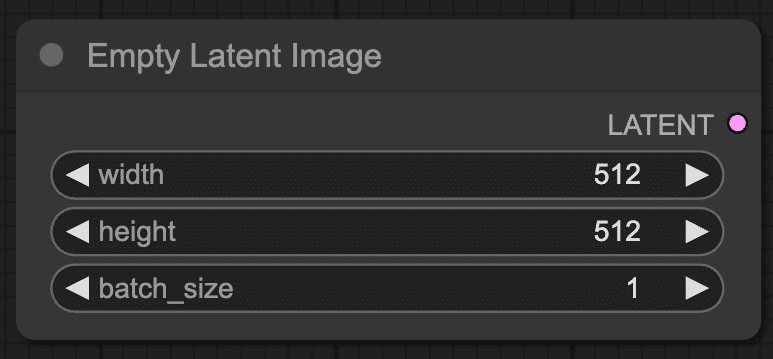

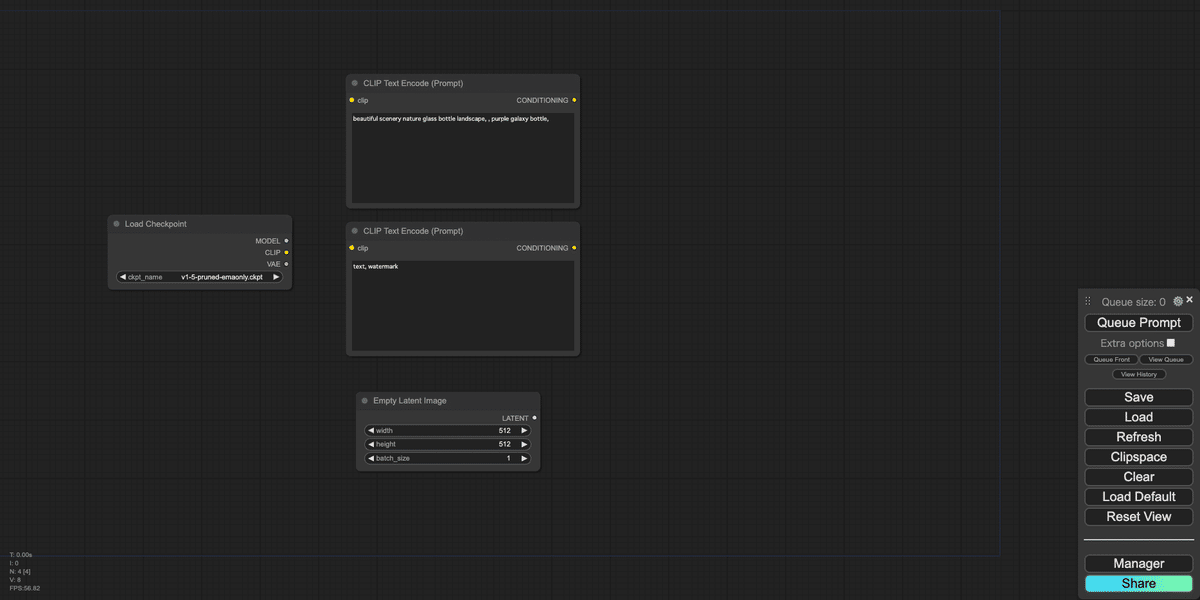

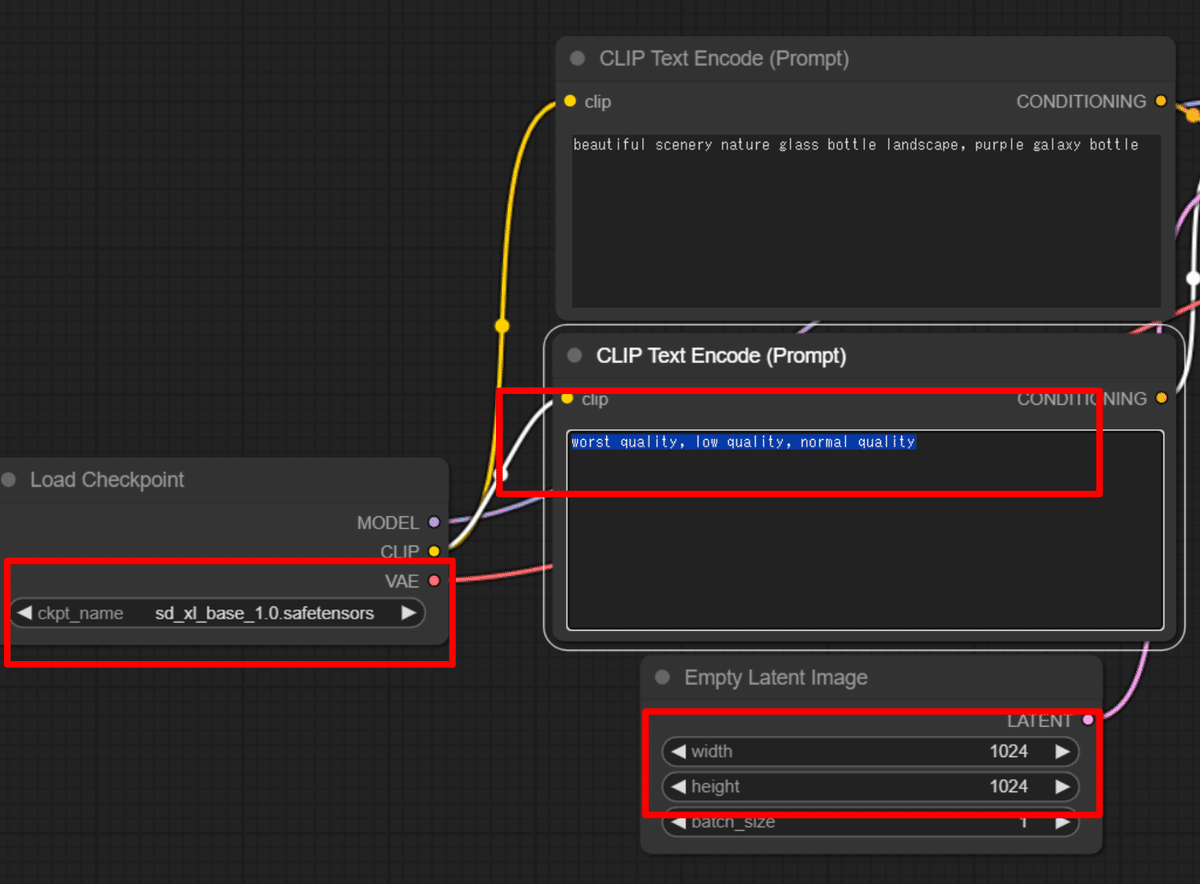

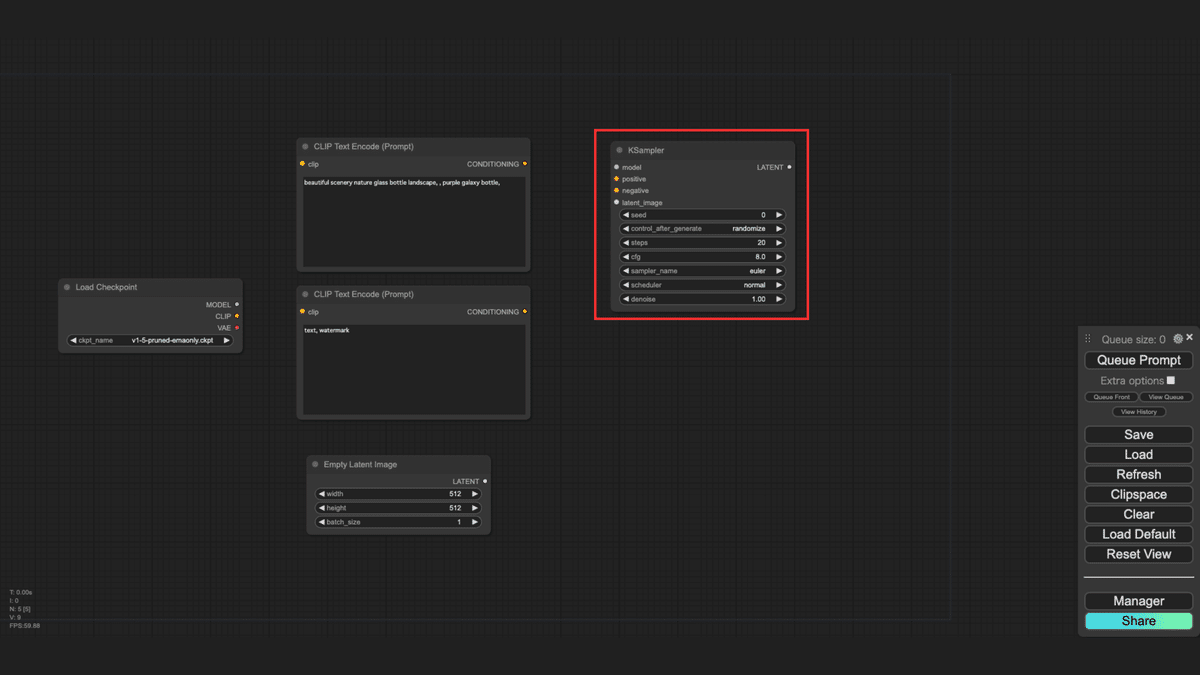

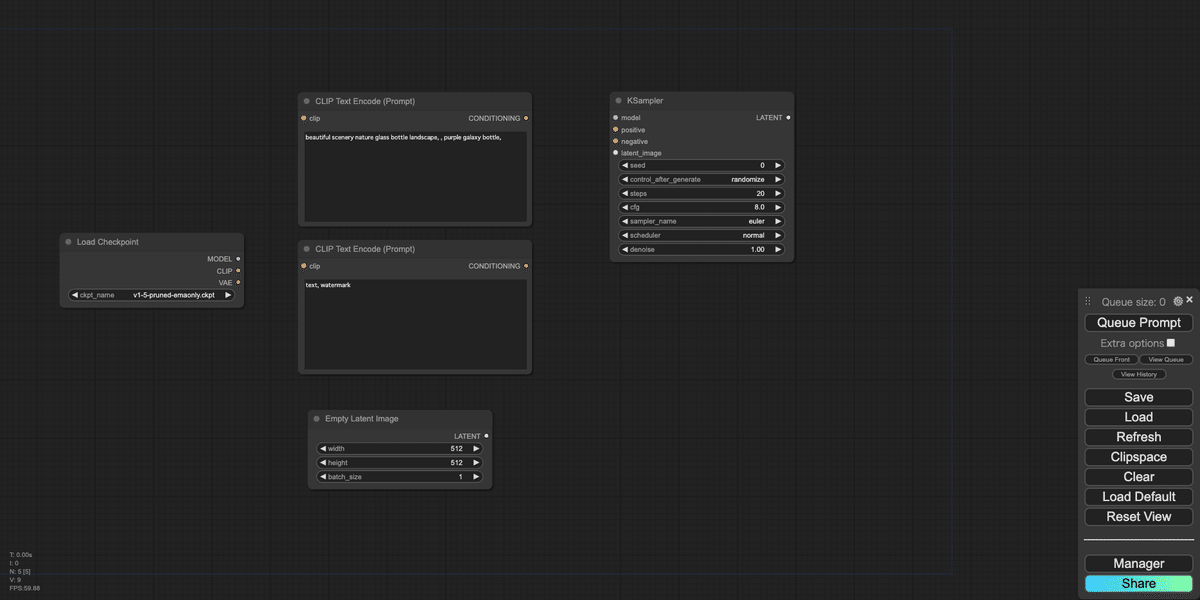

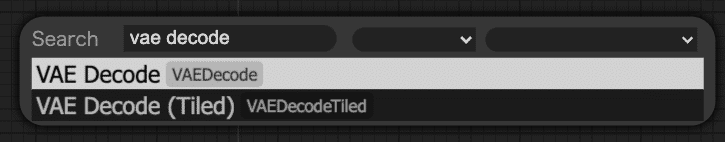

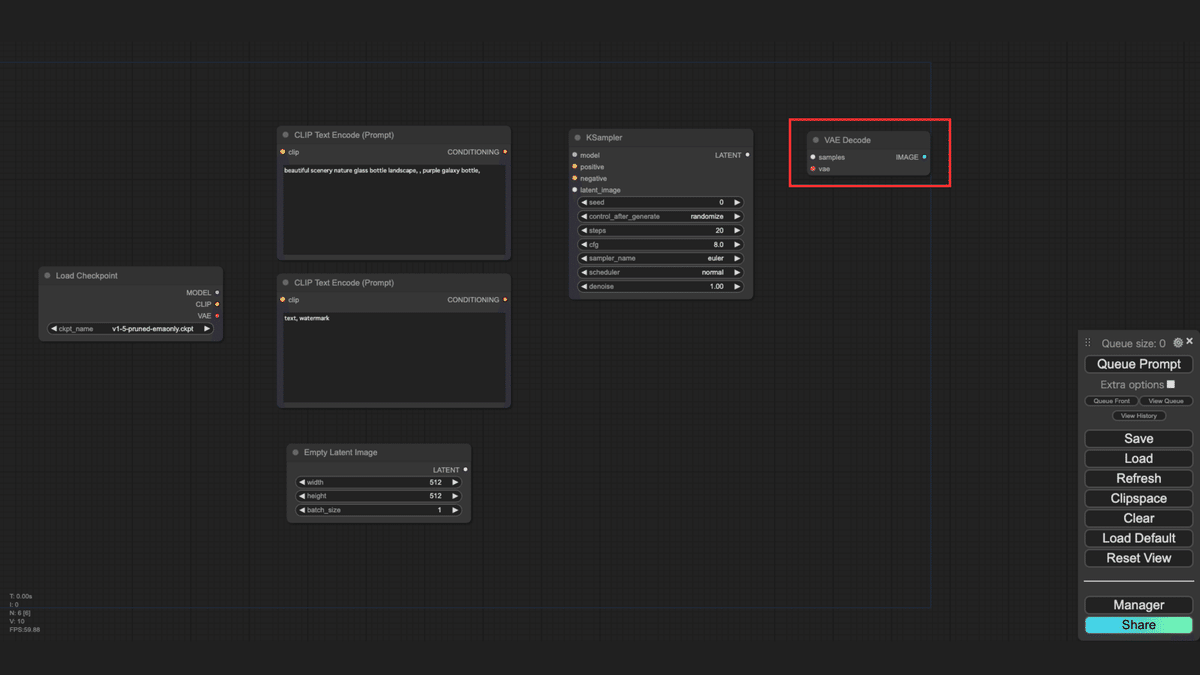

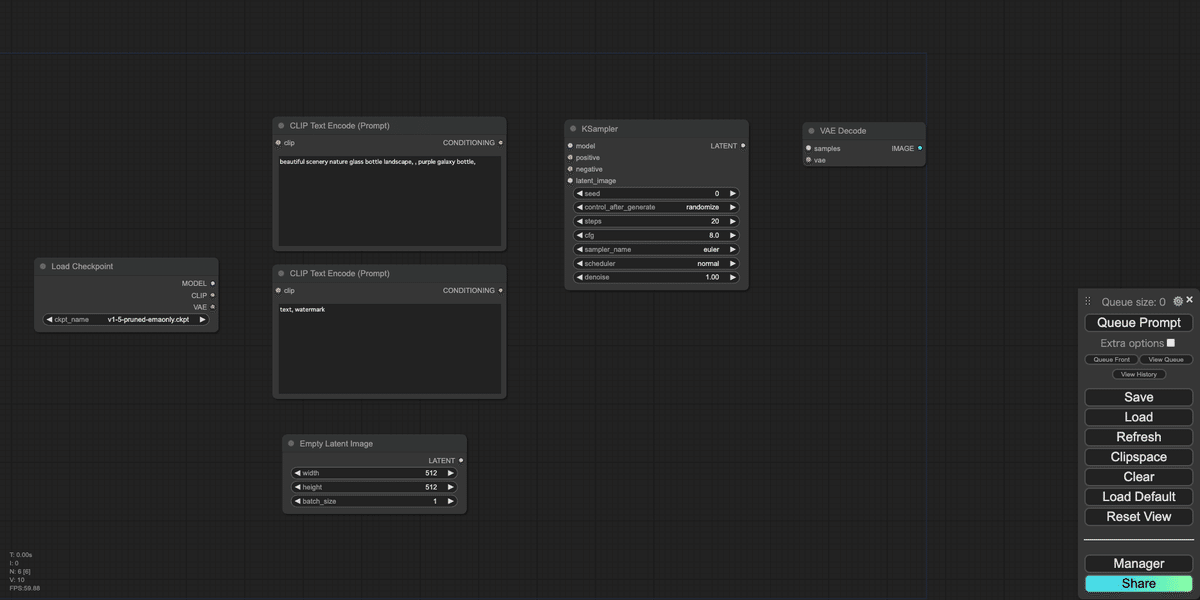

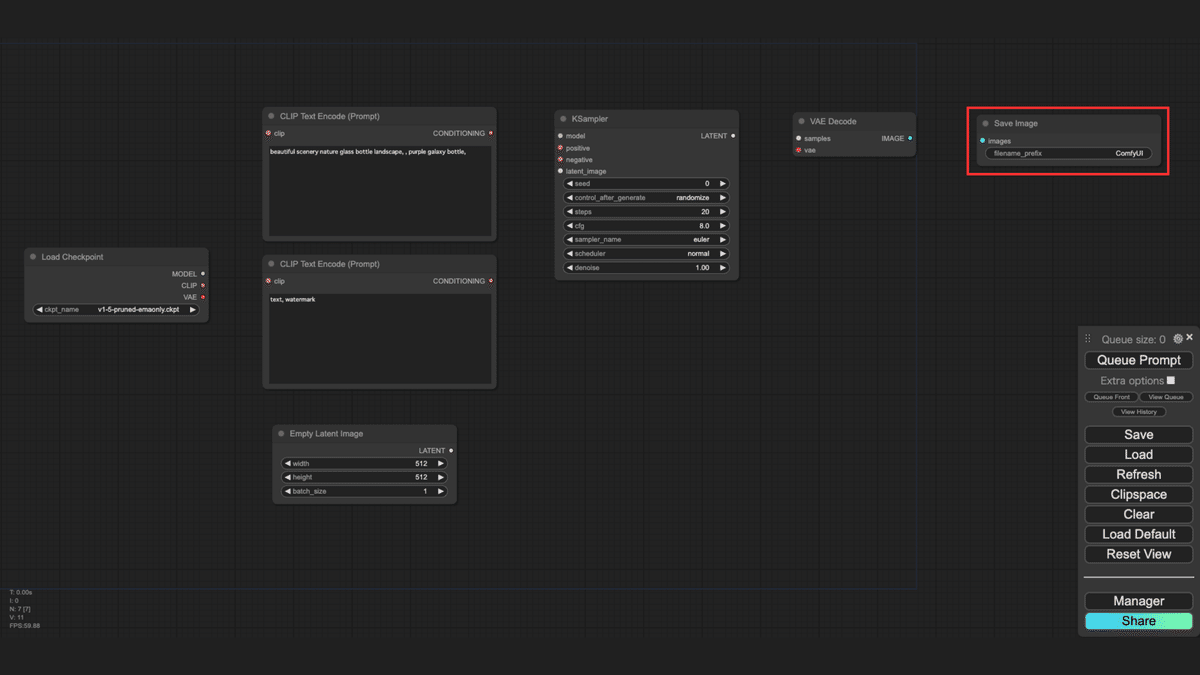

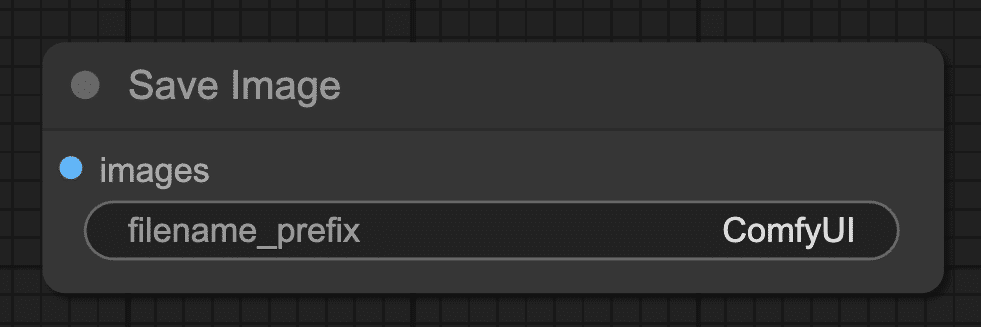

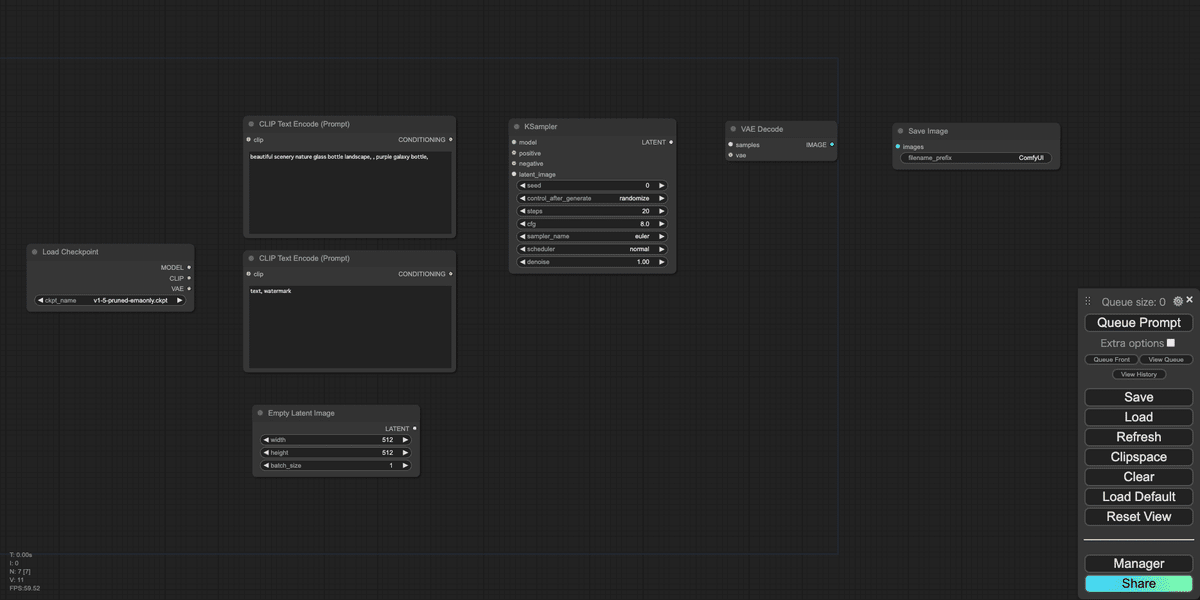

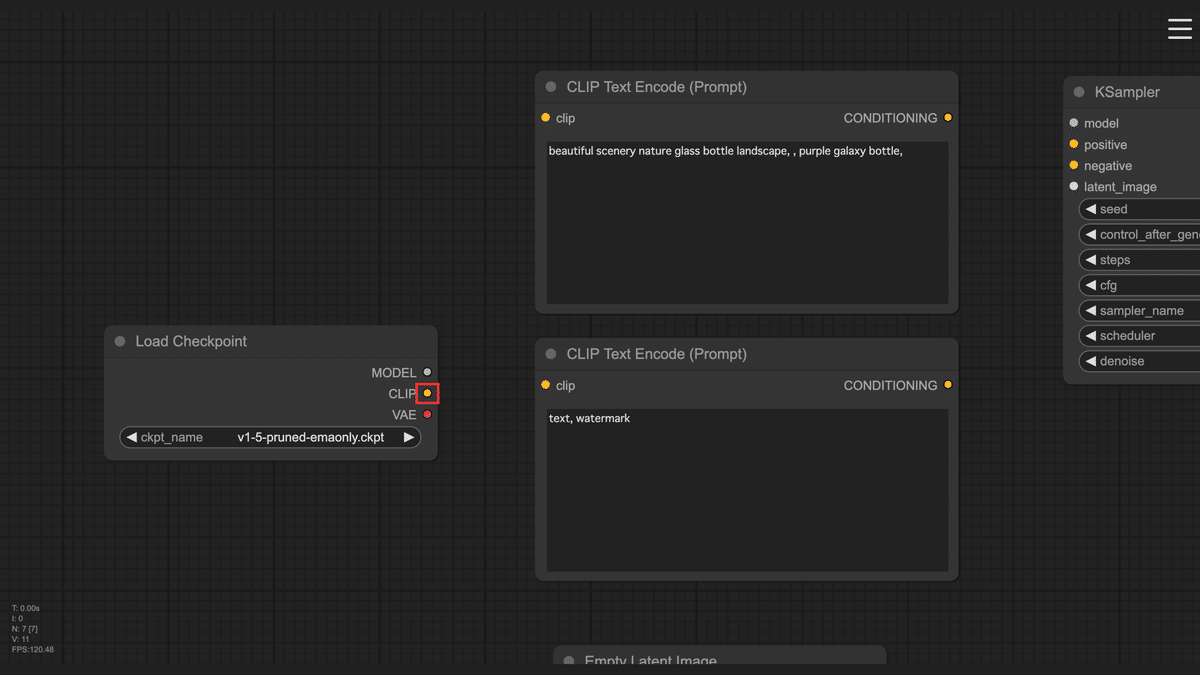

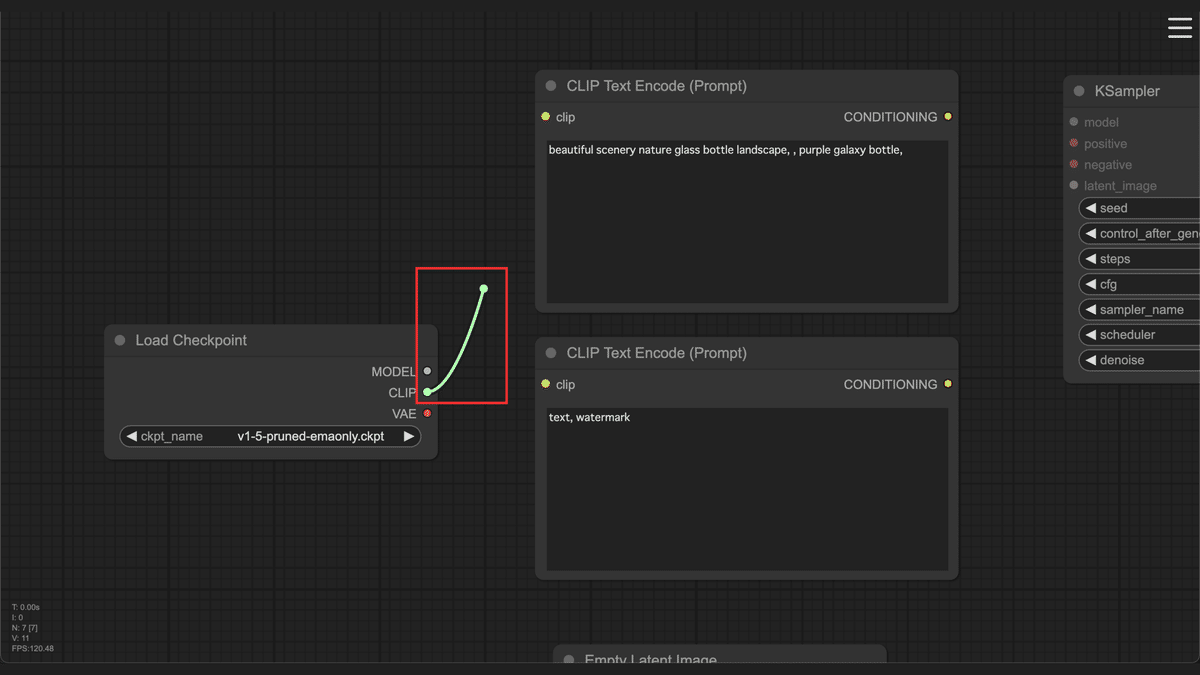

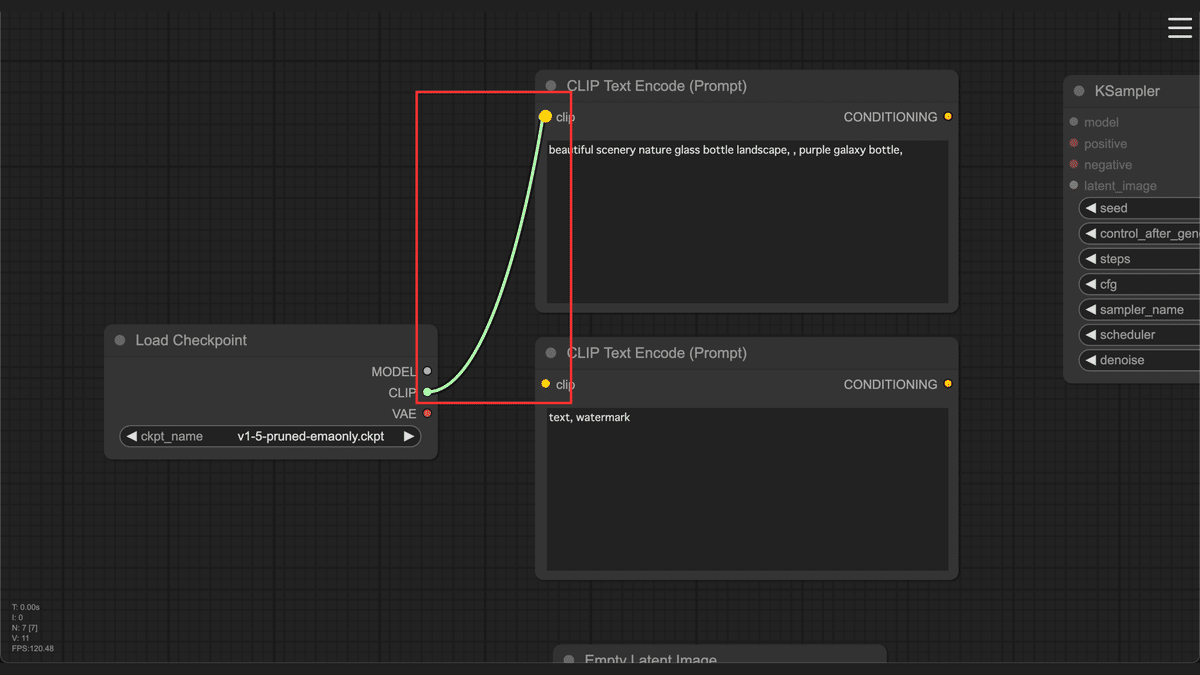

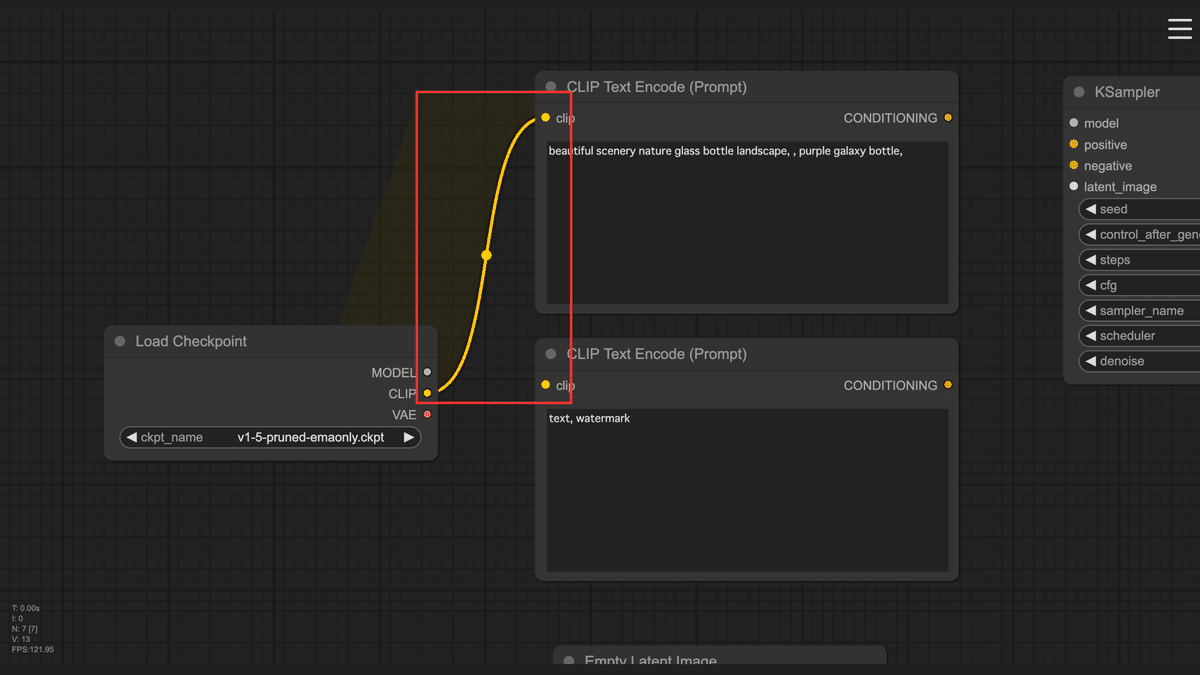

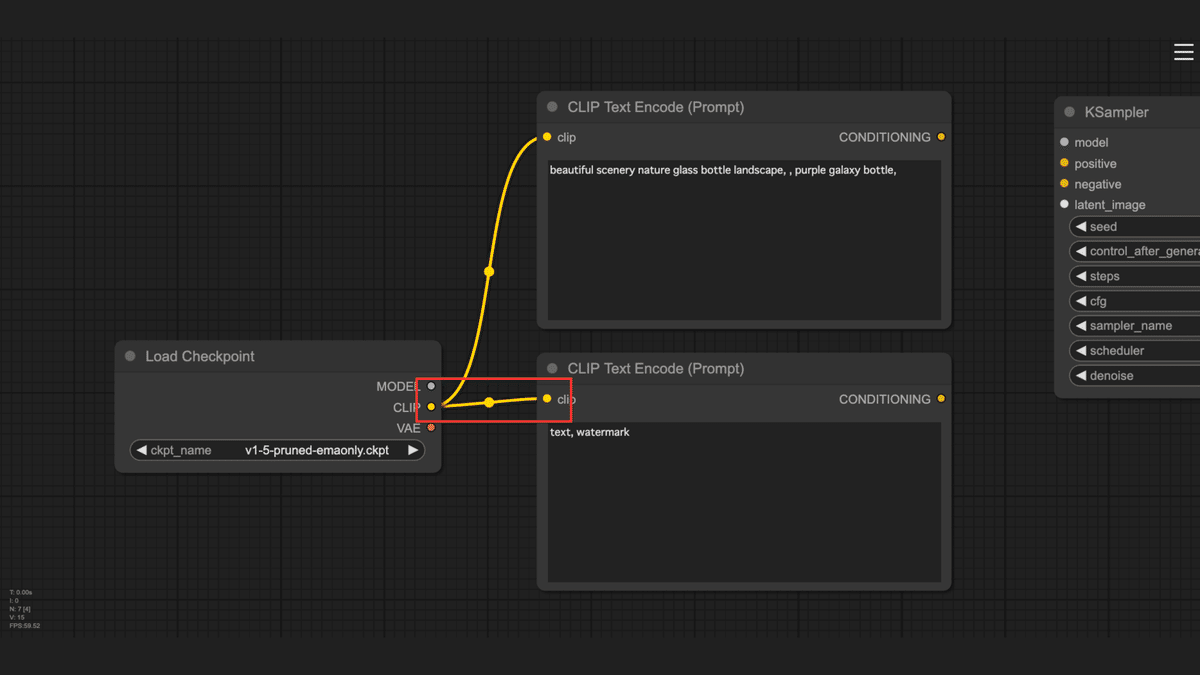

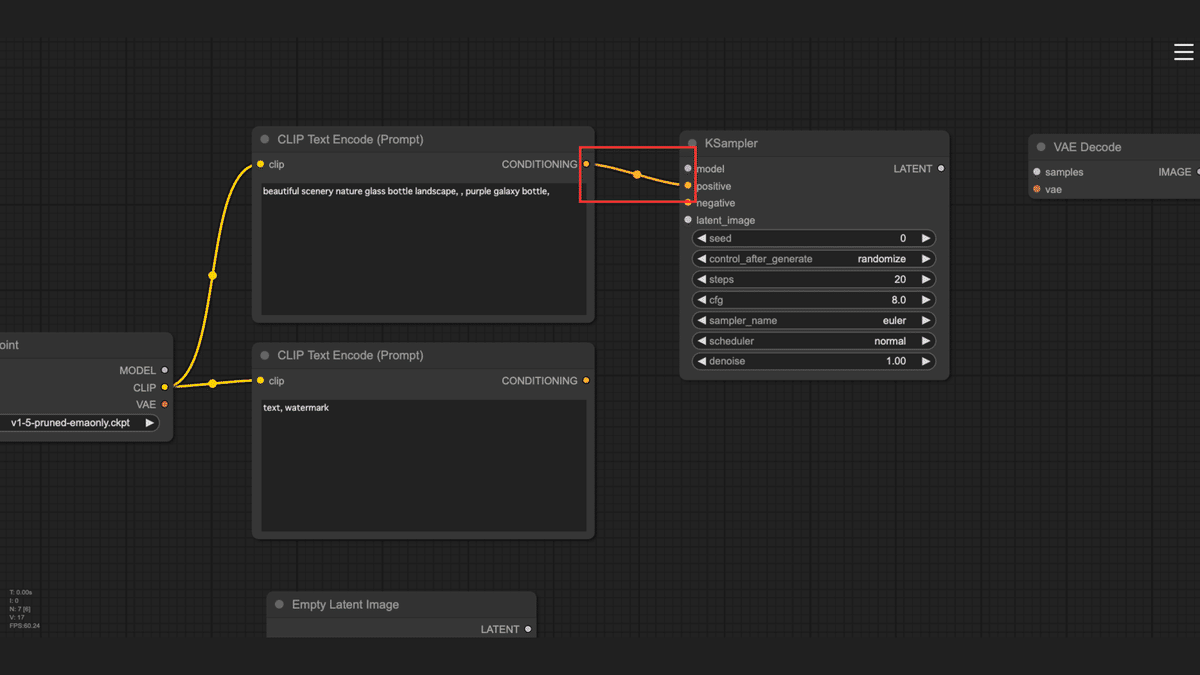

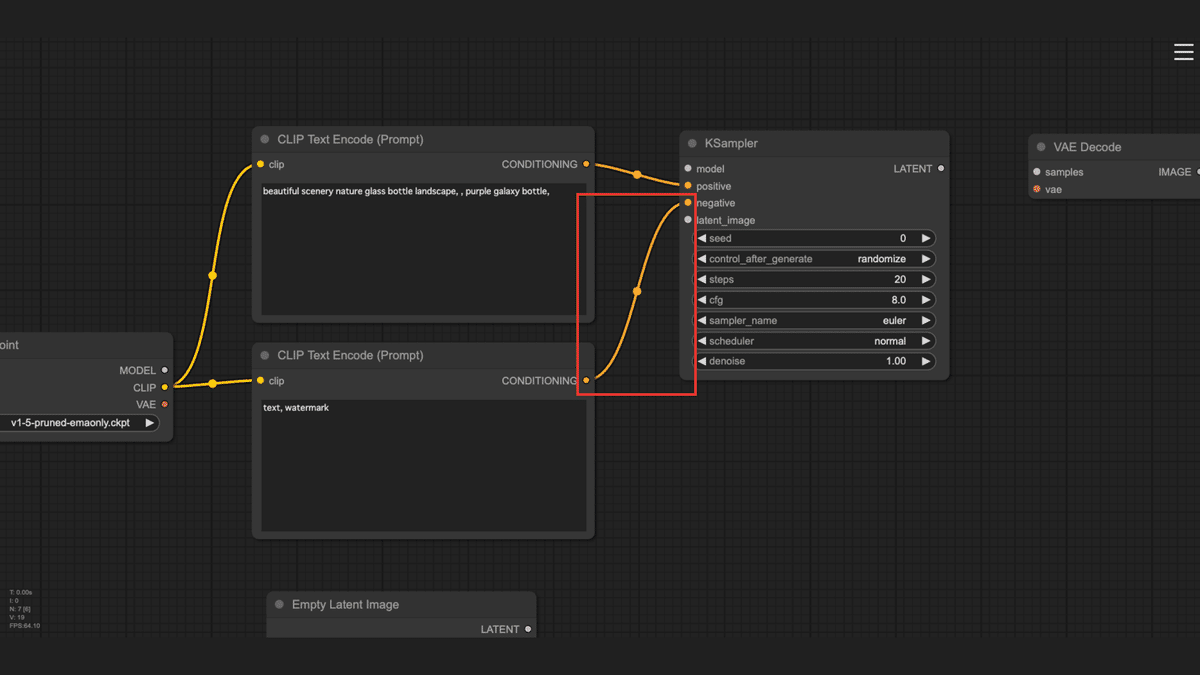

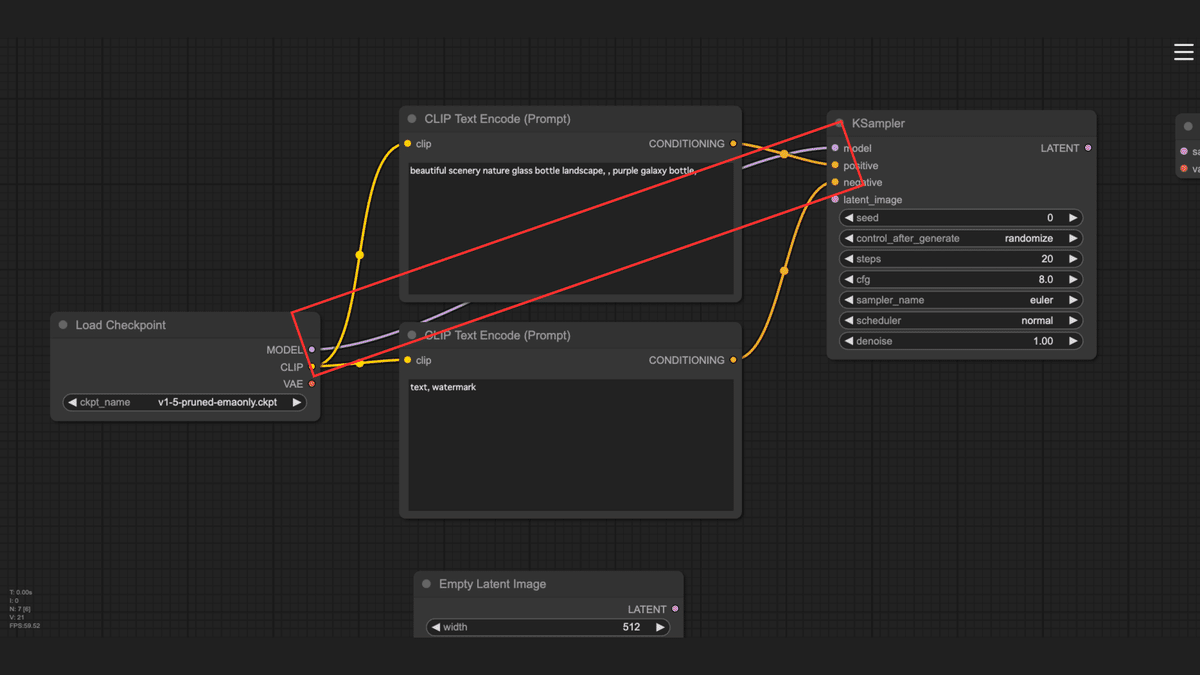

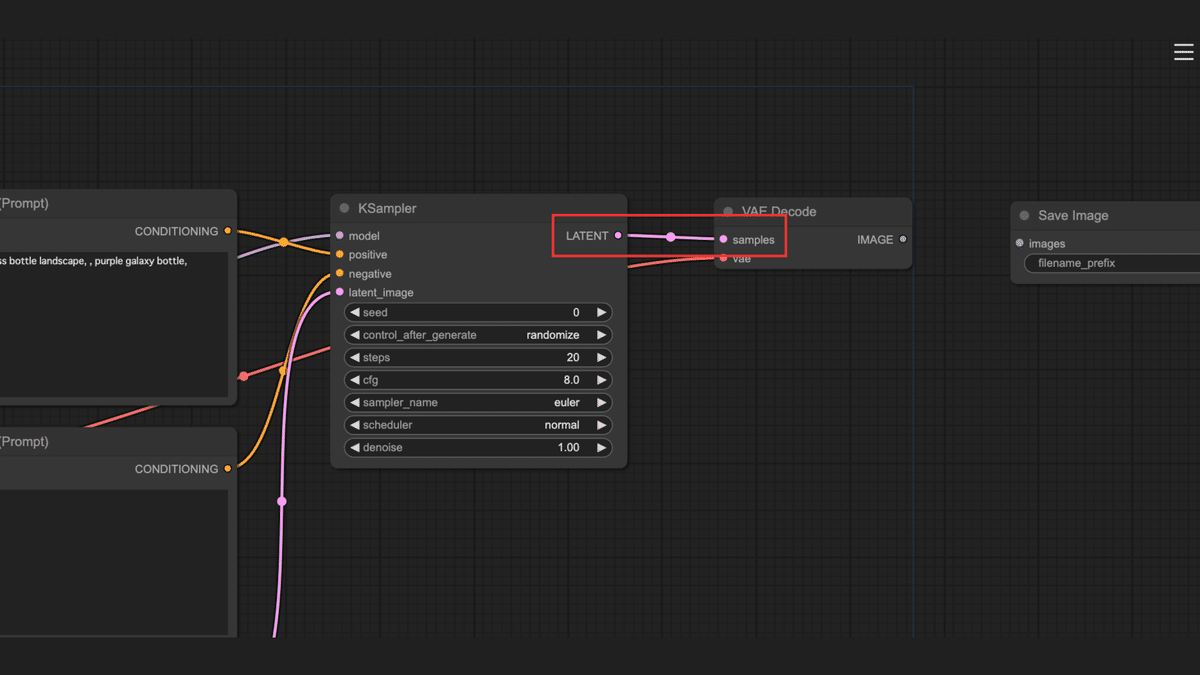

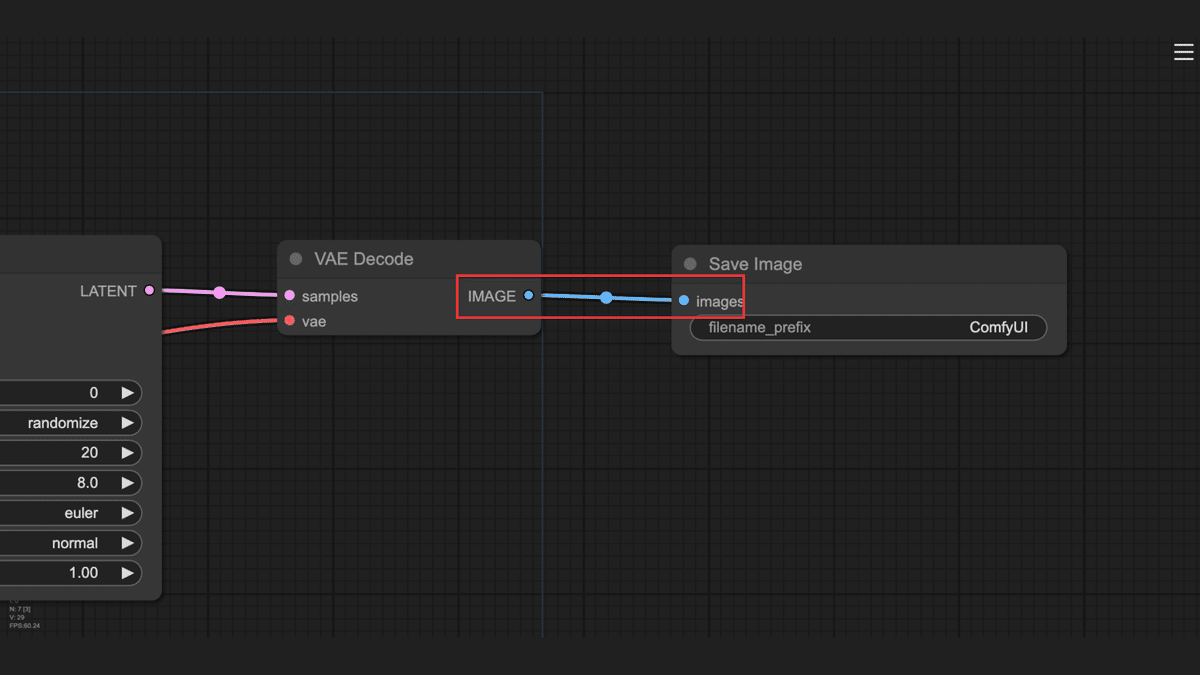

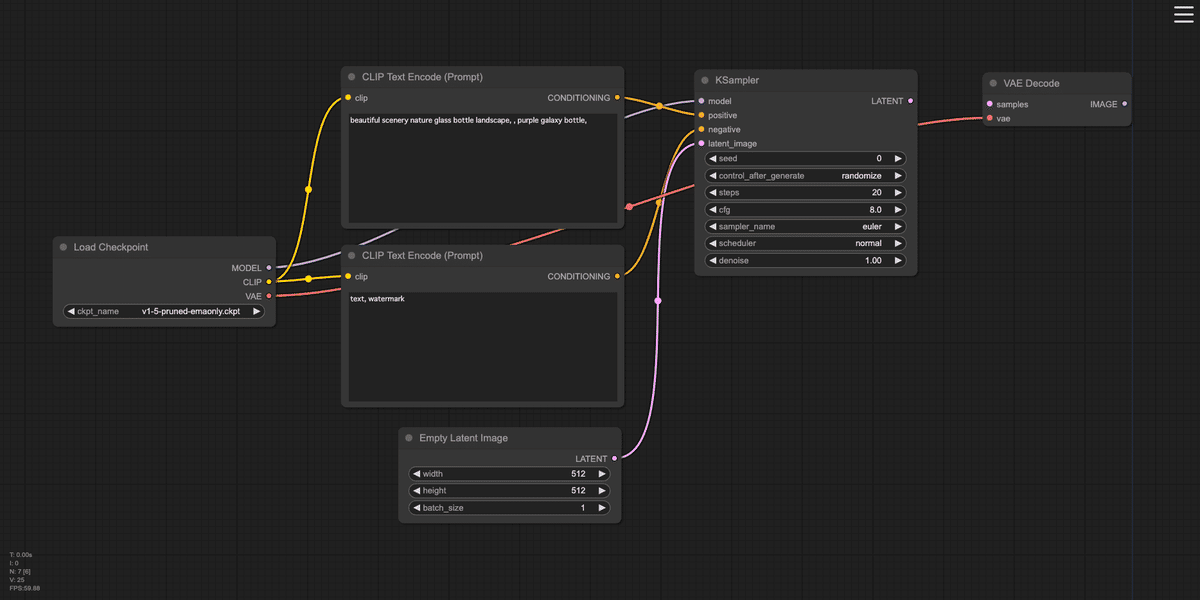

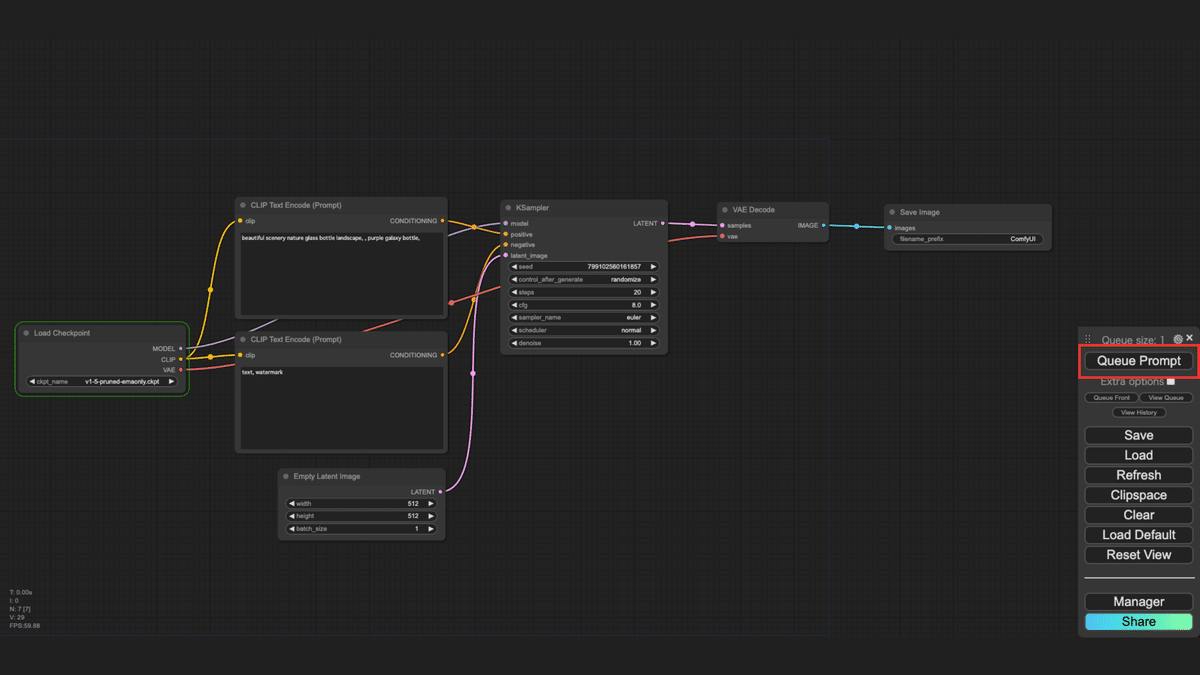

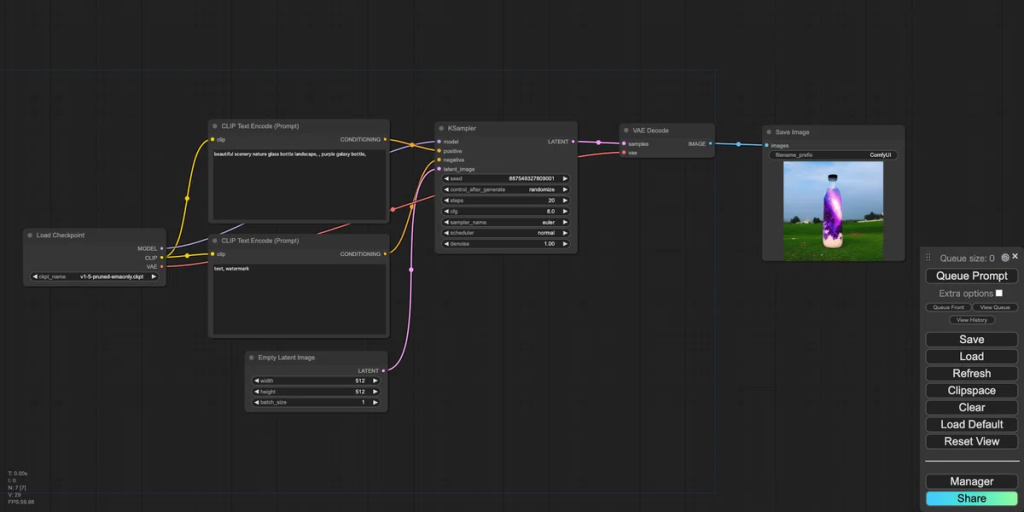

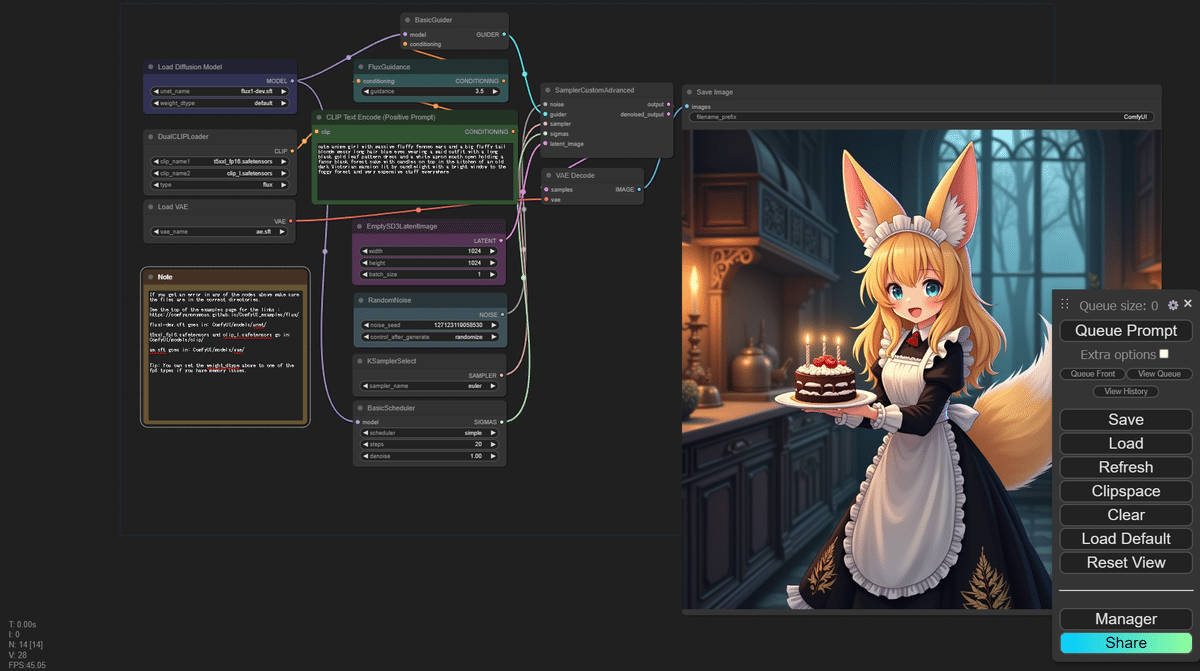

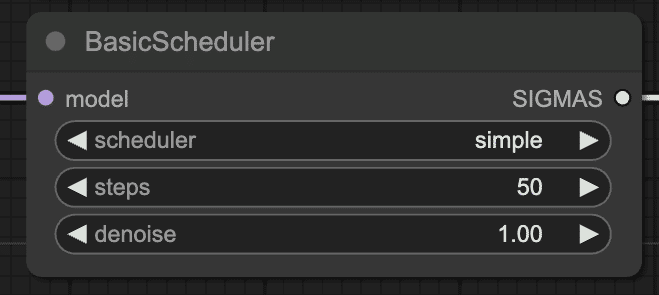

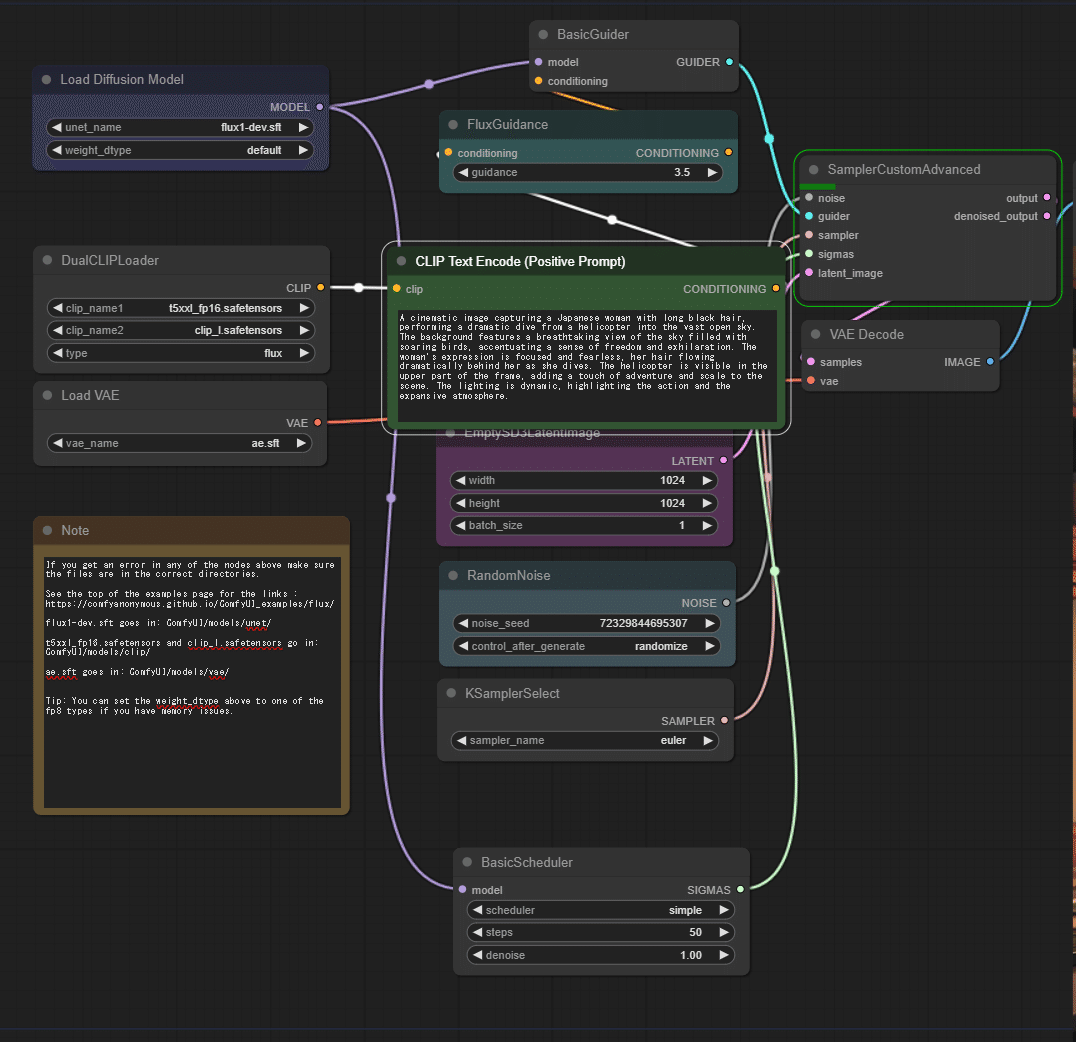

SECTION 02:環境構築

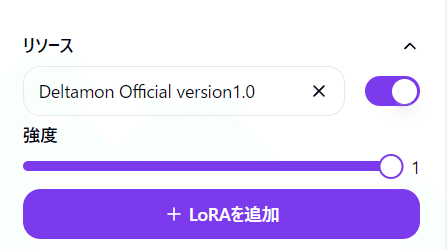

Google Slidesだけで使えるオリジナルツールが提供されます!

その他、Google Colabを使った最新のデモやサンプルもあります。

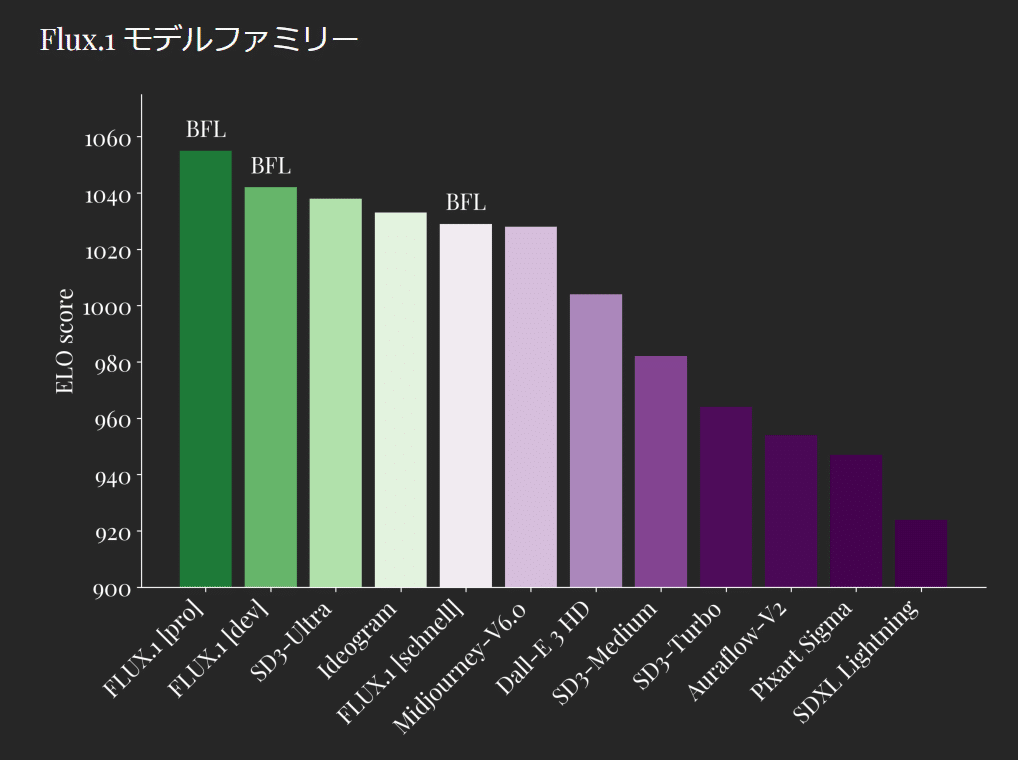

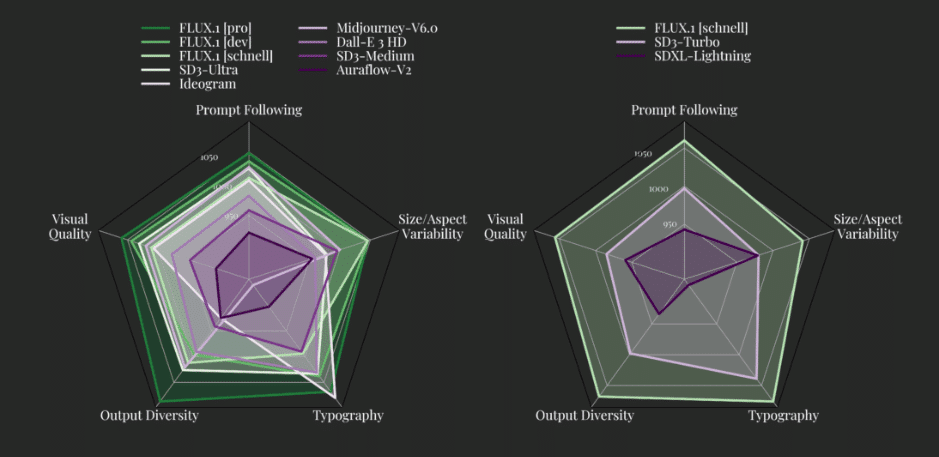

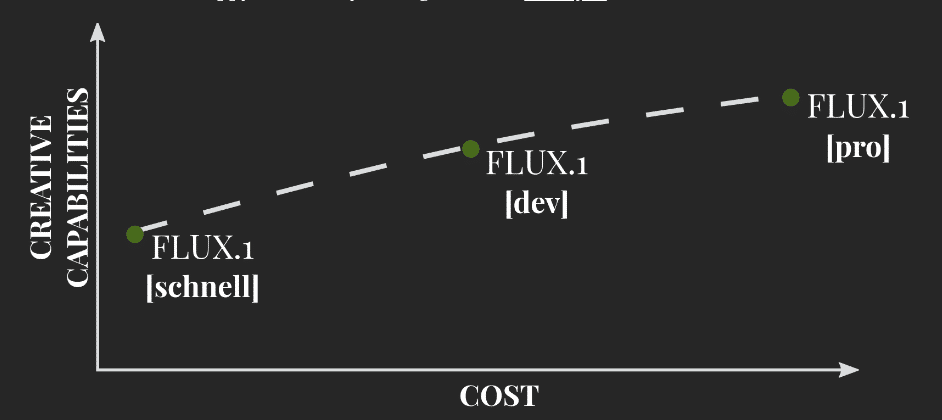

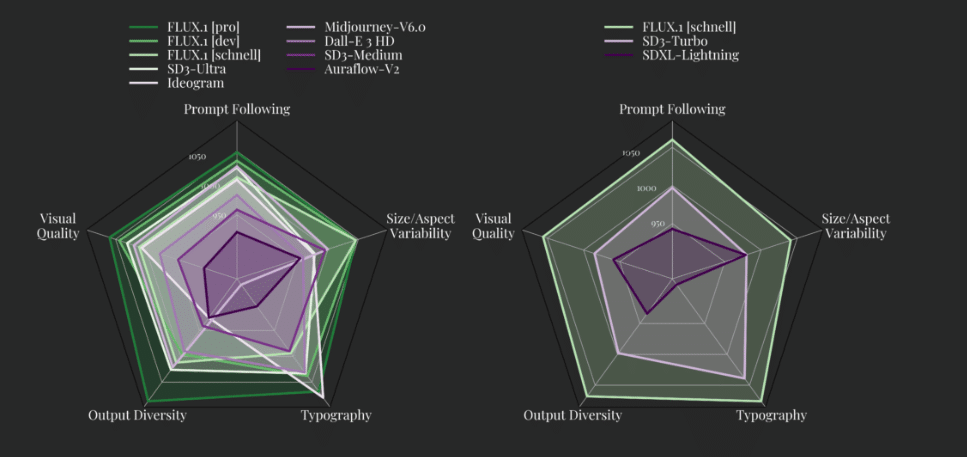

SECTION 03:基礎編[SD3時代のモデル評価とプロンプト探求]

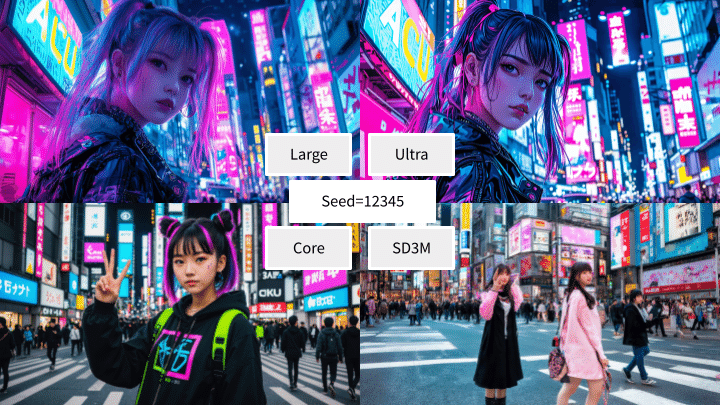

最新・最先端・高画質のモデル評価手法をしっかりマスター!

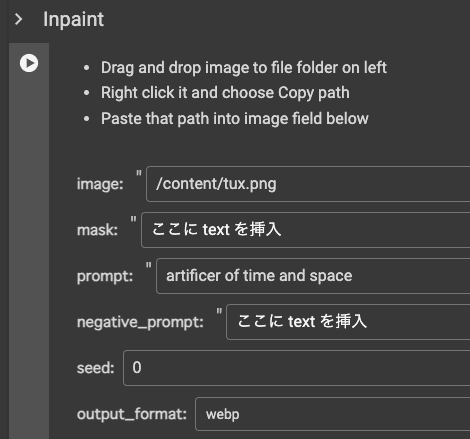

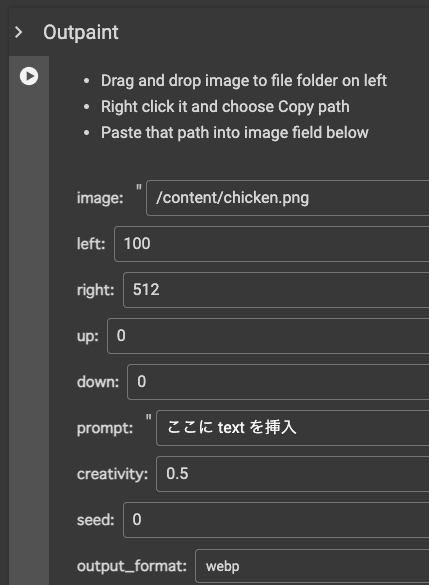

SECTION 04:Stability AI API の革新的機能

知らないと損、Stability AIのAPIだけで利用できる革新的な機能。

Edit機能を活用した画像加工

Structureを使ったポージング、構造の制御

便利なツールと、初心者向けの対話、デモなどを使ってスキマ時間にギュンギュン学べちゃう構成になっています!

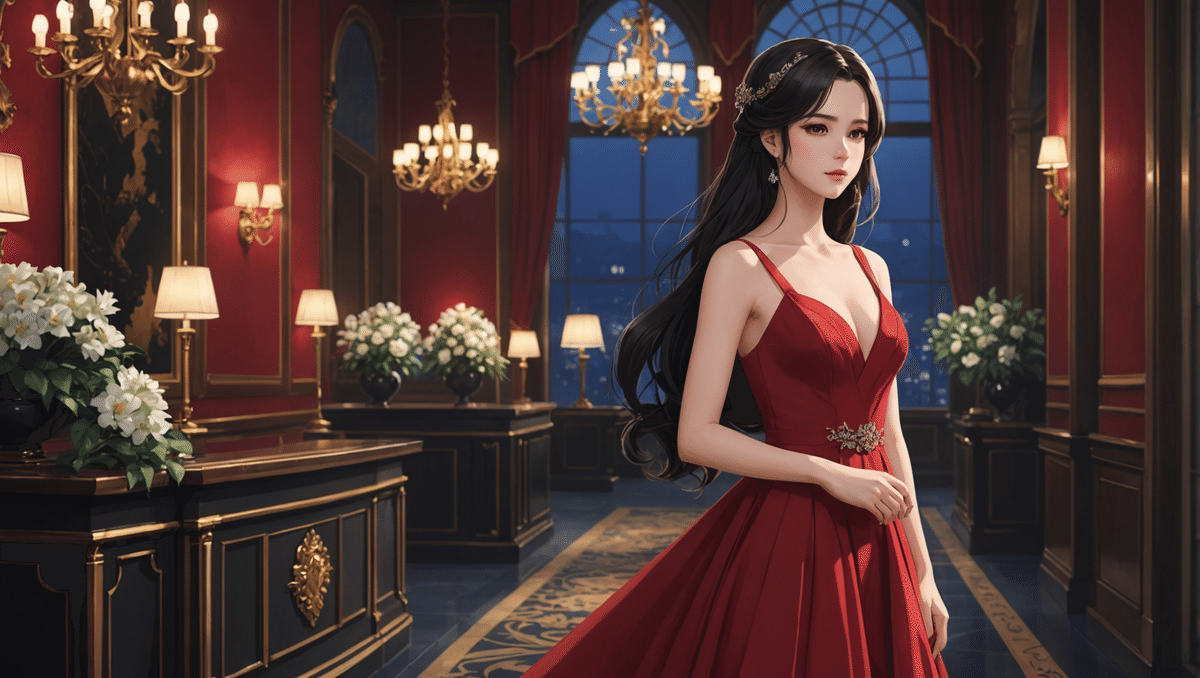

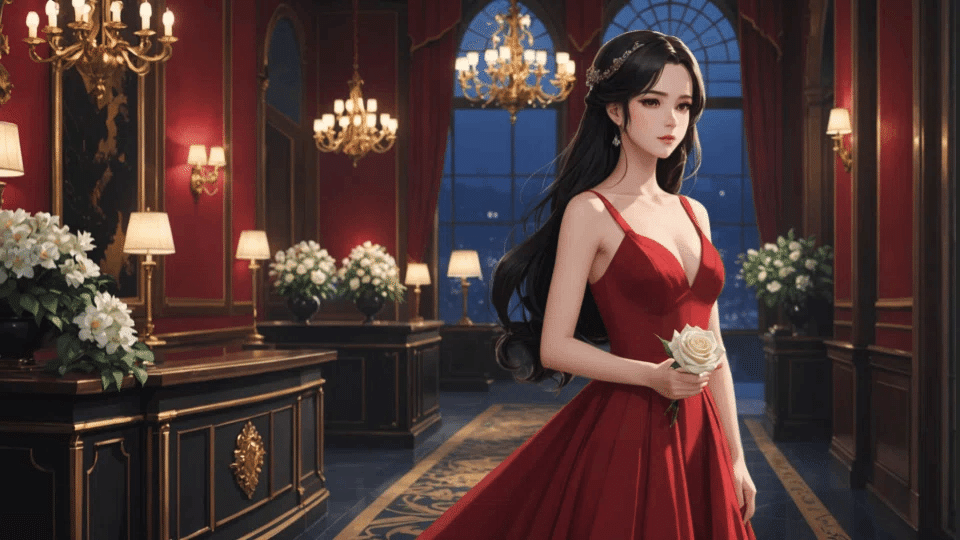

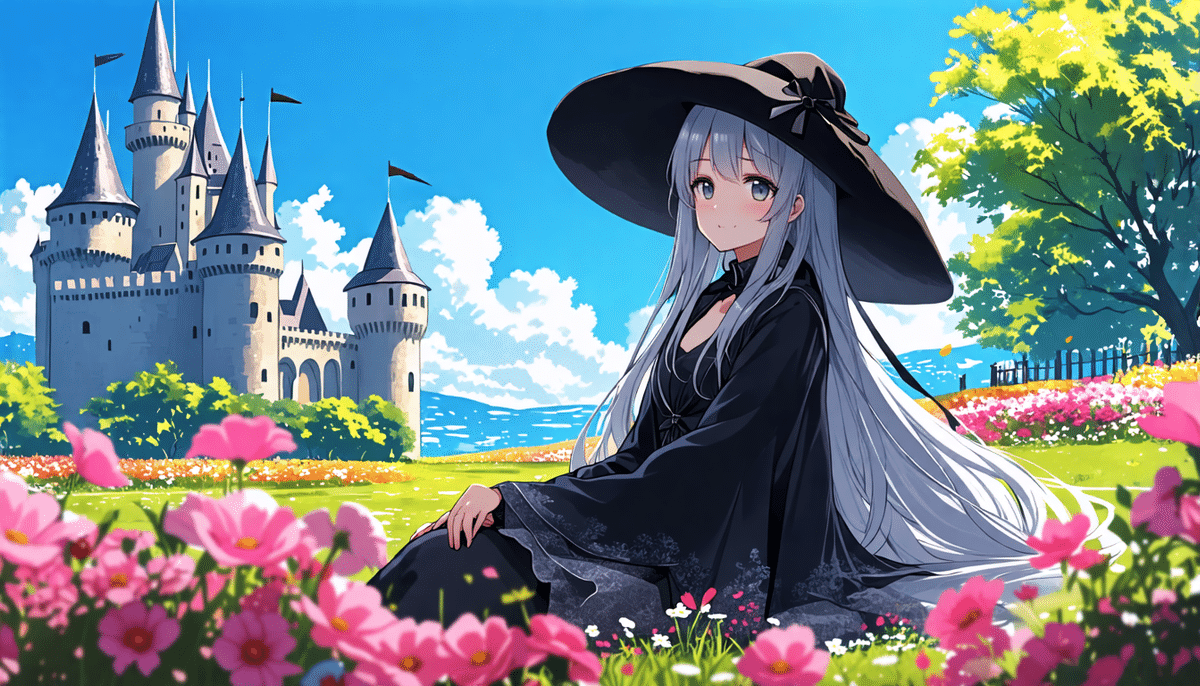

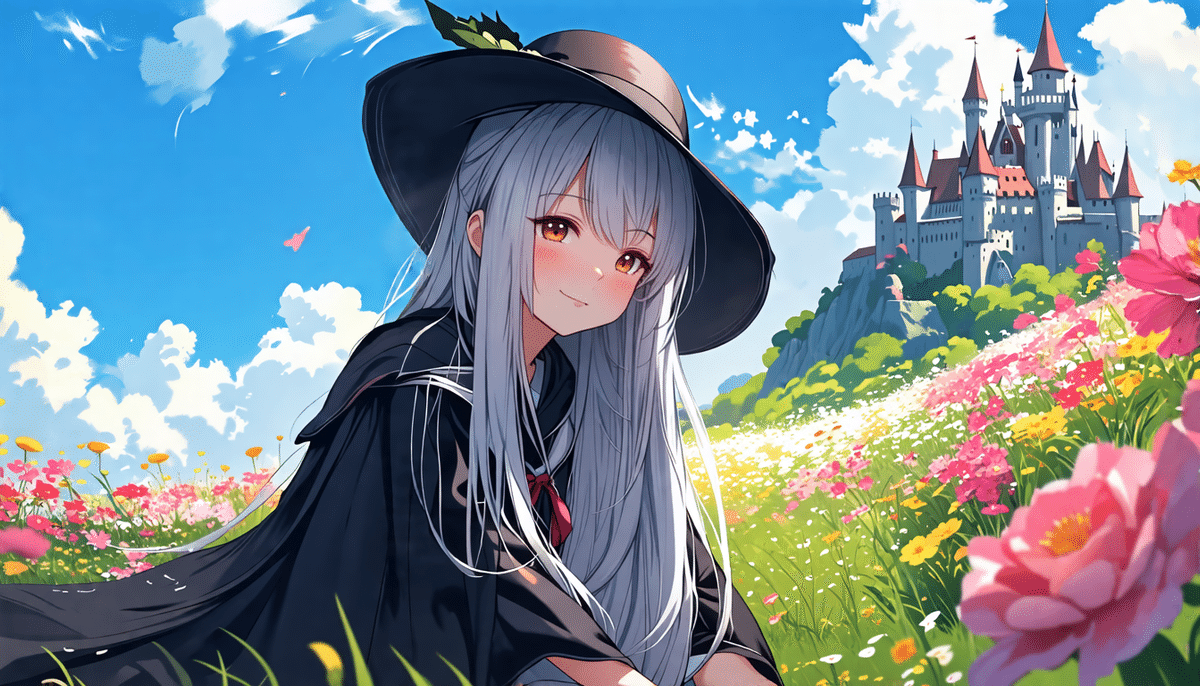

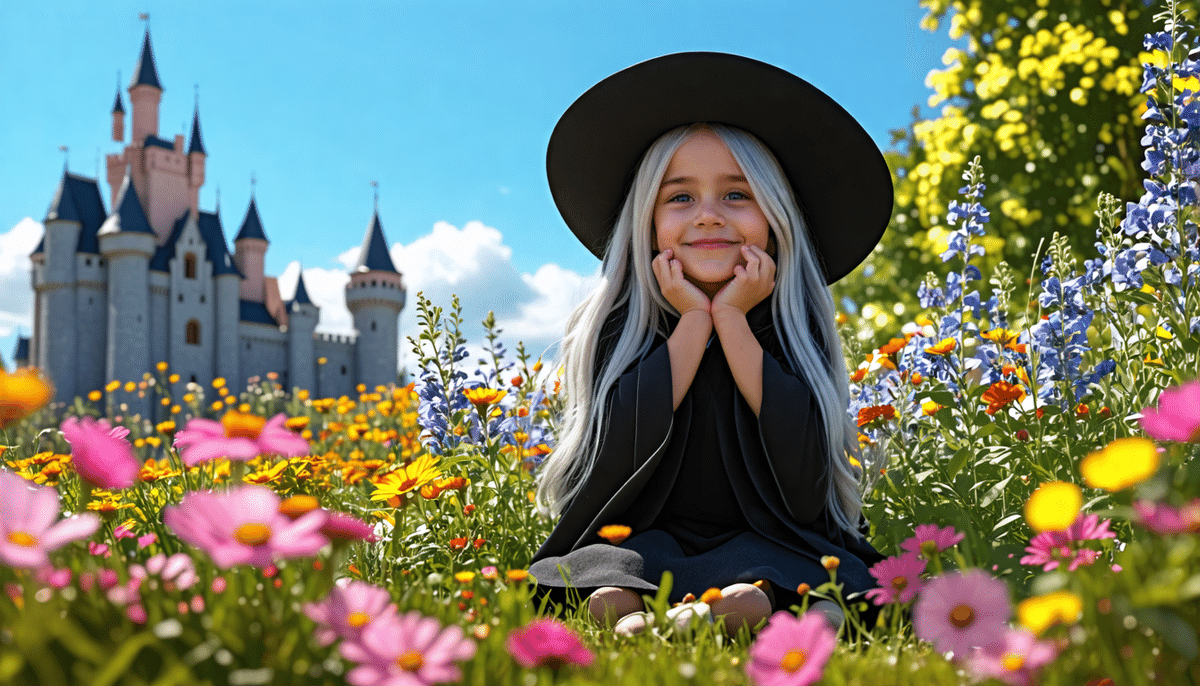

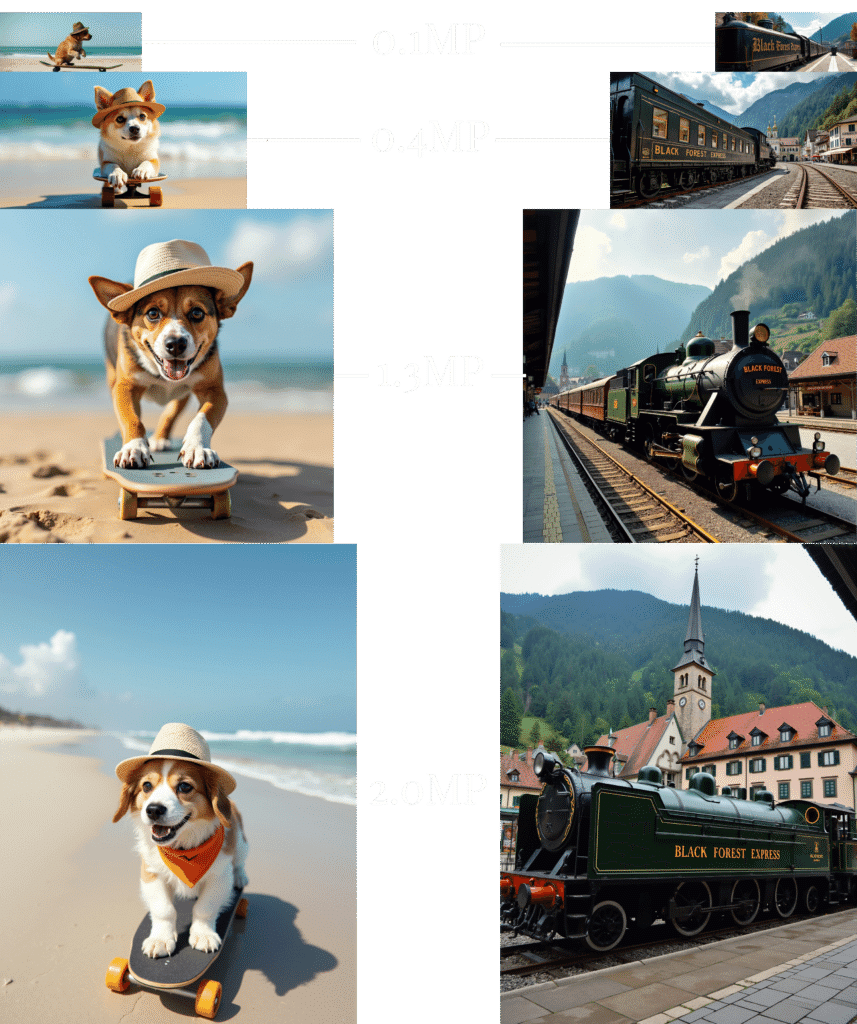

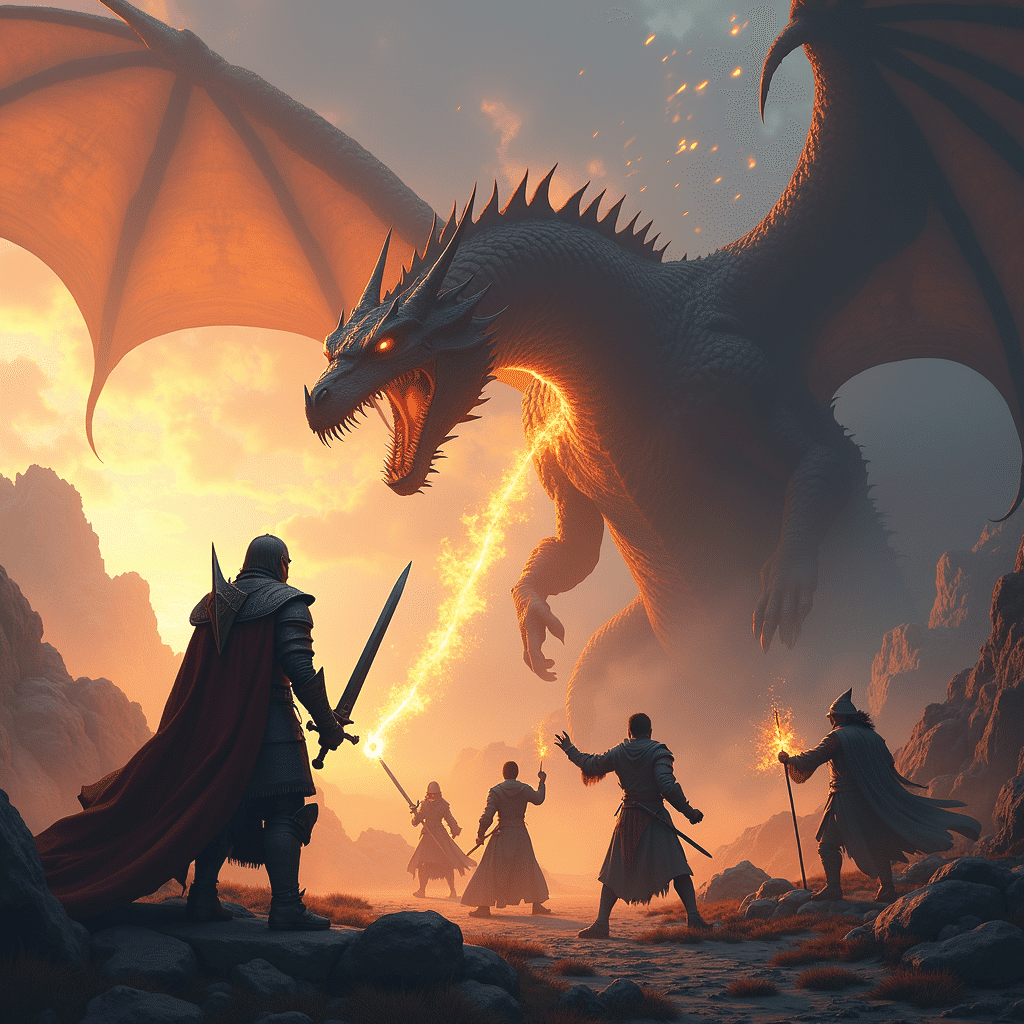

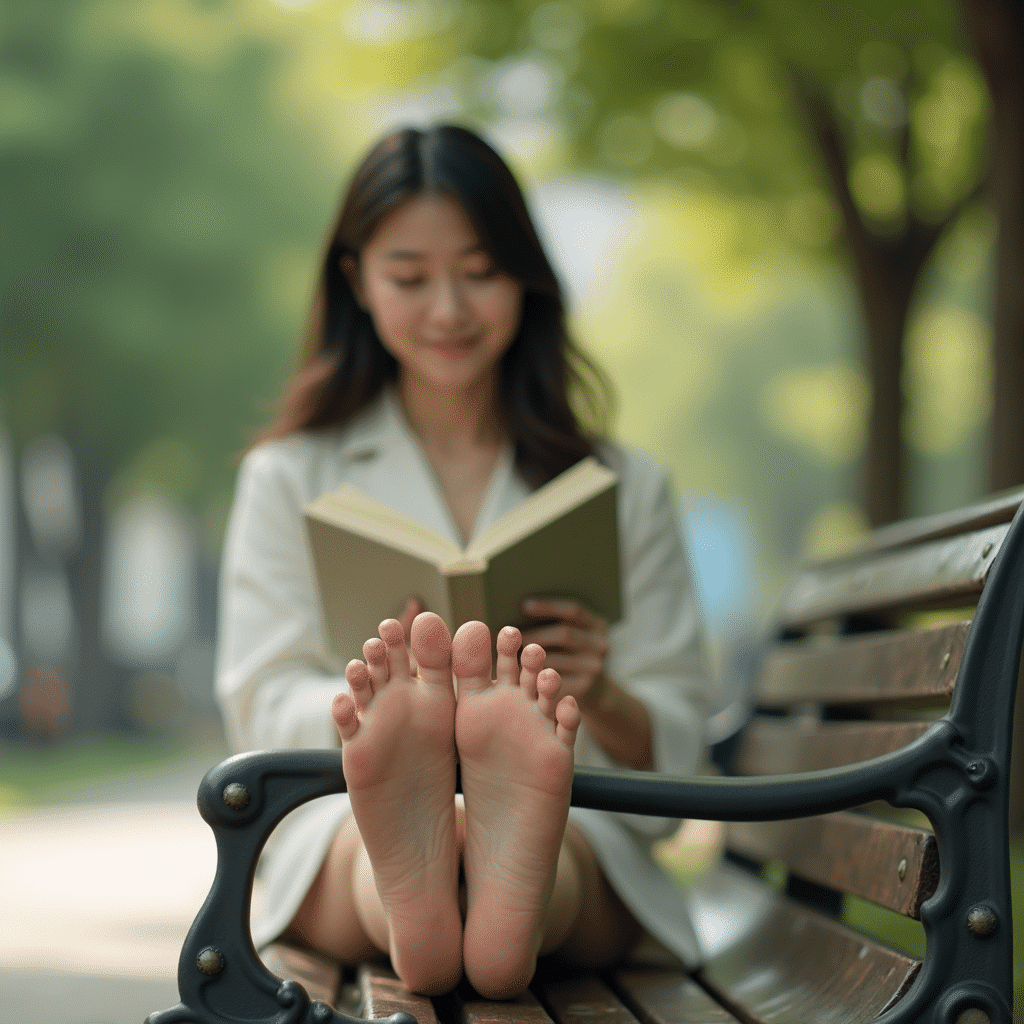

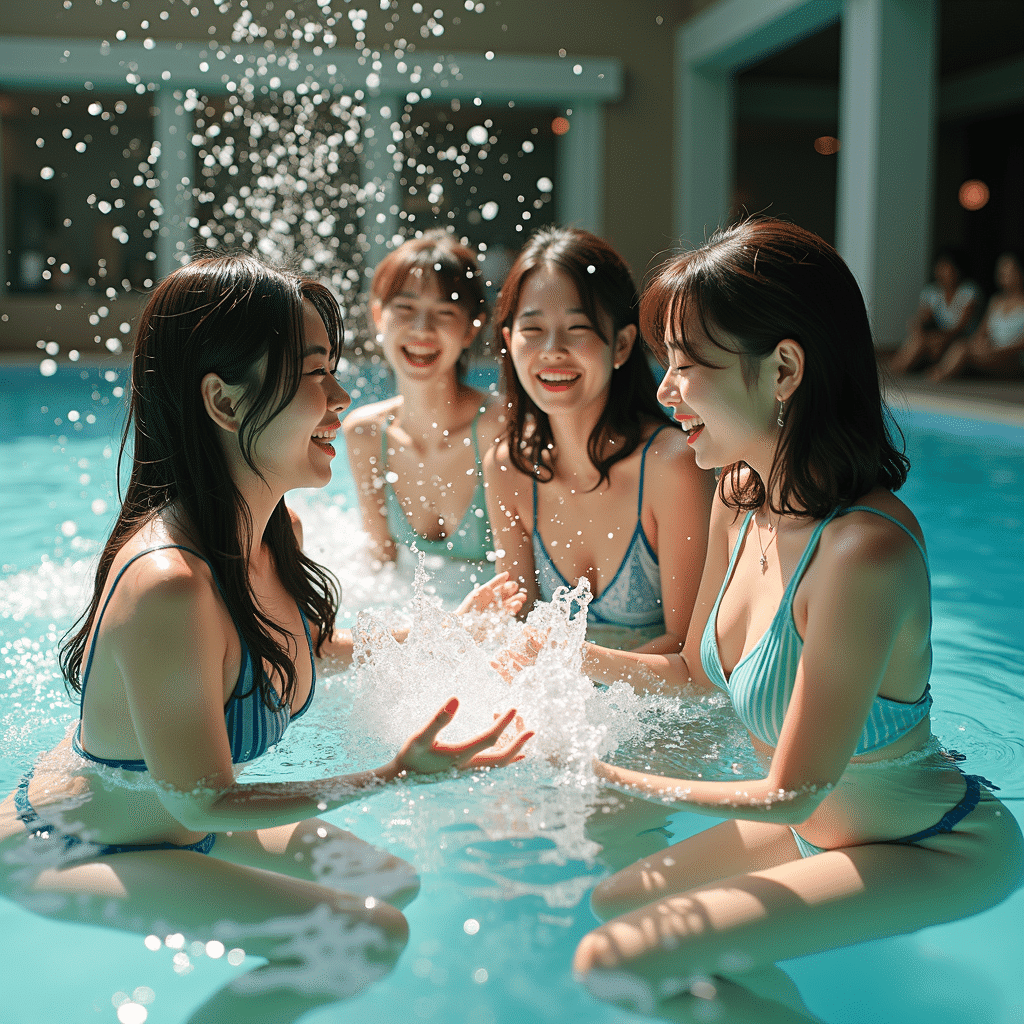

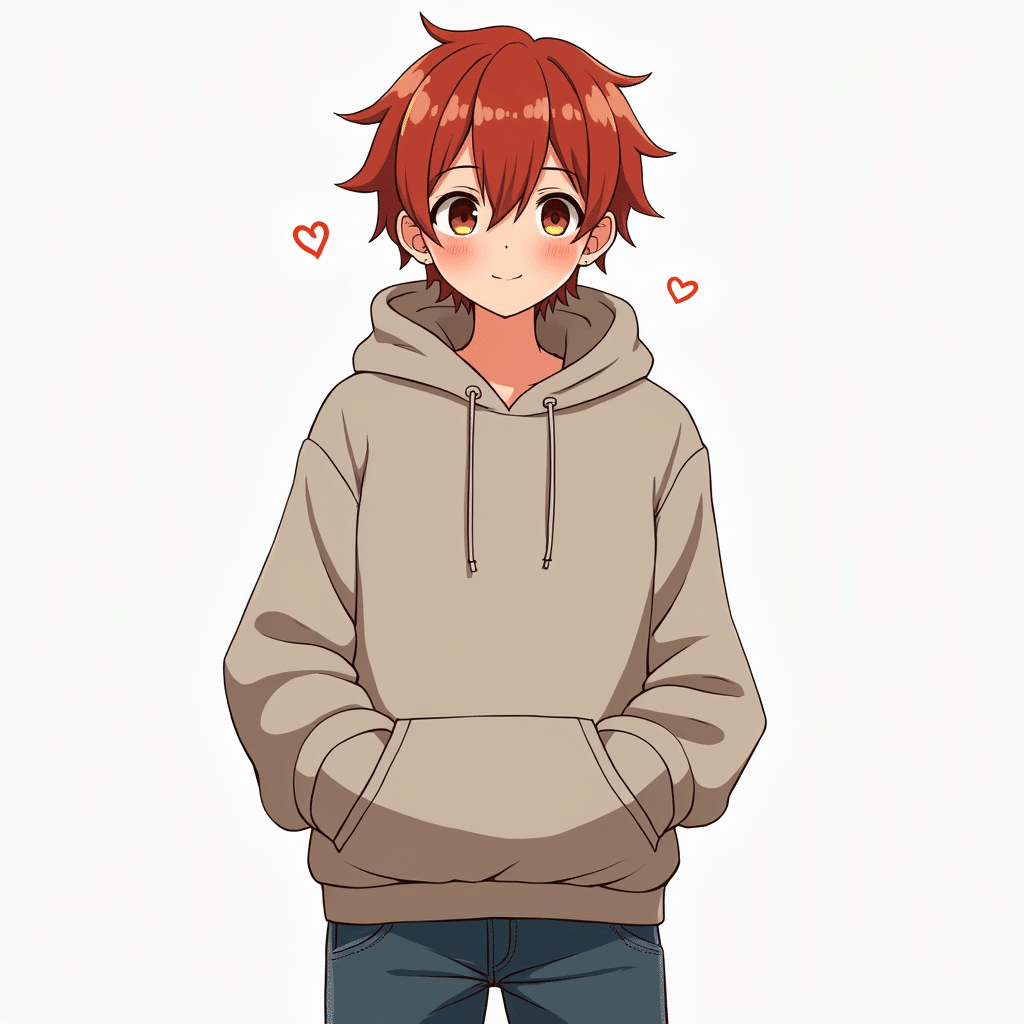

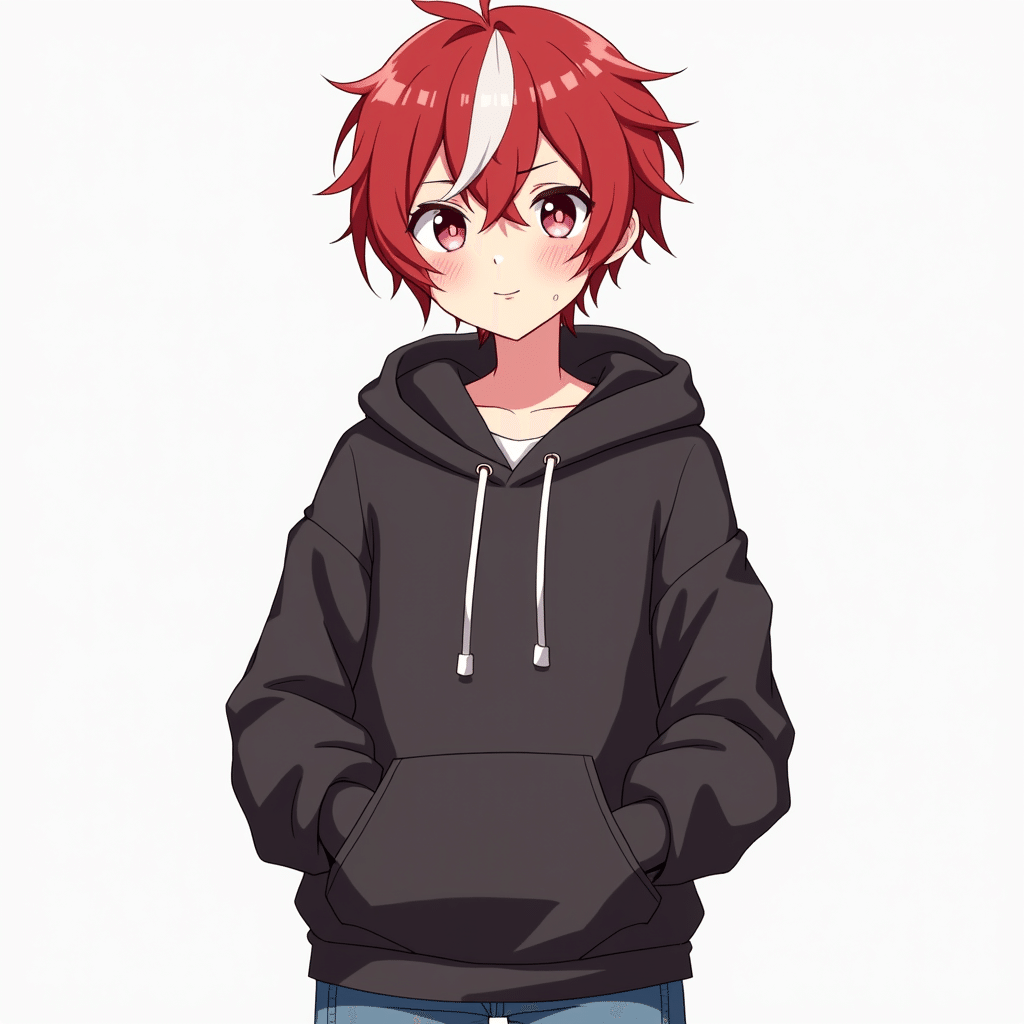

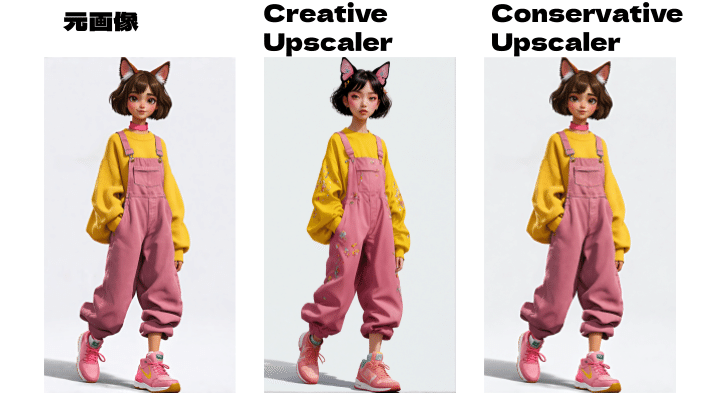

SECTION 05:応用編 [バーチャルファッションモデルの開発]

バーチャルなファッションブランドのルックブックを作ってみましょう!

卒業制作や研究、企業のプロトタイプとして実践的なワークフローを学ぶ最高のチャンスです。

SECTION 06:活用編 [広告バリエーションの展開と評価手法]

広告バリエーションの制作にお悩みではありませんか?

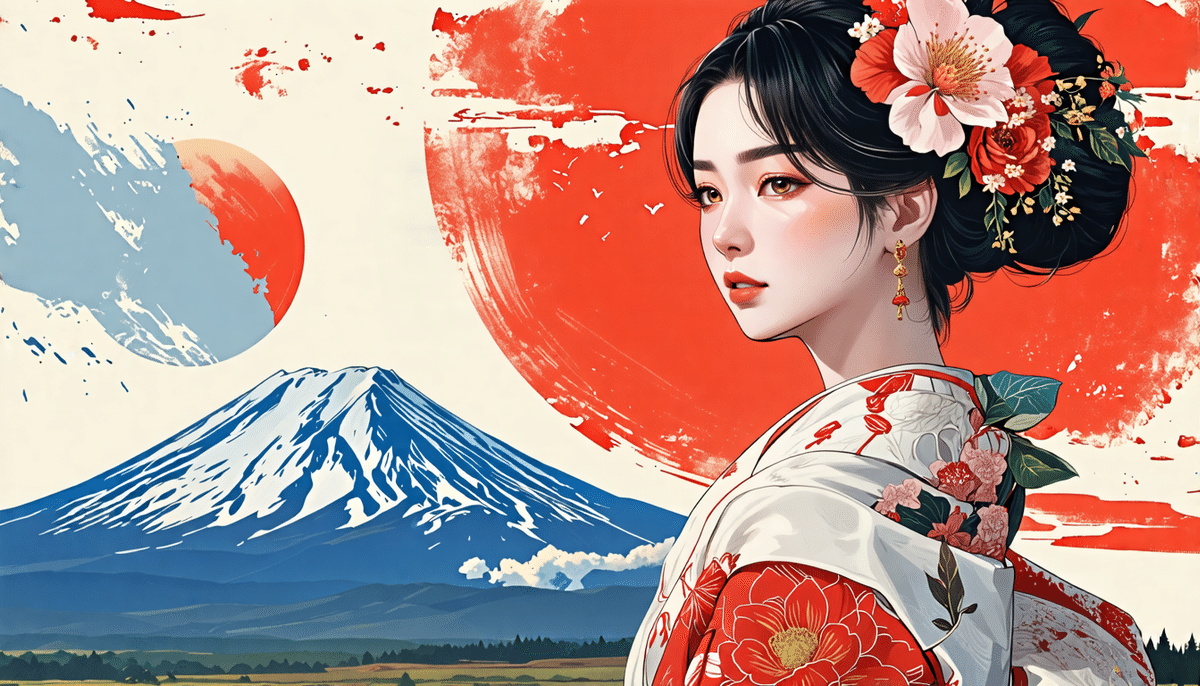

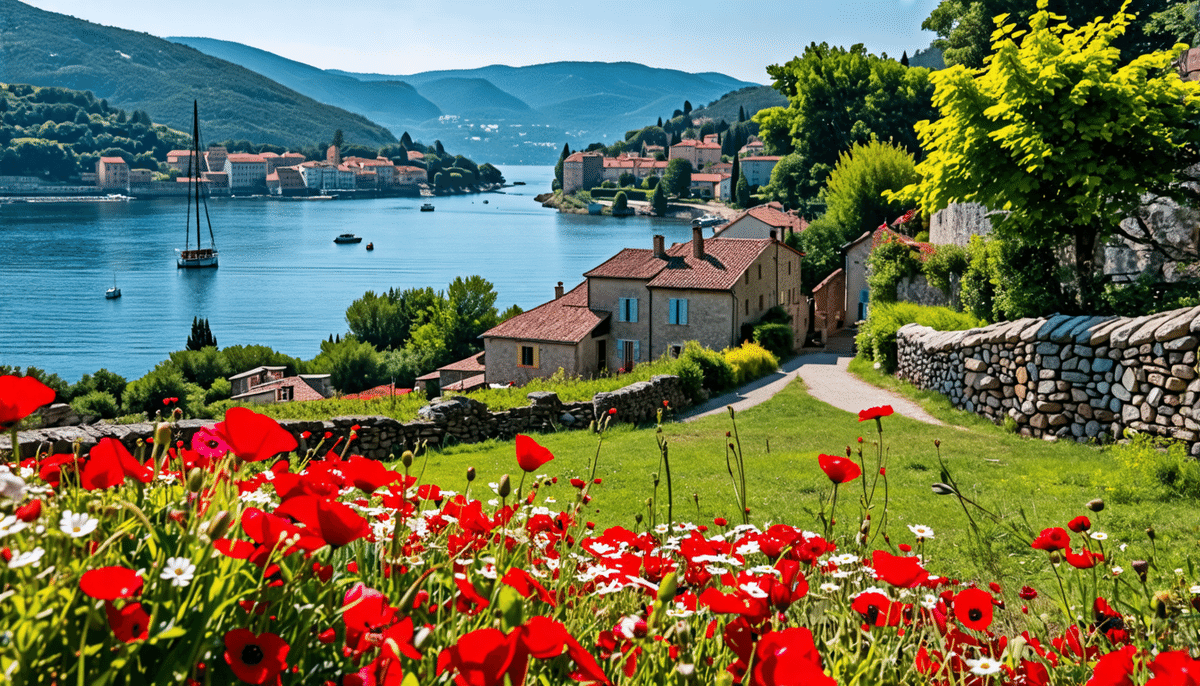

旅行代理店の広告制作を通して、画像生成AIを使った具体的な広告バリエーションの制作フローを体得できます。もちろんChatGPTを使いこなすプロンプトも含まれています!

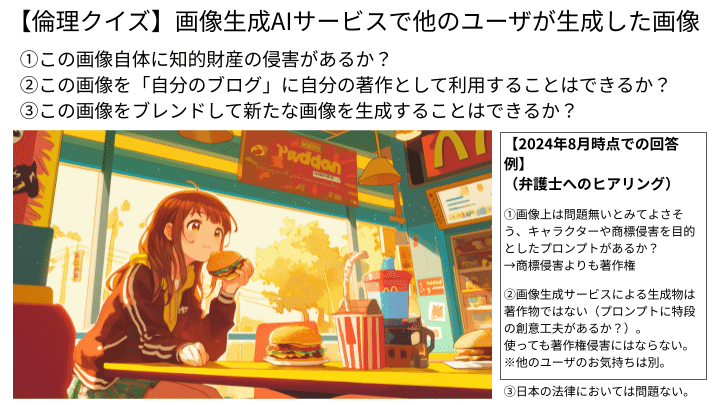

SECTION 07:法律・倫理・未来

「画像生成AIって違法なの?」法律だけではありません、生成AIクリエイティブ分野の社会実装でトップランナーを続けてきたAICUならではのノウハウ、国家試験である知的財産管理技能検定に基づいた理解と解説、弁護士とのヒアリングで開発した倫理クイズ、子供でもわかる画像生成AIの「陽の当たる未来」のための重要なポイントを他人に説明できるレベルで体系的に学ぶことができます…!

受講生全員に提供:AICUの講座だけの特典

- AICUによる画像生成AIに必要な知識が詰まった、講座動画25講を期間制限なしで受講可能

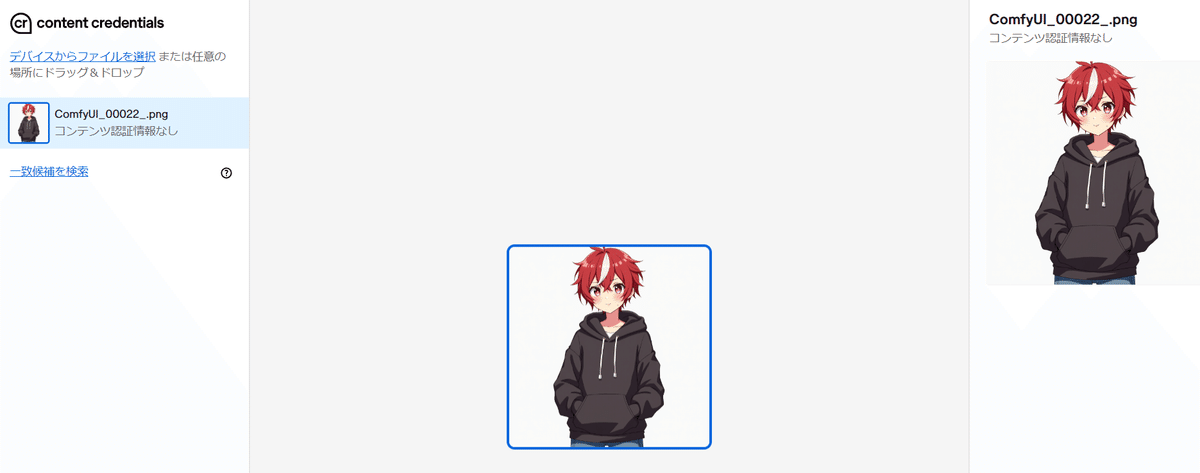

- 講座を通してセミリアルや実写など12点の例題を完成

- 講座内容に関するPDFデータや資料、Google Slidesで使えるツールを提供

- 画像生成プロンプト

- 講座で生成するイメージのプロンプト集提供

- 講座資料提供

- AICUのノウハウが詰まった講座PDF使用を提供

豊富な例題を通して学ぶ画像生成AIの基礎!

- ゴールの設定

- Google Slidesで使える自動スライド生成

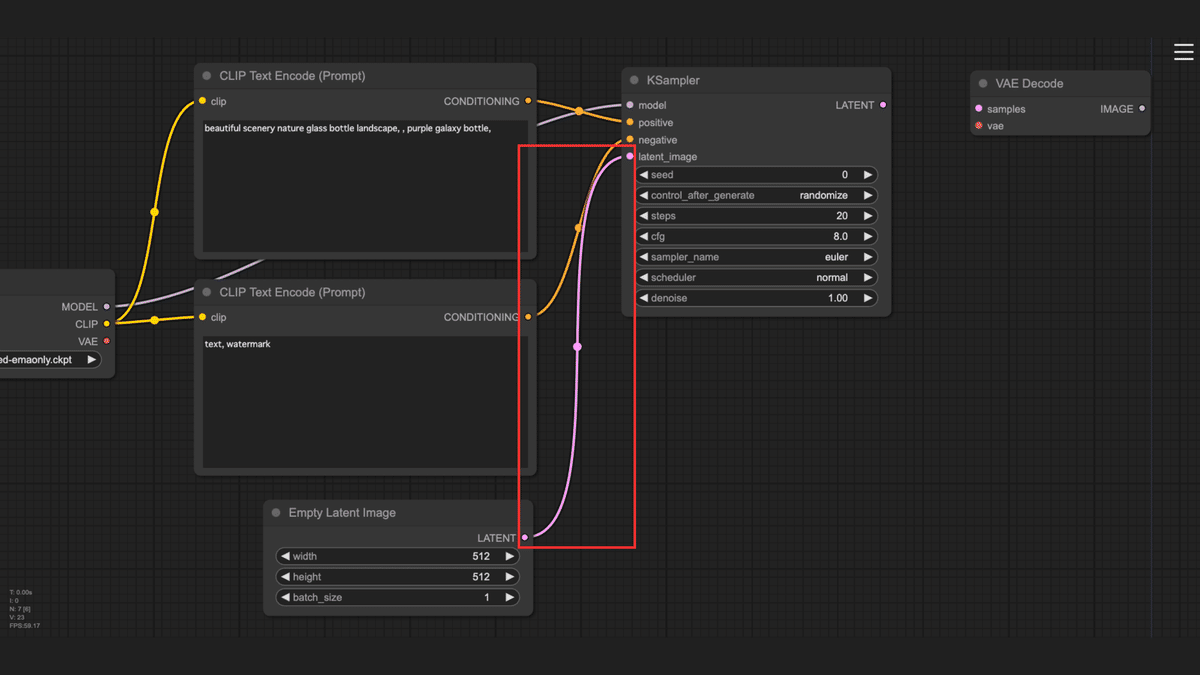

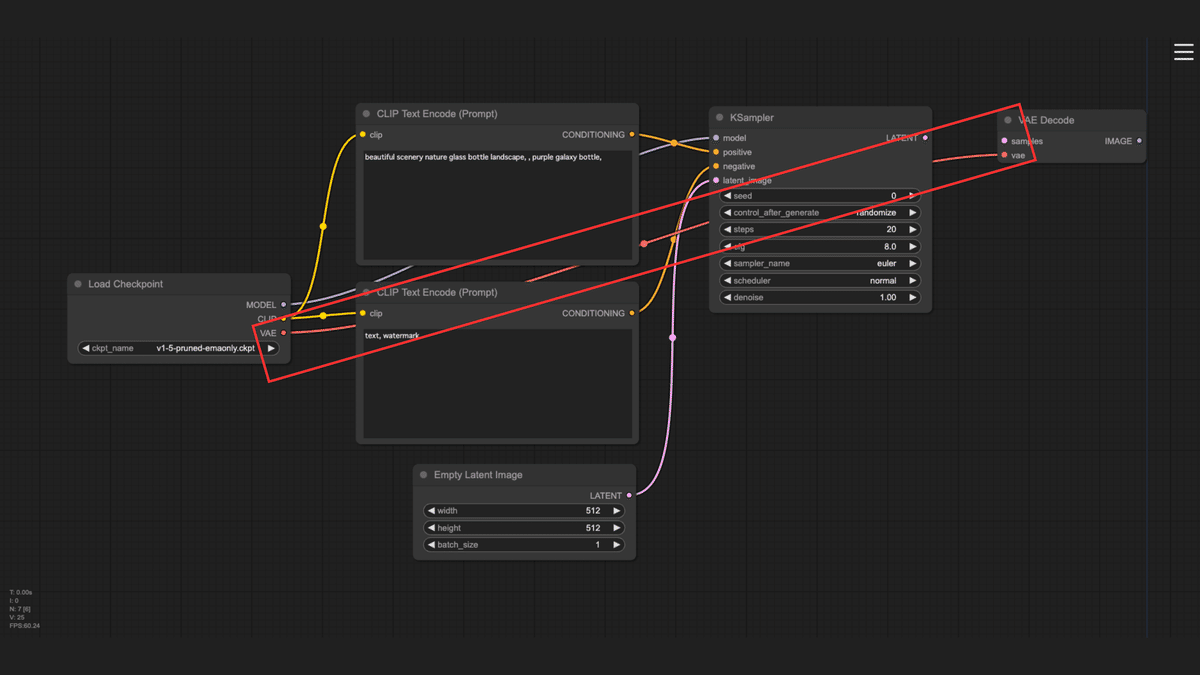

- Google ColabによるStability AI公式サンプルの動作確認

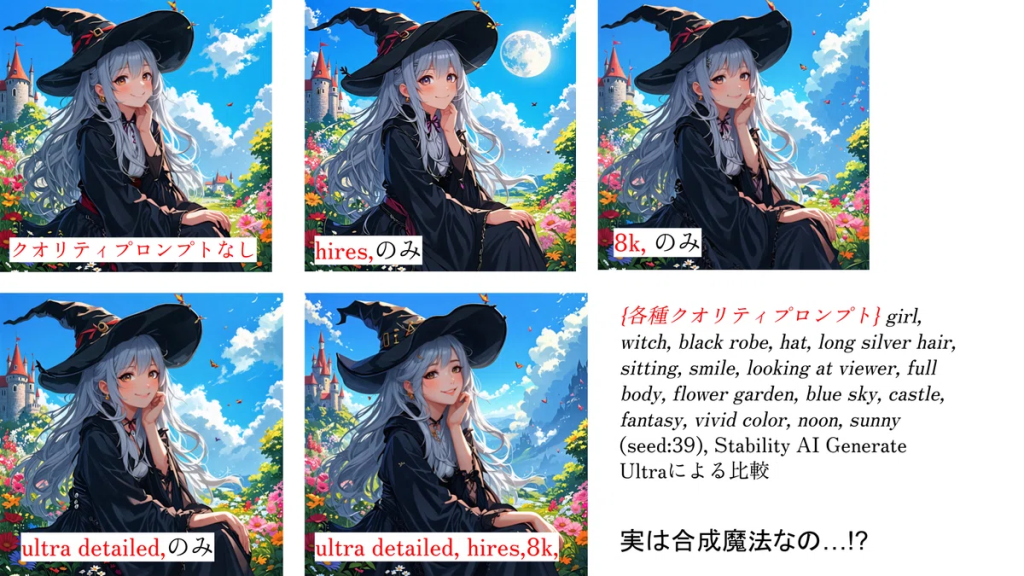

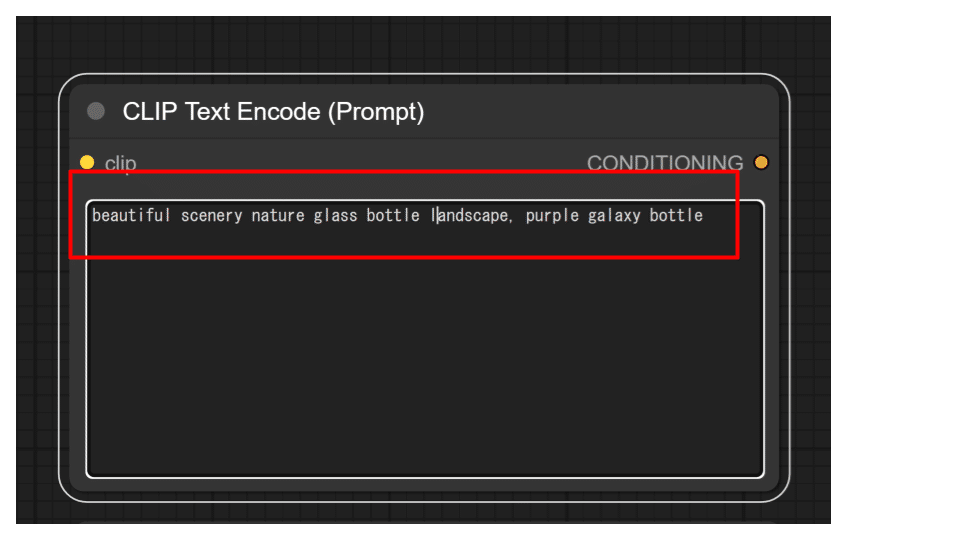

- プロンプトの要素の並びによる生成結果の違い

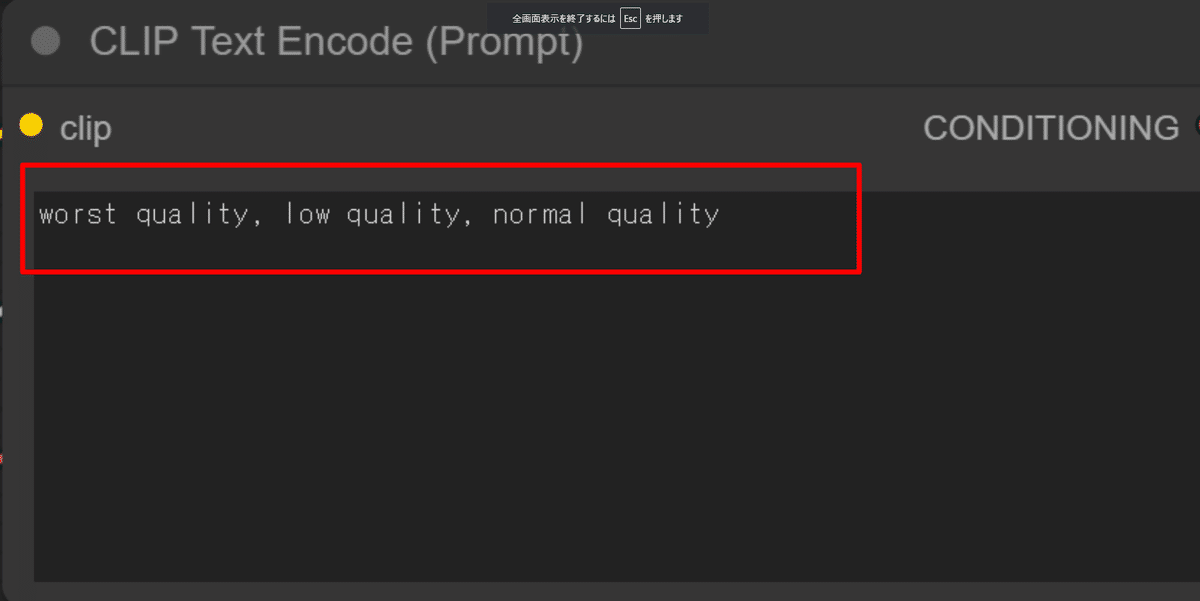

- ネガティブプロンプトの有無による生成結果の違い

- APIから学ぶSD3時代のText to Imageモデル

- ワードリストを使った多様な表現

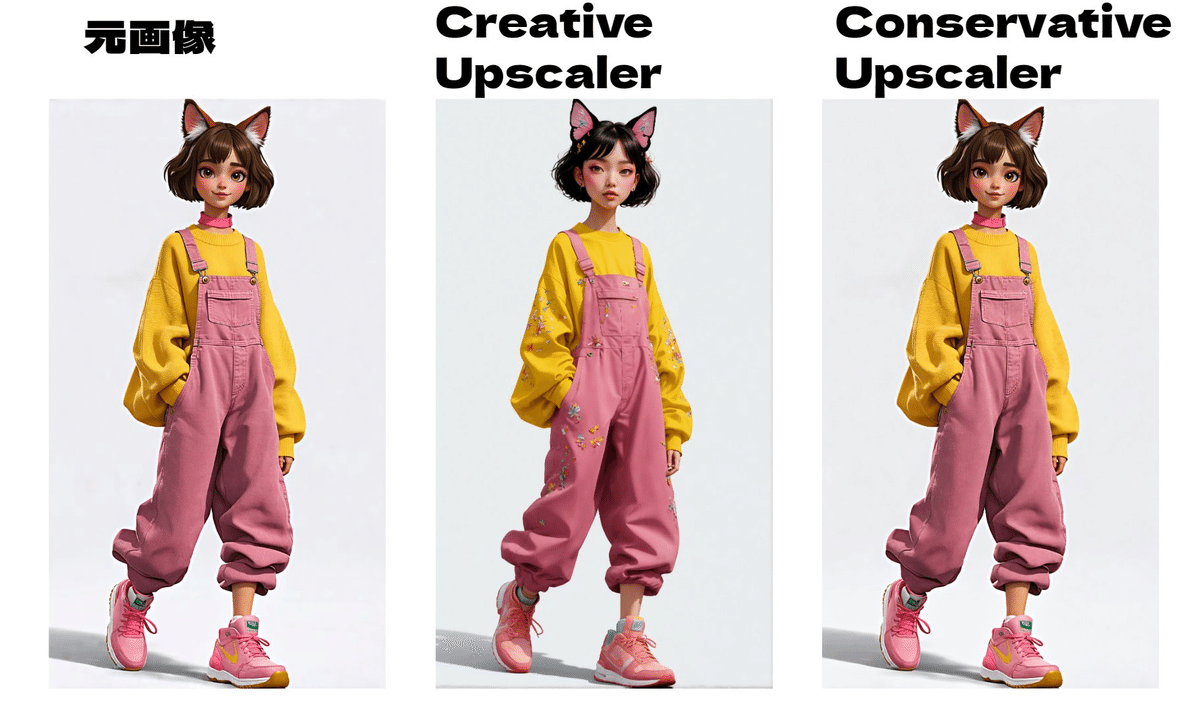

- Conservativeを用いた作品の高解像度化

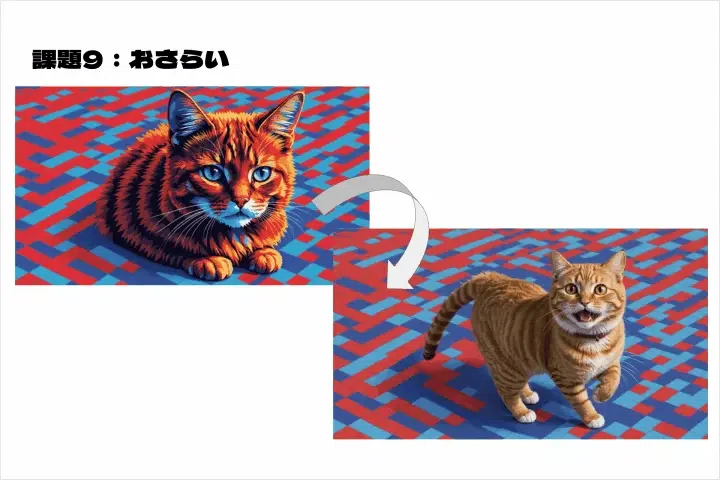

- Edit機能を活用した画像加工

- Structureを使った構造の制御

- オリジナルLookbookの作成

- 広告バリエーションの制作

講師紹介

生成AIクリエイティブ:AICU

[白井暁彦]

こんにちは。生成AIクリエイティブAICU代表の白井暁彦です。 エンタメ業界とメタバース技術の研究開発や、ホワイトハッカー作家として活動しており、デジタルハリウッド大学大学院で特任教授を務めております。デジハリ発国際スタートアップ企業AICU Inc.は、生成AI 時代に「つくる人をつくる」をビジョンに英語や日本語、フランス語、プログラミング言語など、オープンなクリエイティブ活動を行っている会社です。生成AIの最先端で研究や作家活動を通して、生成AIの魅力と楽しさをたくさんの人々に届かせるために活動しています。

[RUNO.]

こんにちは。生成AIクリエイティブ AICUのRUNO.です。昼間は、ITベンチャーでマーケティング・事業開発・データアナリストとして活動しており、夜は、白井主宰のクリエイティブAIラボ「CAIL」で、クリエイティブAI分野の社会実装を研究する「クリエイティブAI系VTuber」として活動しています。得意分野は、プロンプトエンジニアリングやAIサービス開発、執筆、アート制作、事業企画などです。

https://note.com/runos_log/n/ncf1843b2a30c

▼ Coloso講座ページはこちら ▼ https://j.aicu.ai/AICUXColosoJP

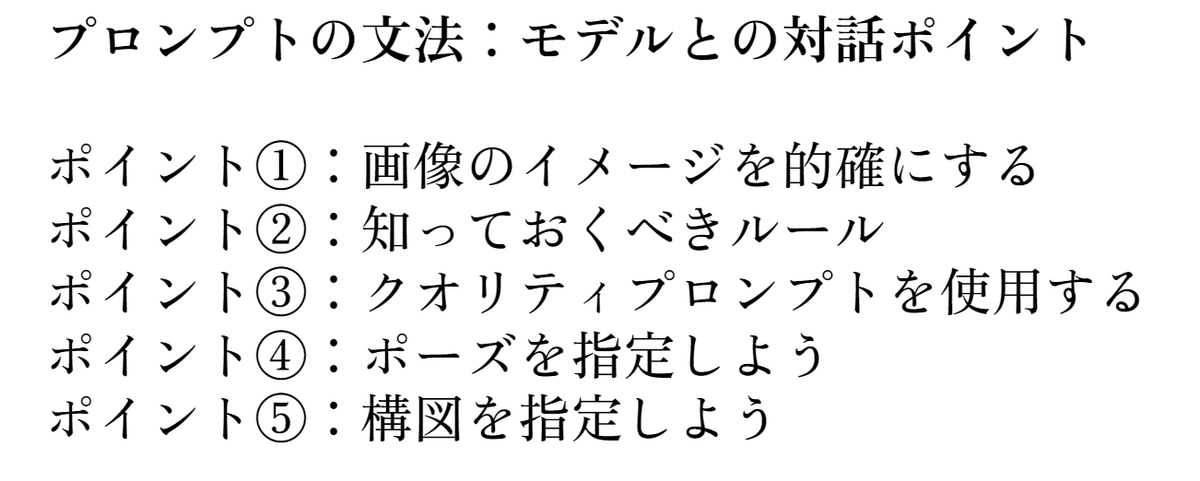

この講座のポイント

AI時代の必須スキル「プロンプトエンジニアリング」の基礎を網羅的に学習

具体的な例題と実践を通して、安定した高品質画像生成のために必要なプロンプトの構造から、最新のテクニックまで、プロンプトエンジニアリングのスキルを体系的に学ぶことができます。また、今後登場するであろう、新しい画像生成AIにも応用可能な、普遍的なプロンプト構築の考え方を身に付けます。

Google ColabとGoogle Slidesを用いたコーディング不要の実践スキル

プログラミングの知識がなくても、Google ColabとGoogle Slidesを使用して、画像生成AIをビジネスに応用する方法を学びます。特に、バーチャルファッションモデルの制作や広告バリエーションの制作といった、具体的な例題を通して、実践的なスキルを磨いていきます。

生成AI時代に必要な著作権や倫理における知識

生成AIを取り巻く法律や倫理的な問題は法律だけではありません。新たな著作権の理解、クリエイティブの扱い、広告ビジュアルや消費者など受け手の理解、そして今後の展望について理解を深めます。それらを通して、AI技術を正しく、責任を持って活用するための知識と、実践的なガイドラインについて学び、持続的な創作活動を行うための基盤を築きます。

講座内容: 下記のような内容を学べます。

- 生成AIにおける基礎知識

- 画像生成AIの歴史やStable Diffusionの仕組み、AIにおける今後の展望など、AI技術についての理解を深めるために必要な基礎知識を学ぶことができます。

- プロンプトによる画像生成の文法

- 高品質な画像生成を可能にするためのプロンプトの構造と要素、そして最新のテクニックを体系的に学びながら、プロンプトエンジニアリングのスキルを身に付けていきます。

- Stability AI APIを活用した高度な画像生成

- 公式APIを活用した画像編集や構造制御などを実践的に学びながら、高度な画像生成技術を習得します。その上で、AIの可能性を最大限に引き出し、より複雑で創造的な画像生成に挑戦します。

- バーチャルファッションモデルの開発

- バーチャルファッションモデルを制作する例題を通して学んだ知識を応用し、ファッションブランドのLookbookを制作することで、ポートフォリオとして活用できるレベルの作品制作を目指します。

- AI技術を駆使した広告制作

- AIを活用した広告バリエーションの制作を通して、ビジネスにおけるAI活用の可能性を広げ、実践的なマーケティングスキルを習得します。AI技術をビジネスに活用することで、新たな価値創造とイノベーションに挑戦します。

- AIの活用における倫理と未来予測

- 生成AIを取り巻く法的、倫理的な問題を理解し、責任のあるAI活用を実践するための知識を身に付けます。AI技術の倫理的な側面を理解し、持続可能な社会におけるAIのあり方を深く考察することで、AIの未来を創造する力を養います。

- 無期限視聴:一回の購入で、期限の制限なく視聴することができます。

- 最安値:08/31 (土) 販売価格が上がります。

もうすぐ販売価格が上がる予定です。

今すぐご購入ください!今が最安値!

▼ Coloso講座ページはこちら ▼

https://j.aicu.ai/AICUXColosoJP

インタビューを受けました

生成AIクリエイティブ

AICUがお話ししたいこと

Question.01:該当の分野を勉強している方は、どういう部分を一番難しいと思っているでしょうか?また、本講座を通じて、そのような部分をどのように解決できるでしょうか?

画像生成AIは、日々進化しており、新しい技術や情報が次々と出てきます。そのため、最新情報をキャッチアップし続けること、そして専門用語や技術的な内容を理解することが難しいと感じている方が多いと思います。この講座では、クリエイティブAIニュースメディアとして、クリエイターのための情報を発信する「AICU」が、基礎知識から先端技術、未来予測までを丁寧に解説していきます。また、実習を通して、実践的なスキルを身に付けることができるので、AI技術への理解を深め、自信を持って活用できるようになると思います。

Question.02:講師さまご自身は、勉強してきた中で難しかった部分、それを解決するためにどのような努力をされてきましたか?

日々進化し続ける生成AIの世界で、その技術についていきながら、毎日勉強し続けることが一番大切で、難しいことだと思います。私は、毎日ブログを書くことを続けています。日々の仮説検証や、新技術の検証といった積み重ねが、「自分自身の成長」としてしっかりと可視化できます。これは、ChatGPT時代のクリエイターにとってとても重要なことで、単に道具の使い方を学ぶのではなく、新しい技術に対して適応する速度が大きく変わってきます。

Question.03:アウトプットを形にすることにおいて、大切なポイントは何になりますか?

アウトプットを形にする上で大切なポイントは、「明確なビジョンと目的意識を持つこと」、そして「それを達成するための仮説と実験する方法論を持つこと」だと考えています。AI技術は常に進化しており、新しい技術や情報が次々と出てきます。何を作りたいのか、なぜ作りたいのか、誰のために作るのか、といった根本的なメッセージにフォーカスを合わせ、それを明確にすることで、ビジュアル制作の方向性を定めることができ、迷いが少なくなると思います。

Question.04:講師さまがお考えになる、クリエイティブAI分野においての市場性と展望についてお話しください。

クリエイティブAI分野は、まだ市場が構築されていません。世間には、謎のAIクリエイターがたくさんいらっしゃいますが、この技術を専門的に学べる場があるわけでもなく、多くの方々は、独学で学んでいる状況です。誰でも簡単に、画像を生成できるサービスが普及する一方で、業務的には、超スピードでインパクトのある画像や映像をつくる人々が求められる、専門性の高いプロフェッショナルな分野になっていくと予測します。単に「安く」ではなく、倫理観がしっかりした「学び続ける人」が、体系的な知識と技術を背景に、速度感をもって大きな市場を作っていくと思います。

▼ Coloso講座ページはこちら ▼

今後の更新情報や、オトクな情報はメンバーシップ向けに発信していきます。

【8/24追記!】

8月30日23時59分まで or 先着100名様限定で、AICUの講座限定で5,000円割引が受けられるシークレットクーポンをいただきました!

リポストで見れるようにしておきましたのでぜひチェックしてください!

最安値でゲットしてください!

この記事の続きはこちらから https://note.com/aicu/n/nd680d8290d11

Originally published at https://note.com on Aug 23, 2024.