2024年10月3日、国の先端科学技術研究を紹介する国立研究開発法人 科学技術振興機構(JST)のYouTubeチャンネル「SCIENCE CHANNEL」において「AI時代の創作の世界 人の感性を支援するデジタル技術」として動画ニュースが配信されました。

https://scienceportal.jst.go.jp/gateway/videonews/m230001010

▼AI時代の創作の世界 人の感性を支援するデジタル技術|Science Portal動画ニュース(2024年10月3日配信) – YouTube

お気に入りのアニメやマンガ、音楽などを自分でも創作してみたいと思ったことがある人は多いはず。技術やセンスが必要とされるそうした創作活動を、コンピュータで手助けするツールが登場しつつあります。

という軽い切り口で始まる「すべての人々向け」の動画ニュースですが、紹介されている技術は、日本を代表するこの分野の先端研究者です。

■出演・協力機関

謝浩然(北陸先端科学技術大学院大学 創造社会デザイン研究領域 准教授)

宮田一乘(北陸先端科学技術大学院大学 創造社会デザイン研究領域 教授)

森勢将雅(明治大学 総合数理学部 専任教授)

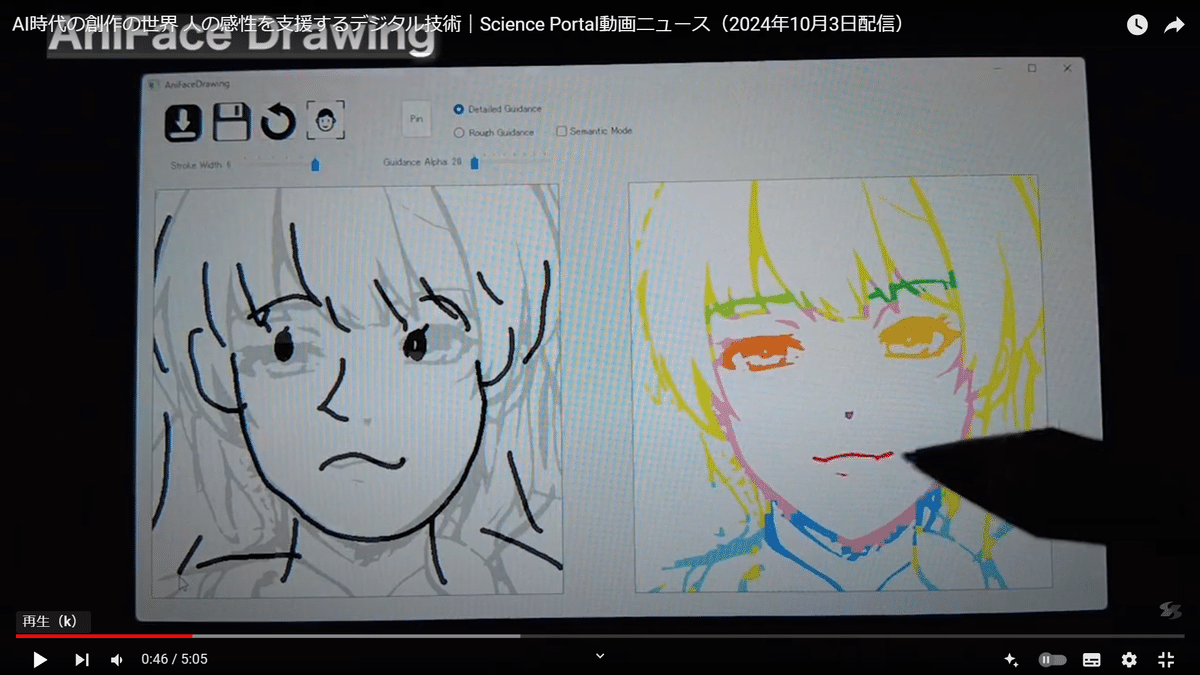

「アニフェイス・ドローイング」

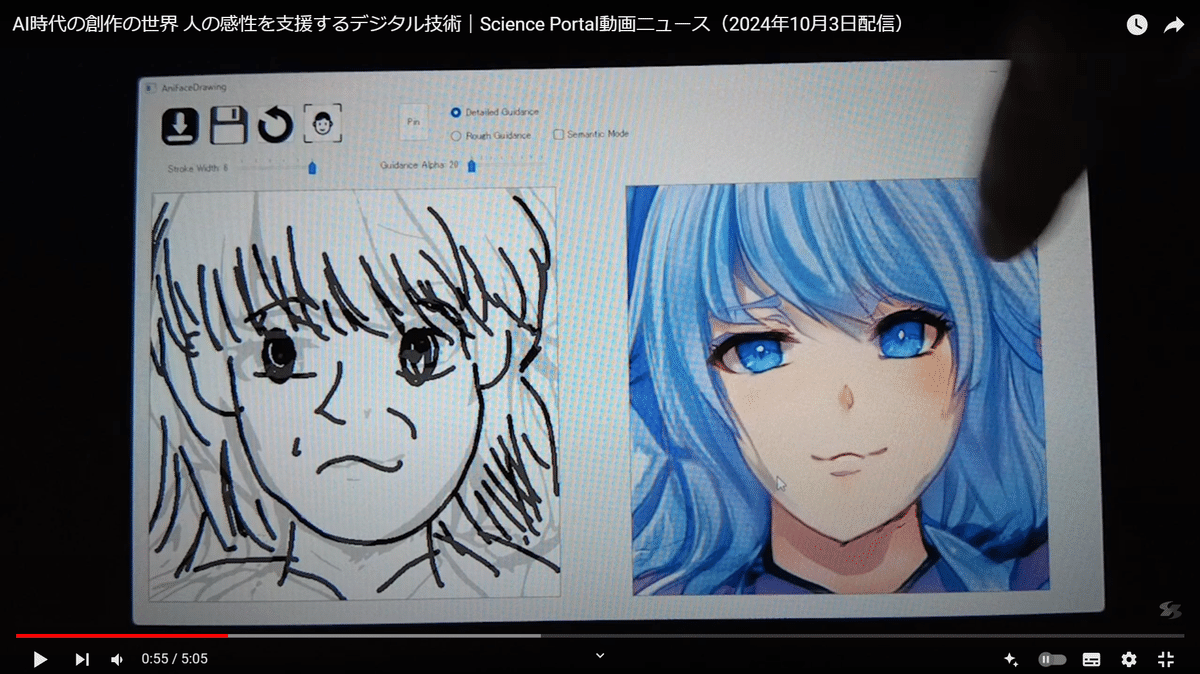

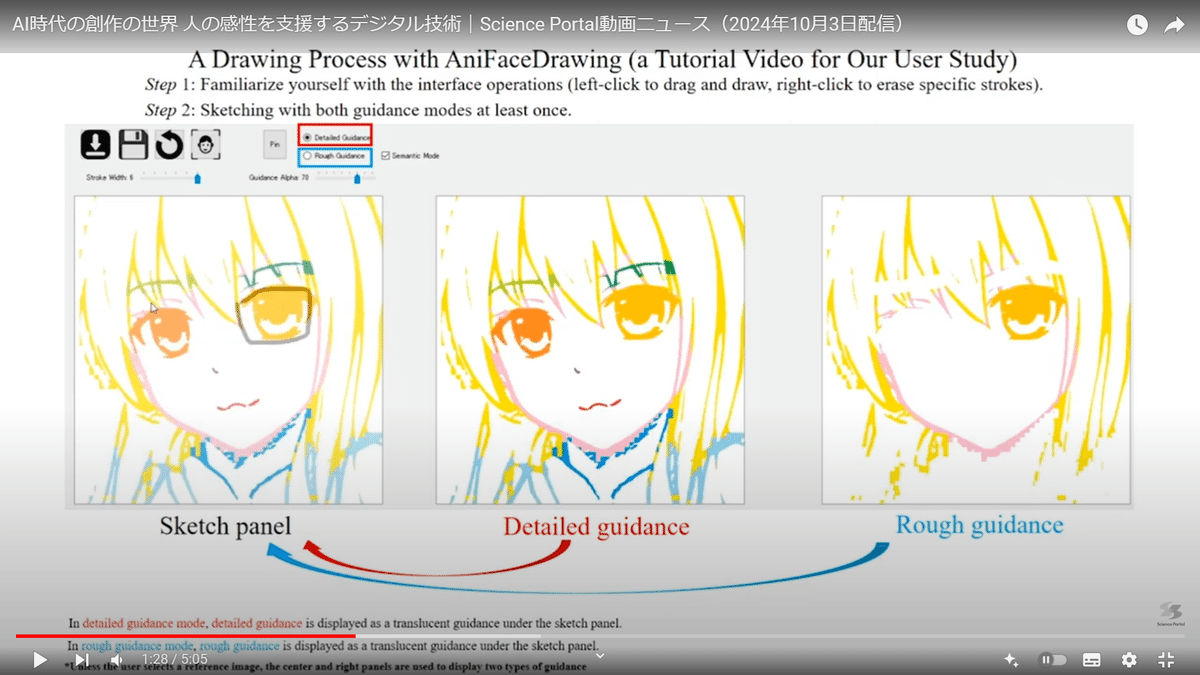

紹介された「アニフェイス・ドローイング(AniFace Drawing)」は、手書きのスケッチを、プロが描いたようなアニメ絵に仕上げるようにガイドしてくれるシステムです。

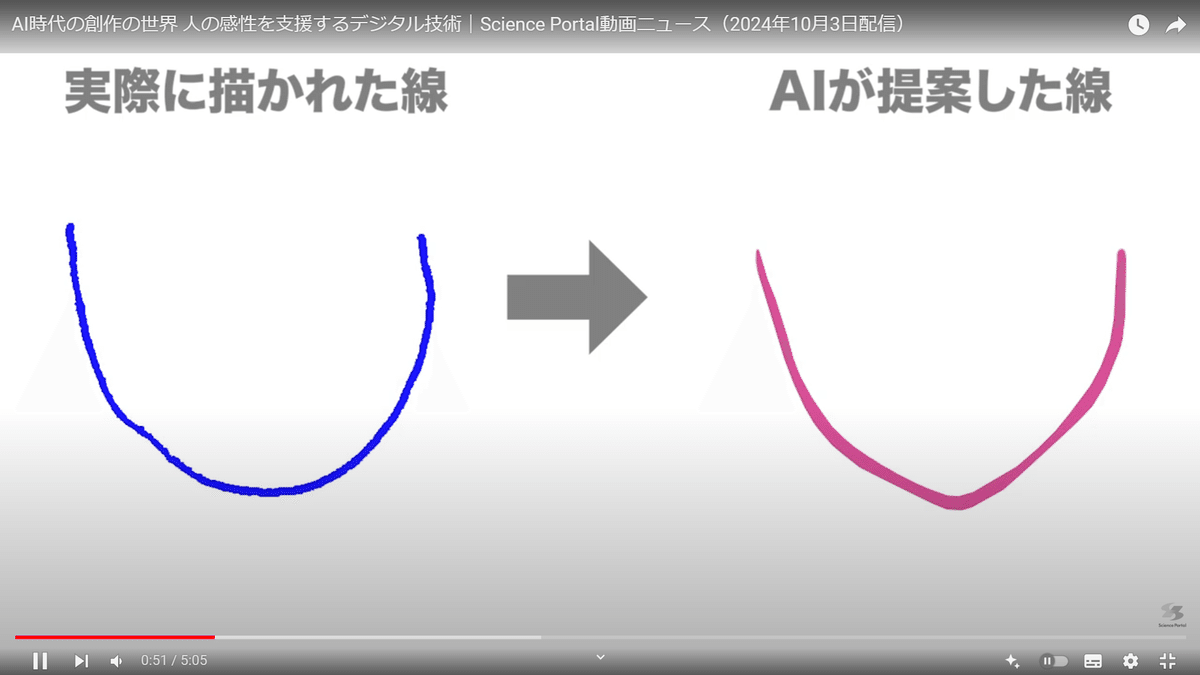

線をひいていくと AIの予測に基づいて その線をコンピュータが整えてくれたり ガイドを表示してくれます。

アニメ調の似顔絵が完成していきます。

北陸先端科学技術大学院大学(JAIST)創造社会デザイン研究領域 謝浩然 准教授 @Jesusxie

謝先生「今回の研究は、ひとつの絵を描いて、その描くプロセスひとつひとつをシミュレーションすることができます。そうすると 人間がどんな絵を描いているかを予測することができます。それをもとにして、完全な絵を予測することができます。こういうところは面白いところです。」

このシステムは画像生成AIを下書き全体ではなく ユーザーの描いた一本一本の線に対して用います。線を「色」「形」「大きさ」などの特徴ごとに分解した上で、結果を出力する事を実現しました。こうすることで 一方的に結果を提示するのではなく、書き手が描きたかったような絵により近づけていくことができます。

北陸先端科学技術大学院大学 創造社会デザイン研究領域 宮田一乘 教授 @kazmiyata

宮田先生「今の生成系AIですと『入れたらすぐに、一瞬で出てくる』ので結局は自分の能力が全然拡張されてないわけですよね。ですのでコンピュータを使って『あくまで支援』として使ってあげて、『自分の力』というか『潜在能力』を引き出すようなことになれば良いかなと思っています」

https://www.jaist.ac.jp/~xie/AniFaceDrawing.html

この技術は 今まで絵が苦手で諦めていた人が、漫画やアニメの創作に取り組むきっかけになるかもしれません。

コンピュータは声によっても創作の世界を広げてきました。合成音声です。

明治大学 総合数理学部 森勢将雅 専任教授 @m_morise

明治大学の森勢さんらもこの合成音声の技術を開発しています。

人の声を分析し数理的な操作で三つの要素に 分解した上で再合成します。

補足解説:森勢将雅先生は人工合成ボイス「No.7」の開発者さんでもあります。

[YouTube] No.7と学ぶ信号処理

ずんだもんとNo.7の楽しい雰囲気で、信号処理を中心とした大学数学を学べる番組を製作されております。

さて、サイエンスチャンネルでのデモの様子、音声の高さや低さ、フラットにした合成の様子はこちら。

なおサイエンスチャンネルの動画は「この技術はソースフィルターという数理モデルによるもので実はAIは使っていません 」という衝撃的な流れになっています。

森勢先生「いかにきれいに分離させるかというところで、数学的な要素を頑張って作り込むことによって性能を上げていったという流れになります。人間の喋っている声をどのように加工するかでして、AIは関係なく 数学的に信号処理の分野としてやってきました。加工の際に劣化していたので劣化させないように人工知能でうまくフォローする技術を作っていきたいと考えています」

AIとの連携も模索しながら 森勢さんがめざしているのは『より魅力的な声を作り出す技術』。その関心は どのような声に人は惹きつけられ 魅せられるのかという問いに広がっていきます。

森勢先生「心理学と音声情報処理の連携・融合研究とでもいうんでしょうか そういったものをやりたいと思っています。『人間と同じ声を作る』というだけでしたら、もう今の技術でできちゃっていまして。となると次は『どんな 豊かな声 を作るか』とか『キャラクター性』とか、一つのコンテンツとして人間の声のコピーはできたけれども『それをより魅力的に見せる』そういったものを『どう広げていくか?』というところが今後出てくるのではないかと思っています。その一つとして 声をデザインするということに 着眼して研究をしています」

AIと人間の共存、新たな表現の可能性に取り組む研究者たち

AIが発展していく中で、創作活動がAIに取って代わられるのではないかと不安視する声も耳にするようになりました。しかし、今回の国の科学技術を推進する研究開発機構の動画によって紹介された技術は、AIが時々言われるような「人の創造性を奪う」とか「仕事を奪う」ではなく、人間の創造性を支援し、新たな表現の可能性を広げていくことをこの動画は社会に伝えています。

謝辞:原作JST サイエンスポータル&サイエンスティーム

お知らせ:AICUは先端学術研究を応援します

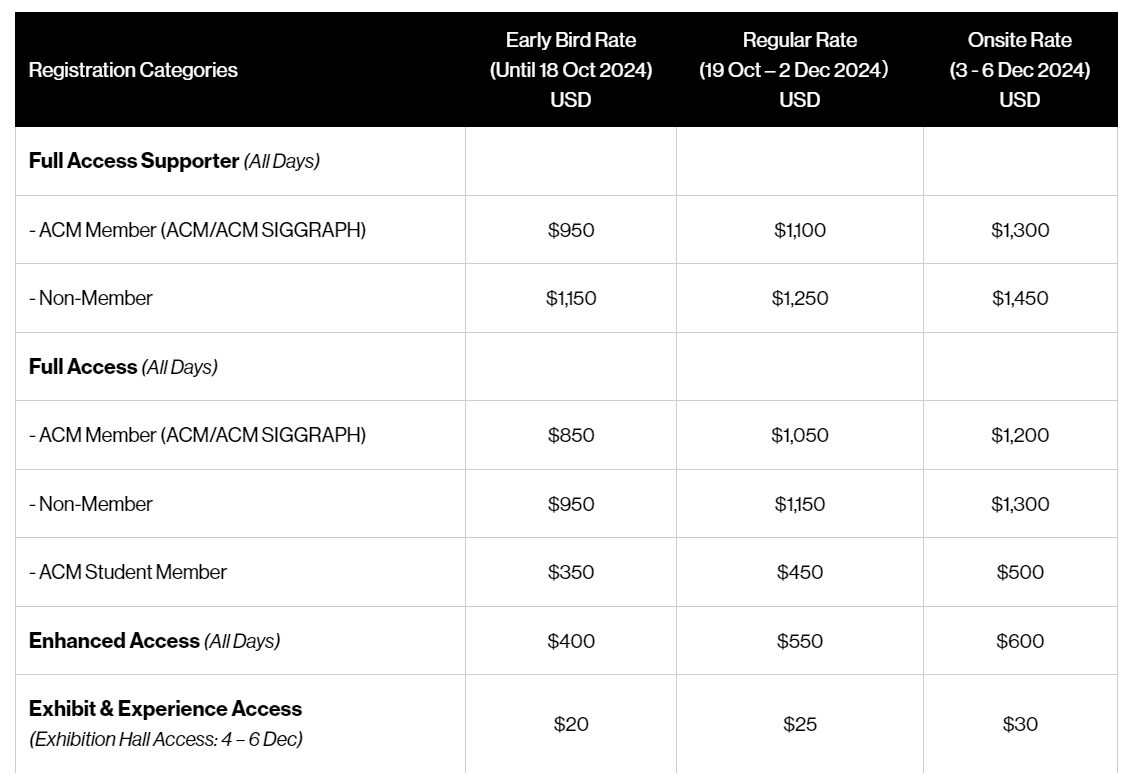

ここでお知らせです、謝先生や宮田先生が挑戦する世界最大のCG/インタラクティブ技術のトップカンファレンス「SIGGRAPH」のアジア開催「SIGGRAPH ASIA 2024」が、2024年12月3日~6日に東京国際フォーラムで開催されます。東京での開催は3年ぶりになります。

https://asia.siggraph.org/2024/ja/

そしてAICUはオフィシャルプログラムスポンサーです。

世界レベルのCG・インタラクティブ研究を共有する場を応援できることを誇りに思います。

AICU media編集部もSIGGRAPH ASIA2024は全力で応援していきますが、プログラムスポンサーとしてAICU Inc.からの先行第1弾として、

メンバーシップ会員向け「10%OFF登録コード」を配布いたします。

SIGGRAPH ASIA 2024の当日フルアクセス(Full Access Supporter)は $1300、10月18日までの登録で、$950 – 10% ($95) = $855です。つまり当日登録価格から$445(約66,373円)割引です!他にも展示会と体験エリアのみの「Exhibit & Experience Access」は学生さんやビジネスの方にもオススメで、$20→$18となります。

【メンバーシップ向け情報】(全プラン)

AICUから10% OFFのオファーコードがございます。

https://registration.asia.siggraph.org/terms_jpn.html

最後のお会計のタイミングで、「SA24AICU10」入力することで、10%OFFとなります。なにか不具合がございましたら X@AICUai までDMもしくはDiscordにてお問い合わせください。

招待コード https://j.aicu.ai/JoinDiscord

Originally published at https://note.com on Oct 13, 2024.