2023年11月6日、OpenAI DevDayにて新モデルと開発者向け製品が発表されました。

https://openai.com/blog/new-models-and-developer-products-announced-at-devday

DevDayで発表されたモデルと開発者向け製品は主に以下のとおりです。

以下、公式リリースをできるだけ丁寧に翻訳していきます。

・GPT-4Turboの128Kコンテキストと低価格化:

より高性能で安価で、128Kのコンテキスト・ウィンドウをサポート

・新しいAssistants API:

目標を持ち、モデルやツールを呼び出すことができる独自の支援AIアプリを開発者が簡単に構築できる

・GPT-4 Turbo with Vision

・DALL-E 3 API

新しいマルチモーダル機能 視覚、画像作成(DALL-E 3)、音声合成(TTS)が本日午後1時(太平洋時間)から提供されます。

GPT-4 Turbo 128Kコンテキスト

OpenAIは今年3月にGPT-4の最初のバージョンをリリースし大きな反響を得ました。7月にGPT-4をすべての開発者が一般的に利用できるようになりましたが、本日、このモデルの次世代であるGPT-4 Turboのプレビューが公開されました。

GPT-4 Turboはより高性能で、2023年4月までの世界情勢を把握しているようです。128kのコンテキスト・ウィンドウを持ち、300ページ以上のテキストを1つのプロンプトに収めることができます。GPT-4 Turboは、GPT-4と比較して、入力トークンで3倍安く、出力トークンで2倍安く提供されます。

APIで「gpt-4–1106-preview」を渡すことにより、すべての有料開発者が試すことができます。

関数呼び出し(function calling)の更新

関数呼び出しは、アプリや外部APIの関数をモデルに記述し、モデルにそれらの関数を呼び出すための引数を含むJSONオブジェクトを出力するように賢く選択させることができます。1つのメッセージで複数の関数を呼び出す機能など、アップデートが本日リリースされました。

例えば「車の窓を開けてエアコンを切る」といった複数のアクションを要求するメッセージを1回のリクエストで送ることができます。また関数呼び出し精度も向上しています。より正しい関数パラメータを返す可能性が高くなりました。

命令追跡とJSONモードの改善

GPT-4 Turboは、特定のフォーマット(「常にXMLで応答する」など)を生成するときなど、命令に注意深く従う必要があるタスクにおいて、これまでのモデルよりも優れたパフォーマンスを発揮するようになりました。モデルが有効なJSONで応答することを保証する新しい「 JSONモード 」をサポートしています。新しいAPIパラメータ「response_format」は、モデルが構文的に正しいJSONオブジェクトを生成するように出力を制約することを可能にします。JSONモードは、関数呼び出し以外でチャット完了APIでJSONを生成する開発者にとって便利と考えます。

再現可能な出力とログ確率

新しい「seed」パラメータは、モデルが一貫性のある補完を返すようにすることで再現可能な出力を可能にします。このベータ機能は、デバッグのためにリクエストを再生したり、より包括的な単体テストを書いたり、一般的にモデルの動作をより高度に制御したりするようなユースケースに便利です(OpenAI社内でこの機能をユニットテストに使用しており、 非常に貴重なものだと感じているそうです)。

また、GPT-4 TurboとGPT-3.5 Turboによって生成された最も可能性の高い出力トークンのログ確率を返す機能を数週間以内に開始とのことです。

更新されたGPT-3.5 Turbo

GPT-4 Turboに加えて、デフォルトで16Kのコンテキスト・ウィンドウをサポートするGPT-3.5 Turboの新バージョンもリリースします。新しい3.5 Turboは、改良された命令フォロー、JSONモード、並列関数呼び出しをサポートしています。例えば、JSON、XML、YAMLを生成するようなフォーマット・フォロー・タスクにおいて、内部検証では38%の改善が見られました。開発者はAPIで「gpt-3.5-turbo-1106」を呼び出すことで、この新しいモデルにアクセスできます。「gpt-3.5-turbo」の名前を使用しているアプリケーションは、12月11日に自動的に新しいモデルにアップグレードされます。古いモデルには、2024年6月13日までAPIで「gpt-3.5-turbo-0613」を渡すことでアクセスできます。 詳細はこちら。

アシスタントAPI、検索、コード・インタープリター

今日、私たちは「 Assistants API」をリリースします。これは、開発者が自身のアプリケーション内でエージェントのような体験を構築することを支援するための第一歩です。アシスタントとは、特定の指示を持ち、余分な知識を活用し、モデルやツールを呼び出してタスクを実行できる「目的に特化したAI」です。

新しいAssistants APIは、Code InterpreterやRetrieval、関数呼び出しなどの新しい機能を提供し、これまで自分で行わなければならなかった多くの重労働を処理し、高品質のAIアプリを構築できるようにします。

このAPIは柔軟に設計されており、自然言語ベースのデータ分析アプリ、コーディングアシスタント、AI搭載のバケーションプランナー、ボイスコントロールDJ、スマートビジュアルキャンバスなど、使用例は多岐にわたる。アシスタントAPIは、当社の新製品GPTsを可能にする同じ機能、すなわちコード・インタープリタ、検索、関数呼び出しなどのカスタム命令とツールに基づいて構築されています。

このAPIによって導入された重要な変更点は、持続的で無限に長いスレッドです。これにより、開発者はスレッドの状態管理をOpenAIに委ねることができ、コンテキストウィンドウの制約を回避することができます。アシスタントのAPIでは、既存のスレッドに新しいメッセージを追加するだけです。

アシスタントは、必要に応じて新しいツールを呼び出すことができます。

Code Interpreter:サンドボックス化された実行環境でPythonコードを書き込んで実行し、グラフやチャートを生成したり、多様なデータやフォーマットのファイルを処理したりできます。アシスタントがコードを繰り返し実行することで、難しいコードや数学の問題などを解決することができます。

検索:独自のドメインデータ、製品情報、ユーザーから提供されたドキュメントなど、弊社のモデル外からの知識でアシスタントを補強します。つまり、ドキュメントの埋め込みを計算して保存したり、チャンキングや検索アルゴリズムを実装したりする必要はありません。アシスタントAPIは、ChatGPTで知識検索を構築した経験に基づいて、どのような検索手法を使用するかを最適化します。

関数呼び出し: アシスタントは、あなたが定義した関数を呼び出し、その関数応答をメッセージに組み込むことができます。

プラットフォームの他の部分と同様に、OpenAI APIに渡されたデータやファイルは、 OpenAIのモデルを訓練するために使用されることはありません。

「 Assistantsプレイグラウンド 」に行けば、コードを書かずにAssistants APIベータ版を試すことができます。

公式による動画紹介:Assistantsプレイグラウンドを使って、コードを書かずに高品質のアシスタントを作成

https://cdn.openai.com/new-models-and-developer-products-announced-at-devday/assistants-playground.mp4

Assistants APIはベータ版で、今日からすべての開発者が利用できます。作ったものを「@OpenAI」と共有してください。Assistants APIとそのツールの価格は、 価格ページ で確認できます。

APIの新しいモダリティ

ビジョン付きGPT-4 Turbo

GPT-4 TurboはChat Completions APIで画像を入力として受け付けることができ、キャプションの生成、実世界の画像の詳細分析、図付きドキュメントの読み取りなどのユースケースが可能になります。例えば、 BeMyEyesはこの技術を使用して、目の不自由な人や弱視の人が商品を識別したり、店舗をナビゲートしたりするような日常作業を支援します。開発者はAPIで「gpt-4-vision-preview」を使用することでこの機能にアクセスできます。安定したリリースの一部として、メインモデルの「GPT-4 Turbo」にビジョンサポートを展開する予定です。価格は入力画像サイズに依存します。例えば、1080×1080ピクセルの画像をGPT-4 Turboに渡す場合、$0.00765かかります。詳細は ビジョンガイド をご覧ください。

DALL-E 3

モデルとして「dall-e-3」を指定することで、最近ChatGPT PlusとEnterpriseユーザーに提供を開始した「 DALL-E 3」を、Images APIを通じてアプリや製品に直接統合することができます。Snap、Coca-Cola、Shutterstockのような企業は、DALL-E 3を使用して、顧客やキャンペーン用の画像やデザインをプログラムで生成しているそうです。旧バージョンの DALL-E と同様に、API には開発者がアプリケーションを悪用から守るためのモデレーション機能が組み込まれています。様々なフォーマットやクオリティのオプションをご用意しており、生成される画像1枚あたり0.04ドルからご利用いただけます。 API で DALL-E 3 を使い始めるためのガイド をご覧ください。

音声合成 (TTS)

開発者はテキスト読み上げ API を使ってテキストから人間品質の音声を生成できるようになりました。新しい TTS モデルでは、6 種類のプリセット音声から選択でき、「tts-1」と「tts-1-hd」の 2 つのモデルバリエーションがあります。価格は1,000文字入力あたり0.015ドルから。まずは TTSガイド をご覧ください。音声サンプルも聞く事ができます。

モデルのカスタマイズ

GPT-4ファインチューニング実験アクセス

GPT-4ファインチューニングの実験アクセスプログラムを作成中です。予備的な結果では、GPT-4ファインチューニングは、GPT-3.5ファインチューニングで実現した大幅な利益と比較して、ベースモデルから意味のある改善を達成するために、より多くの作業が必要であることを示しています。GPT-4ファインチューニングの品質と安全性が向上するにつれて、GPT-3.5ファインチューニングを積極的に使用している開発者には、ファインチューニング・コンソール内でGPT-4プログラムに適用するオプションが提示されます。

カスタムモデル

ファインチューニングが提供できる以上のカスタマイズを必要とする組織(特に、最低でも数十億トークンという非常に大規模な独自データセットを持つドメインに適用可能)のために、カスタムモデルプログラムも開始します。これにはドメイン固有の事前トレーニングの追加から、特定のドメインに合わせたカスタムRLポストトレーニングプロセスの実行まで、モデルトレーニングプロセスのすべてのステップを変更することが含まれます。組織は、カスタム・モデルに独占的にアクセスすることができます。OpenAIの既存のプライバシーポリシーに従い、カスタムモデルが他の顧客に提供されたり、他の顧客と共有されたり、他のモデルのトレーニングに使用されたりすることはありません。また、カスタムモデルを訓練するためにOpenAIに提供された専有データは、他のいかなる文脈でも再利用されることはありません。これは非常に限定された(そして高価な)プログラムの開始になります。 登録はこちら 。

低価格と高い料金制限

料金の値下げ

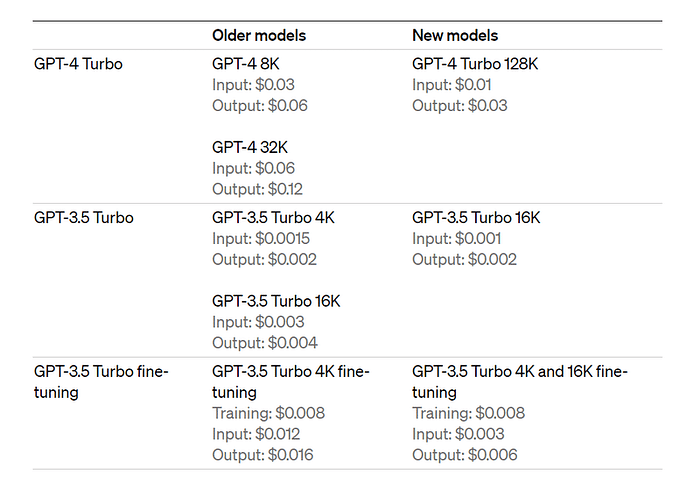

開発者に節約分を還元するため、プラットフォーム全体でいくつかの価格を引き下げます(以下の価格はすべて1,000トークンあたりの価格です):

・GPT-4 TurboインプットトークンはGPT-4より3倍安い0.01ドル、アウトプットトークンは2倍安い0.03ドル。

・GPT-3.5 Turboの入力トークンは、以前の16Kモデルより3倍安い0.001ドル、出力トークンは2倍安い0.002ドルです。以前GPT-3.5 Turbo 4Kを使用していた開発者は、0.001ドルのインプット・トークンを33%削減できます。これらの低価格は、本日発表された新しいGPT-3.5 Turboにのみ適用されます。

・ファインチューニングされたGPT-3.5 Turbo 4Kモデルのインプット・トークンは4倍の0.003ドルに、アウトプット・トークンは2.7倍の0.006ドルに値下げされます。ファインチューニングはまた、新しいGPT-3.5 Turboモデルで4Kと同じ価格で16Kコンテキストをサポートします。これらの新しい価格は、ファインチューンされた「gpt-3.5-turbo-0613」モデルにも適用されます。

より高いレート制限

お客様のアプリケーションの拡張を支援するため、GPT-4 のすべての有料顧客の 1 分あたりのトークンの上限を 2 倍にします。新しいレートリミットは レートリミットページで確認できます。また、料金制限の自動引き上げを決定する 使用量階層を公開しましたので、使用量制限がどのように自動的に拡大されるかをご確認いただけます。 アカウント設定 から利用限度額の引き上げをリクエストできるようになりました。

著作権シールド

OpenAIは、システムに組み込まれた著作権セーフガードでユーザを保護することをお約束します。本日、さらに一歩進んで、「Copyright Shield」を導入します。お客様が著作権侵害に関する法的請求に直面した場合、OpenAIが介入してお客様を保護し、発生した費用を支払います。これは、ChatGPTエンタープライズと開発者プラットフォームの一般的に利用可能な機能に適用されます。

Whisper v3 と一貫性デコーダー

オープンソース自動音声認識モデル(ASR)の次のバージョンである「 Whisper large-v3」をリリースします。また、近い将来、APIでもWhisper v3をサポートする予定です。

また、Stable Diffusion VAEデコーダーのドロップインリプレースメントである「 一貫性デコーダー (Consistency Decoder)」もオープンソース化しています。このデコーダーは、Stable Diffusion 1.0+ VAEと互換性のあるすべての画像を改善し、テキスト、顔、直線を大幅に改善します。

ChatGPTのOpenAI DevDayアナウンスについてはこちらをご覧ください。

Originally published at https://note.com on November 7, 2023.