AICU media ライターのやまぐちです!現在開催されているSIGGRAPH Asia 2024の中で気になった研究7選をお届けします。

Technical Papers Programの各セッションの開催情報についてはこちら

InstantDrag: Improving Interactivity in Drag-based Image Editing (InstantDrag:ドラッグ操作で画像編集のインタラクティブ性を向上)

発表セッション: It’s All About Change: Image Editing (変えることのすべて:画像編集)

https://asia.siggraph.org/2024/?post_type=page&p=32163&sess=sess116

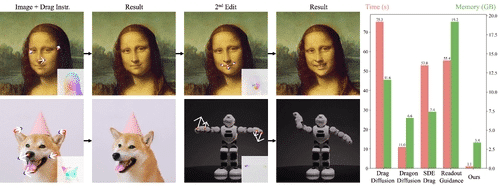

ドラッグベースの画像編集は、そのインタラクティブ性と精度から最近人気を集めています。しかし、テキストから画像へのモデルは 1 秒以内にサンプルを生成できるにもかかわらず、画像コンテンツを維持しながらユーザー操作を正確に反映するという課題のため、ドラッグ編集はまだ遅れをとっています。既存のアプローチの中には、計算集約的な画像ごとの最適化や複雑なガイダンスベースの方法に依存しているものがあり、移動可能な領域のマスクやテキスト プロンプトなどの追加入力が必要となり、編集プロセスのインタラクティブ性が損なわれます。そこで、最適化不要のパイプラインでインタラクティブ性と速度を向上させ、入力として画像とドラッグ命令のみを必要とする InstantDrag を紹介します。InstantDrag は、ドラッグ条件付きオプティカル フロー ジェネレーター (FlowGen) とオプティカル フロー条件付き拡散モデル (FlowDiffusion) という 2 つの慎重に設計されたネットワークで構成されています。InstantDrag は、タスクをモーション生成とモーション条件付き画像生成に分解することで、実際のビデオ データセットでのドラッグベースの画像編集のモーション ダイナミクスを学習します。顔のビデオ データセットと一般的なシーンでの実験を通じて、マスクやテキスト プロンプトなしで高速でフォトリアリスティックな編集を実行できる InstantDrag の機能を実証しました。これらの結果は、ドラッグ ベースの画像編集を処理する当社のアプローチの効率性を強調しており、インタラクティブなリアルタイム アプリケーションにとって有望なソリューションとなっています。

https://asia.siggraph.org/2024/presentation/?id=papers_884&sess=sess116 より翻訳

こちらはTPFFでのパフォーマンスが面白かったのでピックアップしました。紹介動画が作り込まれており、とても印象的でした。30秒程度の発表で来場者の記憶に刻み込むのは簡単ではありませんが、成功すると注目度が一気に上がりますね。

デモのためのソースコードなども開発者によって公開されています

https://joonghyuk.com/instantdrag-web/

Computational Biomimetics of Winged Seeds (翼を持つ種子(翼果)の計算生物模倣学)

https://asia.siggraph.org/2024/presentation/?id=papers_275&sess=sess109

発表セッション: Geometry and Fabrication (ジオメトリと組み立て)

https://asia.siggraph.org/2024/?post_type=page&p=32163&sess=sess109

本研究は、有翼種子のバイオミメティックデザインを容易にする計算パイプラインを開発する。我々のアプローチは、自然の有翼種子の3Dスキャンを活用し、3D差分同型群の測地線座標でそれらを補間することにより、生物にインスパイアされた設計空間を構築する。我々は、確率的な性能目標を持つ空力設計タスクを定式化し、設計空間を探索し、性能目標の期待値を効率的かつ効果的に最小化するために、勾配のないオプティマイザを適応させる。我々のパイプラインは、長距離散布や誘導飛行を含む空力タスクにおいて、自然界を凌駕する新しい有翼種子デザインを発見する。我々は、設計空間において選択された有翼種子のペーパーモデルを紹介し、シミュレーションと現実における類似した空気力学的挙動を報告することにより、我々のパイプラインの物理的忠実性を検証する。

概要の翻訳

翼を持つ種子がどのように飛ぶか、という研究。種子の飛び方を定式化しています。これにより、自然界を凌駕する新しい有翼種子デザインを発見できるそうです。たくさんの種子を実際に集めて3Dスキャンしているところに魅力を感じました。

研究者の公開サイトはこちら

https://leqiqin.github.io/publication/seeds2024

https://dl.acm.org/doi/10.1145/3687899

NeuSmoke: Efficient Smoke Reconstruction and View Synthesis with Neural Transportation Fields (ニュースモーク: ニューラル輸送場を用いた効率的な煙の再構成と視界合成)

発表セッション: Path Guiding, Scattering (パスガイド、散乱)

https://asia.siggraph.org/2024/?post_type=page&p=32163&sess=sess110

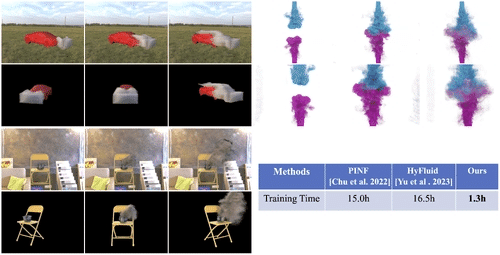

煙のシーンの新しいビュー合成は困難な問題である。これまでのニューラルアプローチは、不十分な品質と非効率な学習に悩まされてきた。本研究では、ニューラル輸送場を用いた動的煙再構成のための効率的なフレームワークであるNeuSmokeを紹介し、多視点映像からの高品質な密度再構成とノベルビュー合成を可能にする。我々のフレームワークは2つのステージから構成される。第一段階では、輸送方程式と神経輸送場を統合した新しい神経流体場表現を設計する。これには、再構成された煙の空間的・時間的整合性を高めるための、複数のタイムスタンプの適応的埋め込みが含まれる。第2段階では、煙の再構築を洗練させるために畳み込みニューラルネットワーク(CNN)を採用し、斬新な色情報と深度情報を組み合わせる。我々のモデルは、これまでの物理情報に基づいたアプローチよりも10倍以上高速な処理を実現する。広範な実験により、本手法は、実世界および合成データセットにおいて、ノベルビュー合成と体積密度推定において既存技術を凌駕することが実証された。

概要の翻訳

https://dl.acm.org/doi/10.1145/3680528.3687667

煙を合成するシミュレーション。上の画像からも、2色の煙がとてもきれいに混ざっていることが分かります。TPFFで流れていたデモ動画ではさらに分かりやすく、普段シミュレーションを扱う人間としてとても興味深かったです。

Quark: Real-time, High-resolution, and General Neural View Synthesis (クォーク:リアルタイム、高解像度、汎用的なニューラル・ビュー合成)

発表セッション: Look at it Differently: Novel View Synthesis (見方を変えよう: 新しいビューの合成)

https://asia.siggraph.org/2024/?post_type=page&p=32163&sess=sess113

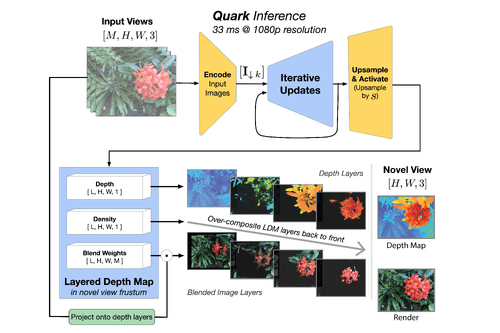

高品質、高解像度、リアルタイムの新しいビュー合成を実行するための新しいニューラル アルゴリズムを紹介します。入力 RGB 画像またはビデオ ストリームのスパース セットから、ネットワークは 3D シーンを再構築し、NVIDIA A100 で 30fps で 1080p 解像度の新しいビューをレンダリングします。フィードフォワード ネットワークは、さまざまなデータセットとシーンに一般化され、リアルタイム メソッドとして最先端の品質を生み出します。品質は、いくつかのトップ オフライン メソッドの品質に近づき、場合によってはそれを上回ります。これらの結果を達成するために、いくつかの重要な概念を新しく組み合わせ、それらを結合してまとまりのある効果的なアルゴリズムにします。半透明のレイヤーを使用してシーンを表す以前の研究を基に、反復学習によるレンダリングとリファイン アプローチを使用してそれらのレイヤーを改善します。フラット レイヤーの代わりに、複雑な深度とオクルージョンのあるシーンを効率的に表現するレイヤー化された深度マップ (LDM) を再構築します。反復更新ステップは、マルチスケールの UNet スタイルのアーキテクチャに組み込まれており、解像度を下げて可能な限り多くの計算を実行します。各更新ステップでは、複数の入力ビューからの情報をより適切に集約するために、特殊な Transformer ベースのネットワーク コンポーネントを使用します。これにより、入力ごとの画像処理の大部分をレイヤー空間ではなく入力画像空間で実行できるようになり、効率がさらに向上します。最後に、再構成とレンダリングのリアルタイム性により、フレームごとに内部 3D ジオメトリを動的に作成および破棄し、ビューごとに LDM を生成します。これらを総合すると、ビュー合成のための斬新で効果的なアルゴリズムが生まれます。広範な評価を通じて、リアルタイム レートで最先端の品質を実現できることを実証しました。

https://asia.siggraph.org/2024/presentation/?id=papers_683&sess=sess113 より翻訳

Googleによる発表です。3D シーンを再構築し、NVIDIA A100 で 30fps で 1080p 解像度の新しいビューをレンダリングします

https://quark-3d.github.io/

ArXivに置かれた論文を解説しながら朗読してくれる動画を見つけました…!

普通の動画からDepth Mapが生成でき、元の動画の解像度が粗くても高画質な動画に変換して新しいビューを作り出すことができるという研究です。NVIDIA A100といえば、AICUでもGoogle Colabでよく使うプロ向けGPU環境です。この研究にもNeural View Synthesis、Neural 3D、Neural Renderingといった手法が用いられており、今後、NeRFで有名になったNeural Fields (ニューラル場)の応用が一般化していくことが予想できます。

End-to-End Hybrid Refractive-Diffractive Lens Design with Differentiable Ray-Wave Model (微分可能な光波モデルを用いた端から端までハイブリッド屈折・回折レンズ設計)

https://asia.siggraph.org/2024/presentation/?id=papers_689&sess=sess223

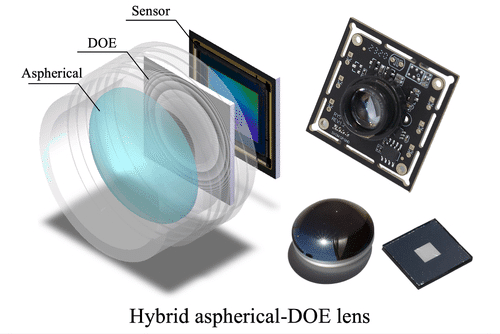

ハイブリッド屈折回折レンズは、屈折レンズの光効率と回折光学素子(DOE)の情報符号化能力を組み合わせたもので、次世代の撮像システムとして大きな可能性を秘めています。しかし、このようなハイブリッド設計を正確にシミュレートすることは一般的に困難であり、特に、十分な精度を持つハイブリッドレンズ用の微分可能な画像形成モデルは存在しません。

本研究では、光学収差と回折位相変調の両方を正確にシミュレートするための新しいハイブリッド光線追跡および波動伝搬(光線波)モデルを提案します。DOEは、最後の屈折面と画像センサーの間、つまりDOEの位置としてよく使用されるフーリエ平面から離れた場所に配置されます。提案された光線波モデルは完全に微分可能であり、勾配逆伝播法を使用して、屈折回折レンズの最適化と画像再構成ネットワークのエンドツーエンドの共同設計を行うことができます。提案モデルの精度は、シミュレートされた点像分布関数 (PSF) を理論結果と比較することで検証し、また、シミュレーション実験では、Zemax などの市販ソフトウェア パッケージに実装されているソリューションよりも当社のモデルの方が正確であることを示しています。実際の実験を通じて提案モデルの有効性を実証し、収差補正と拡張被写界深度 (EDoF) イメージングの両方で大幅な改善が見られました。提案モデルは、計算イメージング、計算写真、高度な光学設計における幅広いアプリケーションへのさらなる調査のきっかけになると考えています。

https://asia.siggraph.org/2024/session/?sess=sess223 より翻訳

光学系設計に革命かも。サウジアラビアのキングアブドラ科学技術大学KAUSTの研究チームが、屈折と回折を組み合わせたハイブリッドレンズの設計を可能にするEnd-to-Endモデルを開発しています。このEnd-to-Endモデル「Ray-Wave Model」は、回折光学素子(DOE)の位置を最適化することで、収差補正と被写界深度拡張を同時に実現しており、スマホカメラやHMDにも応用可能。レンズのサイズがとても小さいのですが、それでもレンズとしてしっかりと機能するようで驚きました。どのような使い心地なのか非常に気になります。

おまけ:KAUSTの研究者でDeepLensという研究をされている方もいらっしゃいます。Differentiable ray-tracing and wave-propagation model、という研究のようです。

https://github.com/singer-yang/DeepLens

https://arxiv.org/abs/2406.00834

MiNNIE: a Mixed Multigrid Method for Real-time Simulation of Nonlinear Near-Incompressible Elastics (MiNNIE:非線形近圧縮性弾性体のリアルタイムシミュレーションのための混合マルチグリッド法)

https://asia.siggraph.org/2024/presentation/?id=papers_148&sess=sess141

発表セッション:Elastics / Solvers / Neural Physics (弾性/ソルバー/ニューラル物理学)

https://asia.siggraph.org/2024/?post_type=page&p=32163&sess=sess141

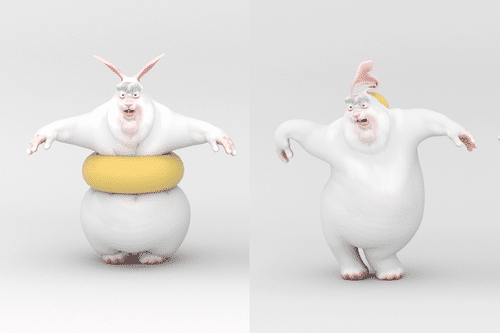

本研究では、非線形近圧縮性弾性体のリアルタイムシミュレーションのための、シンプルかつ包括的なフレームワークであるMiNNIEを提案する。線形有限要素法(FEM)の高ポアソン比における一般的な体積ロックの問題を回避するために、MiNNIEを混合FEMフレームワーク上に構築し、さらにマルチグリッドソルバの優れた収束を保証する圧力安定化項を組み込む。私たちの圧力安定化戦略は、準ニュートン法を使用して除去することができる節点変位に有界の影響を注入します。MiNNIEは、修正されたスキニング空間補間スキーム、新しい頂点Vankaスムーザー、およびSchur補数を使用した効率的な密なソルバーを含む、特別に調整されたGPUマルチグリッドソルバーを備えています。MiNNIEは様々な弾性材料モデルをサポートし、リアルタイムでシミュレーションを行い、0.5までのあらゆるポアソン比をサポートすると同時に、大きな変形、要素の反転、自己衝突を処理します。

キャラクターモデルをリアルタイムで変形させたりアニメーションさせたりするための新たな手法とのことです。キャラクターの動きがスライムのようになるのですが、リアルタイムのシミュレーションという点が興味深いです。

A Unified MPM Framework supporting Phase-field Models and Elastic-viscoplastic Phase Transition (位相場モデルと弾性-粘塑性相転移をサポートする統合MPMフレームワーク)

https://asia.siggraph.org/2024/presentation/?id=tog_109&sess=sess144

発表セッション: Fluid Simulation (流体シミュレーション)

https://asia.siggraph.org/2024/presentation/?id=tog_109&sess=sess144

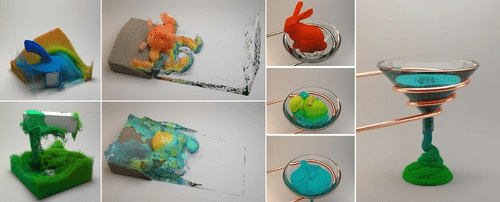

近年、流体、固体、およびそれらの微妙な結合に関する物理ベースのモデリングやシミュレーションのアルゴリズムや手法が、コンピュータアニメーションにおいて急速に普及しています。しかし、流体-固体の相転移に伴う複雑な弾性-粘塑性挙動をモデル化し、同じフレームワーク内でシームレスな相互作用を促進することは、依然として困難な問題である。本稿では、粒状流体、粘塑性液体、弾塑性固体、剛体、および相互作用をシミュレートし、溶解、融解、冷却、膨張、収縮など、現実的な相転移を伴う新しい現象をすべて重くサポートできる実用的な手法を提案する。物理学のレベルでは、粒状、弾性、塑性、粘性材料、液体、非ニュートン流体、およびそれらの滑らかな進化の挙動を記述することができる、統一された位相場駆動EVPモデルを確立するために、フォンミーゼスとドラッカー・プラーガーおよびカム・クレイ降伏モデルを組み合わせ、変形させることを提案する。数値計算レベルでは、Cahn-Hilliard方程式とAllen-Cahn方程式の離散化形式を物質点法によって導出し、界面における境界条件の明示的な取り扱いを避けることで、位相場の進化を効果的に追跡する。応用レベルでは、化学ポテンシャル、密度曲線など、ユーザー定義のスキームを用いて特殊な挙動を制御する新しい学問的戦略を設計する。この新しい統一的アプローチの有効性と汎用性を検証するために、困難なシナリオからなる多数の実験結果を示す。この柔軟で安定性の高いフレームワークは、様々な相間の統一的な取り扱いとシームレスな結合、そして効果的な数値離散化を基盤としており、相転移を多用する新しい現象に対して、芸術的な創造性と指導力をもってアニメーションを作成するというユニークな利点がある。

粘度の違うものを混ぜるシミュレーションです。個人的にはこういうシミュレーションが大好き! デモ動画では小麦粉に次第に牛乳を混ぜているようなシミュレーション結果が流れていました。このセッションは実際に足を運んでみてさらに詳しい情報を知りたいです。

https://dl.acm.org/doi/10.1145/3638047

他にも興味深い発表がいっぱい!

以上、流体好きが選ぶ、論文7本でした!

TPFFでは277本ぐらい発表があったので、個別に扱うと驚きやさんみたいになってしまいますが、WOW!は大事ですね。

他にもこんな発表がありました。

技術的、もしくは数理としての難しさなどはあると思いますが、やはり絵作りにおいて驚きのある映像をつくる、かつ物理的に正しいと考えられる方法を探求されているところは興味深く、本編の発表にも足を向けていきたいと思います!

この記事に「いいね!」と思ったら、いいねとフォロー、おすすめをお願いします!

https://note.com/aicu/ X(Twitter)@AICUai

★会期中「これを取材して!!」というリクエストもDMでどうぞ!

このようなイベントのレポートに興味がある方はこちらもオススメ

https://ja.aicu.ai/category/events/

この記事に「いいね!」と思ったら、いいねとフォロー、おすすめをお願いします!

Originally published at https://note.com on Dec 5, 2024.

![AICU Magazine Vol.6 「Entertainment x AI」プレミアムカラー・ペーパーバック版発売開始です!https://amzn.to/3Zao1Ii AICU Magazine Vol.6 [Entertainment x AI] (AICUマガジン)amzn.to 2,750円(2024年12月03日 00:08時点詳しくはこちら) Amazon.co.jpで購入する](https://ja.aicu.ai/wp-content/uploads/2024/12/rectangle_large_type_2_fcef7d38a3babb69a72ea9cb2d079fe0-1-1024x536.png)