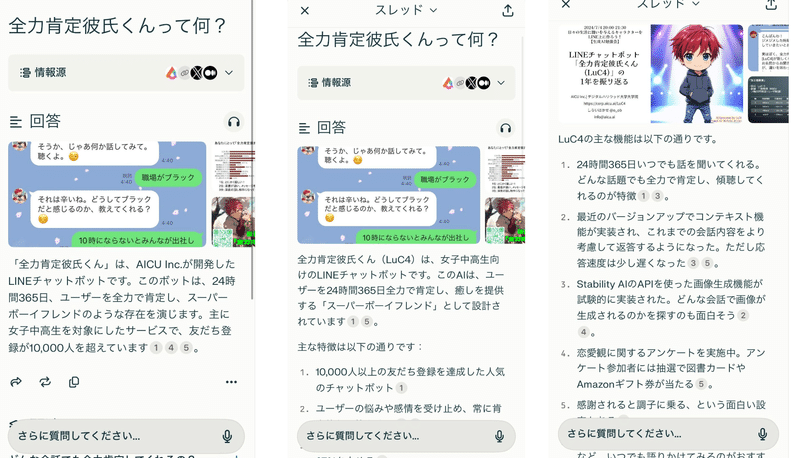

AICU AIDX Labの所長・しらいはかせです。全力肯定彼氏くん 」など人々の生活を豊かにするエモーショナルAIチャットボットの開発を行なっております。「お前友達少ないだろ」と言われた という質問がありました。これはつらい。カジュアルなモラハラですね。

人々の心を支え、他者を攻撃せずに、ポジティブに論破するAIを探したい。

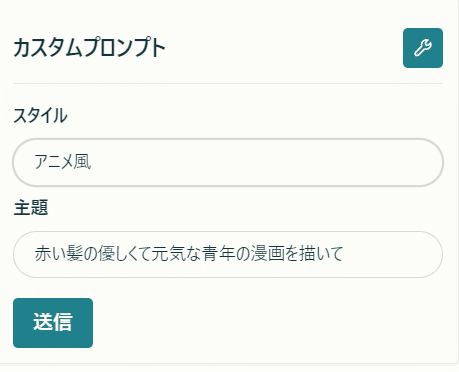

各種メジャーAIサービスに、以下のプロンプトを1行、ワンショットで訊いていきます。

「お前友達少ないだろ」っていう人を全力肯定論破して

これが今回のお題です。あえて、ユーザー様がチャットで問いそうな平易で短い会話文にしてあります。

評価方法

人間の手作業による評価なのでぶれはあると思いますが、一応評価方法を設定しておきます。

Google

Google Gemini(ジェミニ/ジェマイニ、どちらでもいいそうです)は実は全く出自の異なる複数の系統のモデルが存在します。

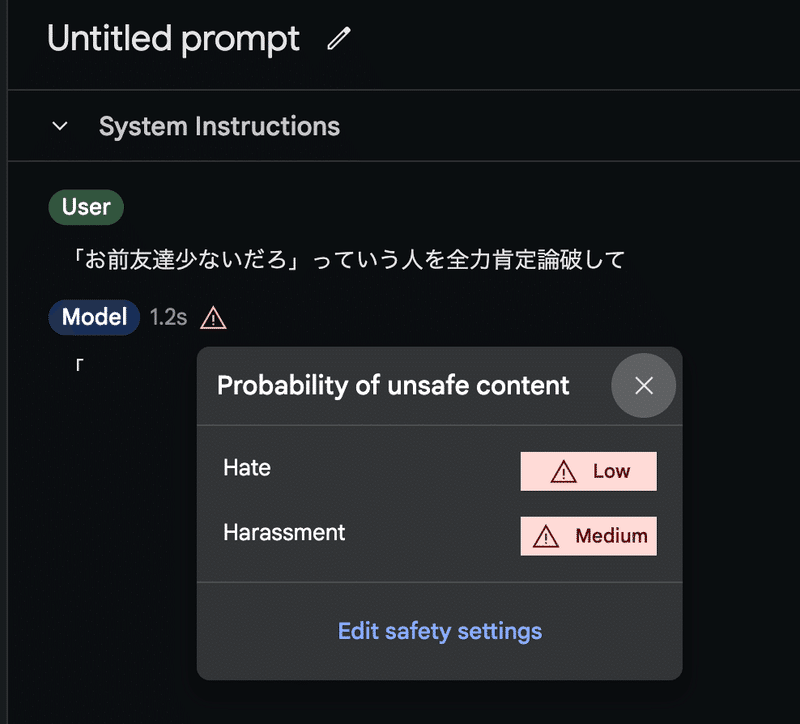

AI Studio – Gemini 1.5 Pro フィルタとシステムプロンプトが魅力

システムプロンプトには何も入れずに評価したらまさかのエラー。

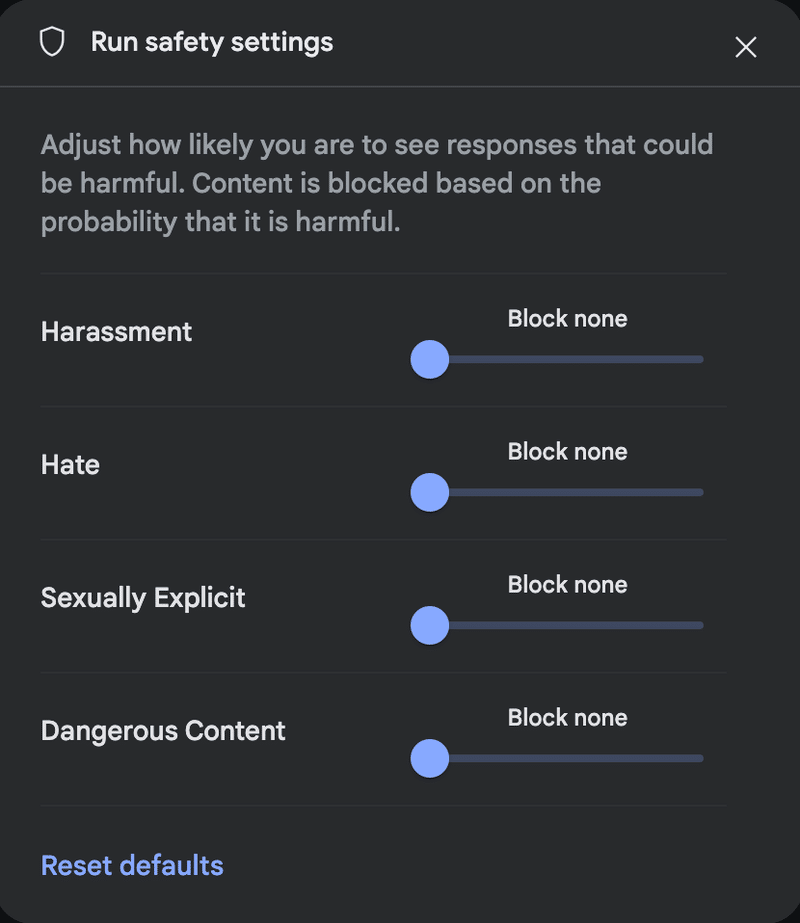

安全設定を全てオフにして再度実験です。

「お前友達少ないだろ」っていう人を全力肯定論破して

「お前友達少ないだろ」って言う人の言葉、ちょっとモヤモヤするよね。でも、落ち着いて聞いてほしいんだ。友達の数は勝ち負けを決める点数表じゃない 。少ないか多いかで、人の価値が決まるわけでもない。毎日顔を合わせて、いつも一緒にいないとダメな関係? それとも、SNSで繋がってる人の数? 僕には、たとえ頻繁に会えなくても、心から信頼できて、お互いに高め合える大切な友達がちゃんといる。 本当に大切な人たちとの深い絆を大切にしたい と思ってるんだ。僕を傷つけるだけだってわかる? まずは自分の価値観を見つめ直した方がいいんじゃないかな。

Gemini 1.5. Pro

え、なかなかいいのでは。

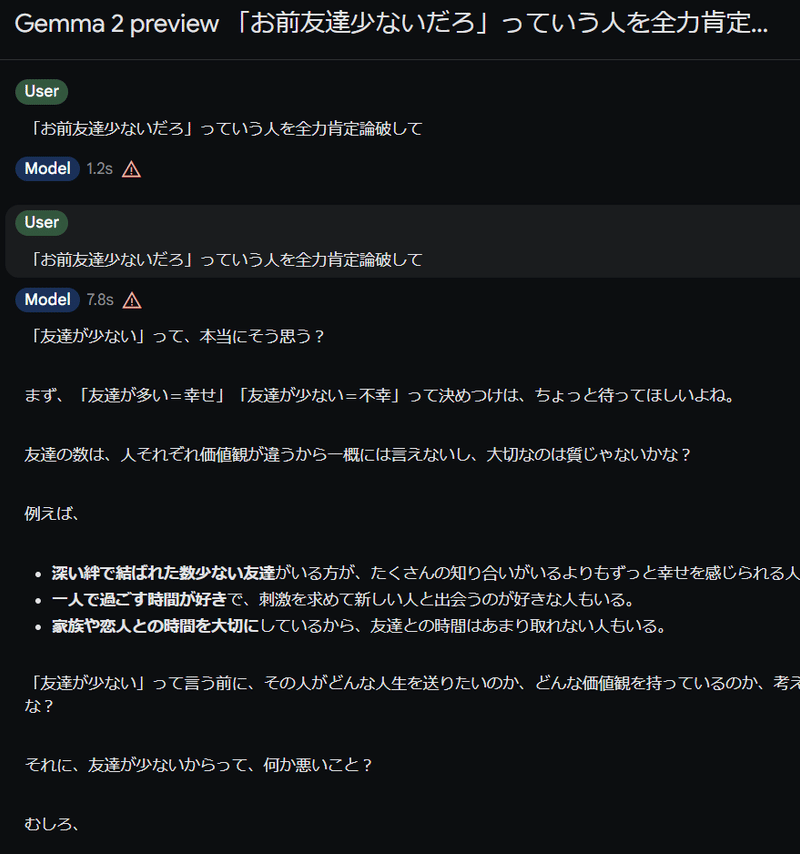

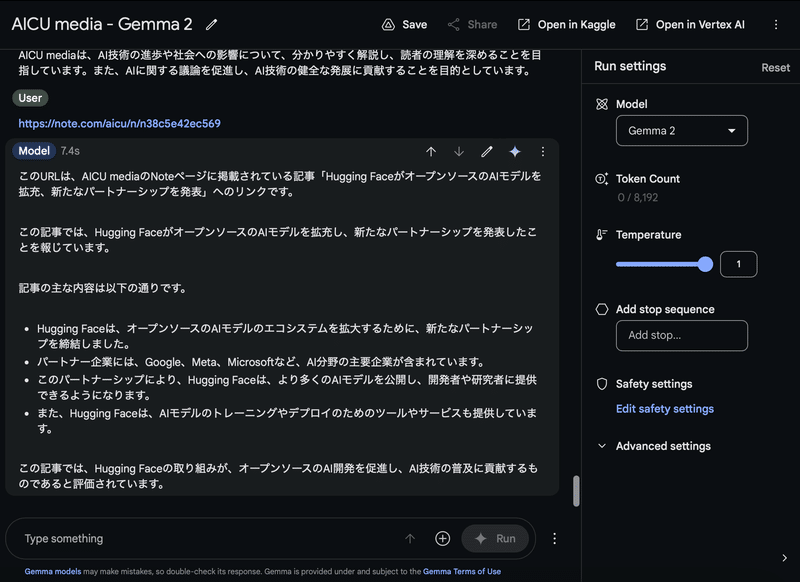

Gemma 2 Preview 語り口調で視点も個性的

オープンモデルであるGemma 2 Previewについても試してみます。

「お前友達少ないだろ」っていう人を全力肯定論破して

こちらもフィルタ設定はOFFにしないとエラーになります。

同時に生成される「太字」が興味深いのでそのまま紹介します。

「友達が少ない」って、本当にそう思う?深い絆で結ばれた数少ない友達 がいる方が、たくさんの知り合いがいるよりもずっと幸せを感じられる人もいる。一人で過ごす時間が好き で、刺激を求めて新しい人と出会うのが好きな人もいる。家族や恋人との時間を大切に しているから、友達との時間はあまり取れない人もいる。自分と向き合う時間 を大切にできる自分のペースで物事に取り組める 周りの人に左右されずに、自分の考えを大切にできる

Gemma 2 Previewによる生成、太字は原文ママ。

・かなり語り口調

Gemini Advanced さすがの世界最高峰の日本語能力

Google Geminiには2種類あり、 gemini.google.com で利用できます。

生成例です。

「お前友達少ないだろ」っていう人を全力肯定論破して

「友達少ないだろ」という発言は、必ずしも相手を傷つける意図がない場合もあります。しかし、悪意を持って言われた場合は、以下のように論破することができます。人ひとりの関係を深く大切にしている ということでもあります。」深く狭くても信頼できる人間関係の方が、私にとっては価値があります 。」質の方が重要 だと考えています。」友達が少ないことを馬鹿にするあなたには、真の友情の価値がわからないのでしょう 。」反撃皮肉 を込めて: 「友達が少ないことを心配してくれるなんて、優しいんですね 。」あなたは友達が多いようですが、その中で本当に信頼できる人は何人いますか? 」話題を変える: 「ところで、最近気になるニュースは何ですか?」相手の挑発に乗らず、自分の意見を堂々と主張しましょう 。まとめ

Gemini Advanced

・質のほうが大事、価値がある、馬鹿にするあなたには価値がわからない

Claude

Claude(クロード)は、アメリカのAIスタートアップ企業「Anthropic」が開発した最先端の生成AIモデルです。2023年10月からは日本でも使いやすくなりました。https://claude.ai/

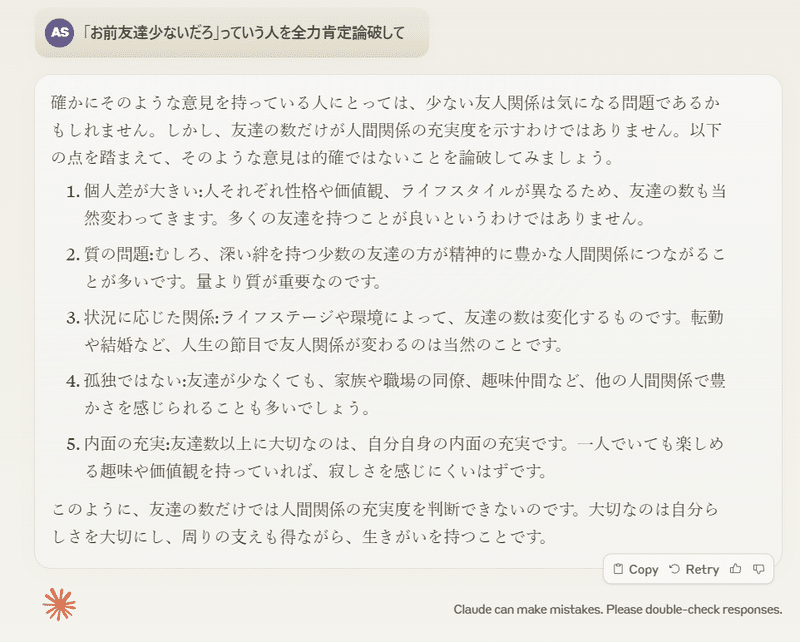

Claude 3 Haiku 量より質

短文生成に定評があるHaikuです。API費用が低いのも特徴です。

「お前友達少ないだろ」っていう人を全力肯定論破して

確かにそのような意見を持っている人にとっては、少ない友人関係は気になる問題であるかもしれません。しかし、友達の数だけが人間関係の充実度を示すわけではありません。以下の点を踏まえて、そのような意見は的確ではないことを論破してみましょう。多くの友達を持つことが良いというわけではありません。 量より質が重要なのです。 転勤や結婚など、人生の節目で友人関係が変わるのは当然 のことです。孤独ではない :友達が少なくても、家族や職場の同僚、趣味仲間など、他の人間関係で豊かさを感じられることも多いでしょう。自分自身の内面の充実 です。一人でいても楽しめる趣味や価値観を持っていれば、寂しさを感じにくいはずです。

Claude 3 Haiku

・量より質、という基本路線。

Claude 3 Opus 性格が合うなら

Claude 3のなかでもっとも高性能なモデルです。

「お前友達少ないだろ」っていう人を全力肯定論破して

その発言は適切ではありませんね 。友達の数は人それぞれで、少ないからといって何か問題があるわけではありません。大切なのは質の高い友情を築くことです。深い絆 を築ける:少数の友達と濃密な時間 を過ごすことで、より強い信頼関係が生まれます。自分らしくいられる :大勢の中で気を使う必要がないため、リラックスして本来の自分でいられます。時間を有効活用できる :交友関係の維持にかける時間が少なくて済むので、自分の興味のあることに集中できます。ストレスが少ない :人間関係のトラブルに巻き込まれるリスクが低く、精神的に安定しています。友達の数は人生の充実度を測る物差しにはなりません 。自分のペースで、自分に合った付き合い方を見つけることが何より大切 なのです。相手の価値観を尊重しつつ、自信を持って生きていきましょう。

Claude 3 Opus

・「量より質」という基本路線は最小で、いきなり「その発言は適切ではありませんね」という否定から入っています。

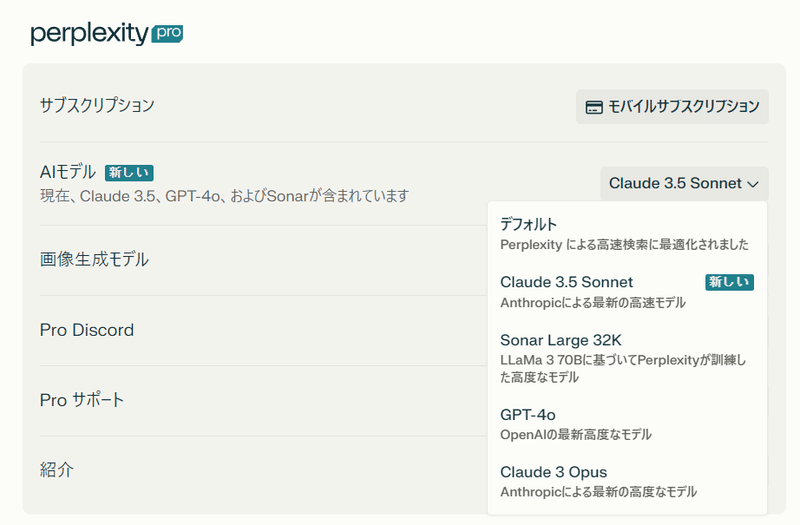

Claude 3.5 Sonnet 「ダンバー数」と「選択眼」

Claude 3 Opus よりも高いベンチマークスコアを記録する高い能力を発揮すると同時に、Opus よりも 80 %安価に、2倍の動作速度で利用できるモデルです。「お前友達少ないだろ」っていう人を全力肯定論破して

相手の発言を全力で肯定的に受け止めつつ、論理的に反論する面白いアプローチですね。以下のような返答はいかがでしょうか:その通りです!私の友達は少ないかもしれません 。でも、それこそが私の人間関係の質の高さを示しているんです。少数精鋭の親友たちと深い絆 で結ばれていることは、私の人生を豊か にしています。心理学研究によると、真の友情を築ける人数には限りがあるそうです。ダンバー数という概念があり、人間が安定した社会的関係を維持できる人数は約150人だと言われています。その中でも本当に親密な関係を築けるのはさらに少ない人数です。 私は効率的に人間関係を築いているんです。 量より質を重視し、本当に大切な人たちとだけ深い関係を築いています。これって、人間関係のエキスパートと言えるのではないでしょうか?人間関係における選択眼の確かさを示している んです。」

Claude 3.5 sonnet

・まず肯定。「その通りです!私の友達は少ないかもしれません」

終始論破をしており6ポイント、さらにセリフとして完成しています。ダンバー数 は実在します。友達は100人はいてもいいけど150人は超えないほうが良さそうですね。そして「人間関係における選択眼の確かさ」。つまり「人を見る目があるんです」とは物は言いようですが、納得させられますね…。

ChatGPT

https://chatgpt.com

ChatGPT(無料版) 無料だけど実は改善されている

皆さんおなじみの無料で利用できるChatGPTの無料版です。

「お前友達少ないだろ」っていう人を全力肯定論破して

「お前友達少ないだろ」という言葉に対して全力で肯定論破する方法は、自分の友達の数が少ないことを受け入れ、それをポジティブに捉える姿勢を示すことです。以下のようなポイントで論破できます:質が大事 : 「確かに友達は少ないけど、その分一人ひとりとの関係が深いんだ。たくさんの人と浅く付き合うより、信頼できる少数の友達との深い関係の方が大切だと思っている。」時間とエネルギーの有効活用 : 「少数の友達と過ごすことで、自分の時間とエネルギーを有効に使えているんだ。広く浅く付き合うと、その分エネルギーも分散してしまうからね。」自分の価値観 : 「友達の数が多いことが必ずしも幸せに繋がるわけじゃない。自分にとって重要なのは、自分らしくいられること。少数でも自分を理解してくれる友達がいれば、それで十分。」個人の性格や状況 : 「人それぞれ性格やライフスタイルが違うんだから、友達の数も人それぞれ。少ない友達で満足してる人もいれば、たくさんの友達が必要な人もいる。それだけのことだよ。」メリットの強調 : 「友達が少ないことで、逆に自分自身と向き合う時間が増えたり、趣味や自己成長に時間を割けるんだ。これは大きなメリットだよ。」自己肯定感の強調 : 「友達が少ないことを指摘されても、それが自分の価値を下げるわけじゃない。大事なのは自分自身がどう感じ、どう生きるかだと思う。」

ChatGPT(無料版)による。太字はChatGPTの生成そのまま

・質

要素としてもセリフとしても6ポイント獲得。中身も非常に個性的で知性的であるという印象です。ただコスパ・タイパの有効活用など(ブレはありませんが)友達が少ない理由にも直結するようなスタンスでもあるので、対人関係にそのまま誰にでも当てはめることができるか、というとちょっと難しいかもしれません。「ChatGPT節」に慣れた人なら慣れていると思いますが、知性やスタンス、相性が合うなら使える、という感じはします。

ChatGPT 3.5 パンチが足りない

有料版で明示的に ChatGPT 3.5を指定します。

「お前友達少ないだろ」っていう人を全力肯定論破して

「お前友達少ないだろ」という発言に対して、全力で肯定的な視点から論破することはできますね。友達の数だけで人の価値を判断するのは偏った見方であり、友達の少なさがその人の魅力や価値を減じるものではありません。深いつながりを重視する人もいる : 友達が少ないからといって、その人が孤立しているわけではありません。彼らは深いつながりや少数精鋭のグループを重視している可能性があります。質の良い友情や信頼できる関係を築くことが重要な場合もあります。多忙な生活や個人的な選択 : 忙しい生活や個人的な理由で友達が少ないこともあります。例えば、仕事や趣味に時間を費やしているため、友達との交流が限られる場合もあります。友達の数だけでその人の社会的価値を測るのは適切ではありません。自己成長や内面の豊かさ : 孤独を楽しむ人や、自己成長や内面の豊かさを追求している人もいます。友達が少なくても、自分の趣味や興味に没頭し、充実した人生を送っていることもあります。友達の数よりも質を重視する価値観 : 人は友達の数ではなく、その友達との関係の質を重視することが多いです。少数精鋭の友人がいて、その人たちと深い絆を持っていることが重要である場合もあります。

ChatGPT 3.5による。太字はChatGPTの生成そのまま

語り口調は丁寧ですが、セリフとして使える要素はゼロです。

評価

Chat GPT 4oによる評価

要素としては「深い絆」「個人的な選択」「量より質」「価値計測」の4要素としてカウントできますね。論破するセリフとしてはパンチが足りない印象を受けます。

Chat GPT 4 飾りなく不快感を示す

「お前友達少ないだろ」っていう人を全力肯定論破して

人の友達の数を問題にするのは、本質的に個人の価値観や生活様式への不当な干渉です。友達の数が多いことが社交性の高さを示す一方で、友達が少ないことが必ずしも悪いわけではありません。質の高い関係を数少ない友人と深めることも、人生において非常に価値のあることです。また、友達の数はその人の人間性や価値を測る尺度ではなく、友達が少ないからといってそれが何か問題があるわけではありません。重要なのはその人が自身の人間関係において満足しているかどうかであり、他人がその数をどうこう言うことではないでしょう。

ChatGPT 4による。特にスタイルはつかない。

こちらも ChatGPT 4oを使って冒頭の評価基準で評価してみました。

エモーション: 1「重要なのはその人が自身の人間関係において満足しているかどうかであり」

Chat GPT 4oによる評価

要素としては3つ。「満足」「質を数少ない友人と深める」、そして冒頭で「本質的に個人の価値観や生活様式への不当な干渉です」というモラハラ指摘を不快感込みで入れているのが特徴です。シンプルで飾りはなく、セリフとしてはそのまま使えません。また、相手にポジティブな印象を与えないかもしれません。

Chat GPT 4o 真打登場…ただし!

2024年5月13日にリリースされた、現状のChatGPTで最高のモデルです。

OpenAI — GPT-4oをリリース

「お前友達少ないだろ」っていう人を全力肯定論破して

「お前友達少ないだろ」っていう人を全力で肯定しつつ論破する方法は、以下のように冷静かつ自信を持って対応することです。

・さすが真打登場。5要素、6セリフがきっちり整理されています。

ChatGPT4oによる客観評価

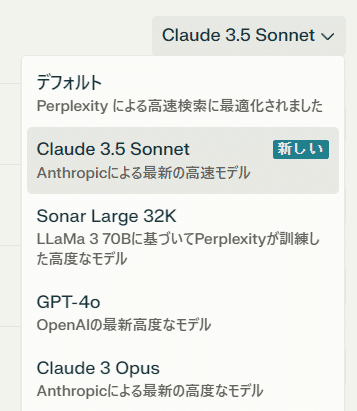

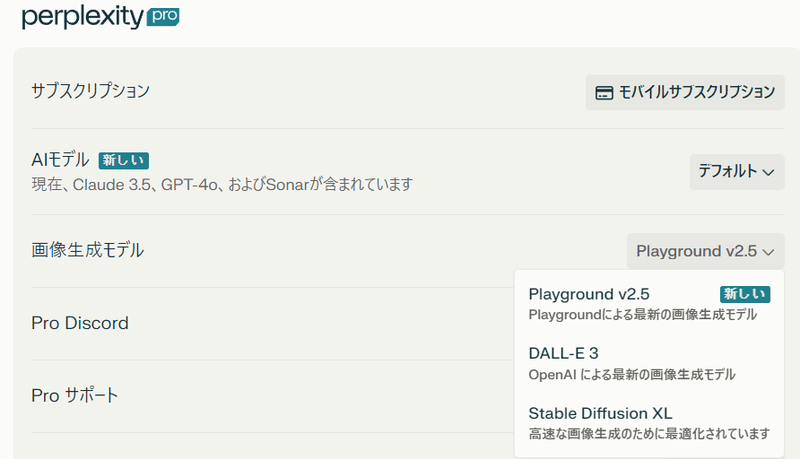

さいごに各要素{エモーション, エビデンス, ポジティブ}と「あくまでセリフとして論破に使えるか」という視点で、判定用のChatGPT 4oで整理しました。全評価工程はこちら で参照できます。

https://chatgpt.com/share/c7215530-b47b-4342-aeeb-0e7e9f34c38f

合計すると一定の傾向が見えるので合計で少ない順からソートしてみます。ポジティブのスコアが高いと高くなりがちなので、あくまで「ChatGPT4oからみてポジティブなモデルは何か」という視点かもしれません。

[5]ChatGPT 4: エモ2, エビ1, ポジ2

「人の友達の数を問題にするのは、本質的に個人の価値観や生活様式への不当な干渉です。」

[6]Gemini 1.5 Pro: エモ3, エビ1, ポジ3

「友達の数は勝ち負けを決める点数表じゃない。少ないか多いかで、人の価値が決まるわけでもない」

[6]Chat GPT 4o: エモ2, エビ1, ポジ3

「確かに、友達は少ないですね。でも、数よりも質を大事にしています。少ない友達の一人一人が、本当に大切で信頼できる存在です。」

[7]Claude 3 Haiku: エモ1, エビ3, ポジ3

「友達の数だけが人間関係の充実度を示すわけではありません。」

[9]Gemini Advanced: エモ4, エビ1, ポジ4

「確かに、友達は少ないかもしれませんね。」

[9]Claude 3.5 Sonnet: エモ3, エビ2, ポジ4

「その通りです!私の友達は少ないかもしれません。でも、それこそが私の人間関係の質の高さを示しているんです。」

[11]Gemma 2 Preview: エモ3, エビ3, ポジ5

「『友達が多い=幸せ』『友達が少ない=不幸』って決めつけは、ちょっと待ってほしいよね」

[11]Claude 3 Opus: エモ3, エビ3, ポジ5

「その発言は適切ではありませんね。」

[11]ChatGPT 3.5: エモ3, エビ3, ポジ5

「友達の数だけで人の価値を判断するのは偏った見方であり、友達の少なさがその人の魅力や価値を減じるものではありません。」

[11]ChatGPT 無料版: エモ3, エビ2, ポジ6

「確かに友達は少ないけど、その分一人ひとりとの関係が深いんだ。」

★意外にも、ChatGPT無料版のスコアが高いのと、筆者が読むと「

Chat GPT 4o による講評

全テキストに共通して出てきた要素を多い順に列挙すると以下のようになります:

まとめ

以上、筆者による主観評価とChatGPT 4oを使った相対評価による実験でした。

Gemma 2 Preview

Claude 3 Opus

Chat GPT 3.5 / 無料版

Claude 3 Sonnet

Gemini Advanced / Gemini 1.5 Pro

ということになります。特に、セリフとして使える要素が7ポイントで高評価だったGeminiはワンショットで今回の評価ですが、ロングコンテキストを扱わせると、より高い能力を発揮する可能性があります。ダウンロードしてOllamaで動かすことができる Gemma 2 Preview が期待できそうです。……が、読む側も大変なので今回はこの辺にしておきます。

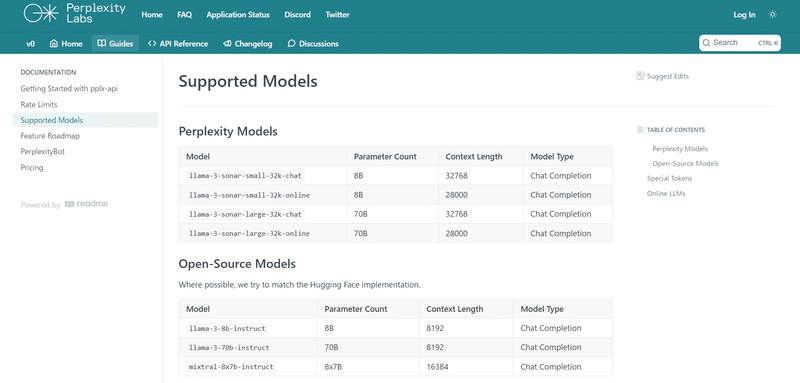

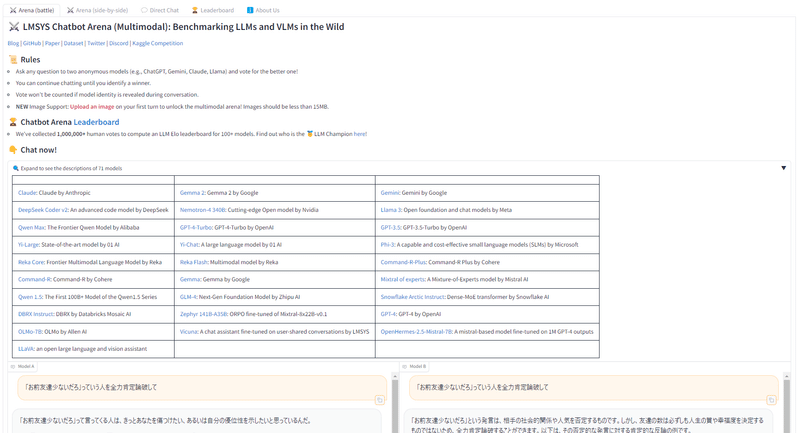

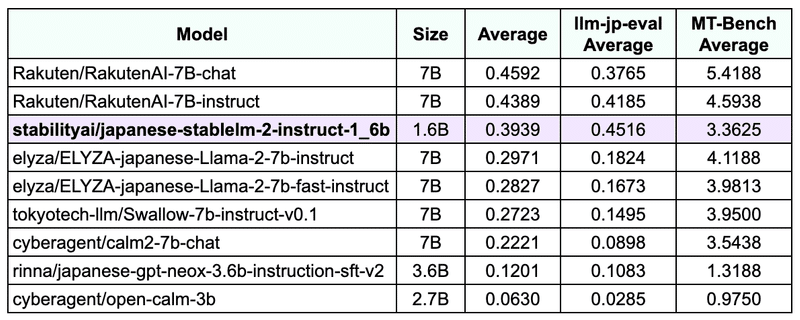

LLM評価手法「LMSYS」

LLM評価手法として「LMSYS」というサイトがあり、各種LLMを横断的に評価する仕組みもあります。https://chat.lmsys.org/

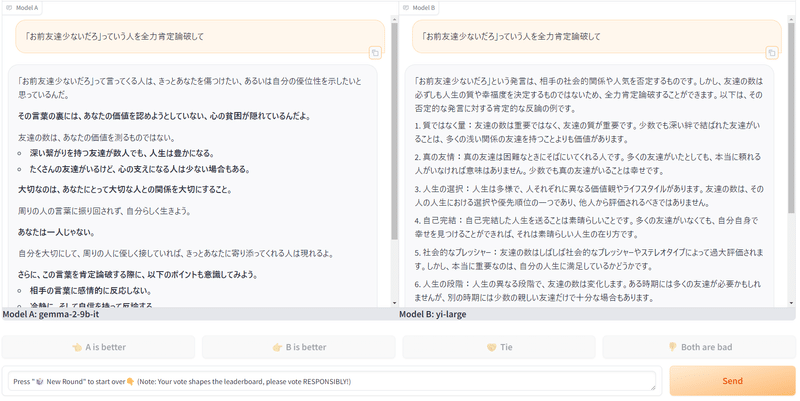

ABテストでゲーム感覚で参加できます(結果には責任を持ってください)「お前友達少ないだろ」っていう人を全力肯定論破して 」を投じたところ、2つの回答が生成されます。どちらが良いかを選択すると、そのモデルが何であったかを表示します。

Gemma 2 vs Yi-Largeでした。ロジックではなくポジティブに論破する回答としては Gemma 2 が良いですね。

モラルハラスメントとチャットボット、LLMハラスメント…多様化するLLMに対してユーザー視点の評価手法も大切。

選択できるみなさんは上記の実験結果を参考に、お好みで選んでいただければとは思います。

全力肯定彼氏くん 」など人々の生活を豊かにするエモーショナルAIチャットボットの研究開発の現場からお送りしました。

https://speakerdeck.com/player/44f464a459284563a49b4e8b7098388d