2024年10月22日23時(日本時間)、Stability AI による最新ベースモデル「Stable Diffusion 3.5」のオープンリリースがアナウンスされました。

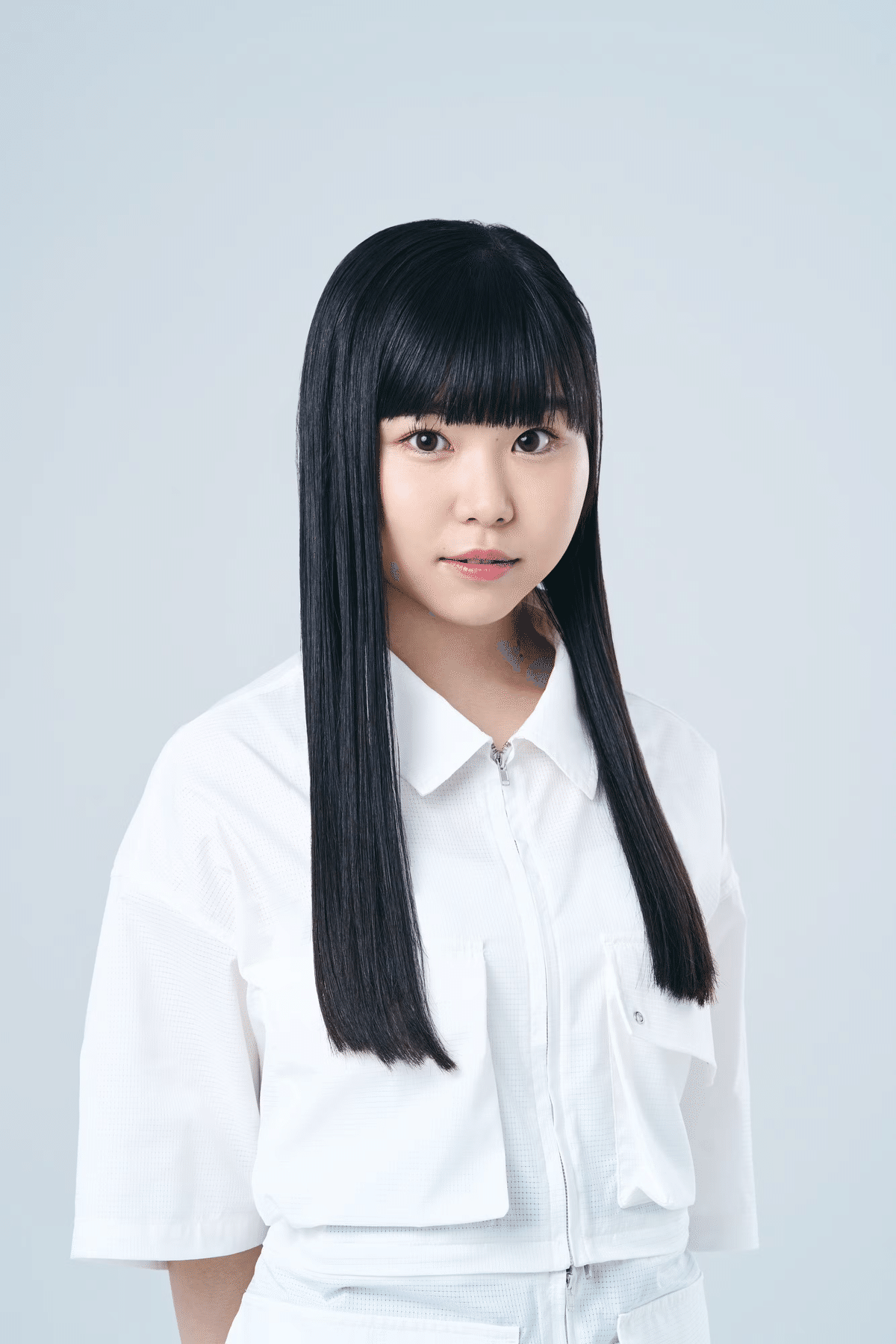

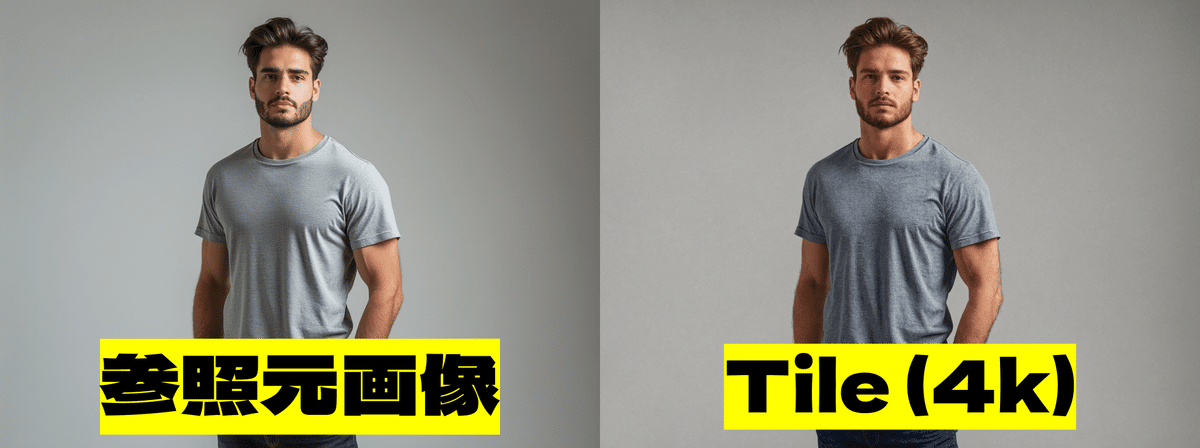

AICU編集部では「日本人の生成」を通してSD3.5の評価を実施しました。

最もパワフルなStable Diffusion 3.5をご紹介します。 このオープンリリースには、そのサイズに対して高度にカスタマイズ可能で、民生用ハードウェアで動作し、寛容なStability AI Community Licenseの下、商用・非商用ともに無料で使用できる複数のバリエーションが含まれています。 Hugging FaceのStable Diffusion 3.5 LargeとStable Diffusion 3.5 Large Turbo、そしてGitHubの推論コードを今すぐダウンロードできます。 Stable Diffusion 3.5 Mediumは10月29日にリリースされる予定です。

https://x.com/StabilityAI/status/1848729212250951911

日本語版公式リリースより

リリースされるもの

- Stable Diffusion 3.5 Large: 80億のパラメータ、1メガピクセル解像度。

- Stable Diffusion 3.5 Large Turbo: Stable Diffusion 3.5 Large の蒸留版、わずか4ステップで高品質な画像を生成。Stable Diffusion 3.5 Largeよりもはるかに高速。

- Stable Diffusion 3.5 Medium (10月29日リリース予定): 26億のパラメータ、改良されたMMDiT-Xアーキテクチャとトレーニング方法により、カスタマイズのしやすさと画質を両立させ、コンシューマー向けハードウェアで「箱から出してすぐに使える」ように設計されています。0.25~2 メガピクセルの解像度の画像を生成できます。

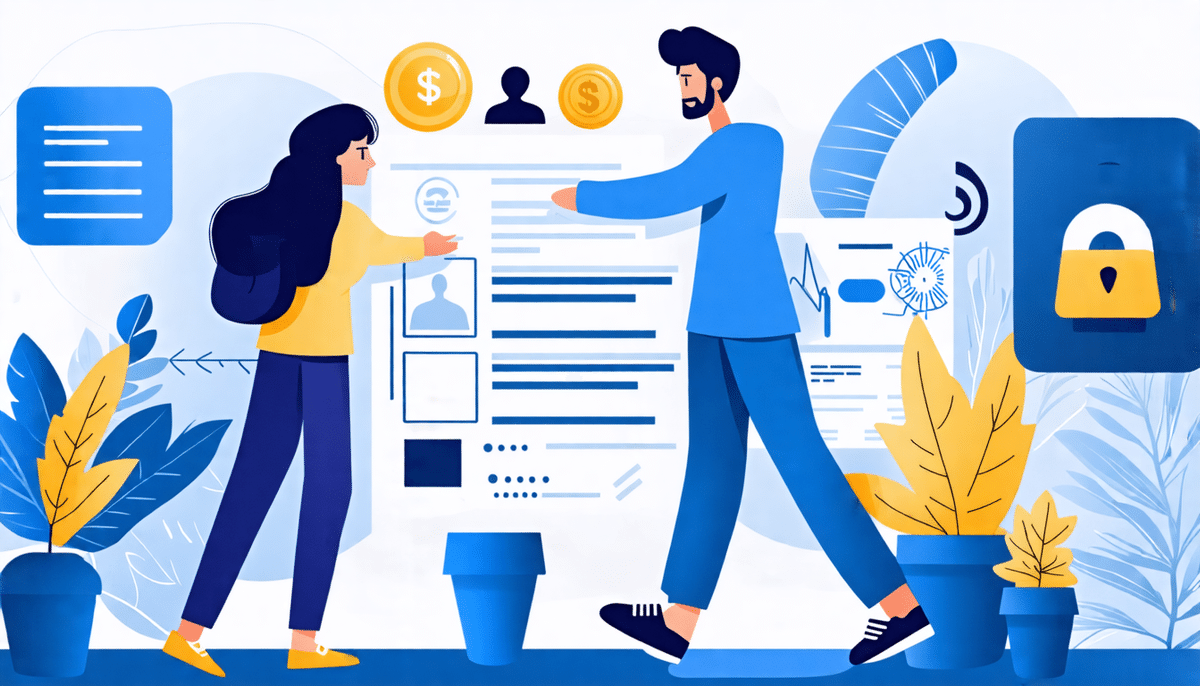

モデルの特徴(公式リリースより)

モデルの開発にあたっては、柔軟な基盤を構築できるよう、カスタマイズ性を優先しました。これを実現するために、Query-Key Normalization をトランスフォーマーブロックに統合し、モデルのトレーニングプロセスを改善し、さらにファインチューニングや開発を簡素化しました。

このレベルの下流での柔軟性をサポートするために、いくつかのトレードオフが必要でした。異なるシードを使用した同じプロンプトからの出力に、より大きなばらつきが生じる可能性があります。これは意図的なもので、ベースモデルにおける幅広い知識ベースと多様なスタイルの維持に役立ちます。しかし、その結果、特定性のないプロンプトでは出力の不確実性が増大し、見た目のレベルにばらつきが生じる可能性があります。

特にMediumモデルでは、品質、一貫性、およびマルチ解像度生成能力を向上させるために、アーキテクチャとトレーニングプロトコルにいくつかの調整を加えました。

モデルの優位性

- カスタマイズ性: 特定のクリエイティブニーズを満たすために、モデルを簡単にファインチューニングしたりカスタマイズされたワークフローに基づくアプリケーションを構築したりすることができます。

- 効率的なパフォーマンス:特にStable Diffusion 3.5 MediumおよびStable Diffusion 3.5 Large Turbo モデルでは標準的な一般消費者向けのハードウェアで高負荷をかけずに実行できるように最適化されています。

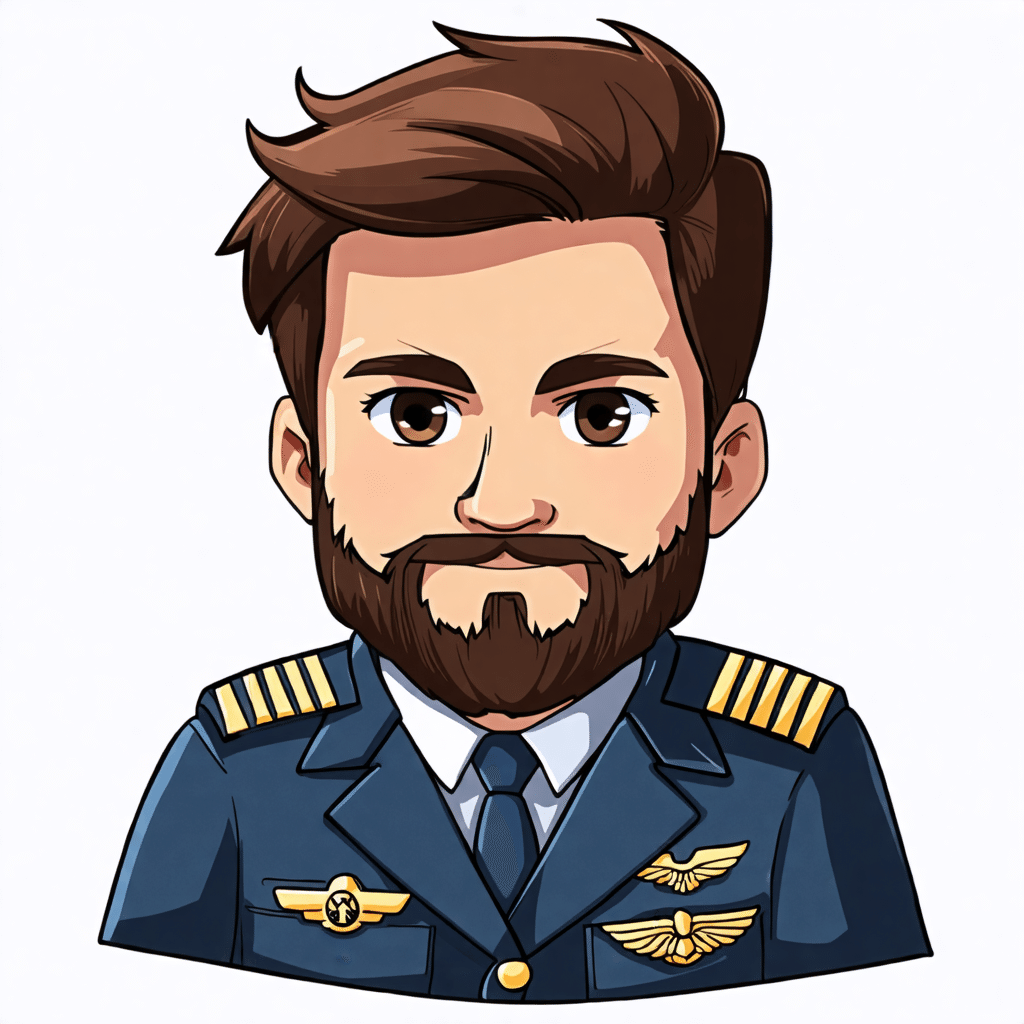

- 多様な出力:広範な指示を必要とせずに、特定の人物だけでなく、さまざまな肌の色や特徴を持つ世界を代表するような画像を作成します。

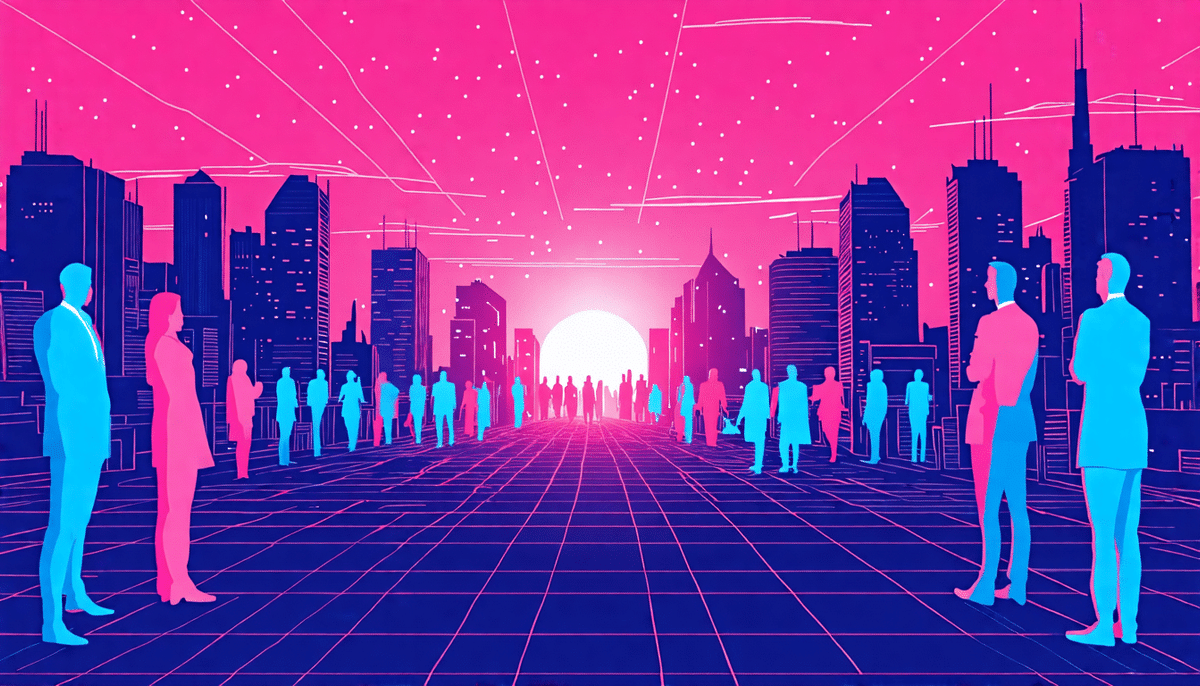

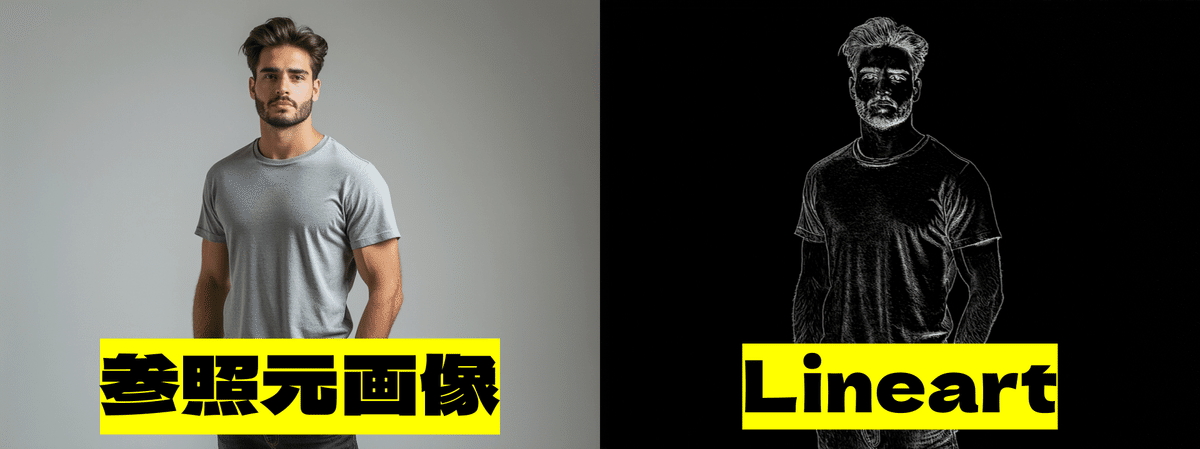

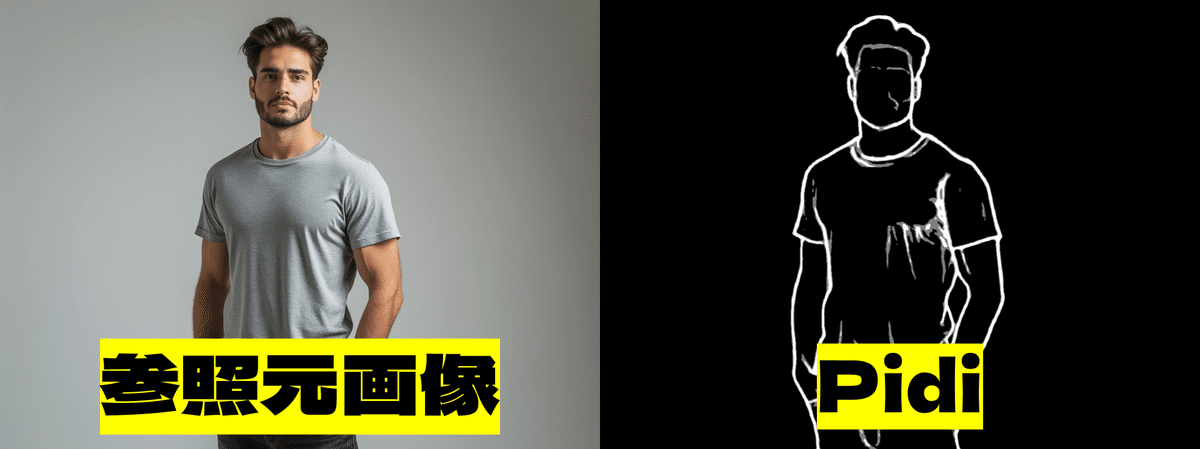

- 多彩なスタイル:3D、写真、絵画、線画など、幅広いスタイルと美しさを生成することが可能です。また、想像可能なほぼすべての視覚スタイルにも対応しています。

Stable Diffusion 3.5 Medium は、他の中型モデルを上回る性能を持ち、プロンプトの再現性と画像品質のバランスに優れていますので、効率的で高品質なパフォーマンスを求める場合の最適な選択肢となりうるでしょう。

Stability AI Community license の概要

https://ja.stability.ai/blog/introducing-stable-diffusion-3-5

community license の概要は以下の通りです。

- 非営利目的の場合は無料: 個人および組織は、科学研究を含む非営利目的の場合、無料でモデルを使用することができます。

- 商用利用も無料(年間収益100万ドルまで):年間収益が100万ドル未満のスタートアップ企業、中小企業、クリエイターは、商用目的でも無料でこのモデルを使用できます。

- 成果物の所有権:制限付きライセンスを伴うことなく生成されたメディアの所有権を保持します。

年間収益が100万ドル以上の企業は、エンタープライズライセンスをこちらからお問い合わせください。

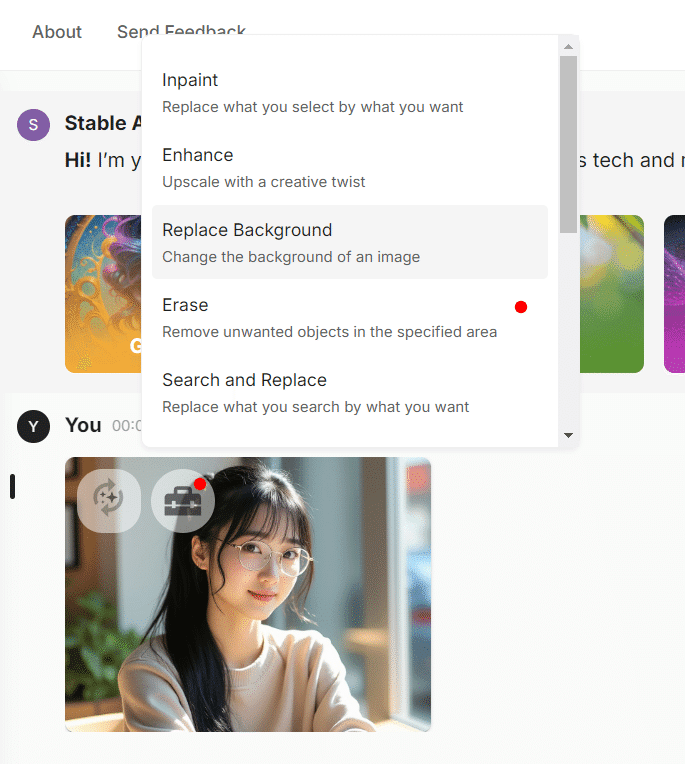

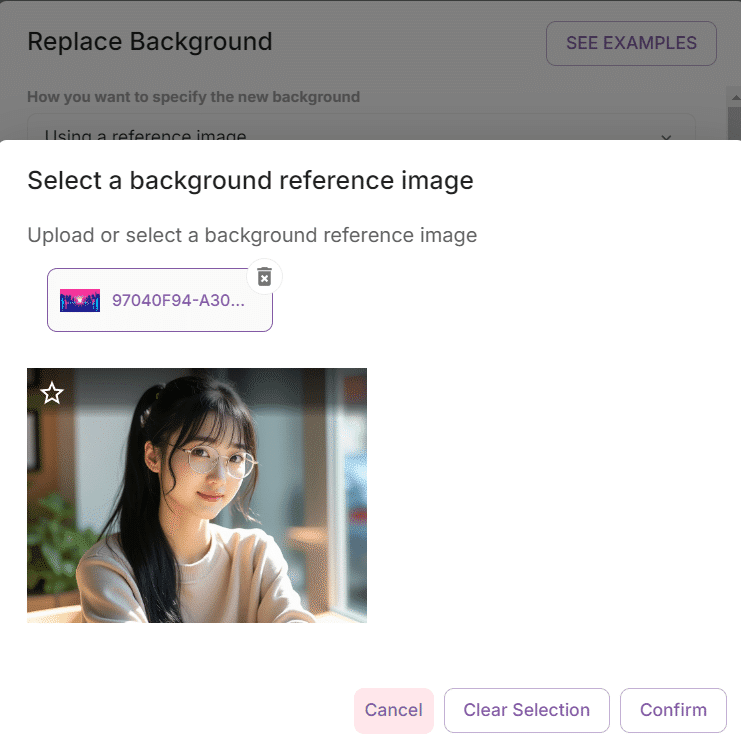

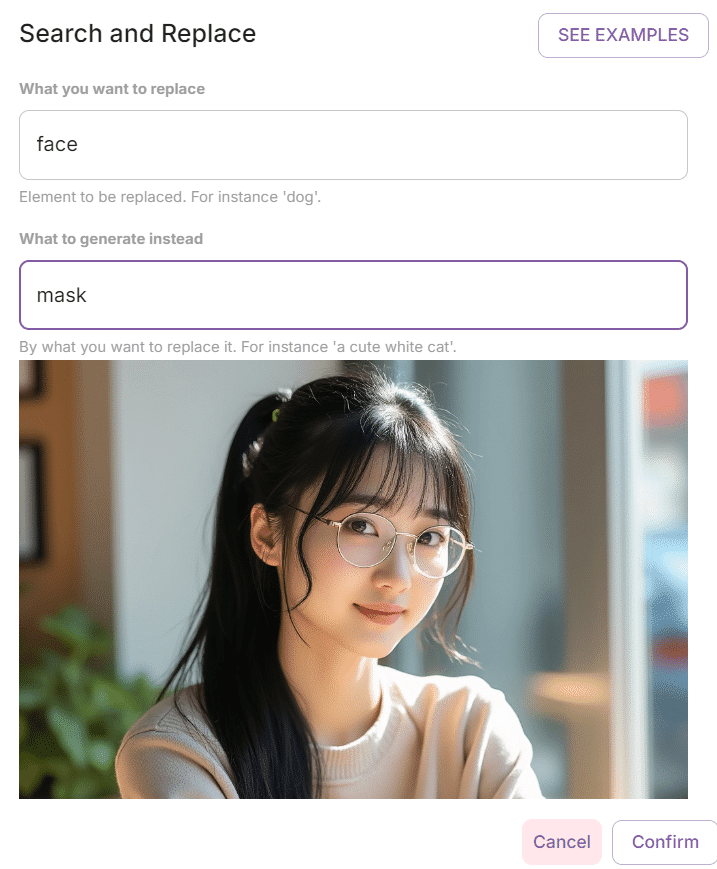

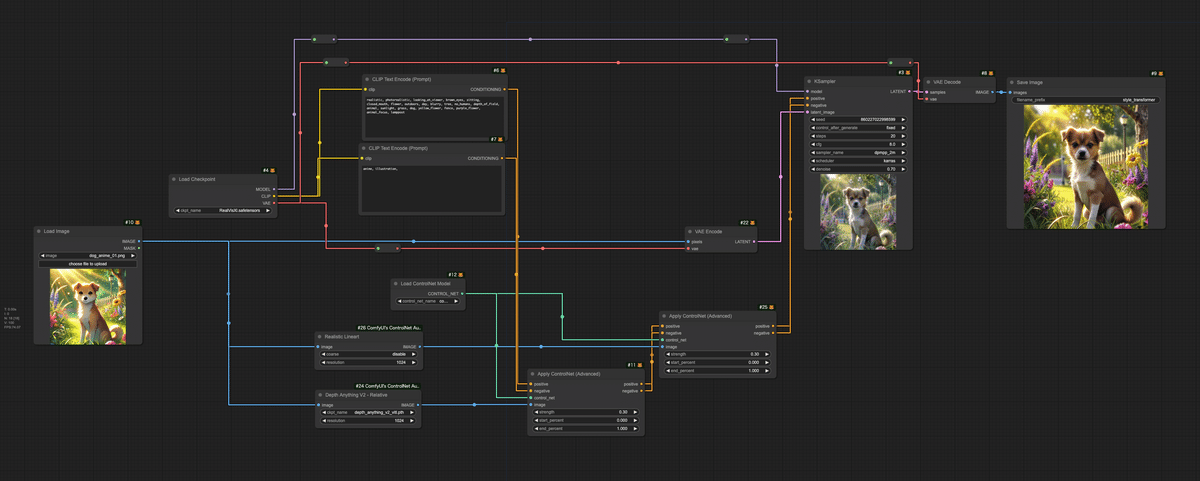

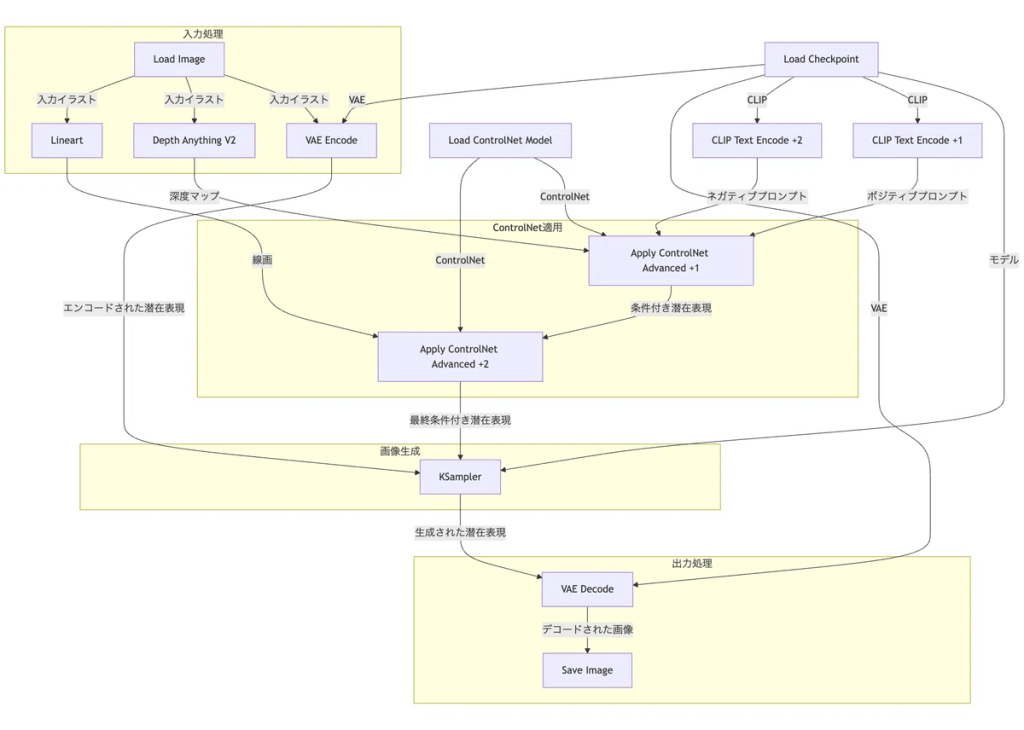

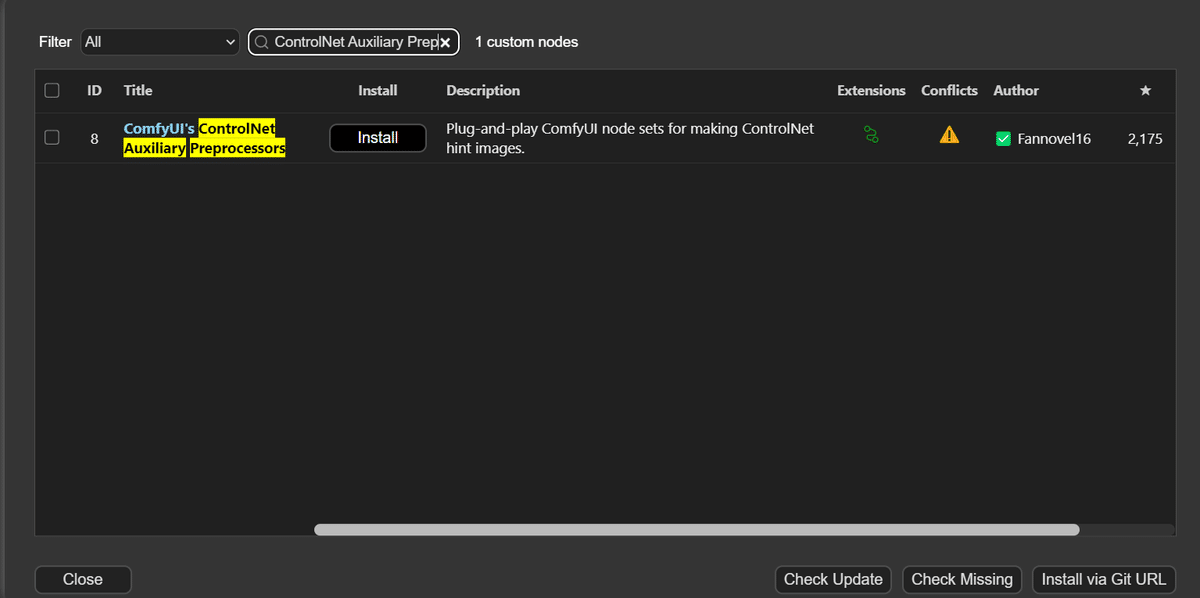

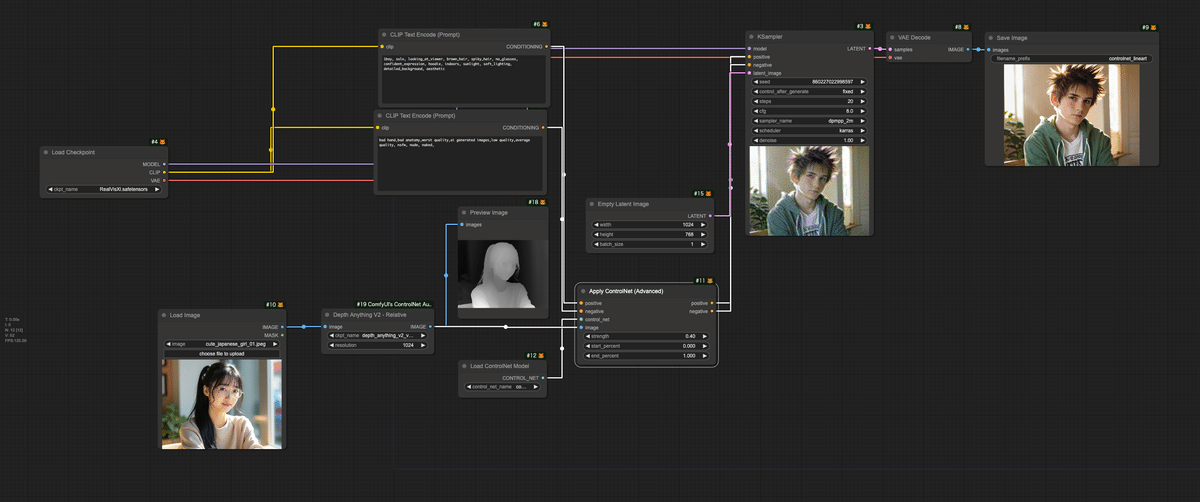

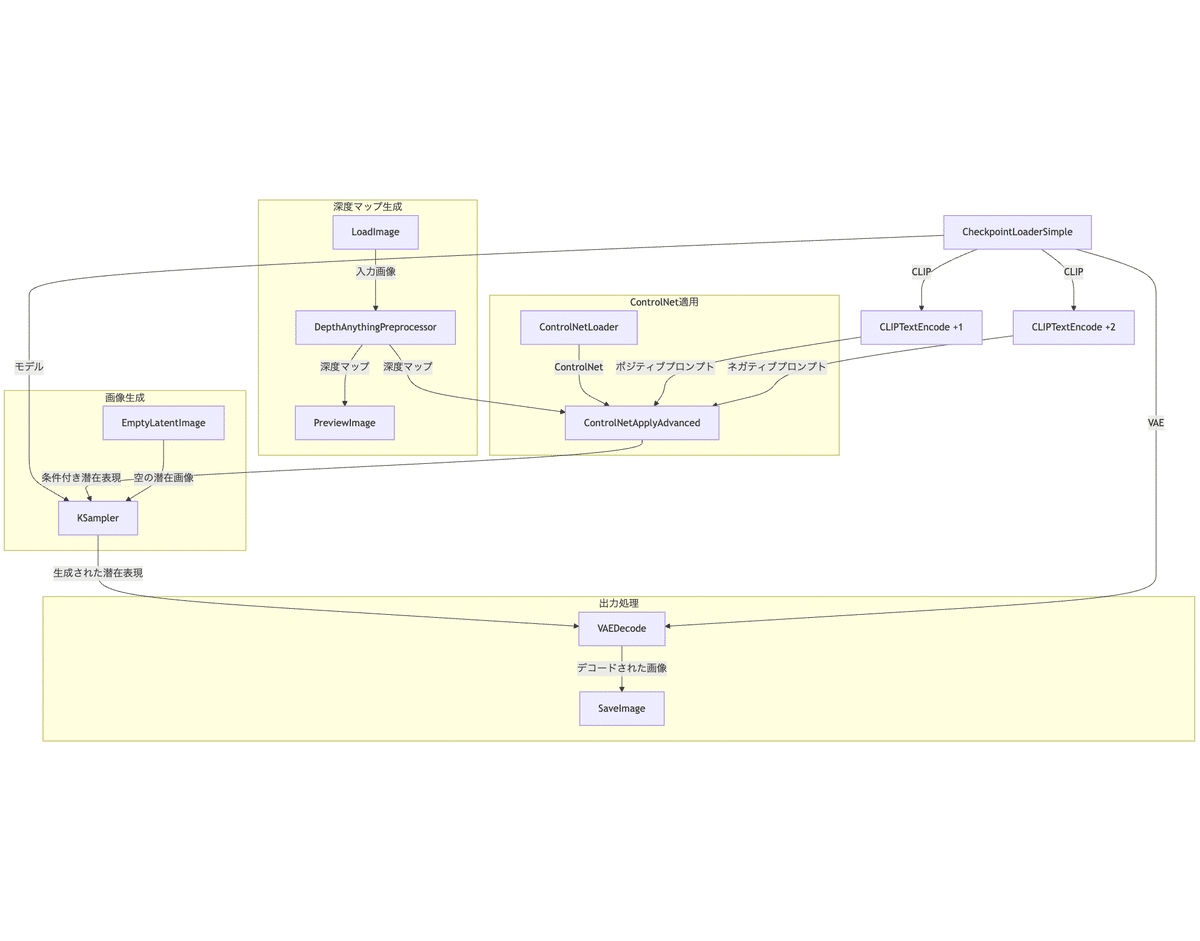

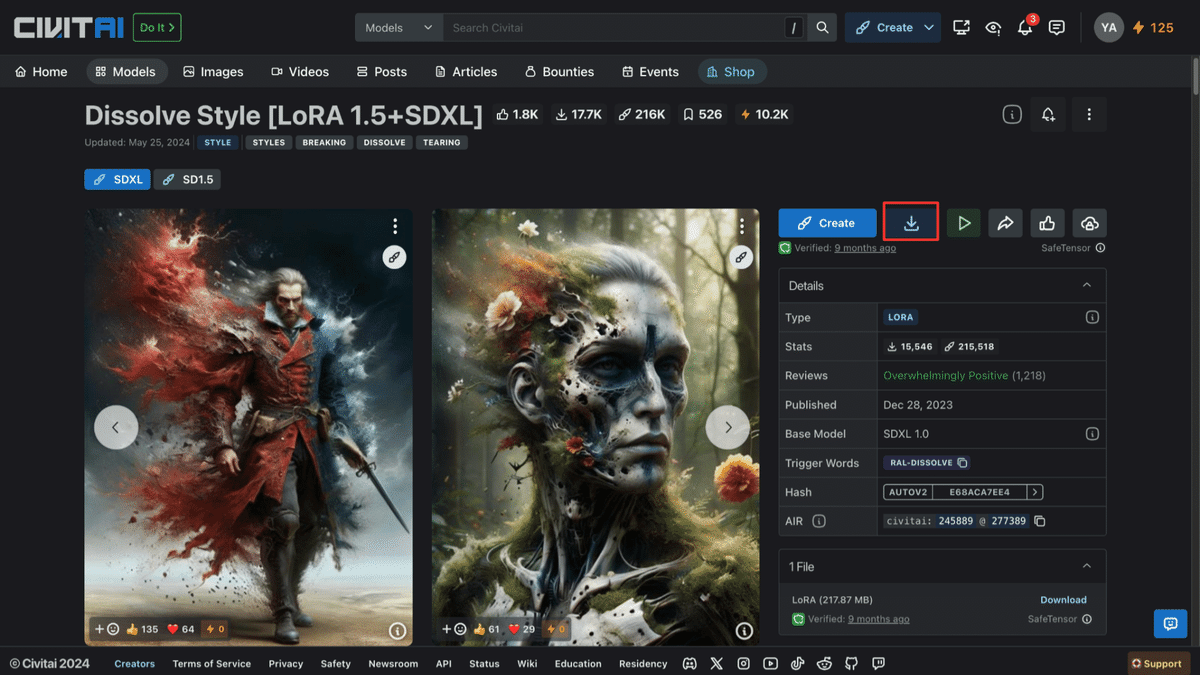

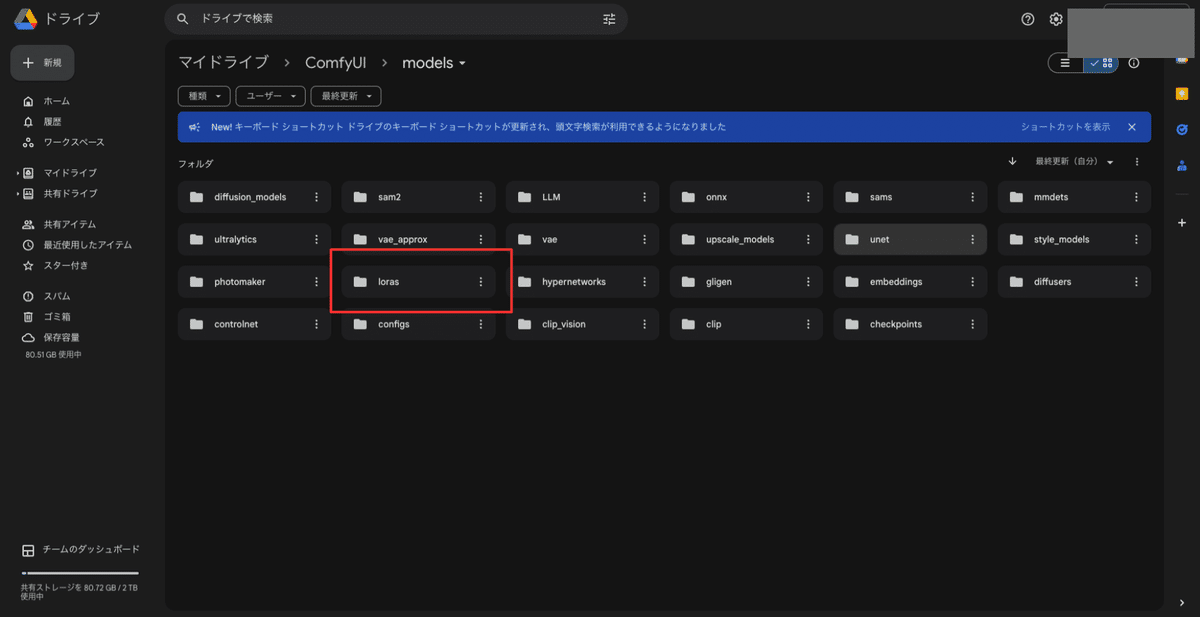

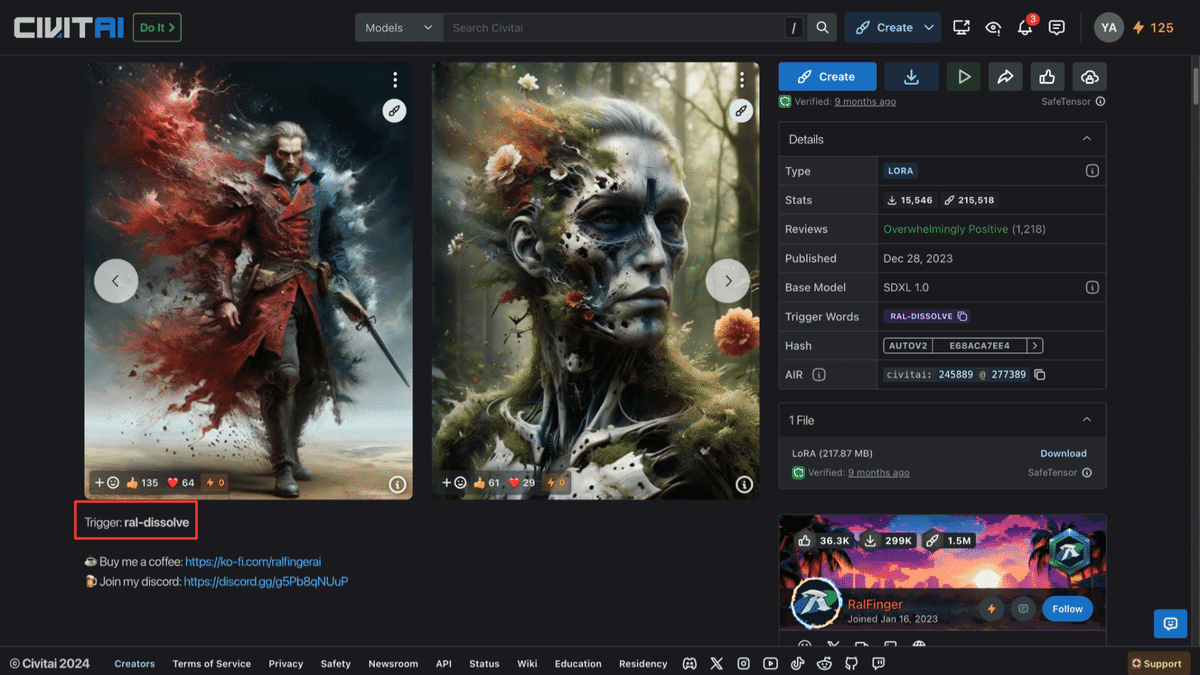

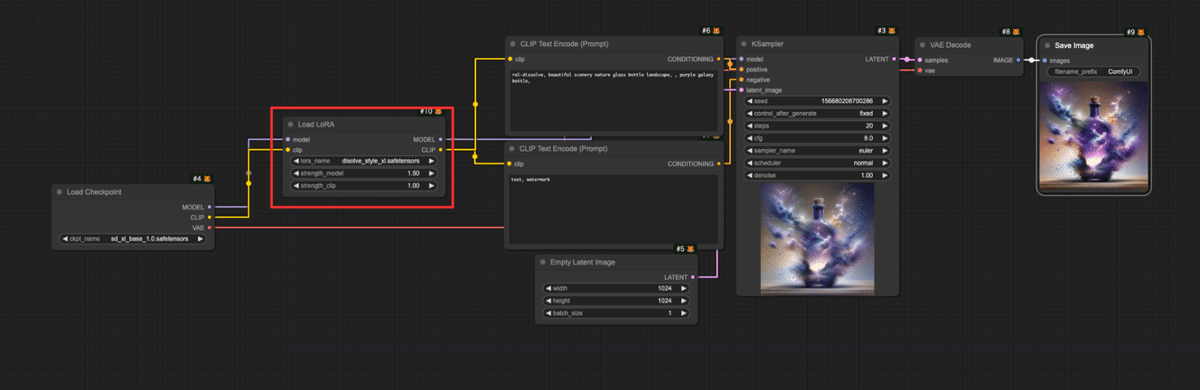

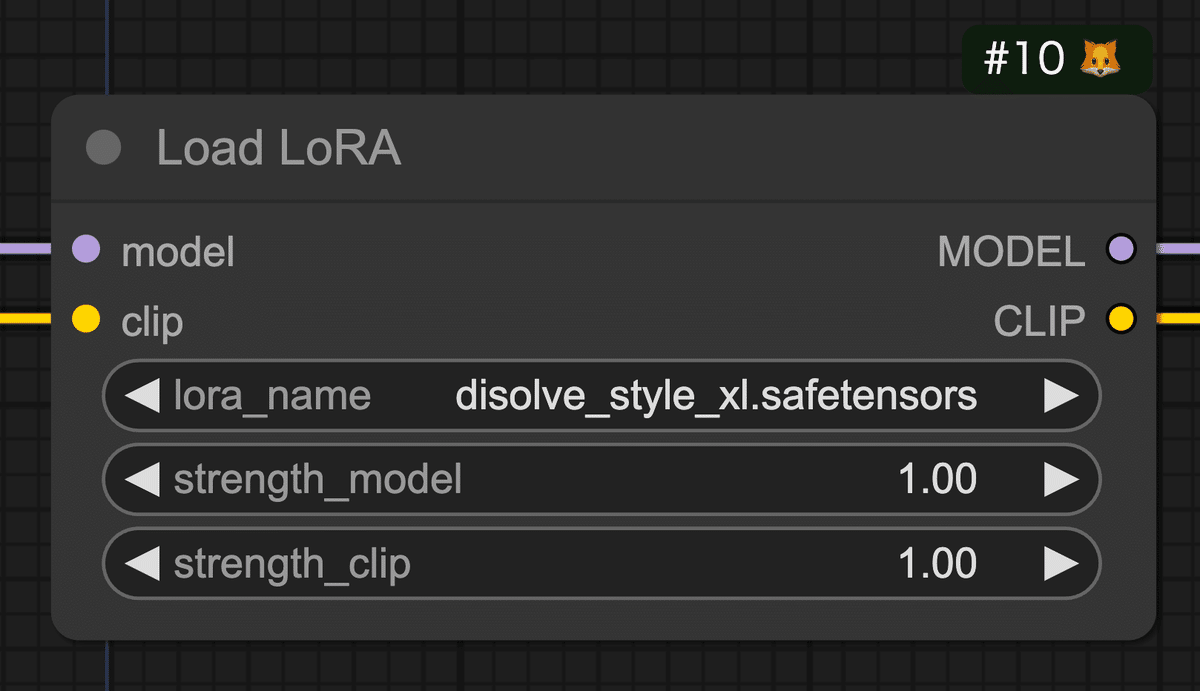

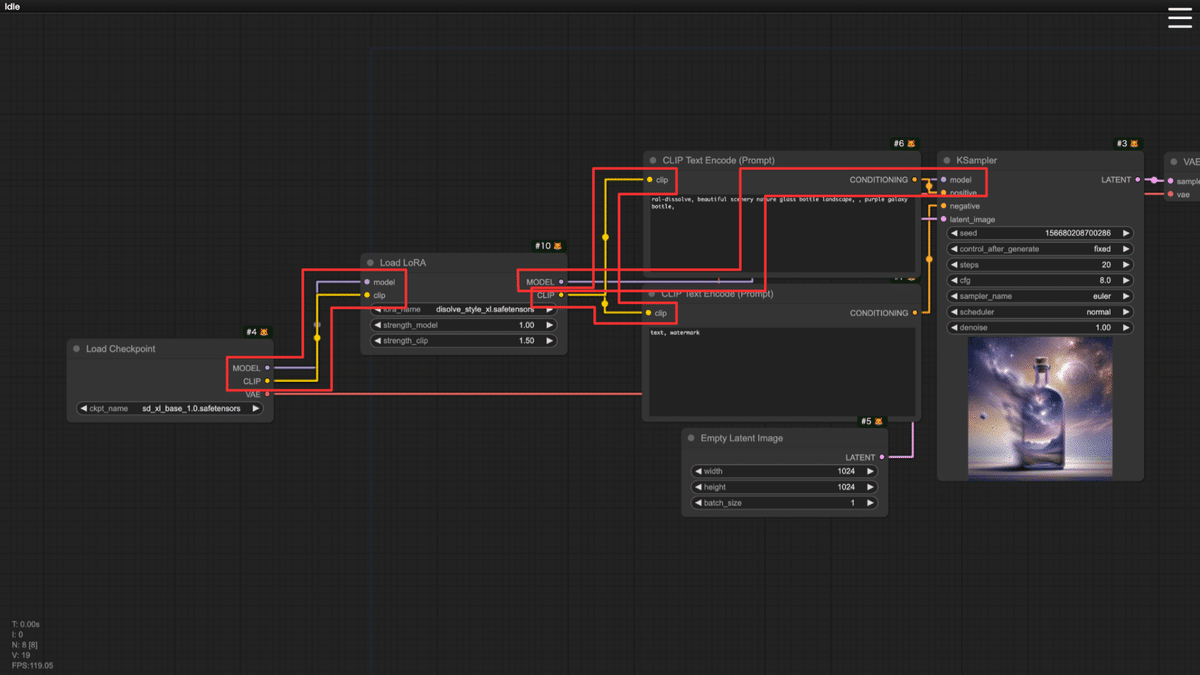

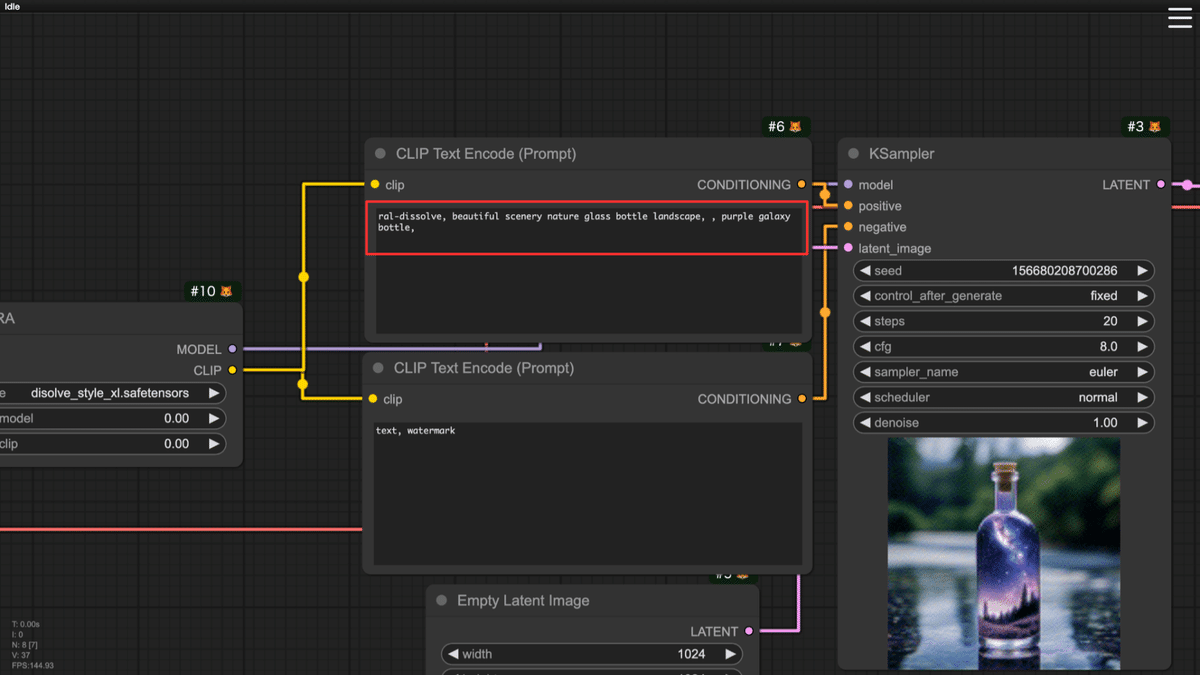

ComfyUIが即日対応

そしてまさかのComfyUIがリリース即日対応を発表しました。

まさかこんなことが起こるなんて!Stable Diffusion 3.5がリリースされました!Stable Diffusion 3.5モデルシリーズの初日サポート開始をお知らせできることを嬉しく思います!SD3.5の使用を開始するには、当社のブログをフォローするか、ベータ版の「missing model」機能を使用してモデルをダウンロードしてください。スキルは必要ありません!

https://x.com/ComfyUI/status/1848728525488197963

昨日リリースされた内容はこちらです。

missing model機能について、チェックしていかねばですね!

いますぐ触りたいアナタに!

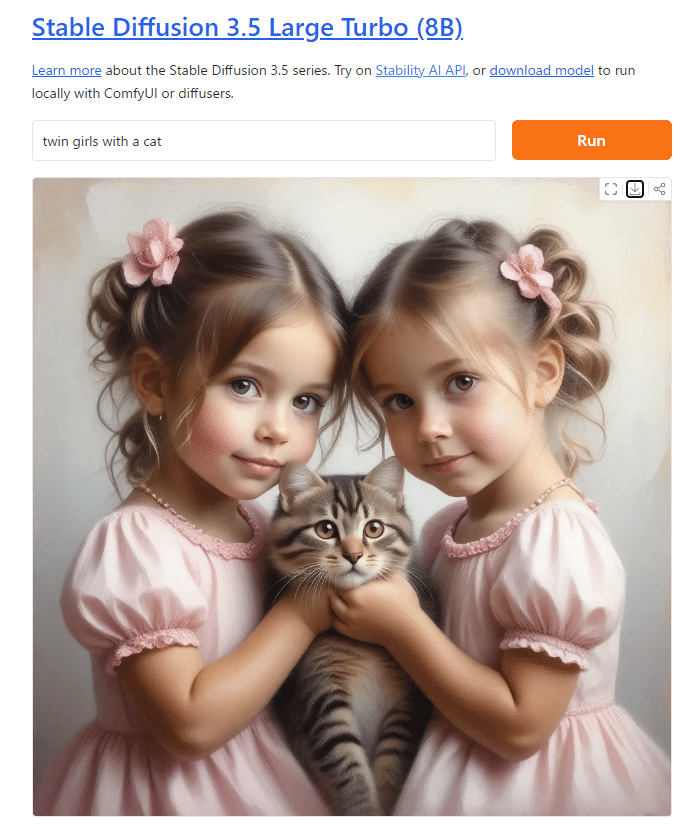

HuggingFace Spacesにて試用環境が公開されています

Stable Diffusion 3.5 Large (8B)

https://huggingface.co/spaces/stabilityai/stable-diffusion-3.5-large

公開直後のため、流石に混雑しているようです。同時に公開されたTurboのほうが使えそうです。

Stable Diffusion 3.5 Large Turbo (8B)

https://huggingface.co/spaces/stabilityai/stable-diffusion-3.5-large-turbo

文字表現についても機能は維持されているようです。

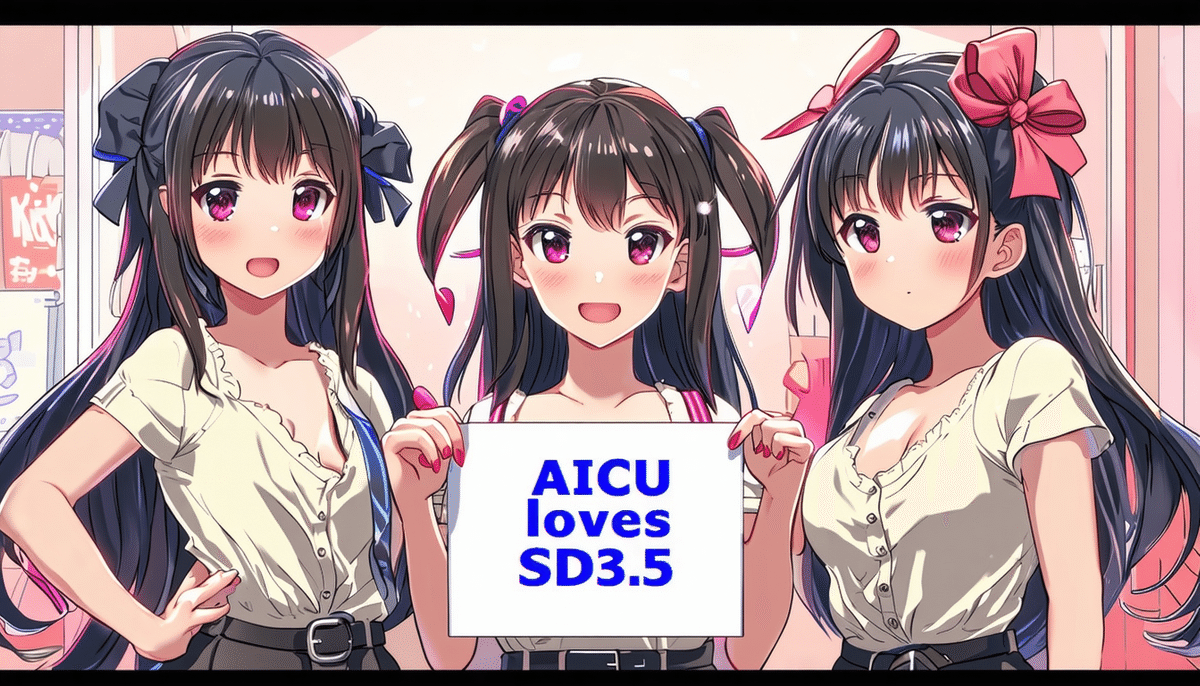

「gemini boys with a panel written “AICU”」

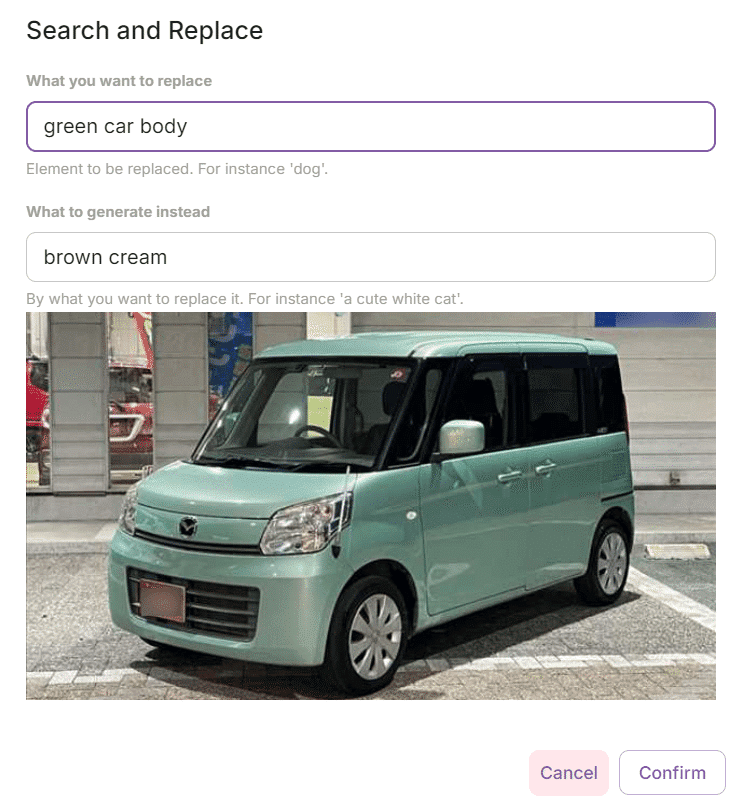

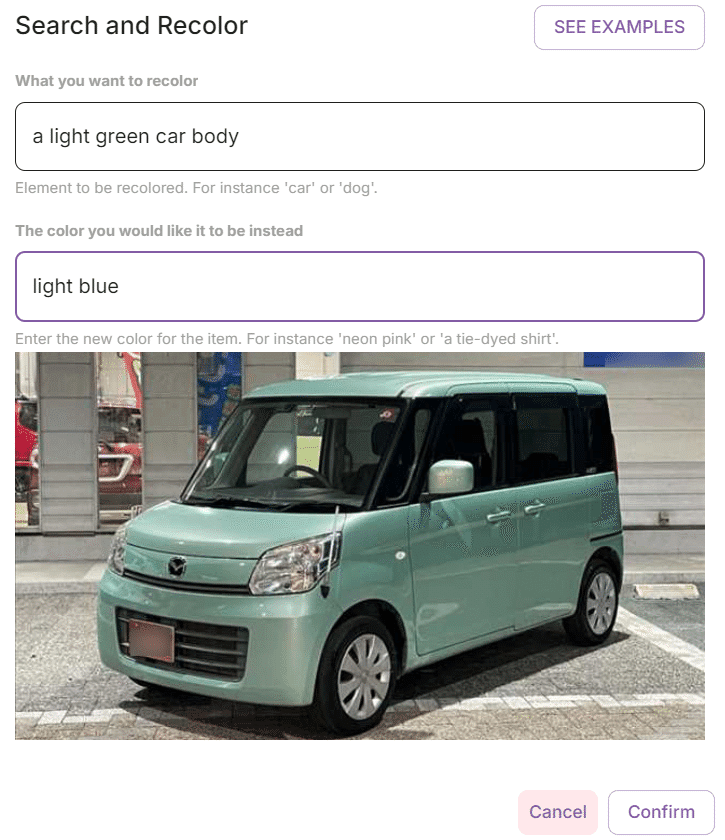

公式APIでの「Stable Diffusion 3.5 Large」

Stability AI 公式APIマニュアルによると、既にGenerate APIとして提供が始まっています。APIキーを取得し、Open Google Colabにアクセスしてください。

[AICU版] Stability AI APIガイド

https://note.com/aicu/n/n4eda1d7ffcdf

デフォルトの解像度は1Mピクセル、1024×1024です。

modelパラメータのデフォルトが「sd3.5-large」になりました。

{sd3-large, sd3-large-turbo, sd3-medium, sd3.5-large, sd3.5-large-turbo}

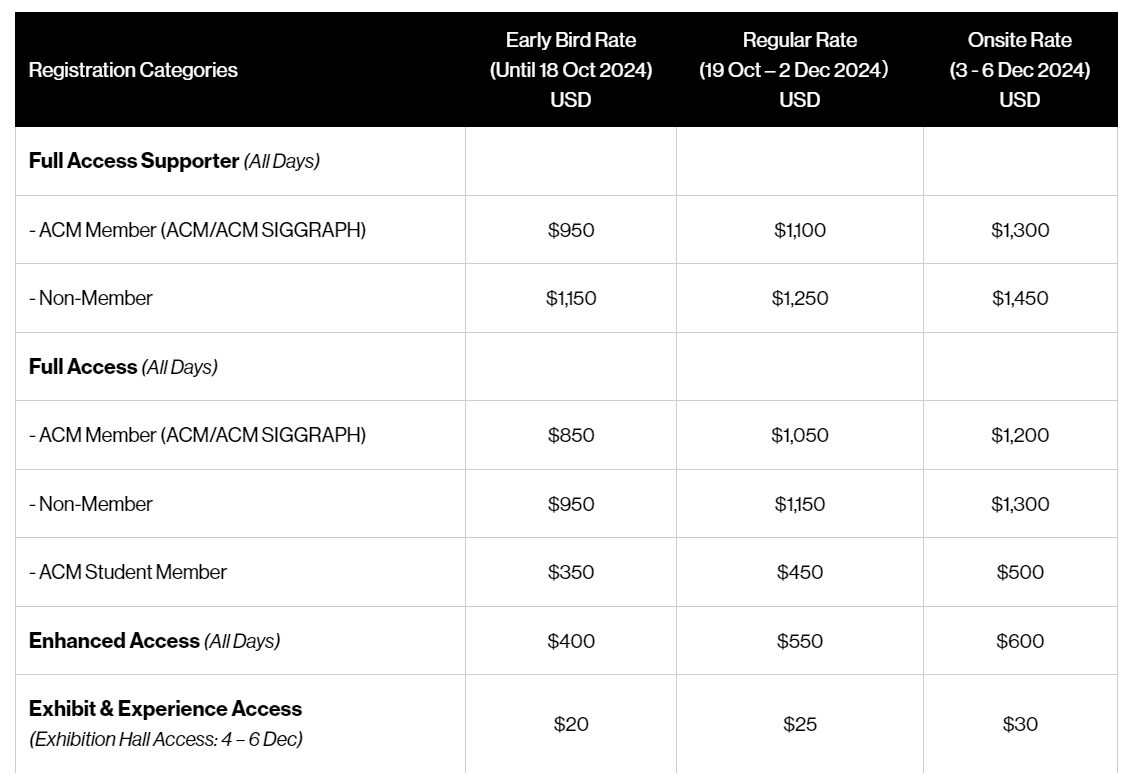

クレジット消費は「生成成功につき」以下のとおりです。

・SD3.5 & 3.0 Largeは一律6.5クレジット

・SD3.5 & 3.0 Large Turbo:一律 4クレジット

・SD3 Medium:一律3.5クレジット。

失敗した生成については請求されません。

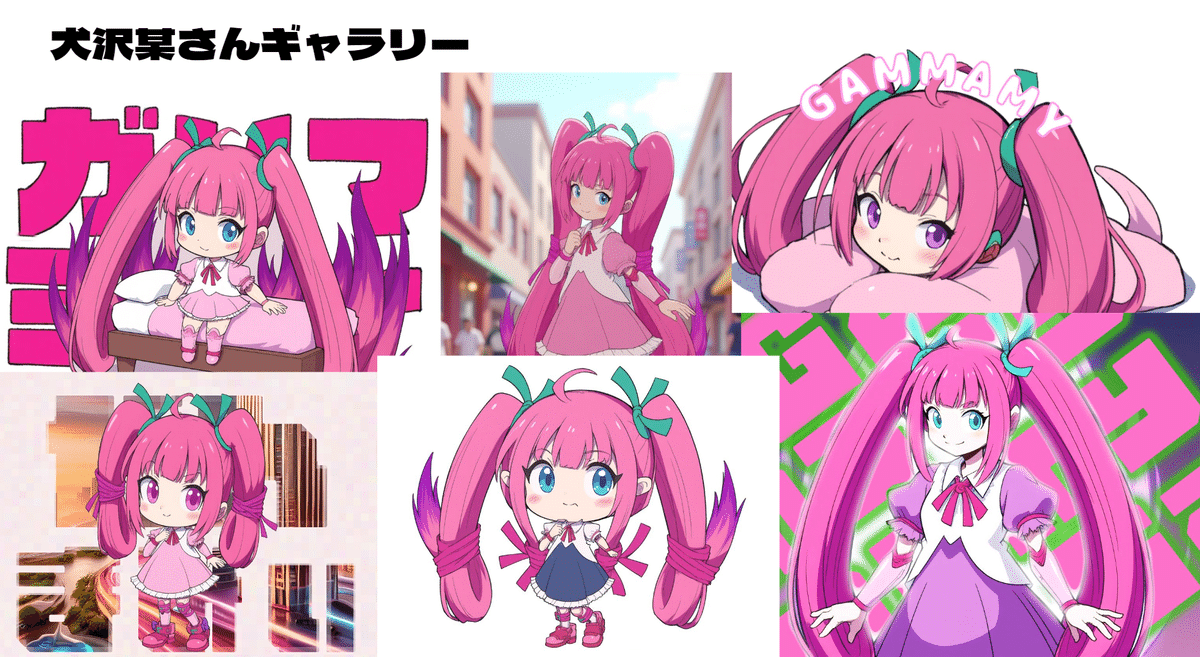

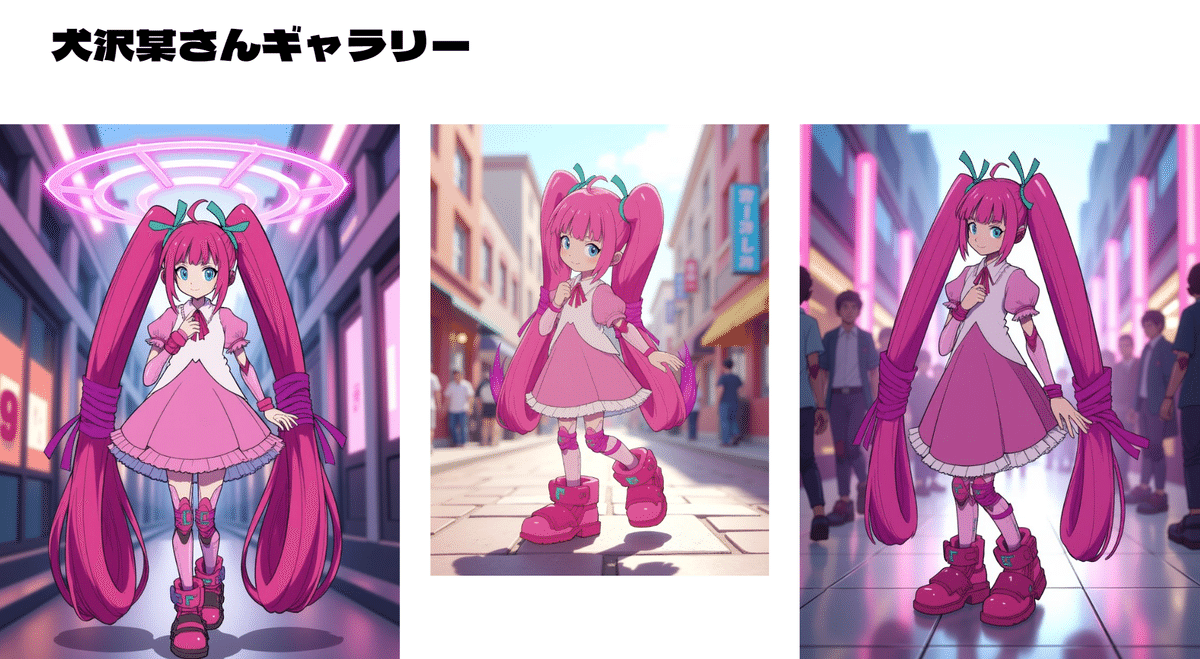

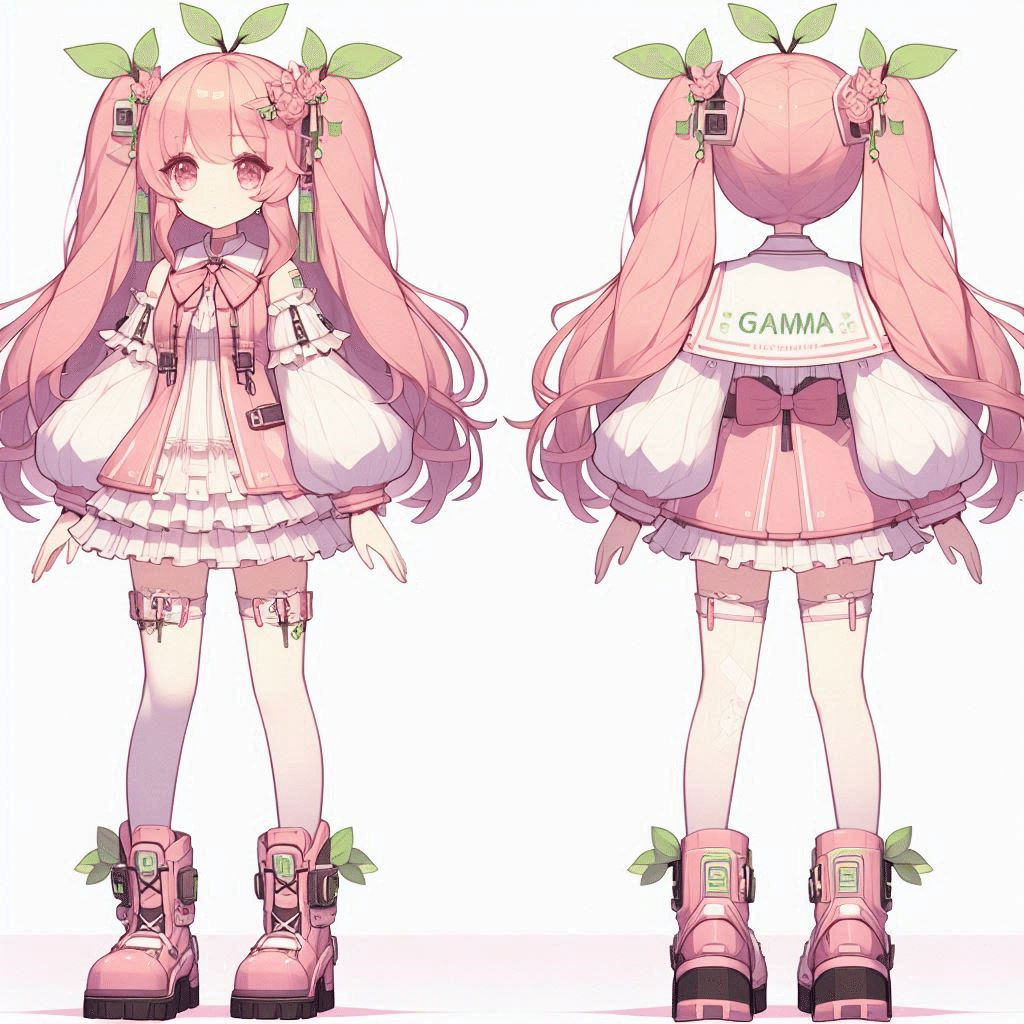

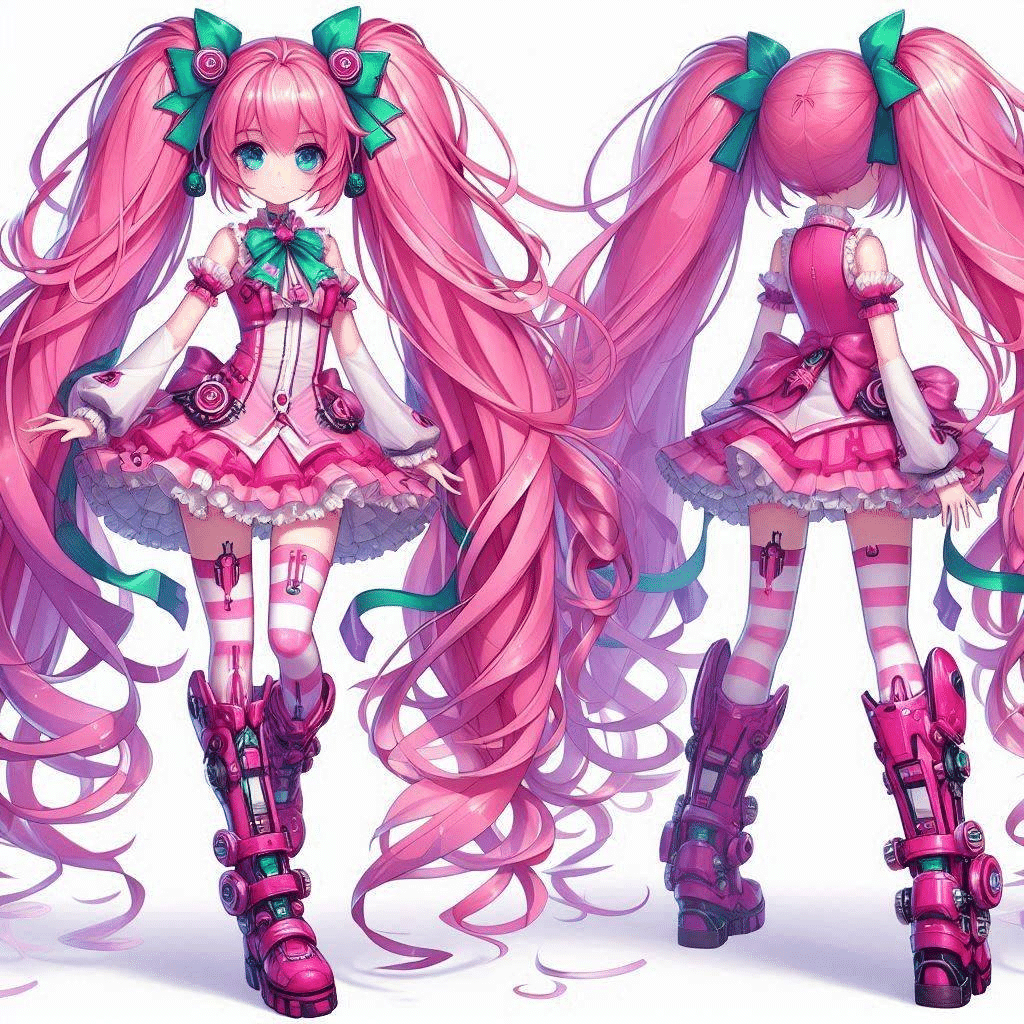

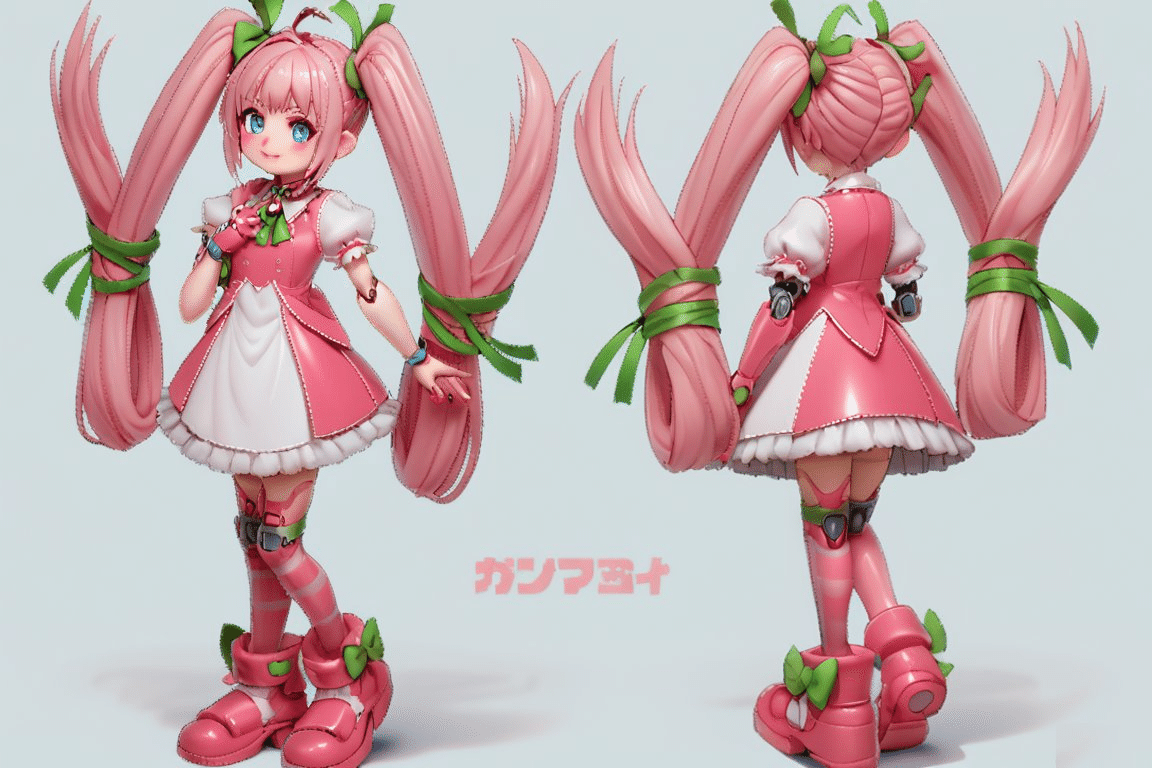

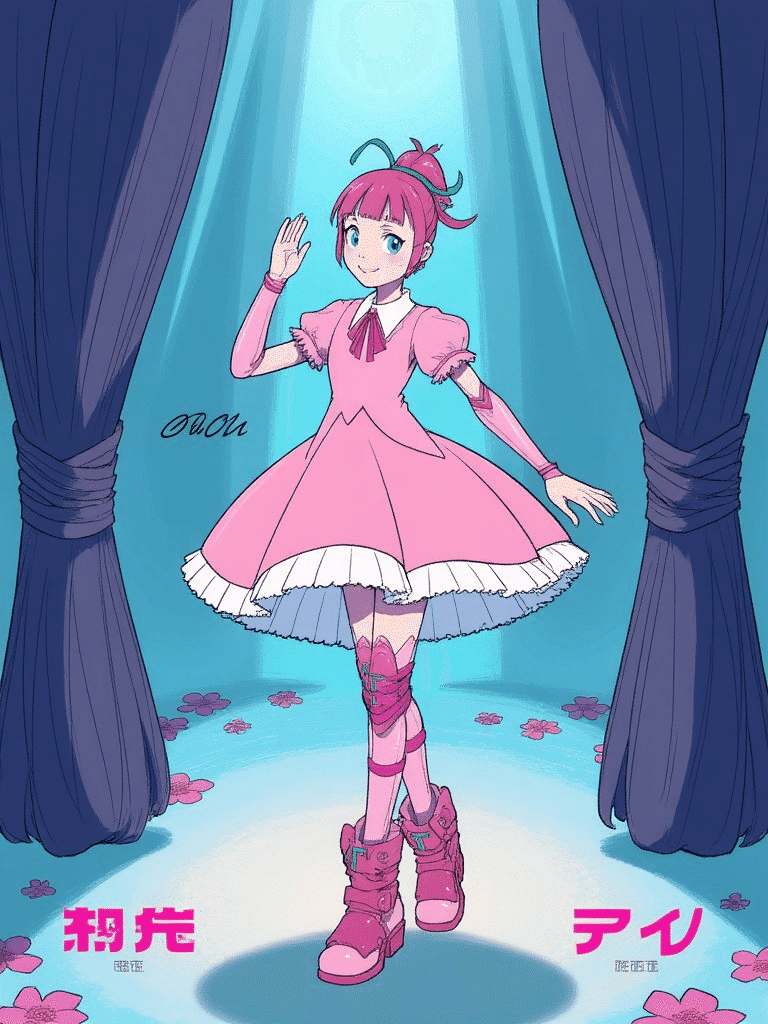

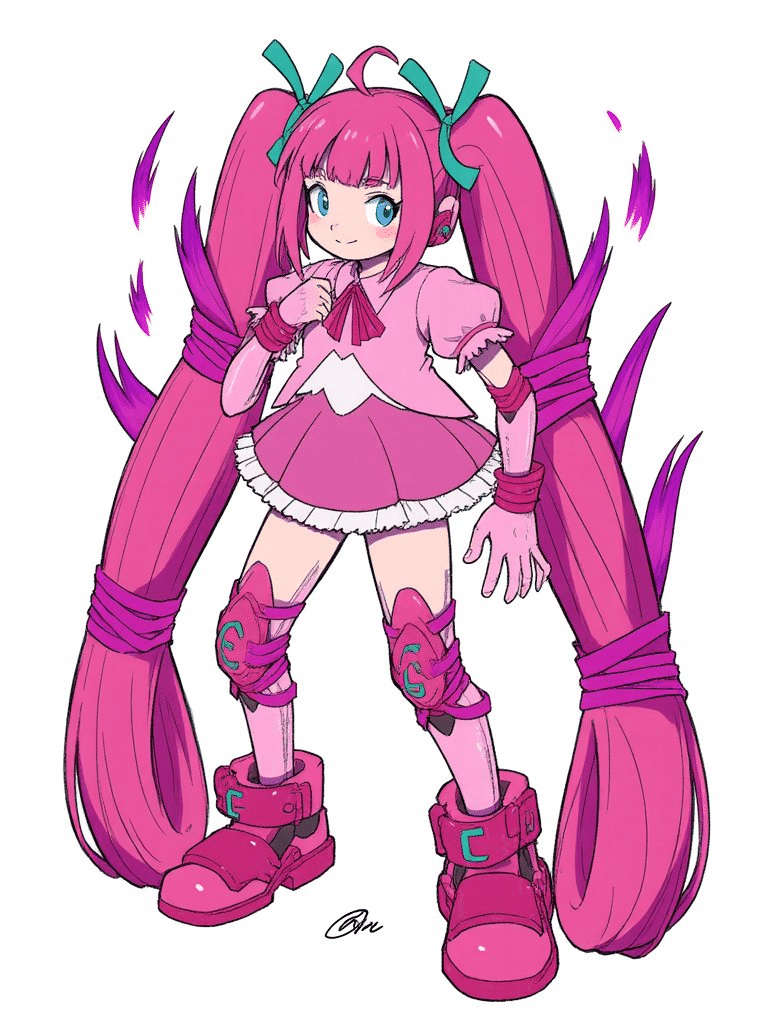

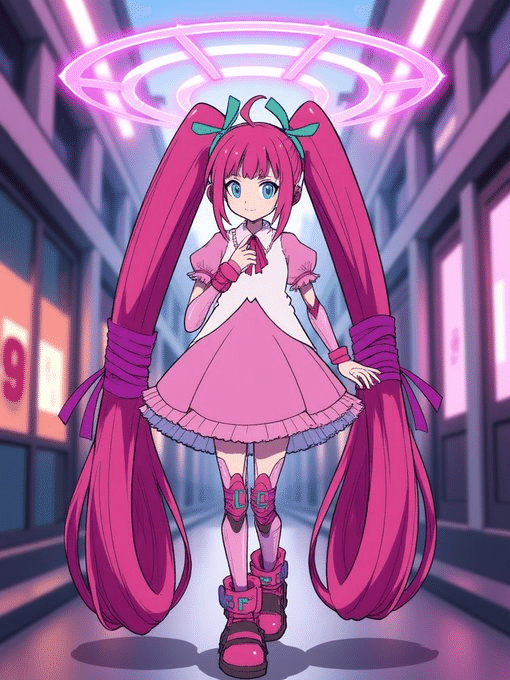

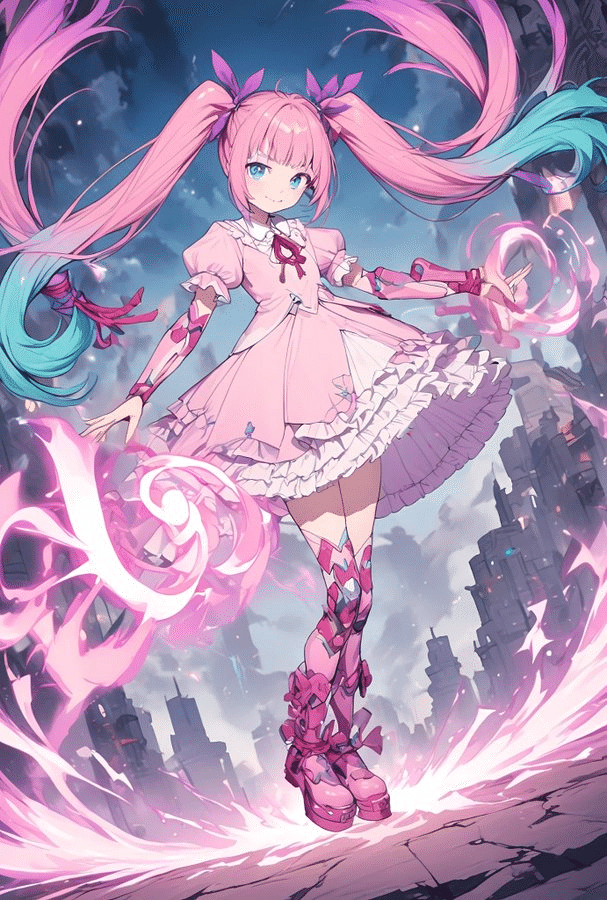

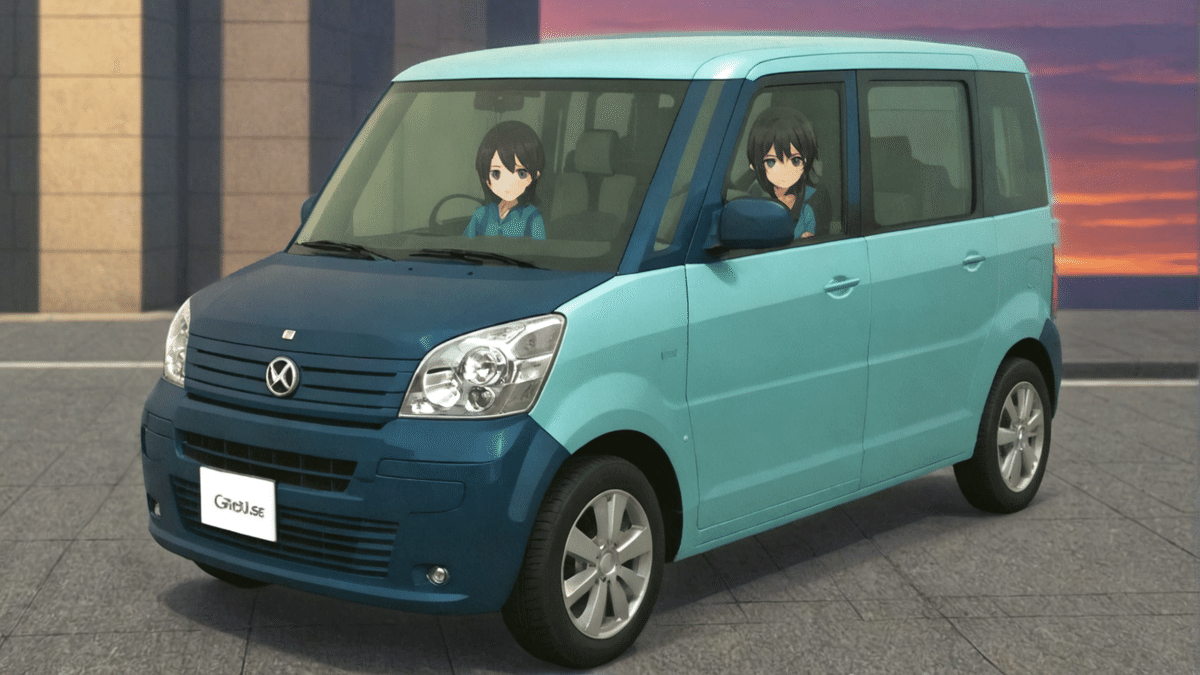

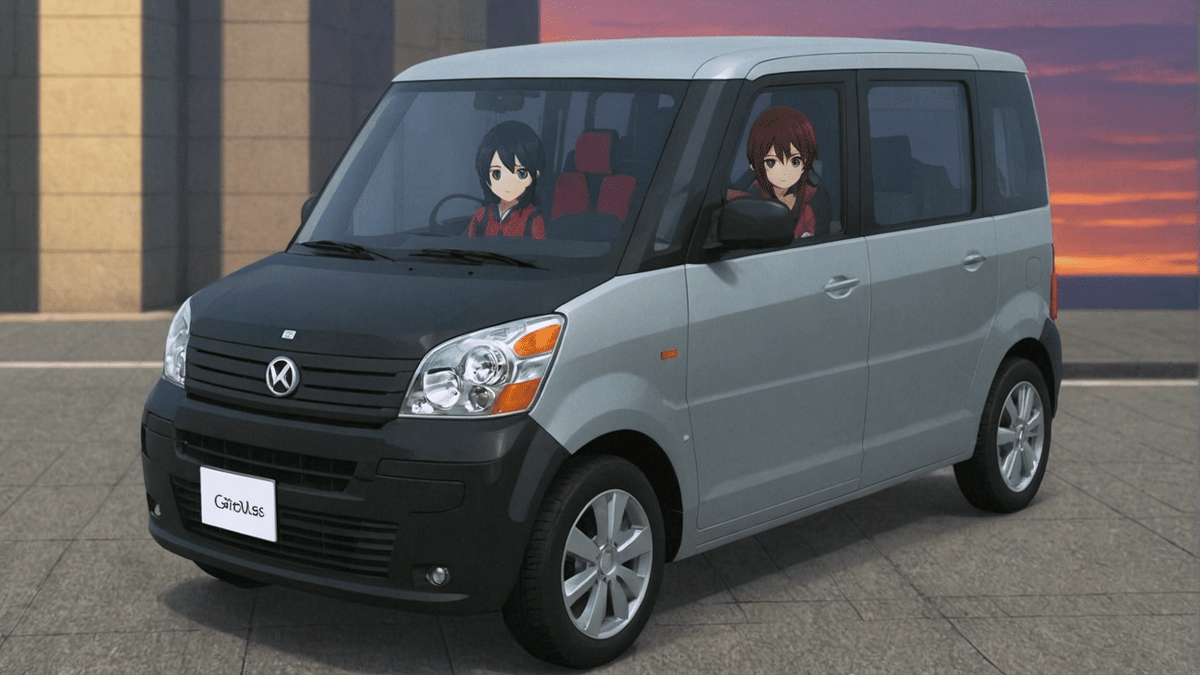

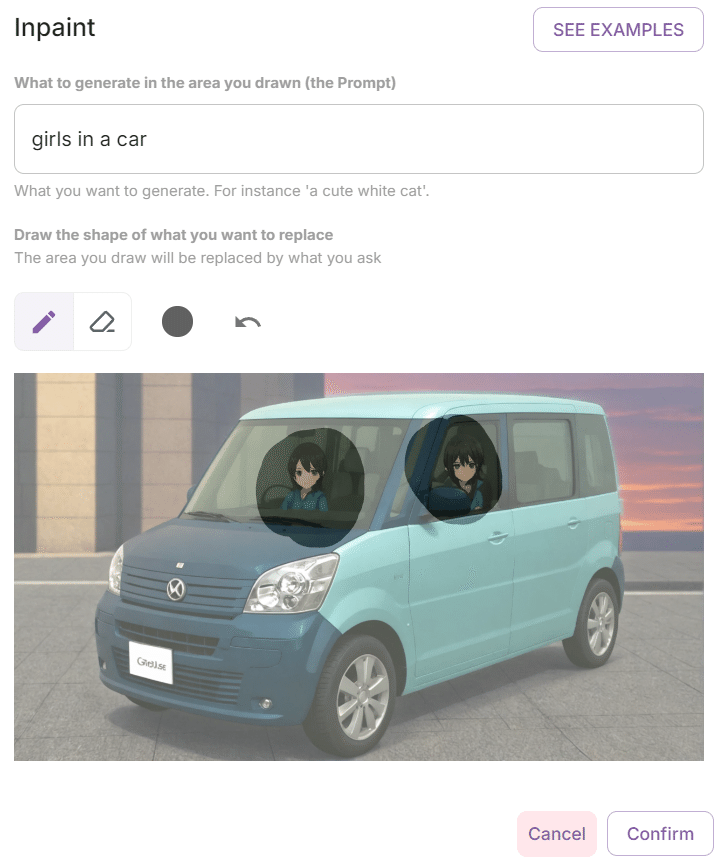

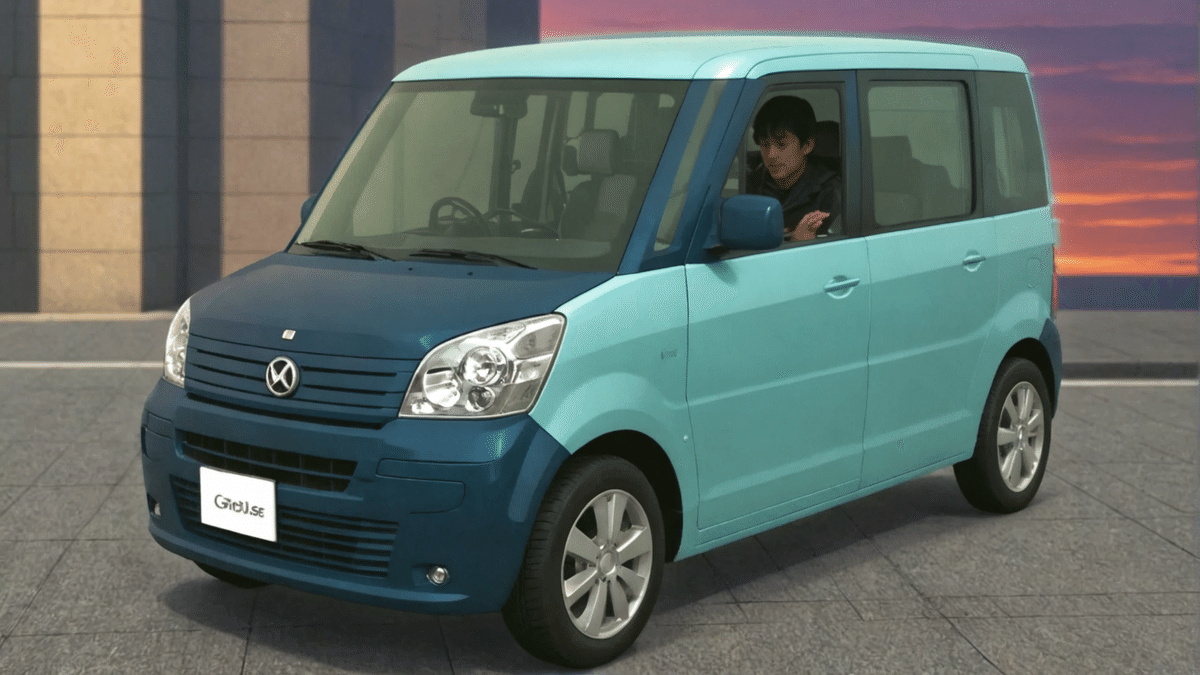

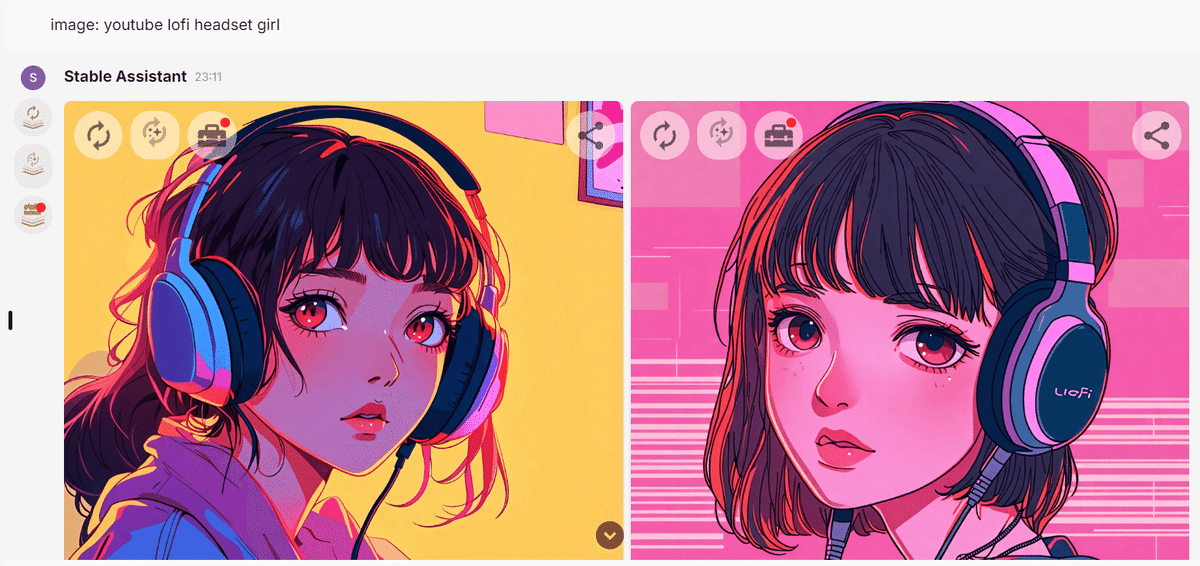

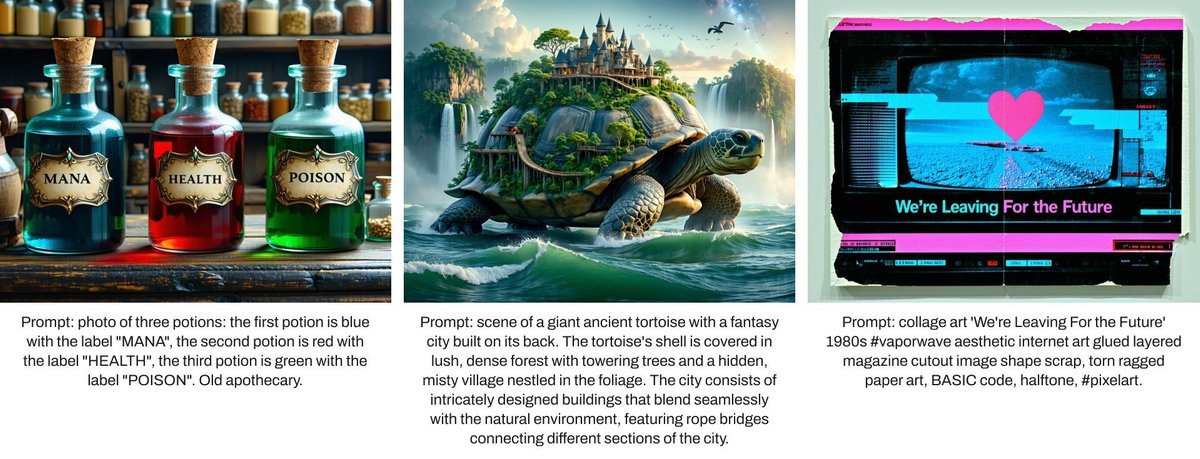

AICUによるSD3.5ギャラリー

SD3.5にて生成

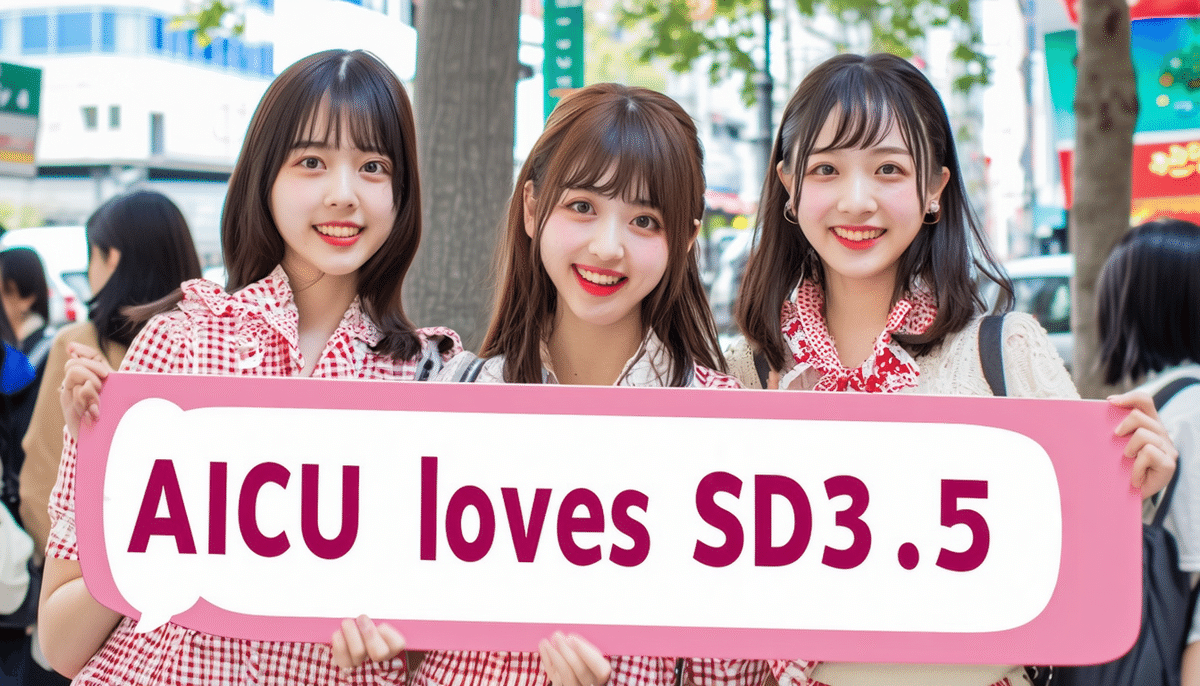

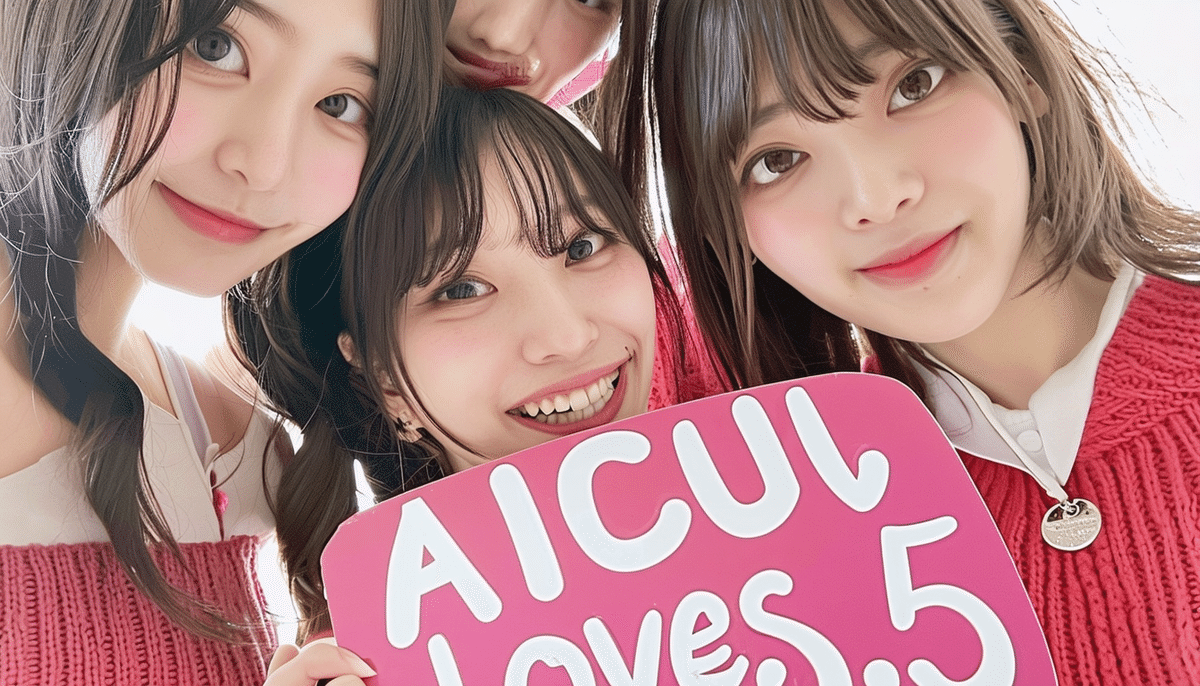

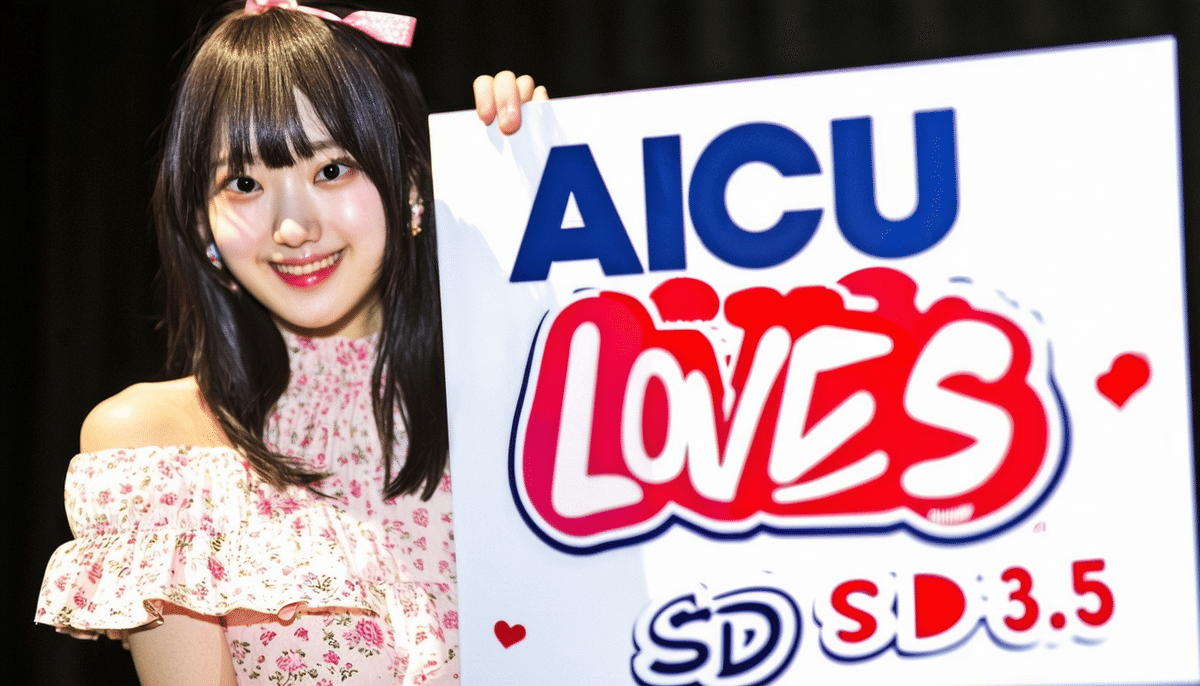

「gemini girls with a panel which written “AICU”」

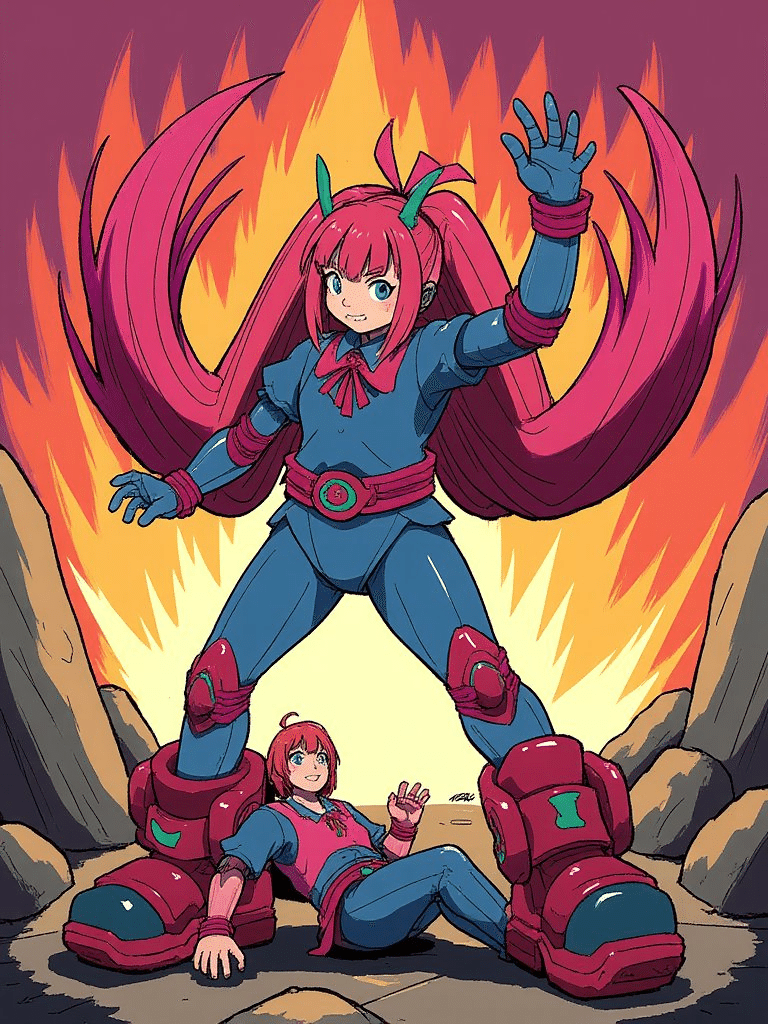

SD3.5 Turboにて生成

「textured palette knife oil painting of a cat riding a surfboard on the beach waves in summer. the cat has a mouse friend who is also riding the surfboard」

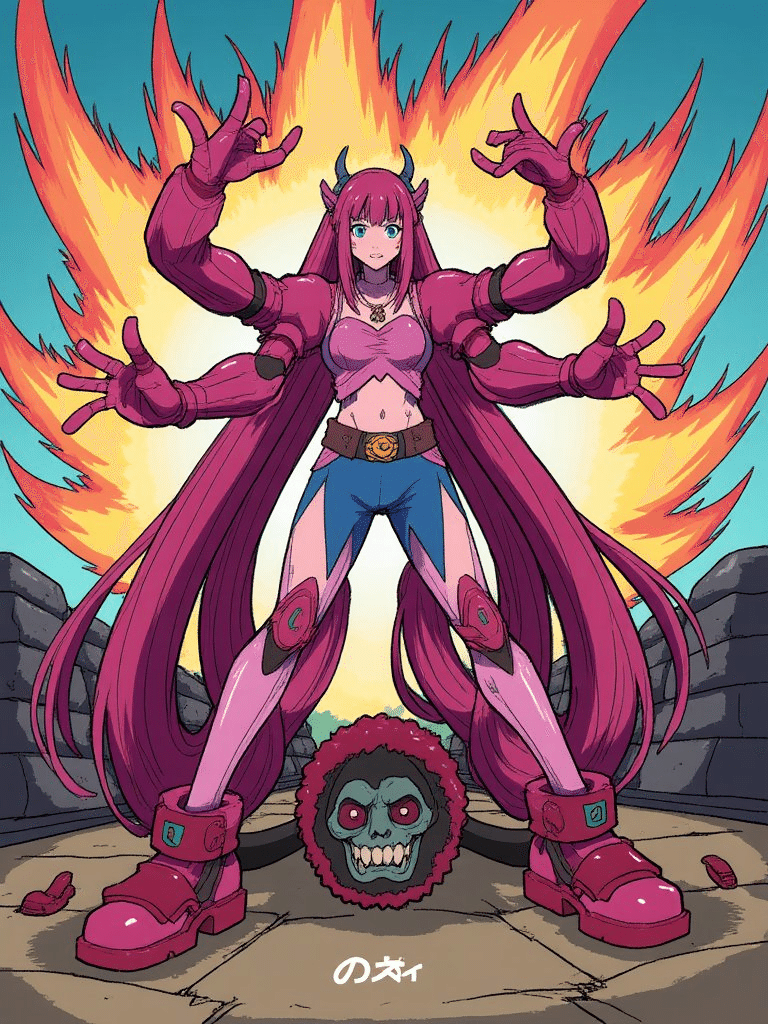

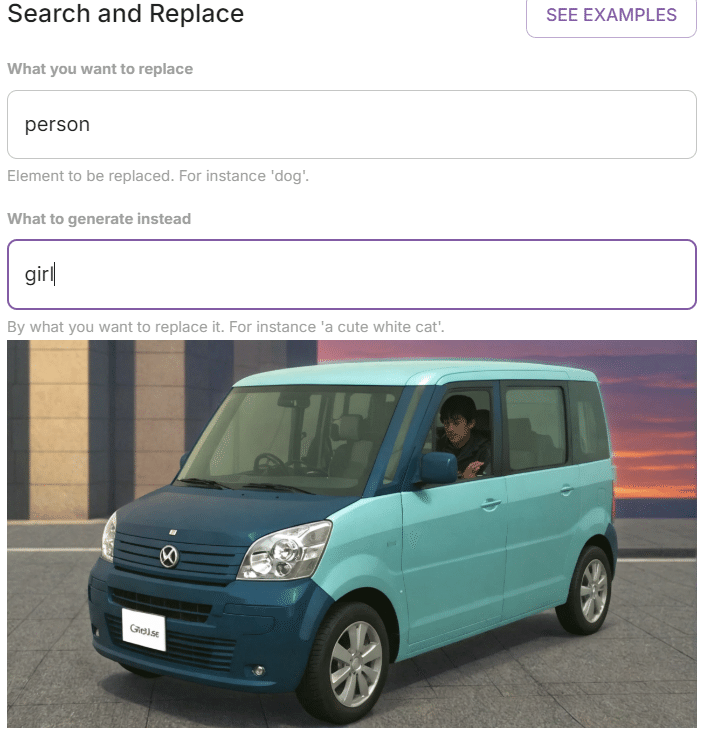

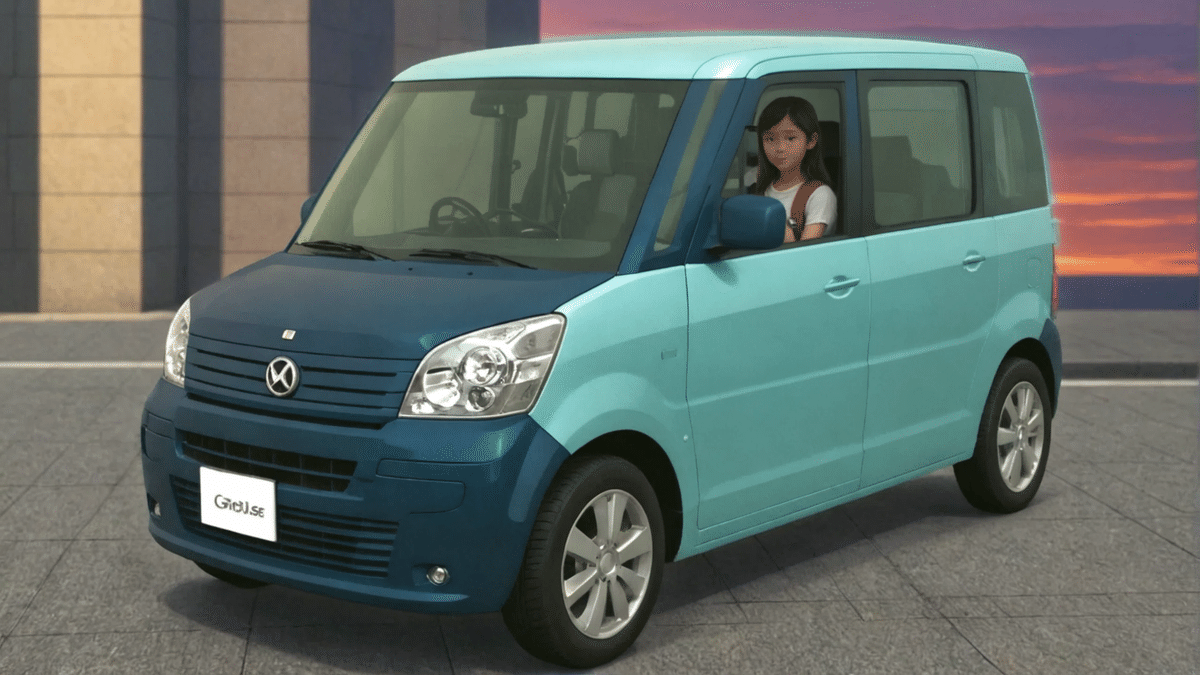

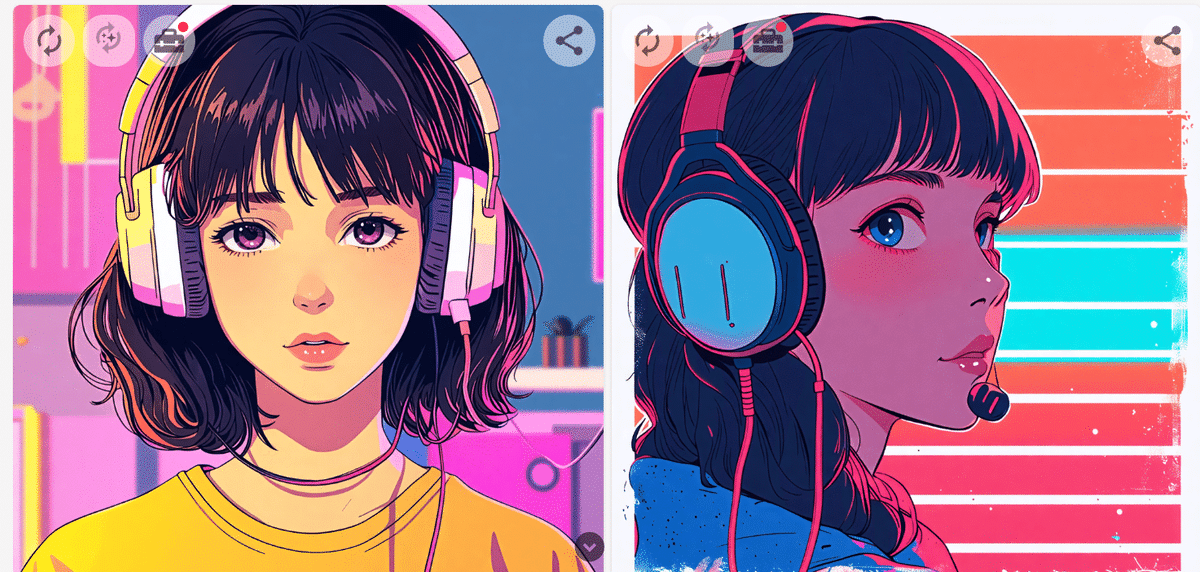

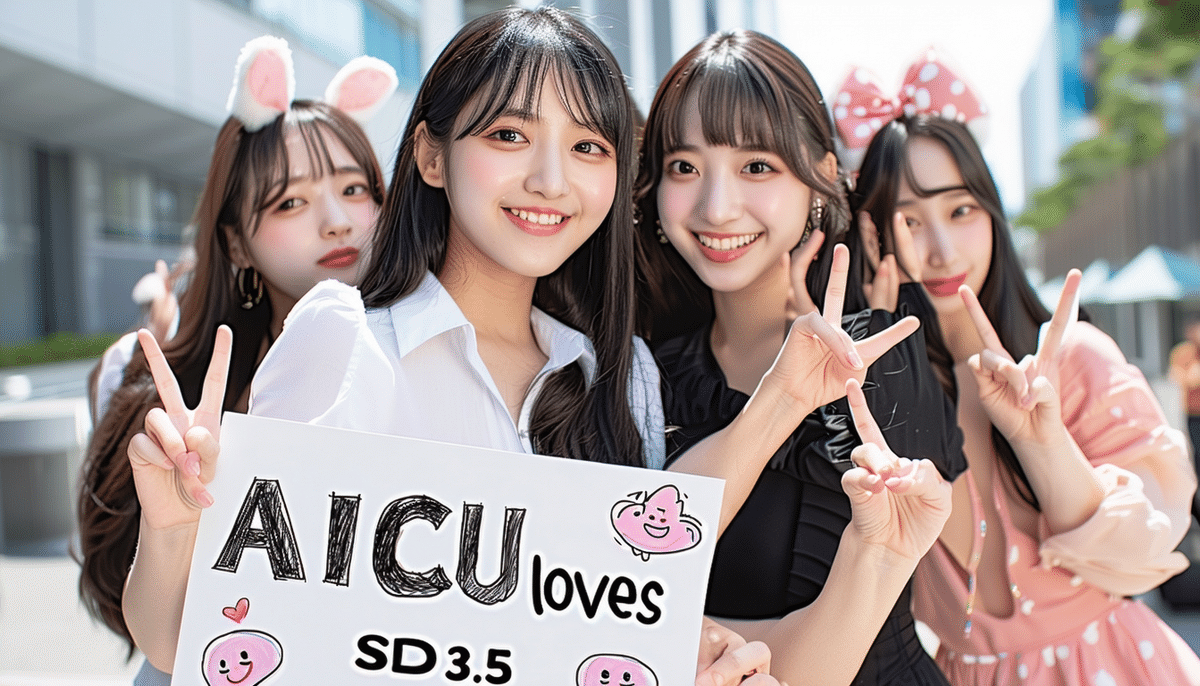

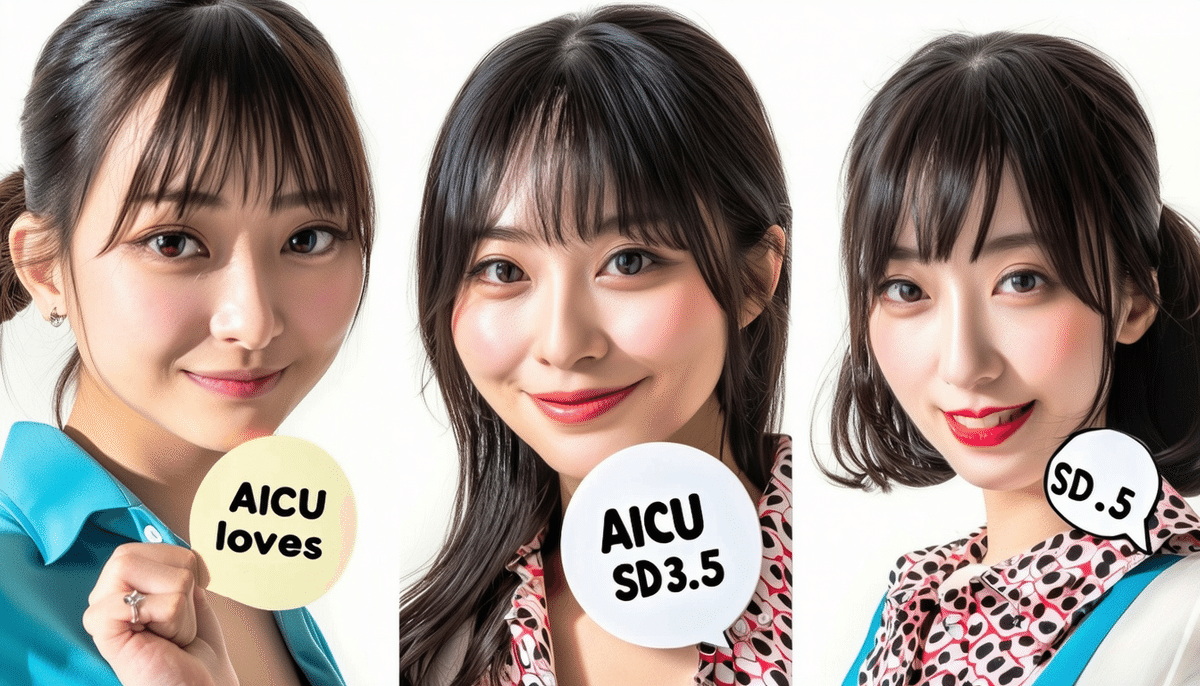

良いものだけ紹介するのではなく、

文字の描画を含めた連続生成の歩留まり率を表現してみます。

「cinematic film still, action photo of a cat with “AICU loves SD3.5”, riding a skateboard through the leaves in autumn. the cat has a mouse friend resting on their head」

SD3.5・同一プロンプト、Seed=0にて実験

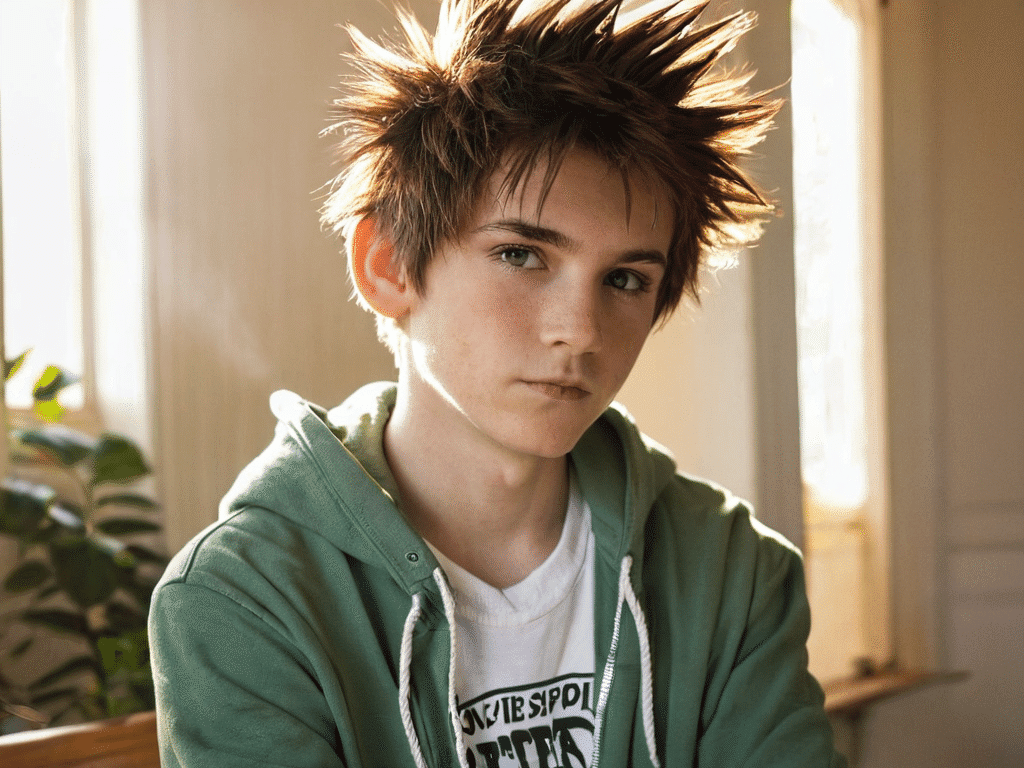

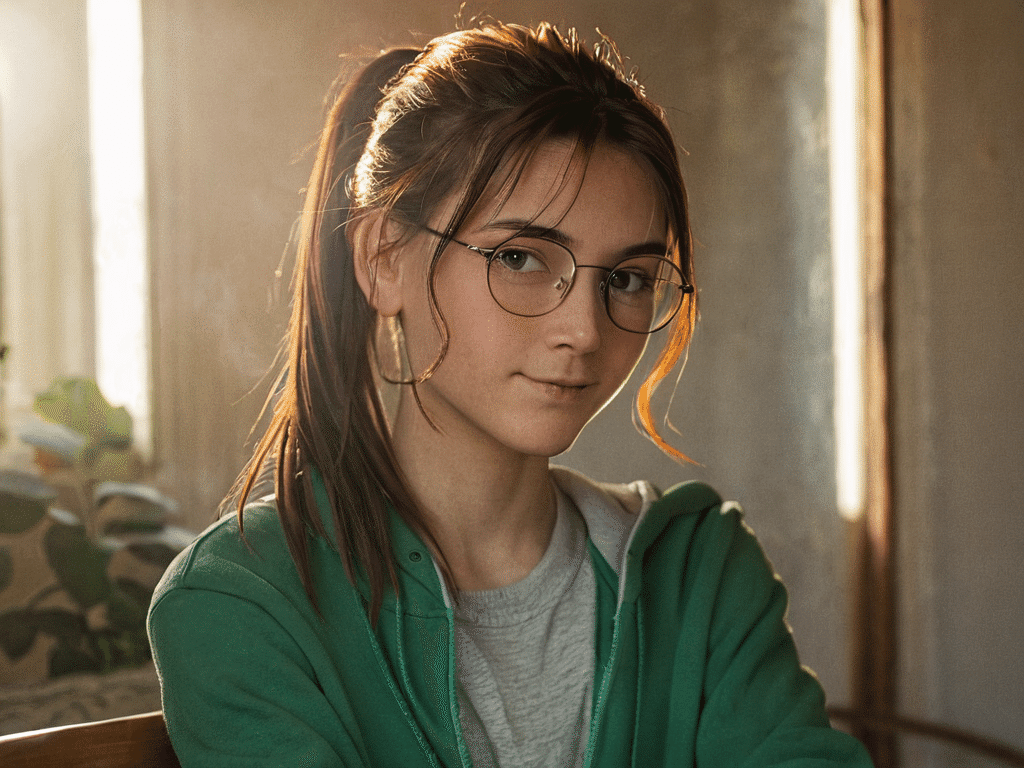

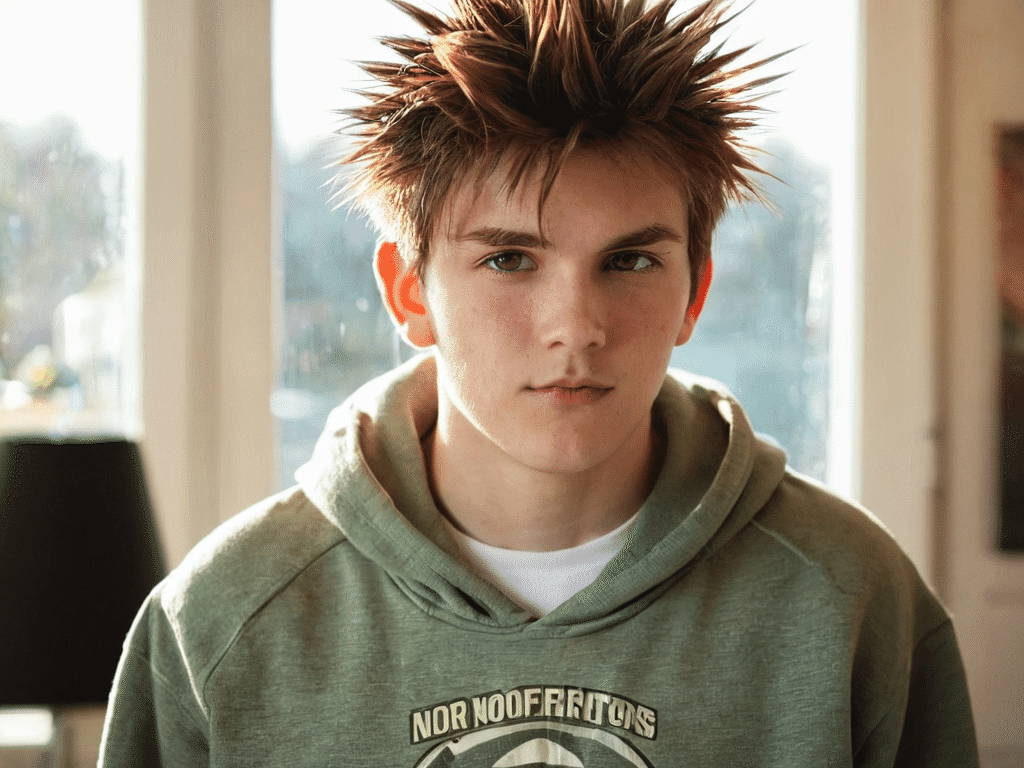

「Japanese girls with a panel which is written “AICU loves SD3.5″」

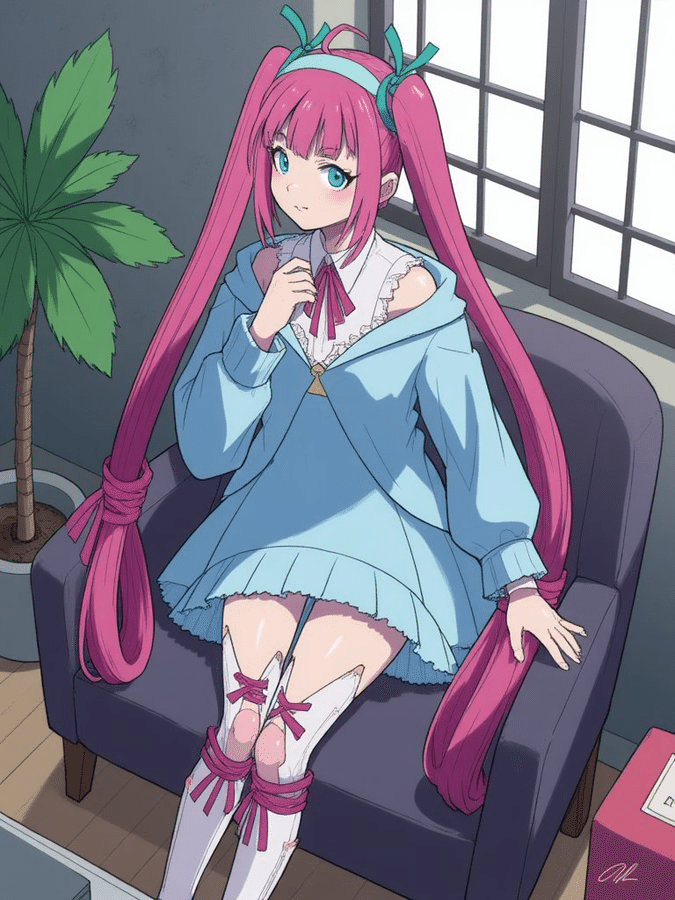

実写系日本人の表現については、結構特徴掴んでいる感じがします。

指の再現率については工夫が必要そうです。

ネガティブプロンプトの効果を確認します。

「bad finger, nsfw, ugly, normal quality, bad quality」を入れることで歩留まり率が上がりました。

さいごに、ComfyUIのブログにあったプロンプトを紹介します。

Prompt: A photorealistic 4K image of a woman with transparent, crystal-like skin, glowing from within with a soft golden light.

NP:bad finger, nsfw, ugly, normal quality, bad quality

AICU編集部のレビュー

電撃リリースとなったStable Diffusion 3.5です。

即日対応を実現したComfyUI、そして商用で試用する上で、APIとしての互換性は高く保たれているようなので安心しました。初期レビューとして少し触ってみた範囲ですが、人種の多様性、特に日本人の描写について多様性と表現力があることを確認しました。

モデルの特性としての「カスタマイズ性」はどのようなところで発揮されるのか、ファインチューニング関係がComfyUIで登場することを期待します。また既存APIでのモデル間比較やEdit API、Style APIとの関係、そして10月29日に予定されているSD3.5Mリリース以降の動向も注目したいところです。

【PR】商用でも利用できるStability AI APIを学びたいアナタへ

超入門:Stable Diffusionではじめる画像生成AI

https://j.aicu.ai/AICUXColosoJP

Originally published at https://note.com on Oct 22, 2024.