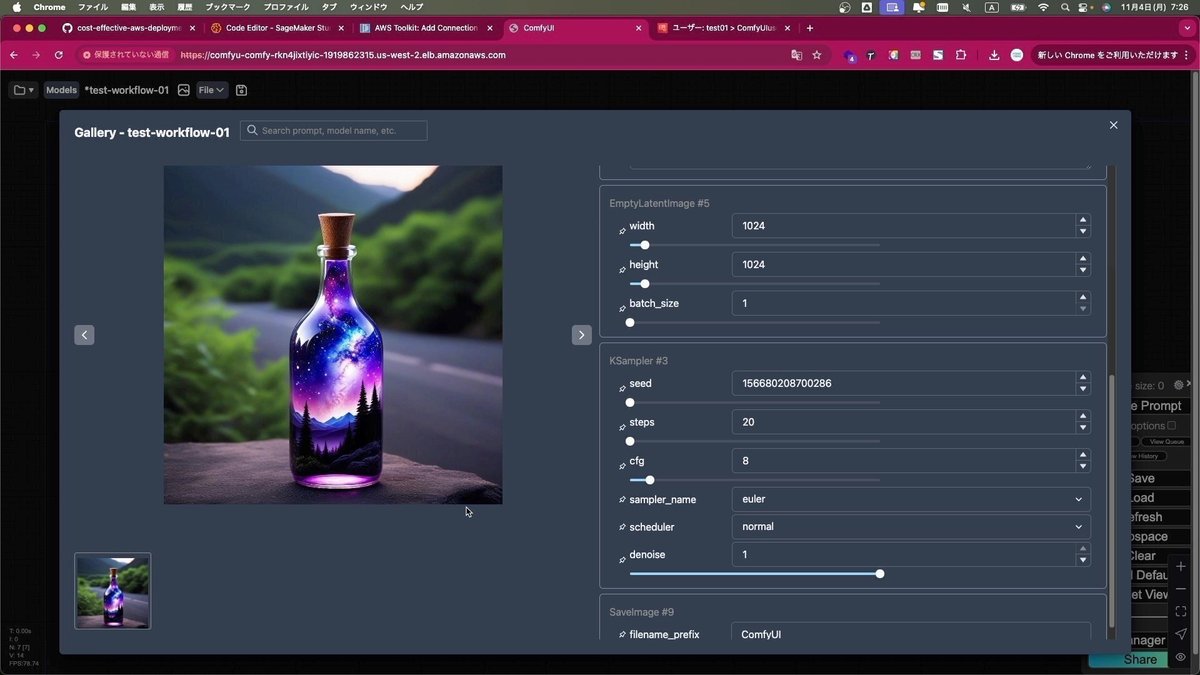

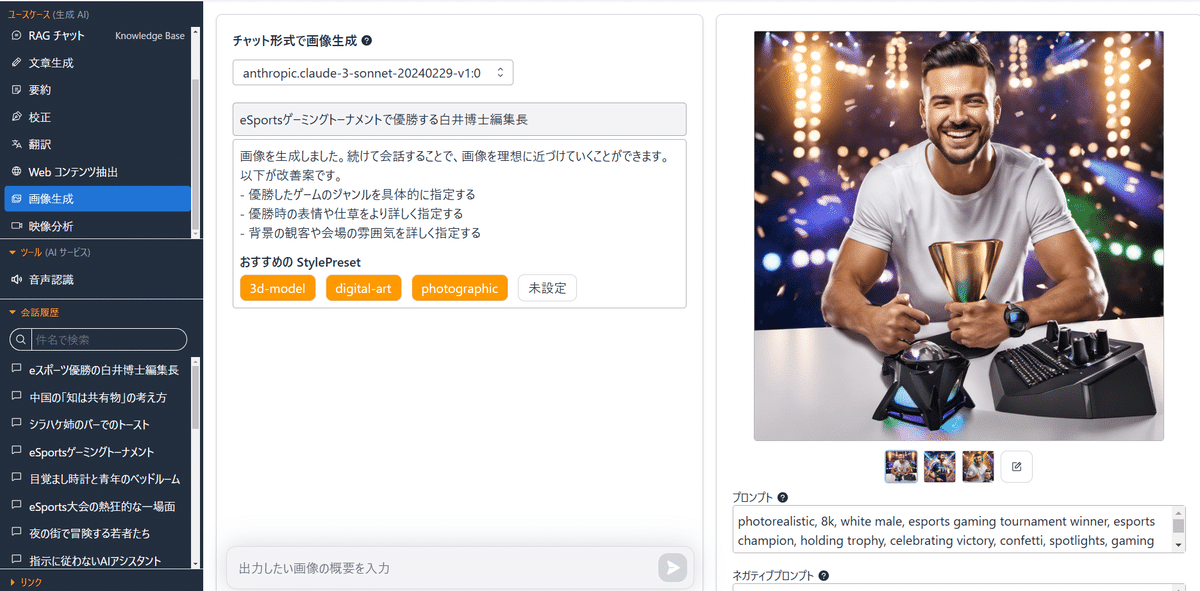

AICU Inc./AICU Japan株式会社 代表 白井暁彦(aka しらいはかせ/AICU編集長/Dr.Hakase:以下「しらいはかせ編集長」)が、AI人工知能EXPO内で開催された「AIアートバトル」チャンピオンシップ決勝に4人のファイナリストとして選出。Stable Diffusion部門で初代優勝を勝ち取りました。

AICU media編集部は、しらいはかせ編集長の個人クリエイターとしての活動は、(業務に支障がない限り)他の所属クリエイター同様、個人活動として平らに尊重して扱っております。改めておめでとうございます。

本稿では開催概要にあわせて、決勝での作品について紹介し、AICUがこれまで開発に関わってきた技術とともに公開解説いたします。

AIBATO (AIアートバトル) イベント概要

https://prtimes.jp/main/html/rd/p/000000006.000147393.html

主催: 株式会社LimerenceAI

イベント名: AIBATO (アイバト) – 国内初*のオフラインAIアートバトル

*注: 国内初の「オフラインAIアートバトル」として (2024年8月時点、株式会社LimerenceAI調べ)

公式サイト: https://aiartbattle.jp/

イベントの目的: クリエイターとAIの融合による新しい芸術表現の開拓、AIクリエイターの発掘・支援。

ポイント:

- 国内初のオフラインで開催されるAIアートバトル。

- MidjourneyとStable Diffusion、それぞれでチャンピオンが決定。

- 著名なクリエイターやAI業界関係者が審査員を務める。

- 予選はポートフォリオ審査、決勝はリアルタイムのバトル形式。

開催日時:

2024年11月21日(木): チャンピオンシップ決勝 (Midjourney使用)

2024年11月22日(金): チャンピオンシップ決勝 (Stable Diffusion使用)

開催場所: 幕張メッセ NexTech Week 2024 (AI・人工知能 EXPO) 内 LimerenceAIブース

審査員:

- 木下健太郎 (THE FIRST TAKE 映像プロデューサー)

- 佐藤カズー (TBWA HAKUHODO CCO)

- 平久江勤 (TBWA HAKUHODO プロデューサー)

- 元木大介 (KandaQuantum 代表取締役社長)

- 本田崇人 (株式会社メロン 共同代表CTO)

- マドカ・ジャスミン (タレント、KandaQuantum CMO)

- Hakushi (ShiftAI AIクリエイティブ講師)

- 他

大会MC: トンピ (eスポーツキャスター)

競技形式

- 予選 (作品選考): ポートフォリオによる審査。MidjourneyとStable Diffusionそれぞれ8名が決勝進出。

- チャンピオンシップ決勝 (リアルイベント): 主催者からのお題に基づき、制限時間内に画像生成。シングルエリミネーション方式。

使用ツール: Midjourney, Stable Diffusion

しらいはかせ本人の個人ブログにて手記が公開されております

準備編

https://note.com/o_ob/n/n3ed4cc5266c1

予習編

https://note.com/o_ob/n/ndf85d8b24d46

実況編

https://note.com/o_ob/n/nf7a760746933

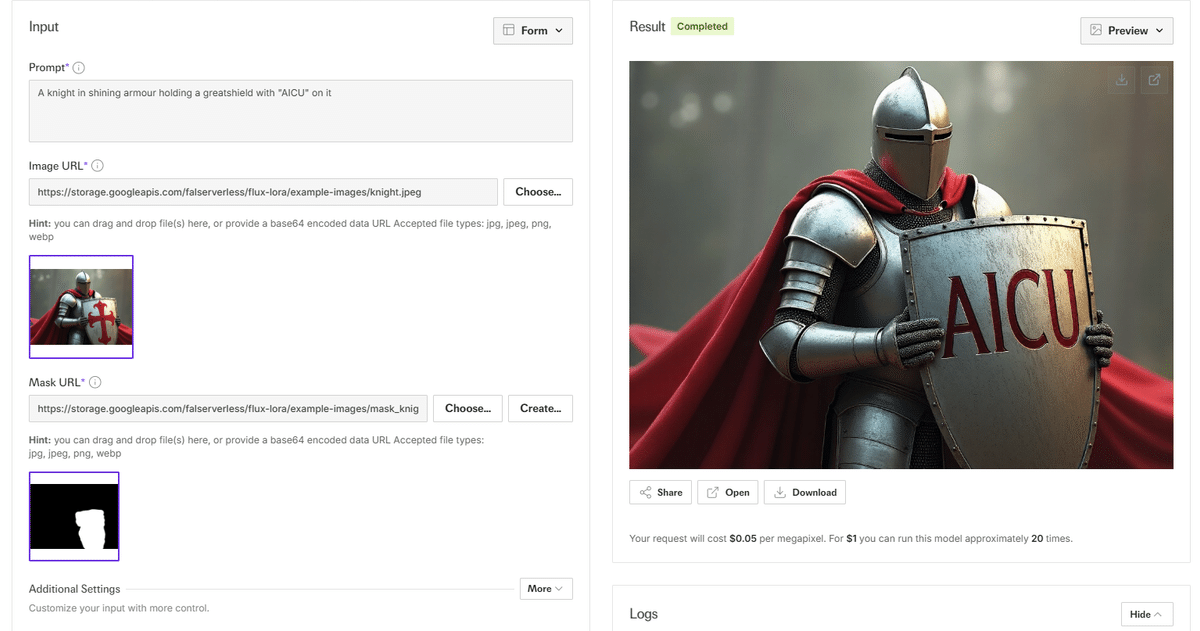

[PR]使用された技術について

使用された画像生成テクノロジーにつきましては大会レギュレーションに基づき、多くはAICUメディア編集部より発行されております以下の技術群によって構成されています。

GPU不要で利用できるAUTOMATIC1111学習のための教科書

「画像生成AI Stable Diffusionスタートガイド」(SBクリエイティブ刊)

Stability AI APIに関する日本語の情報発信(note無料マガジン)

Stability AI Fan!|AICU media

https://note.com/aicu/m/m6000f560d1db

AICUマガジン Vol.5特集「Stability AI Forever!」

「CGWORLD vol.315」画像生成AIによる表紙メイキング、大公開。

#デジタルハリウッド30周年 記念寄稿

上記の原稿はAICU Magazine Vol.6特集「エンターテインメントxAI」に収録されております。 https://j.aicu.ai/MagV6

Google ColabとGoogle Slidseを使った再現性の高い絵作り技術についてはこちらの記事「#10分で学べるAI」が関連あります。

https://note.com/aicu/n/n4fcc8c200569

AICUマガジン5月号「次世代まんが制作術!」に収録されております

Coloso「生成AIクリエイティブ AICU」シリーズ

Stability AI API、Google Slides、Google Colabを使った画作りについて短時間で実用的な技術を学ぶことができます。

■「超入門:Stable Diffusionではじめる画像生成AI」

■「初級者:広告企画から動画制作までのプロセス」

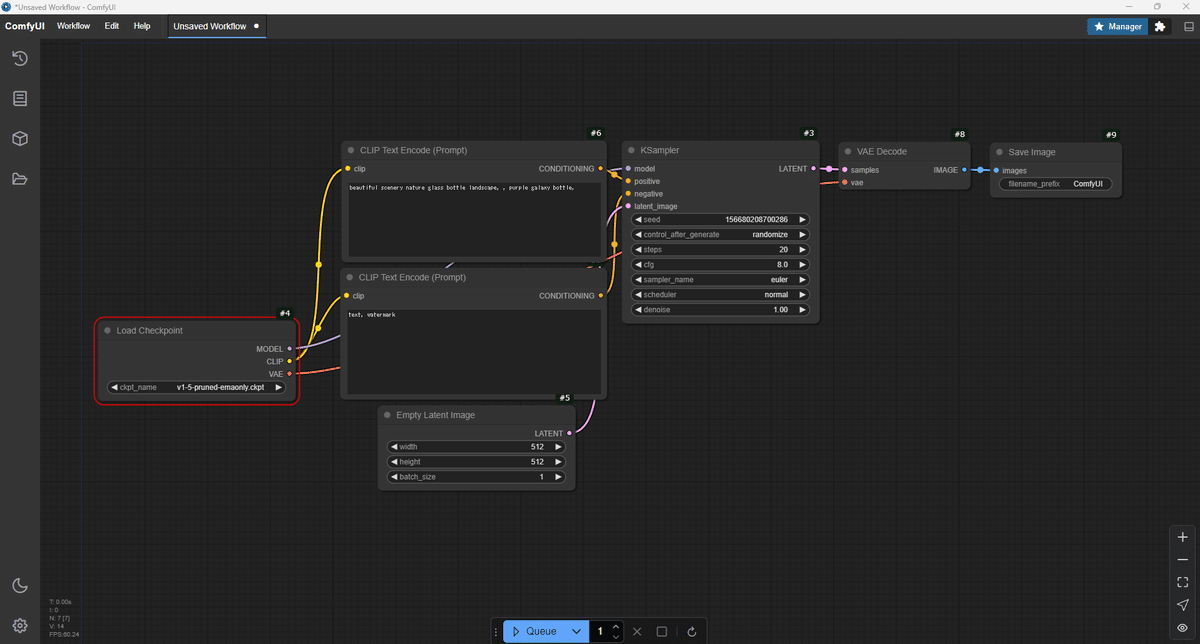

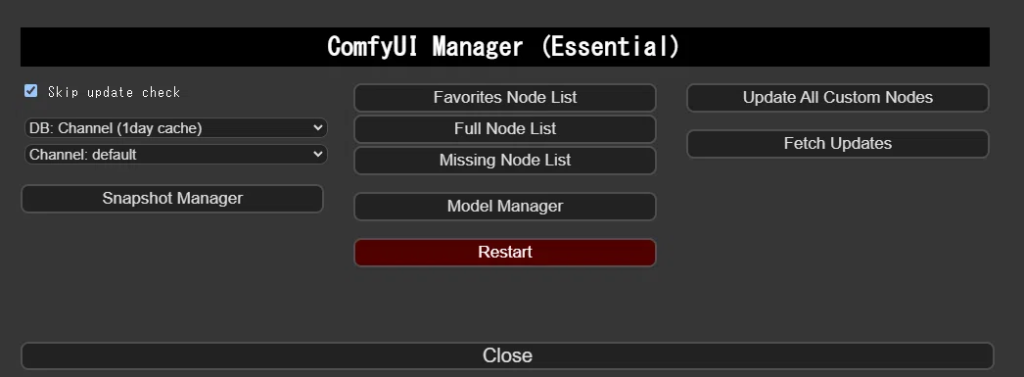

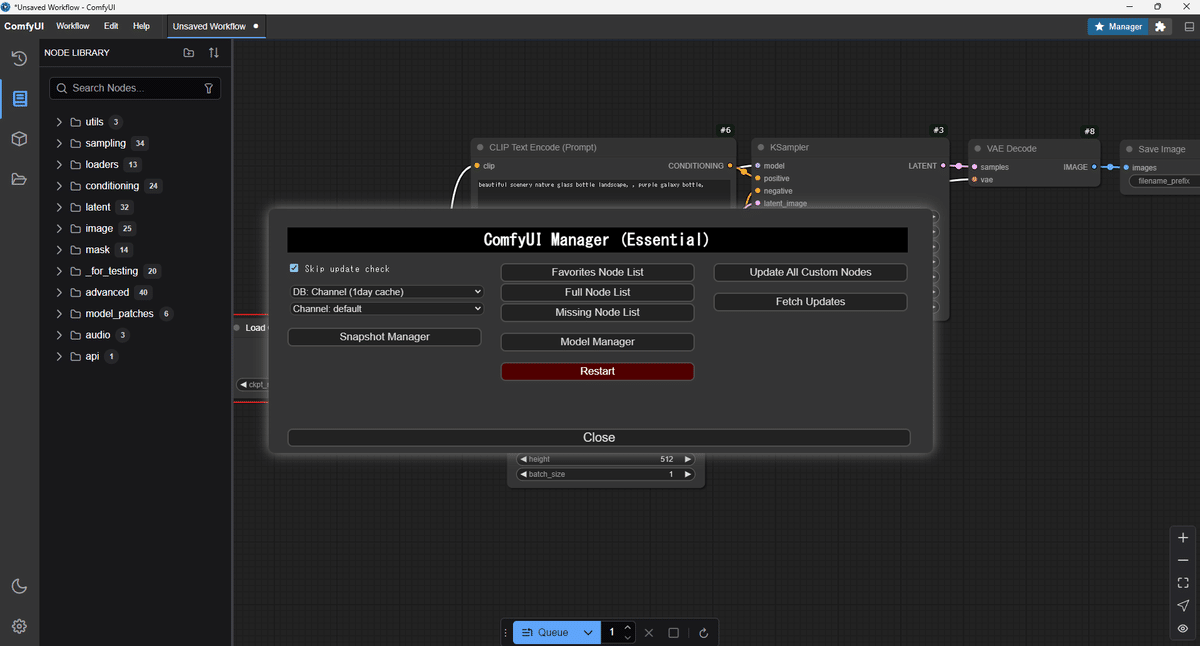

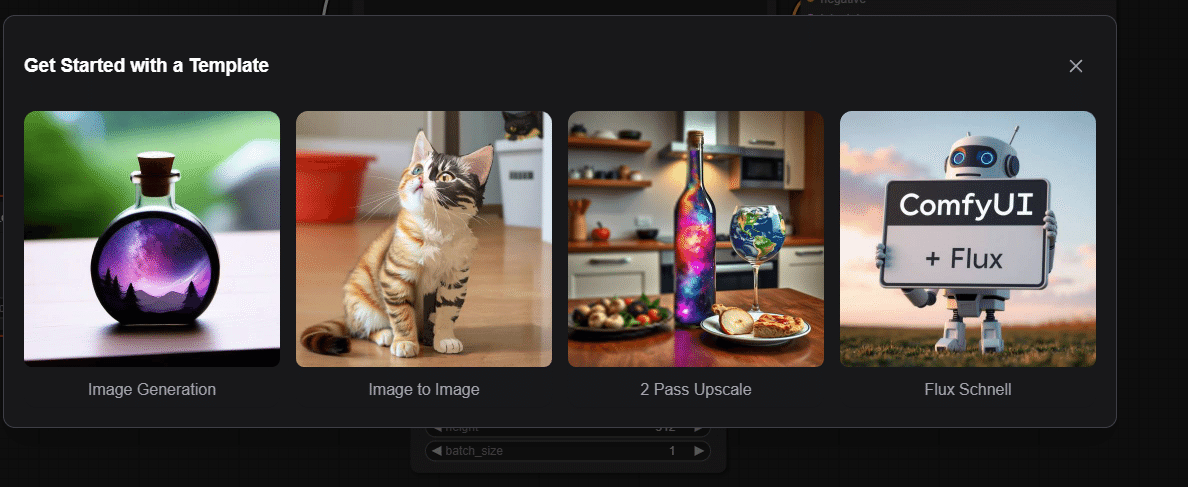

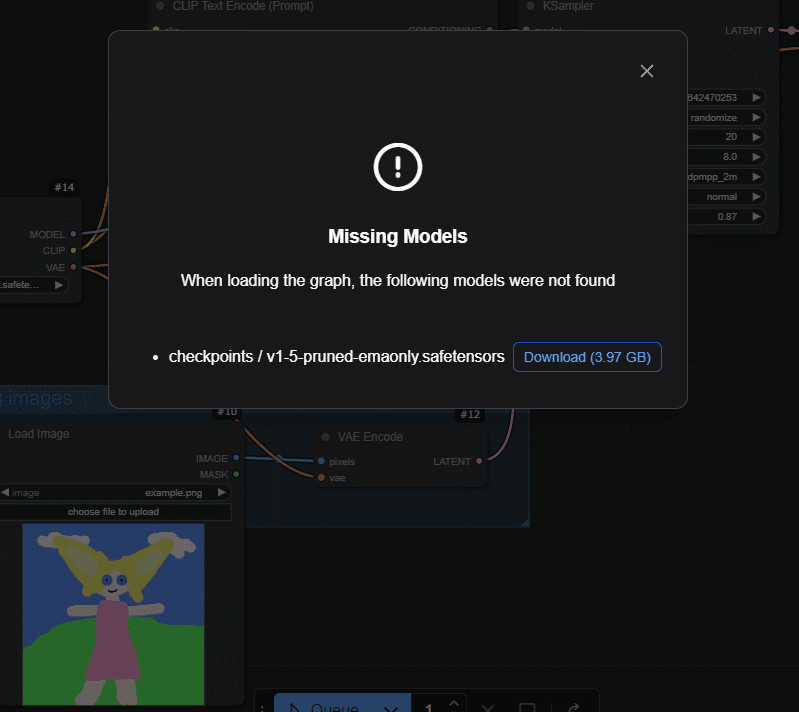

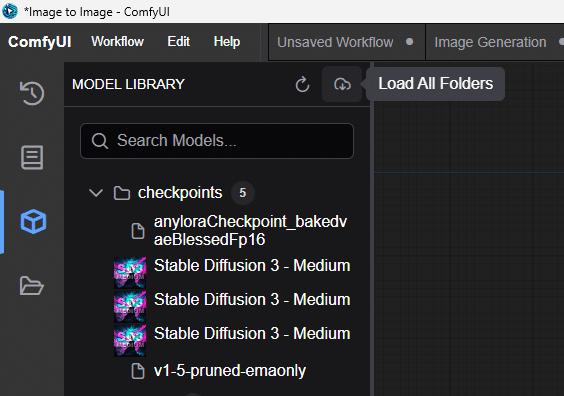

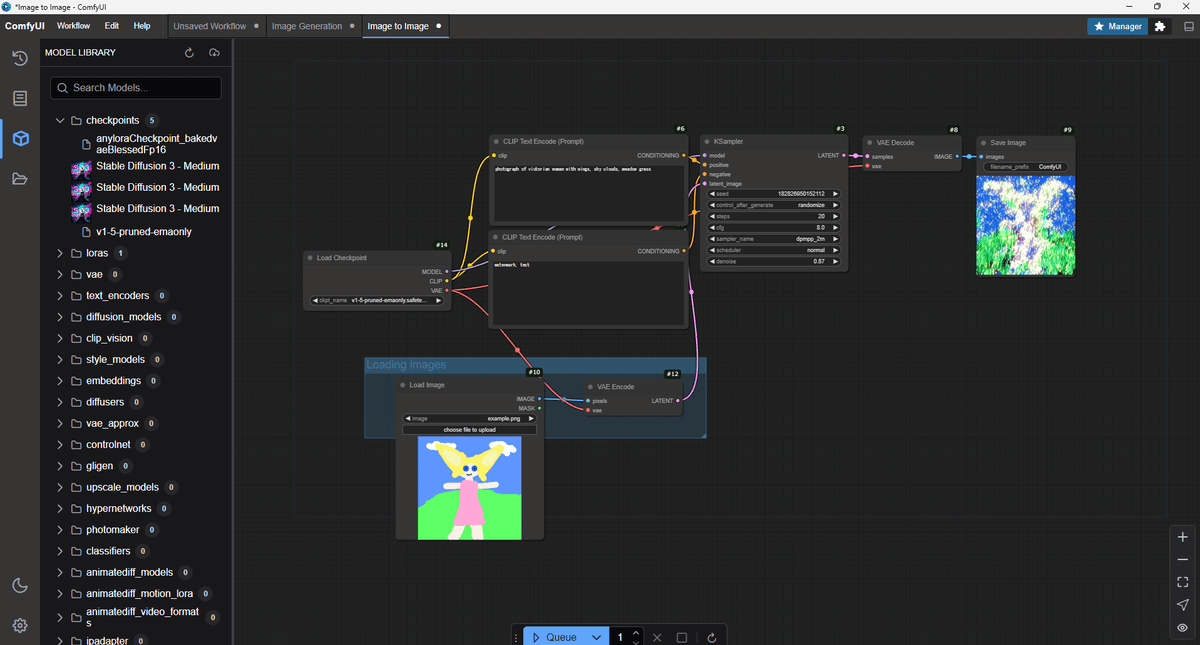

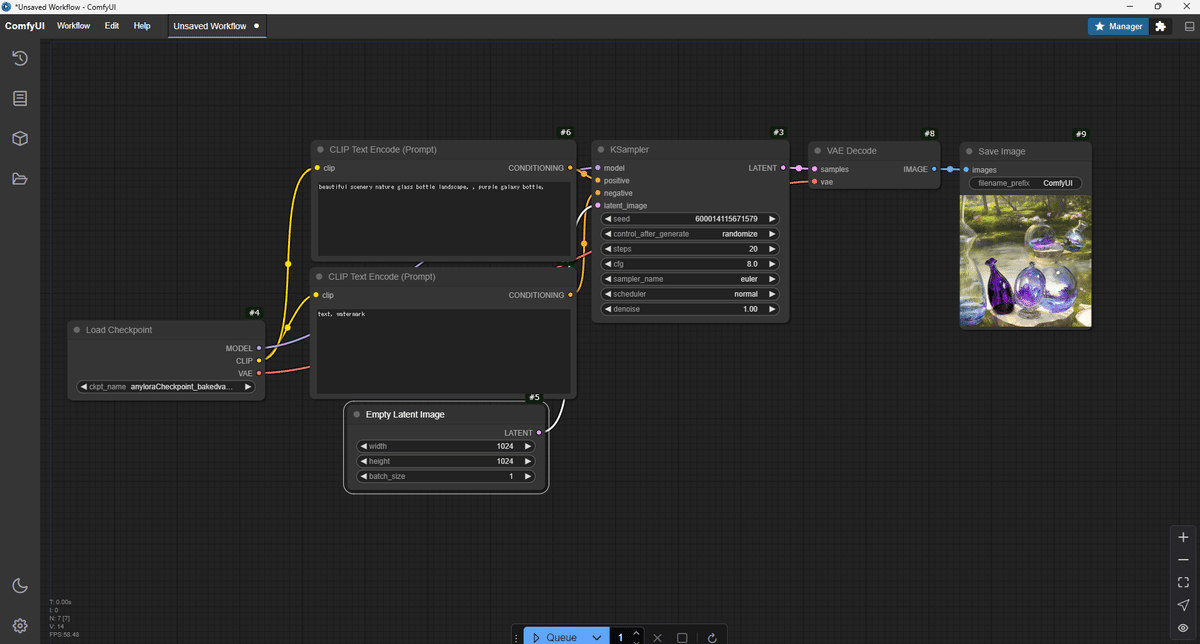

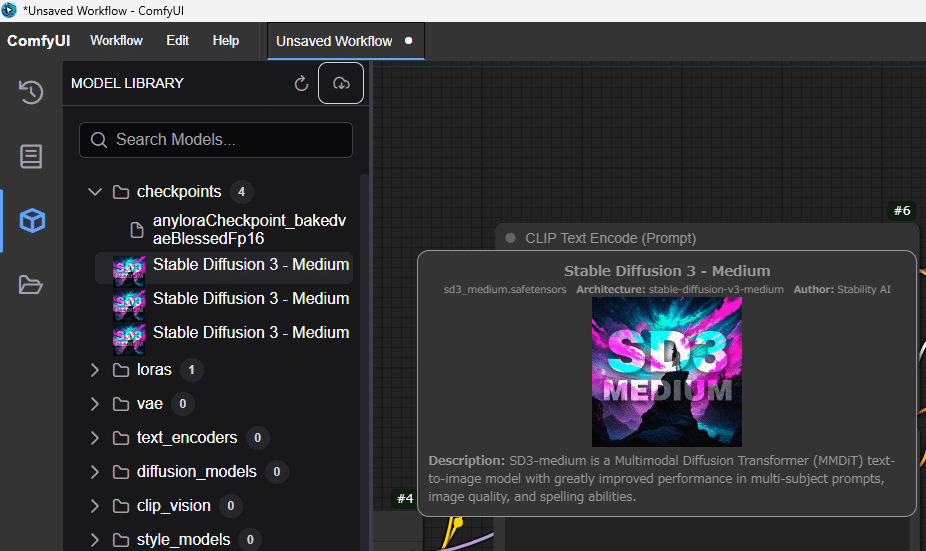

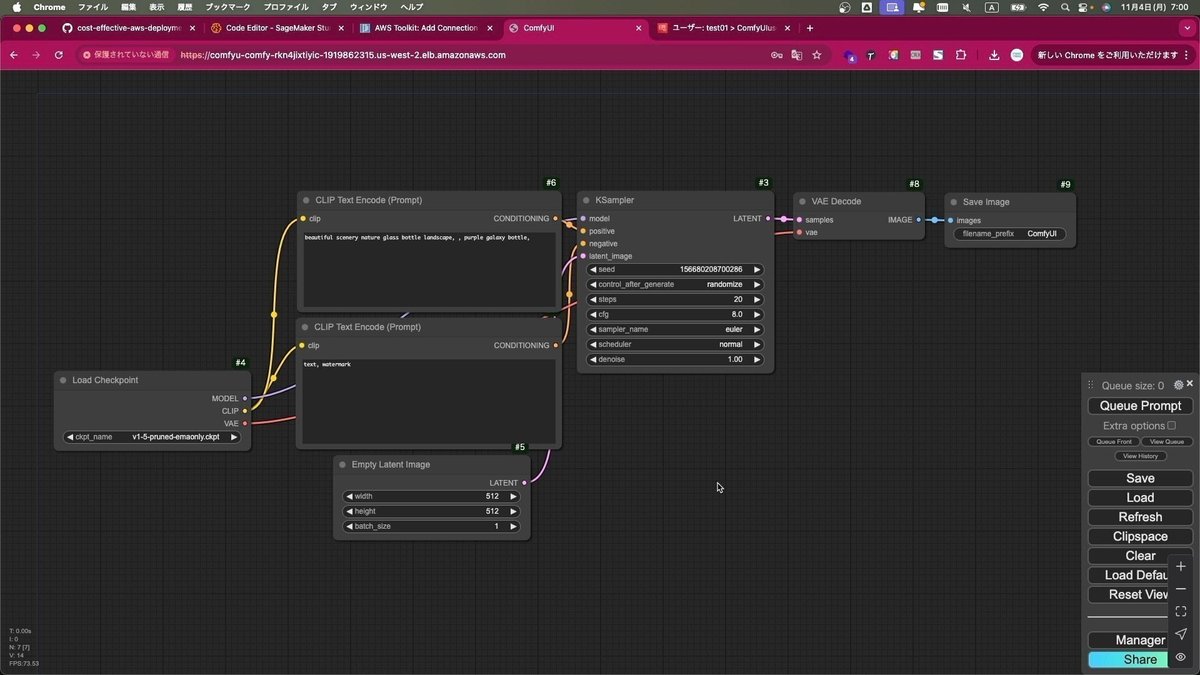

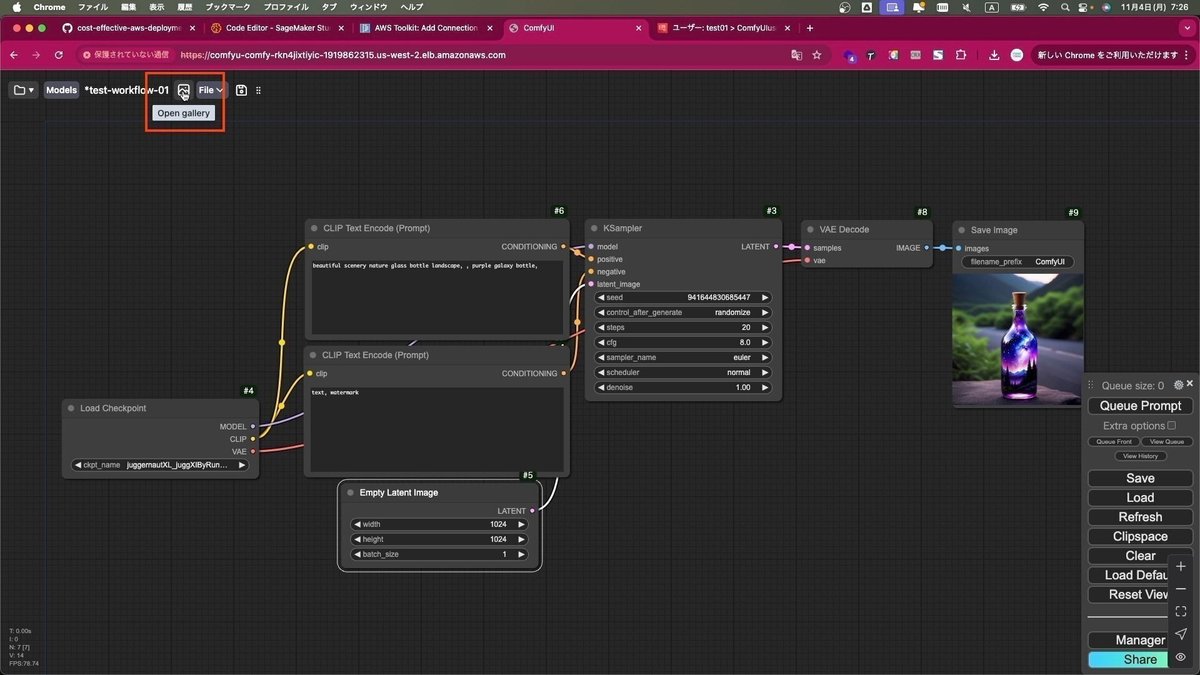

■「ComfyUIマスター:カスタムノードとアプリ開発」

詳細なテクニックにつきましては今後も、AICUマガジンにて特集を組んで紹介予定です。

「つくる人をつくる・わかるAIを伝える」

AICU media https://note.com/aicu

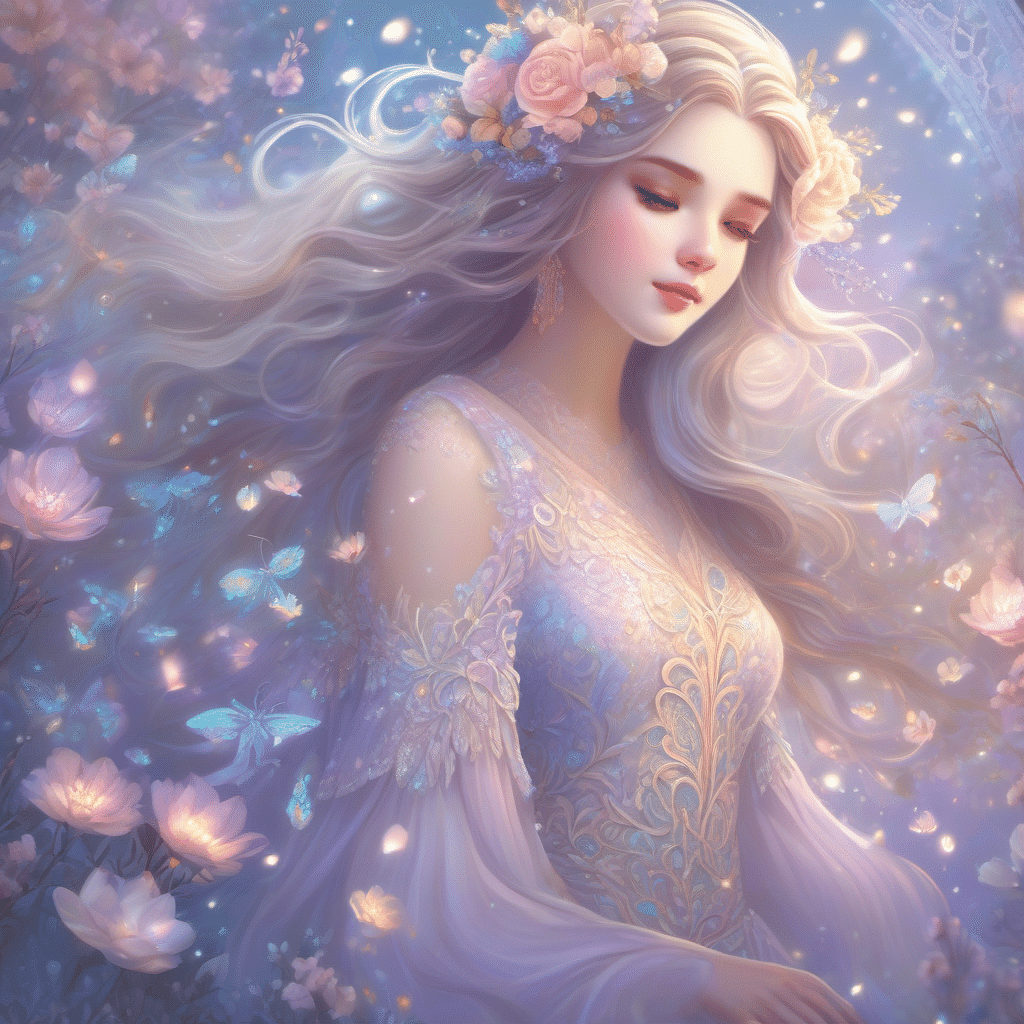

チャンピオンシップ決勝での作品

しらいはかせのコメントや実際に使われたプロンプトとともに、期間限定メンバーシップ向け先行でお送りします。

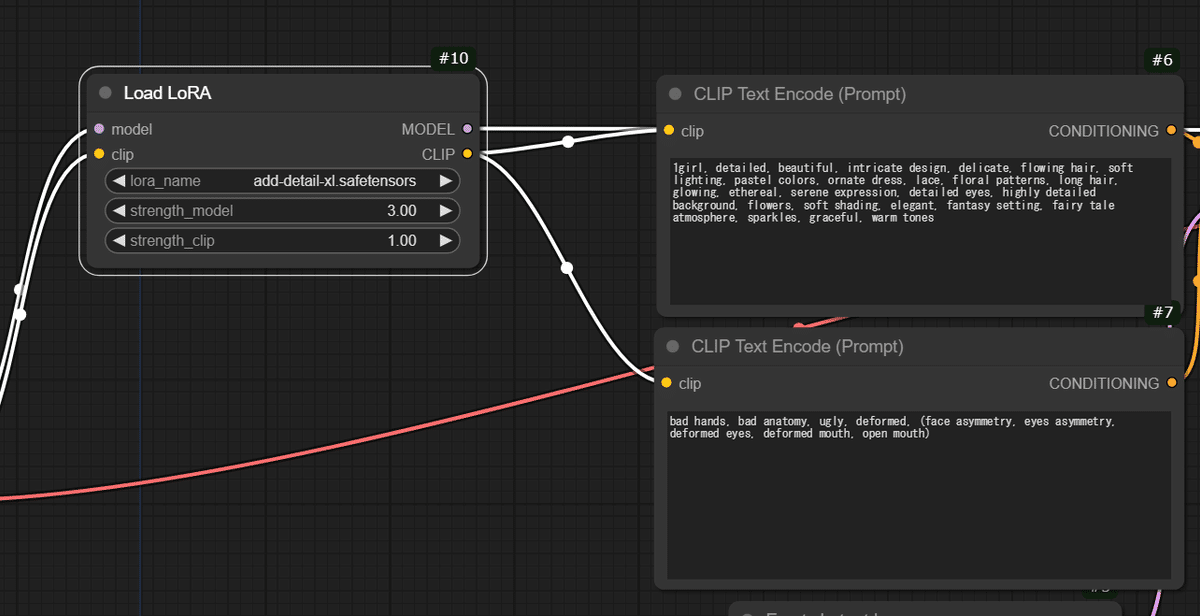

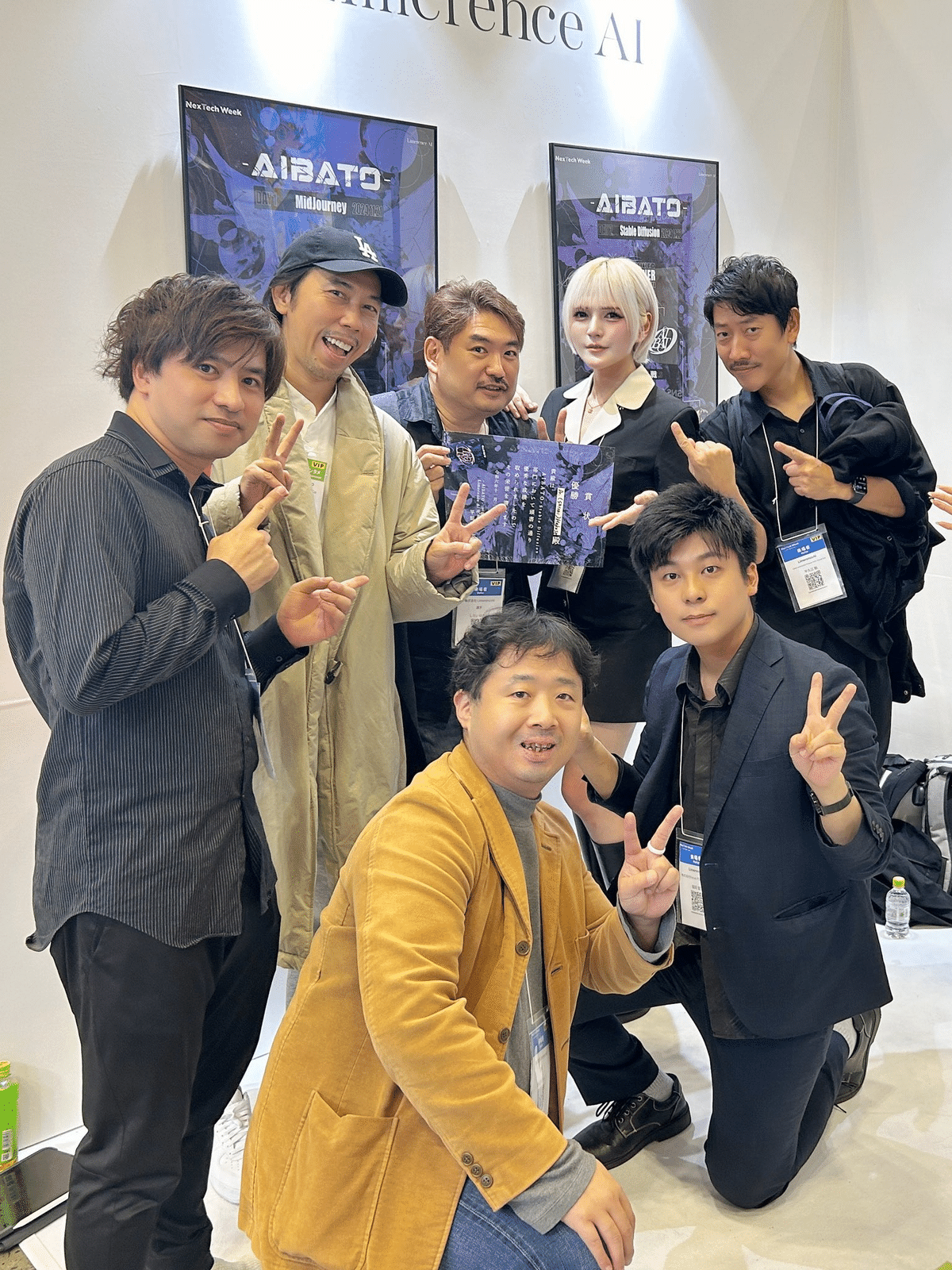

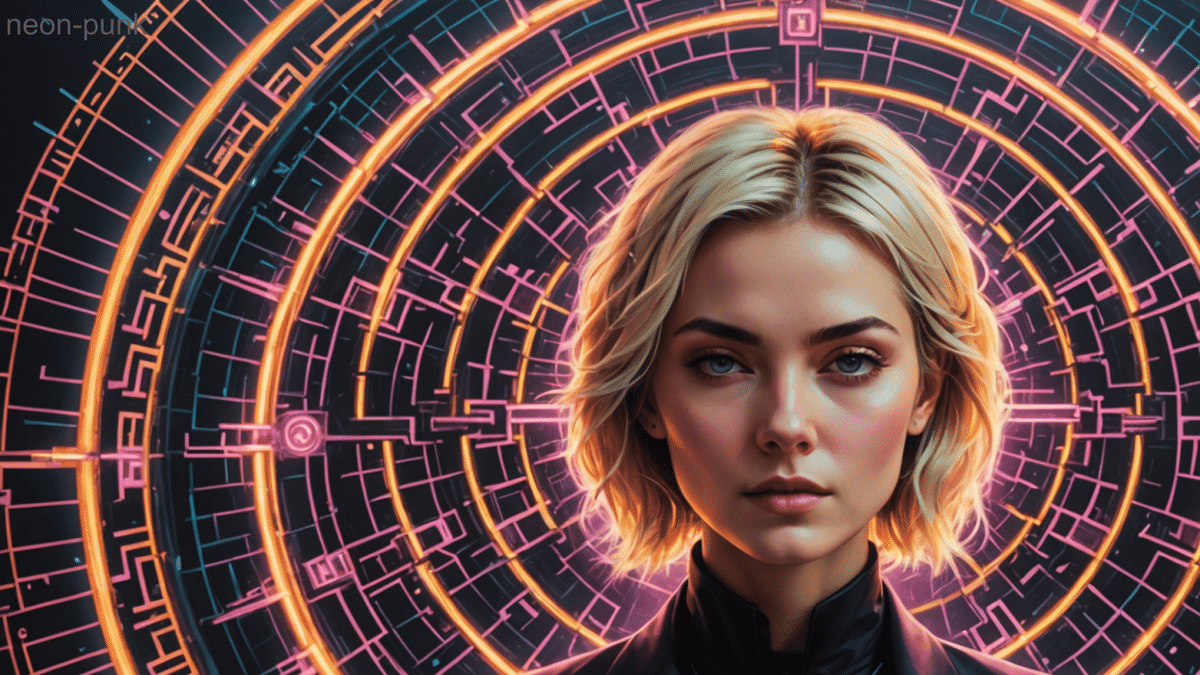

ウォーミングアップ編

当日のMCが前日のMidJourney部門の報告を行うタイミングや、第1試合が実施されている傍らでリアルタイム生成した画像はこちらになります。

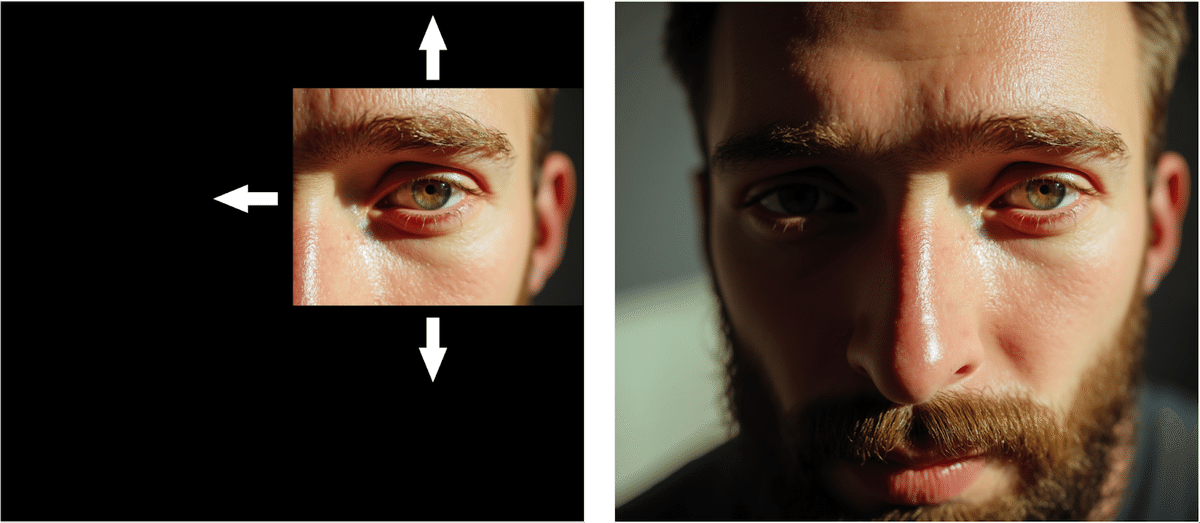

“prompt”: “photorealistic, detailed, highly detailed, alarm clock with accurate dial, young man lying on bed, bedroom scene, realistic lighting and shadows”, “negativePrompt”: “blurred, blurry, out of focus, low quality, distorted, disfigured, deformed, mutilated, extra limbs, poorly drawn, bad anatomy, bad proportions, ugly, monstrous, mutation, mutant, extra body parts, extra heads, extra faces, extra arms, extra legs, extra hands, extra feet, extra fingers, extra toes, malformed hands, malformed feet, malformed legs, malformed arms, malformed digits, malformed limbs, malformed face, malformed body, malformed proportions, poorly rendered, poorly rendered face, poorly rendered hands, poorly rendered body, poorly rendered proportions, artifacts, errors, defects, low resolution, text, watermark, signature, username, logo, ui, hud, bad quality”

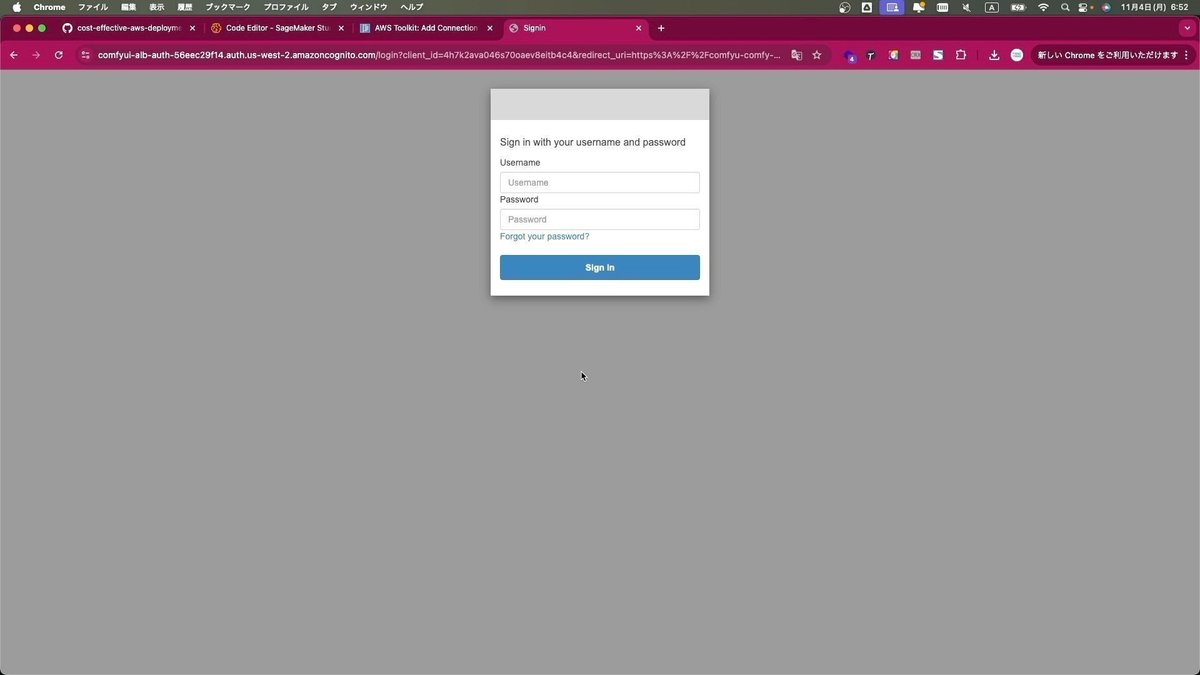

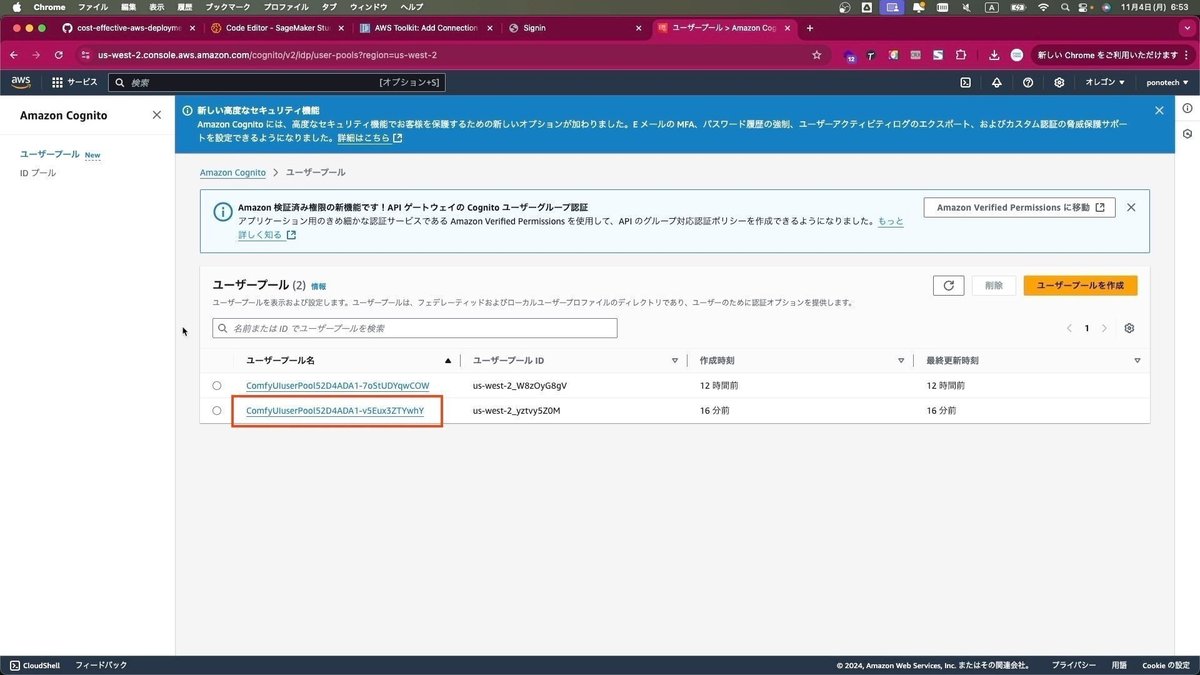

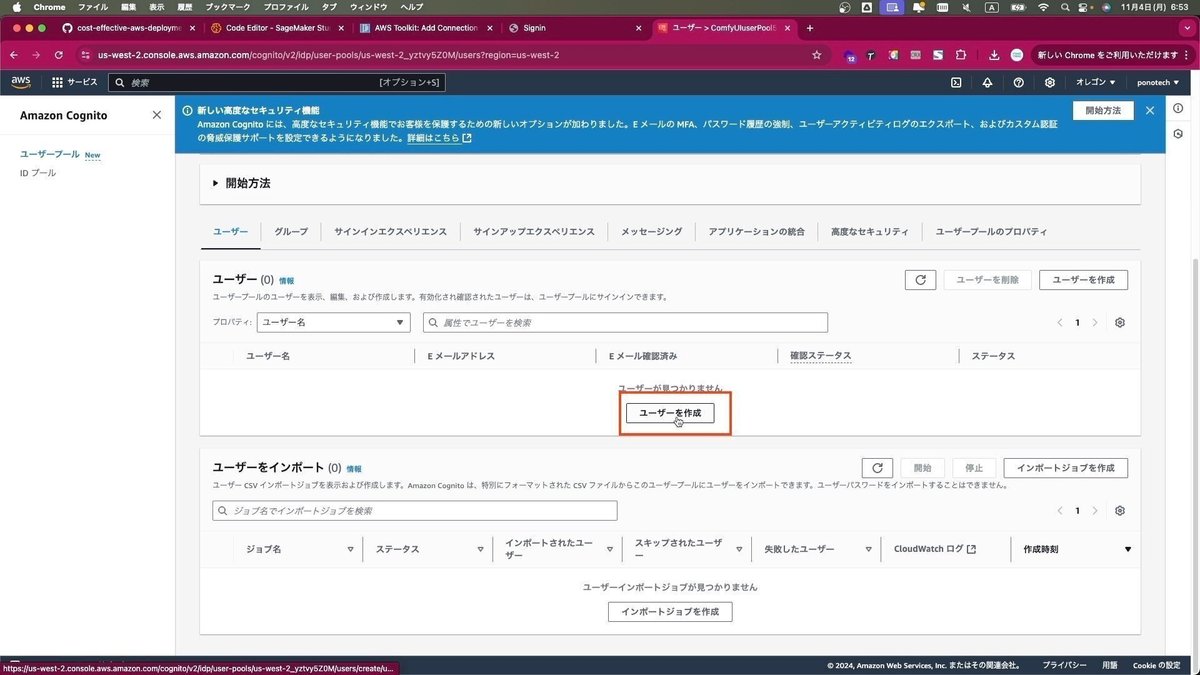

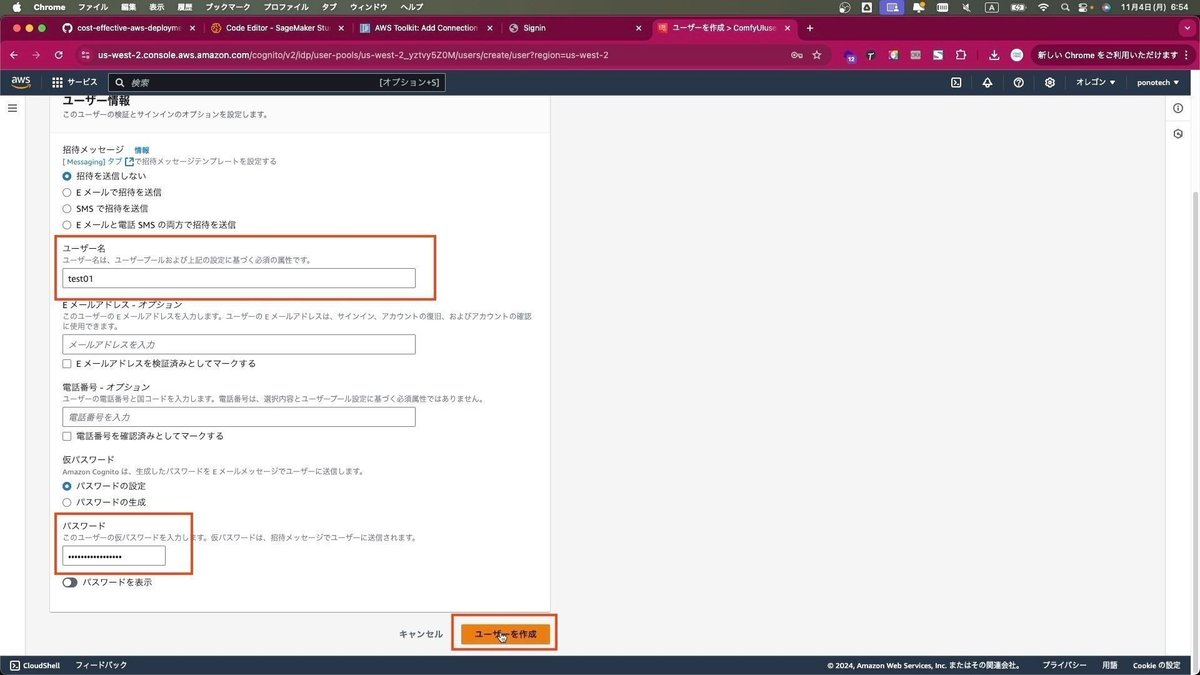

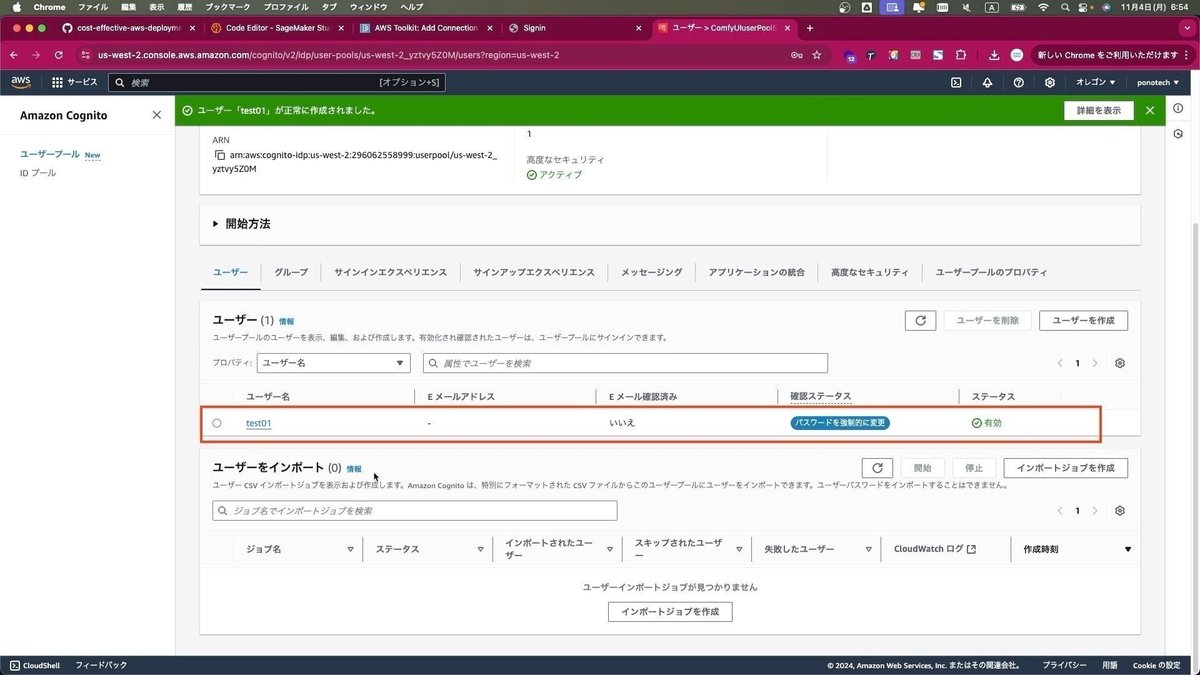

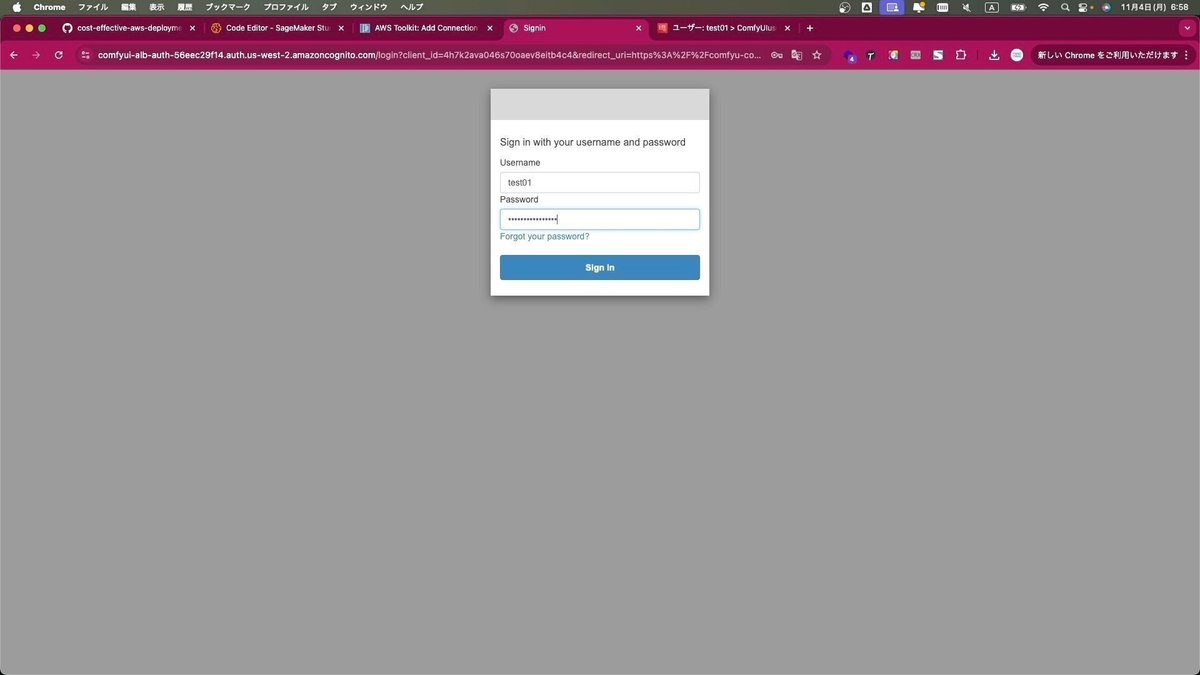

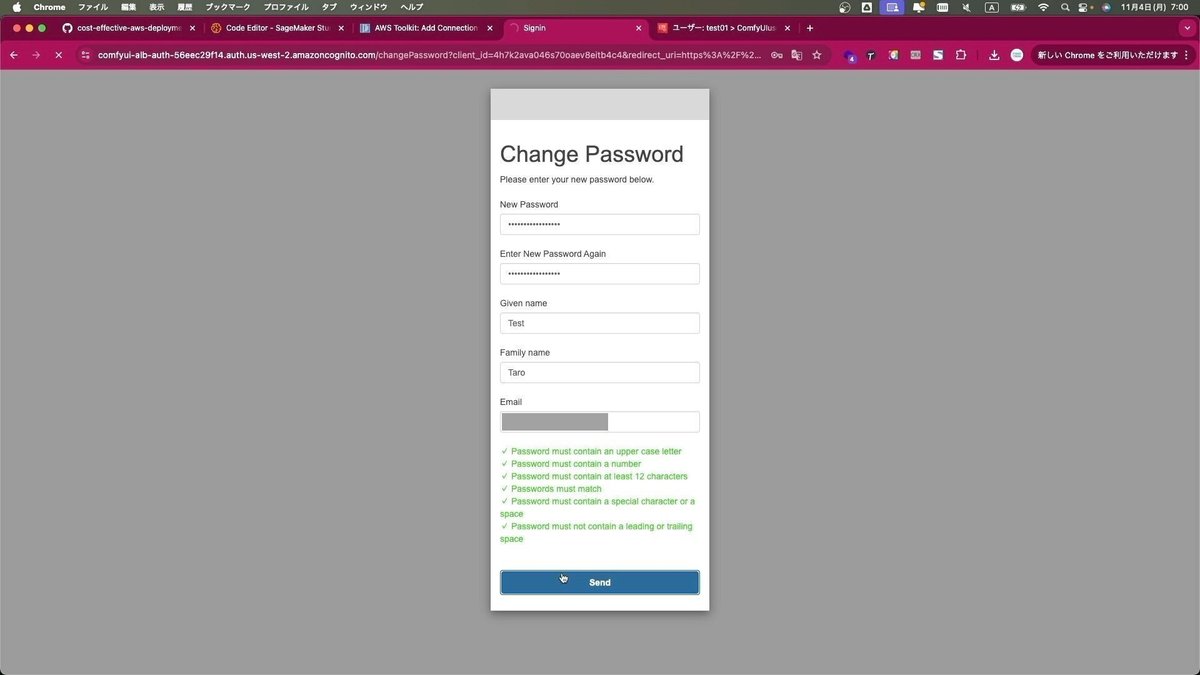

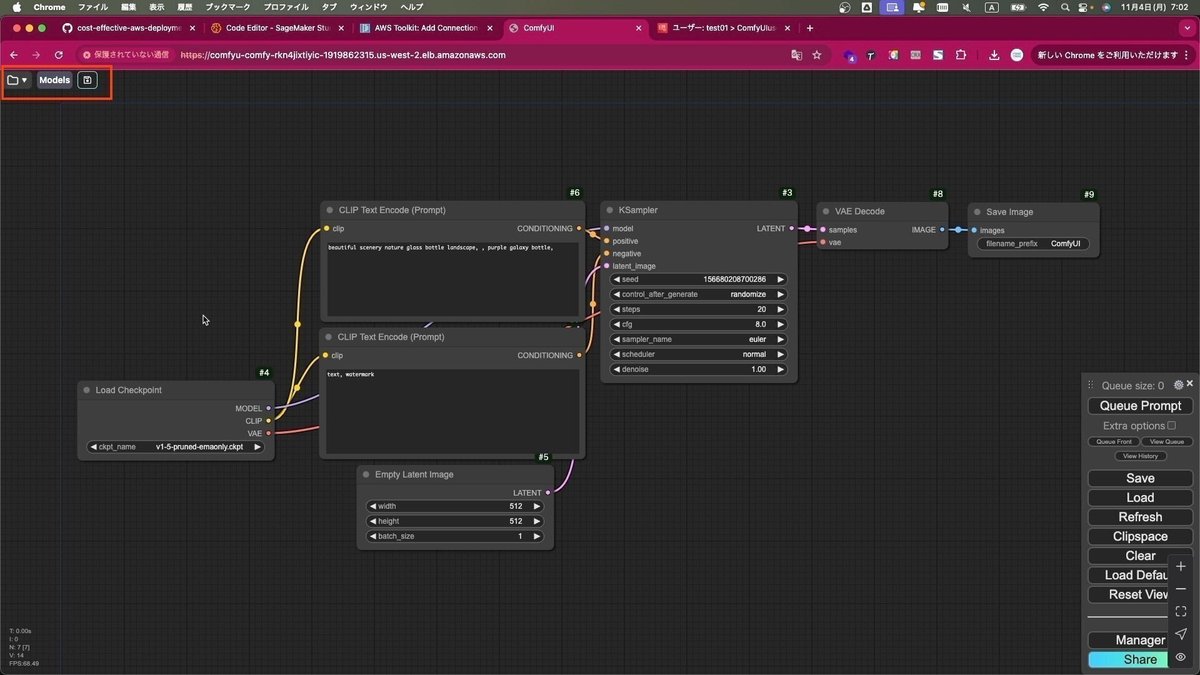

まず、これらの非常に長いプロンプトを英語で表現する上で、シードやモデルとともに一貫性を維持するため、プロンプトエンジンとしてAWSを利用した自社開発のシステムを運用しております。

ベースになっているシステムはAWSが公開しているオープンソースでのGenUであり、AWS 生成 AI 実用化推進プログラムの協力もあり、実用レベルでの実証実験を行っております。

例えば、AICUが実施を担当している、神奈川県「ともいきメタバース講習会プロジェクト」でも障害者むけワークショップでiPad等で利用されており、以下の書籍でも報告されております。

■メタバースとAIで「ともに生きる」を実装する本 ~ 神奈川県の障害福祉現場で開発してみた!(技術書典17:DHGS_CAIL デジハリ大学院「クリエイティブAIラボ」)

https://techbookfest.org/product/2wMwe21GnNdPPpQeby4Dc9?productVariantID=pD8wVXcUzd5zcvXRwH122L

ネット環境やPC、GPU環境が乏しい環境においても安定して日本語でStable Diffusion XLを用いた画像生成が行える環境になります。構築についてのご相談はAICU AIDX Labまでお問い合わせください。

さらに続きます。

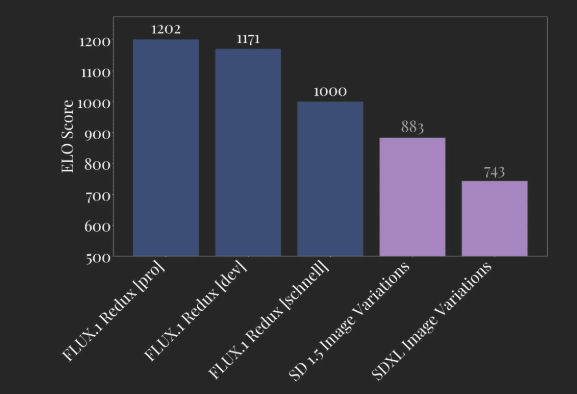

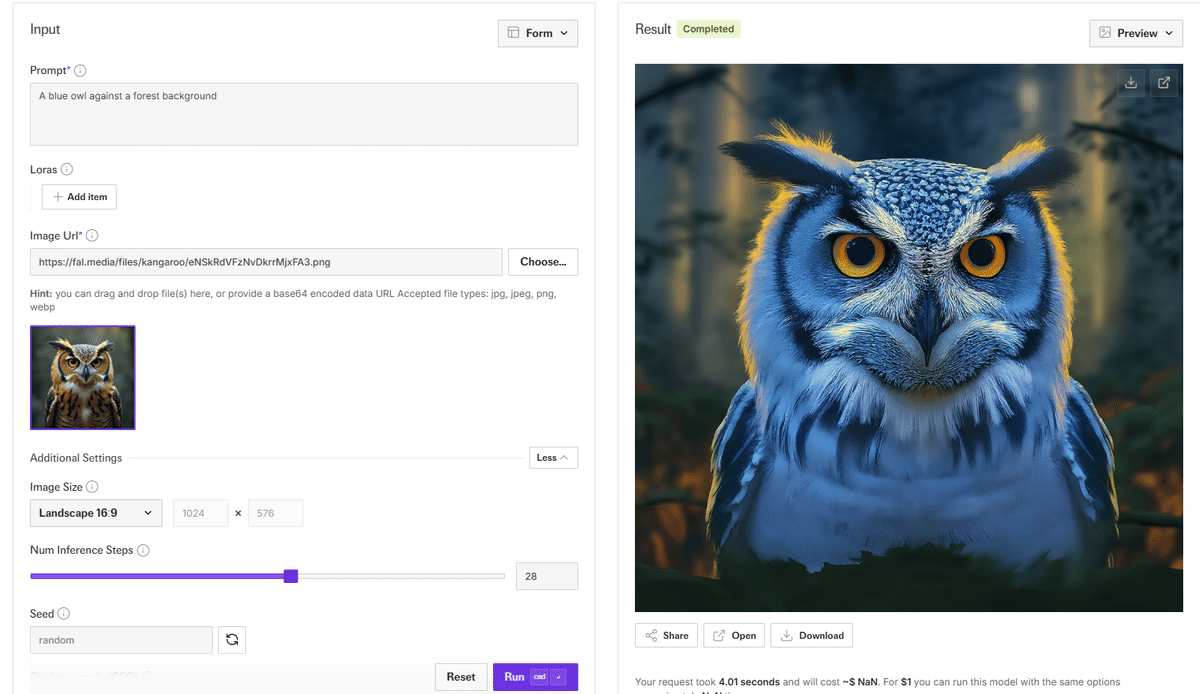

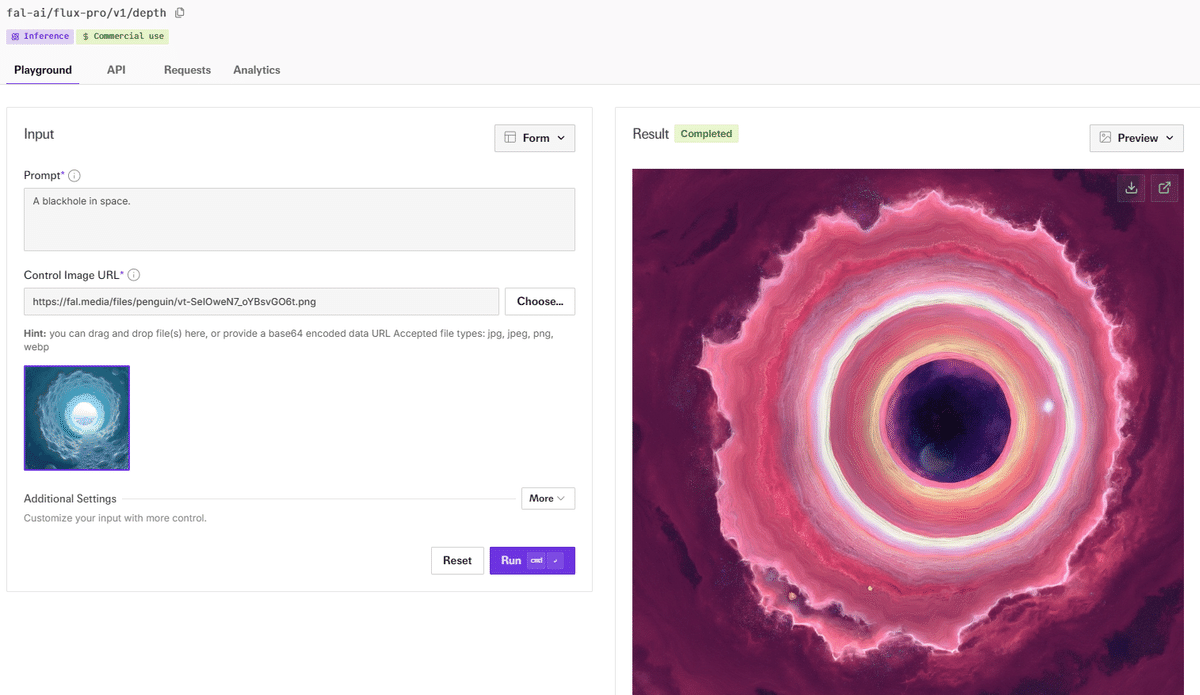

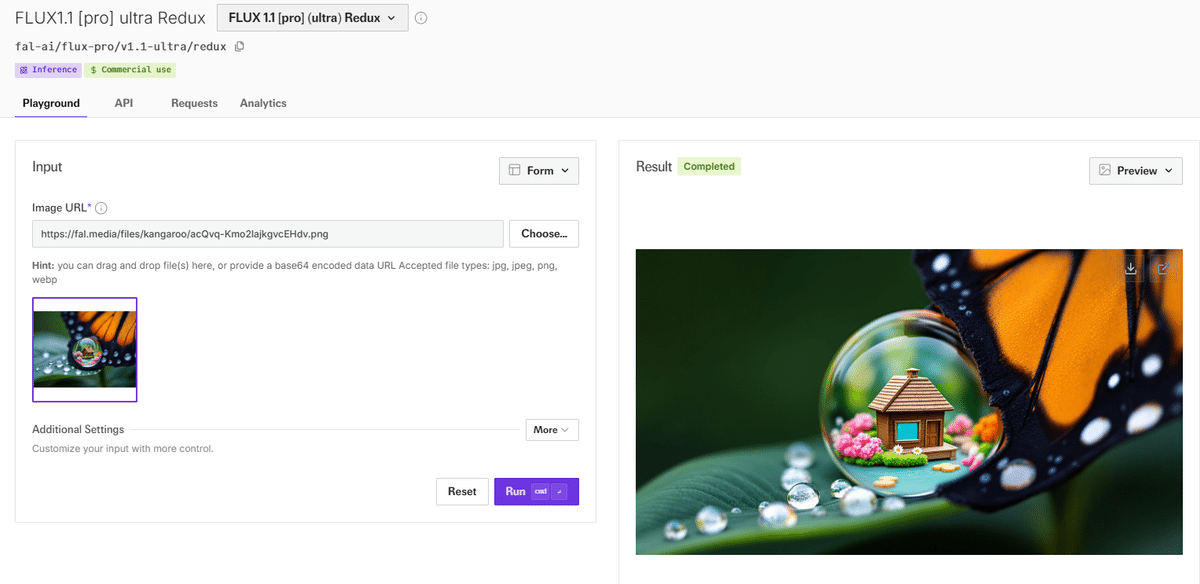

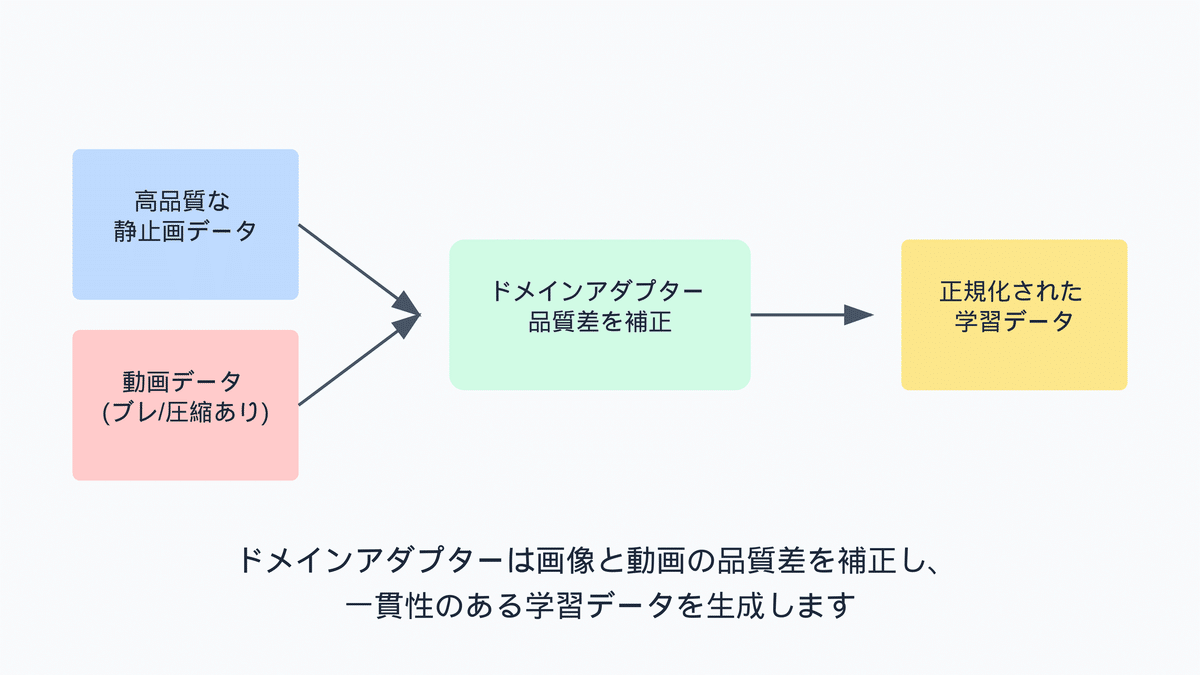

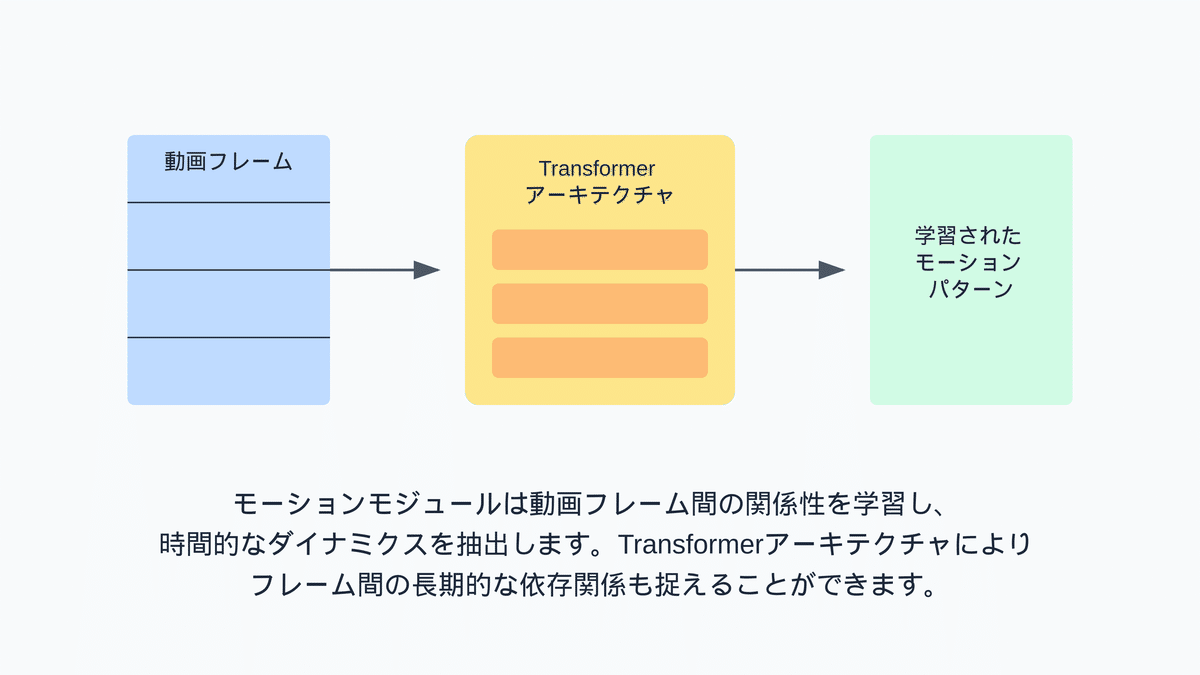

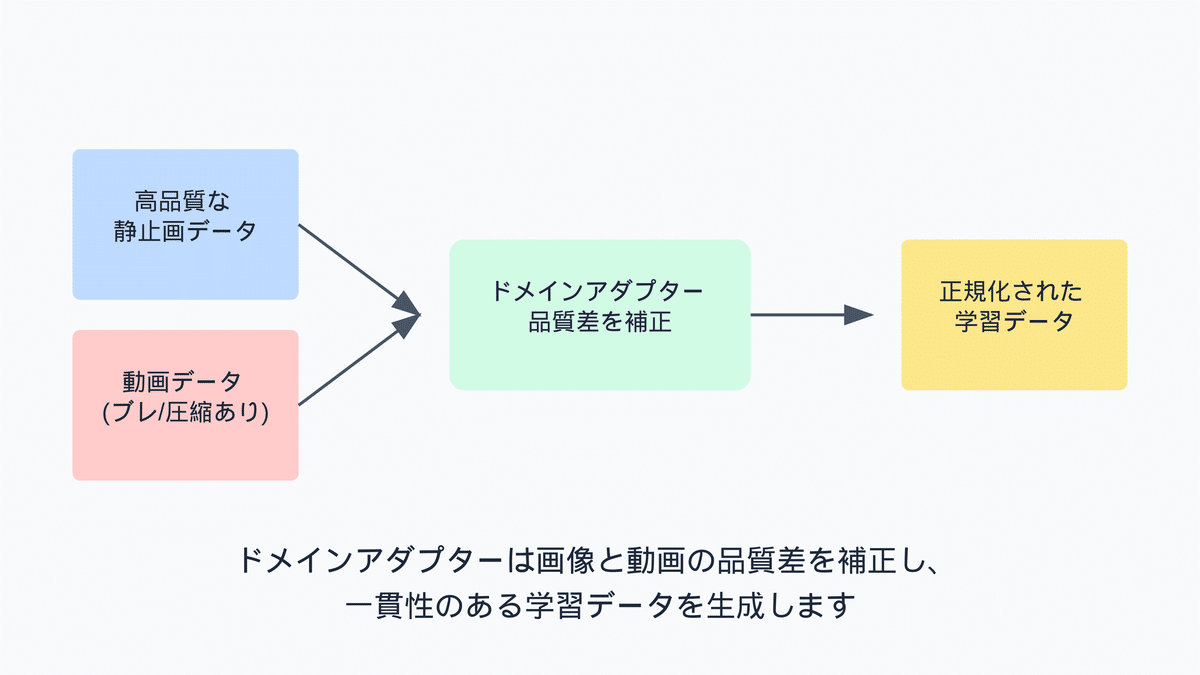

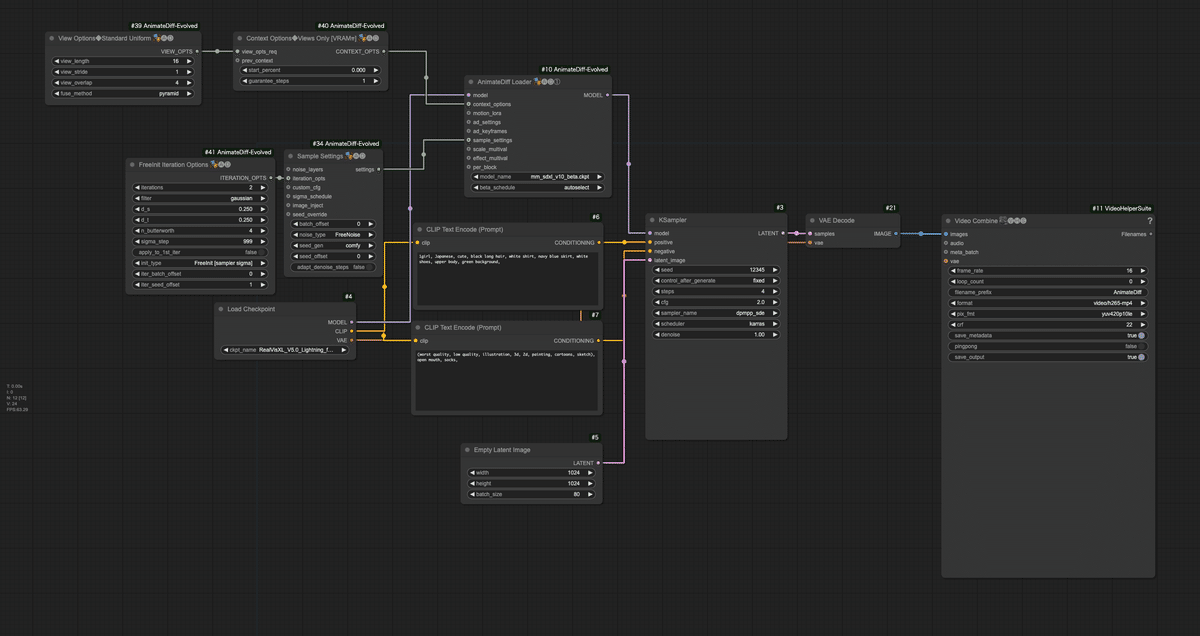

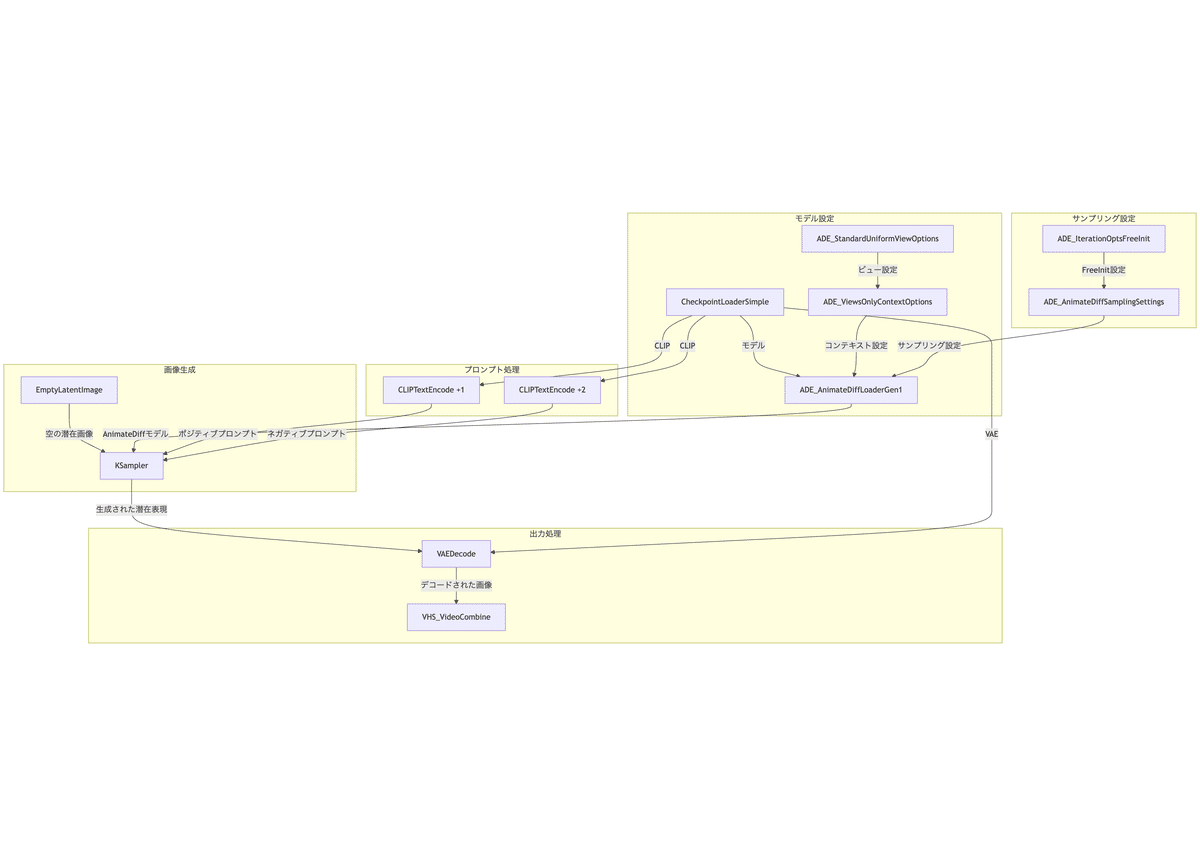

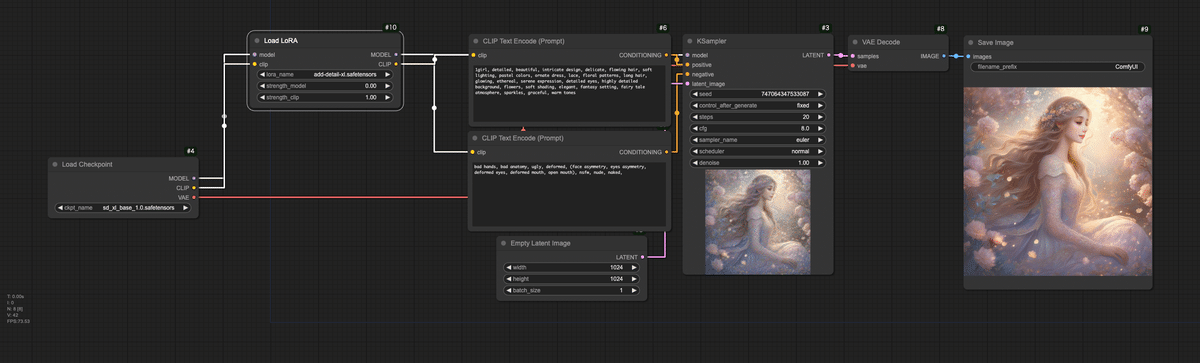

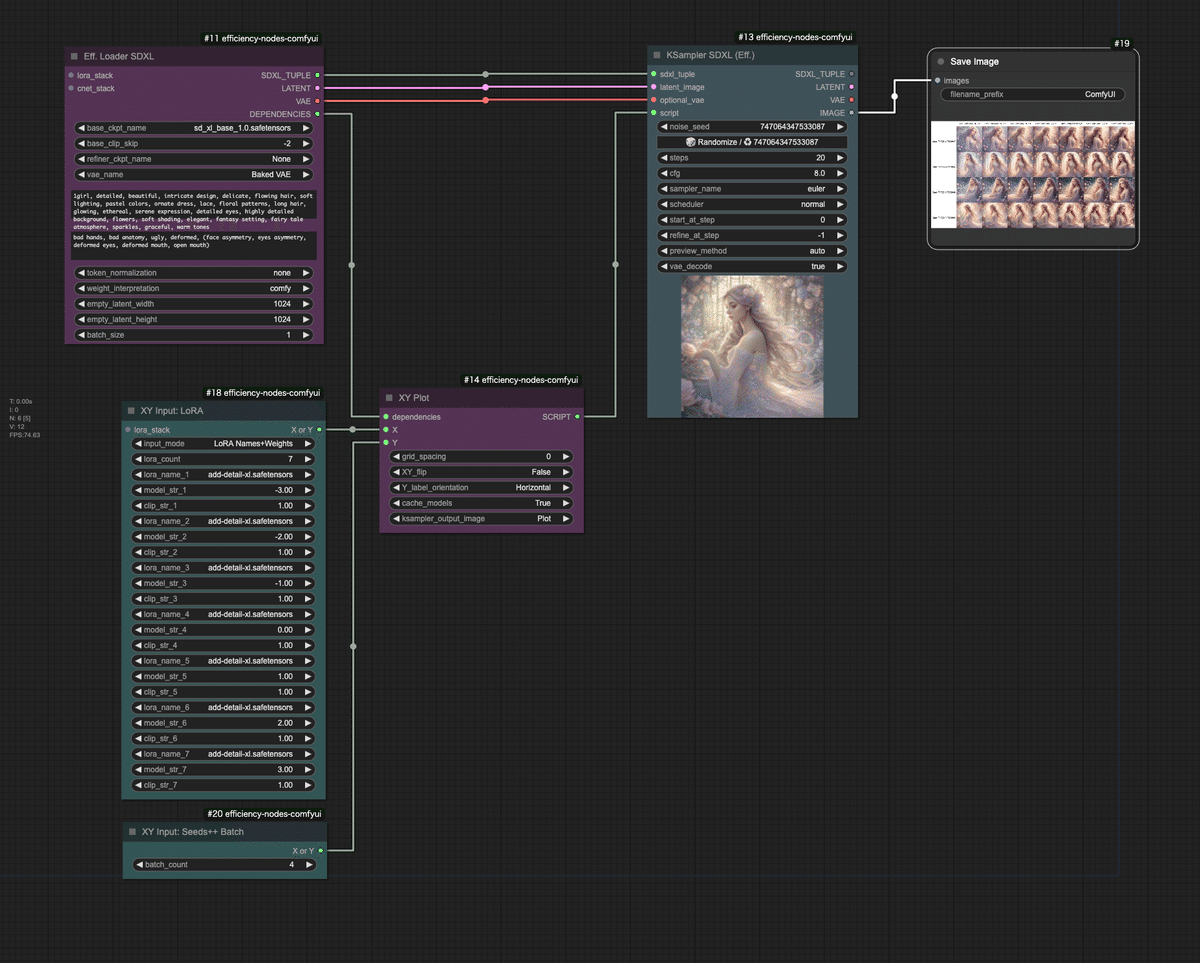

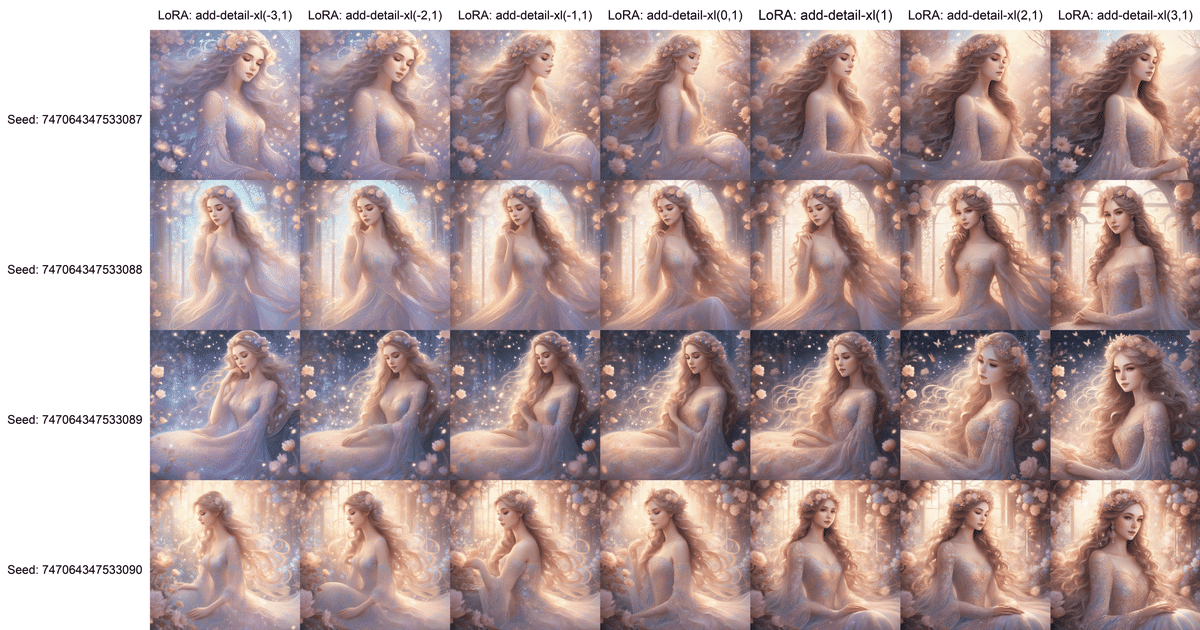

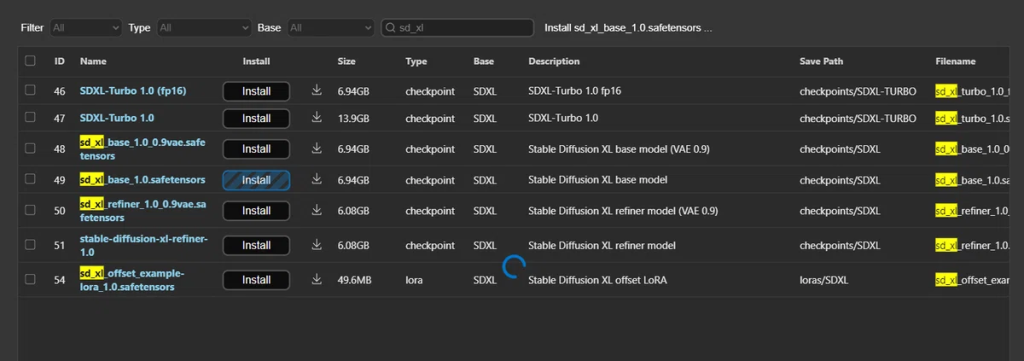

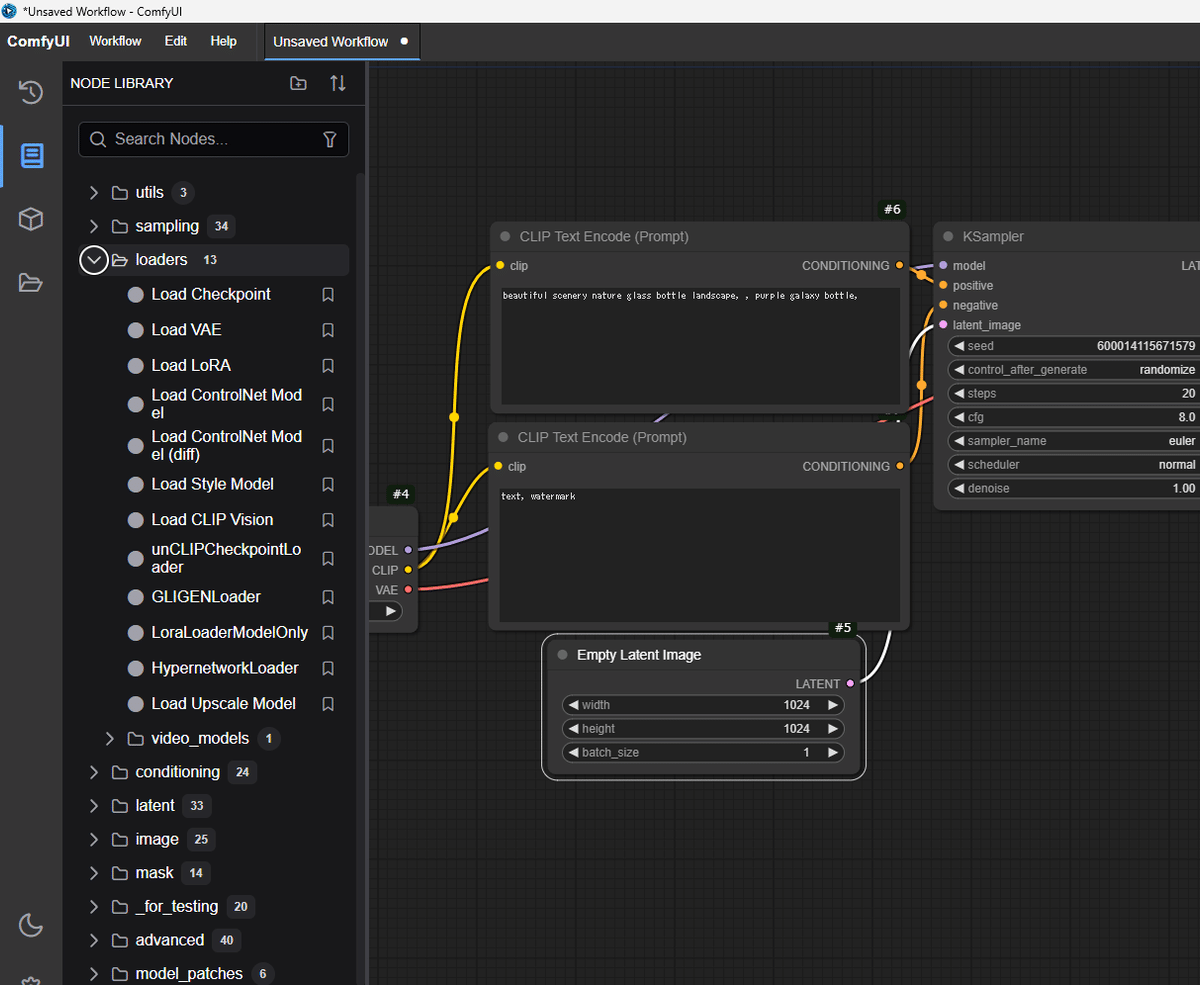

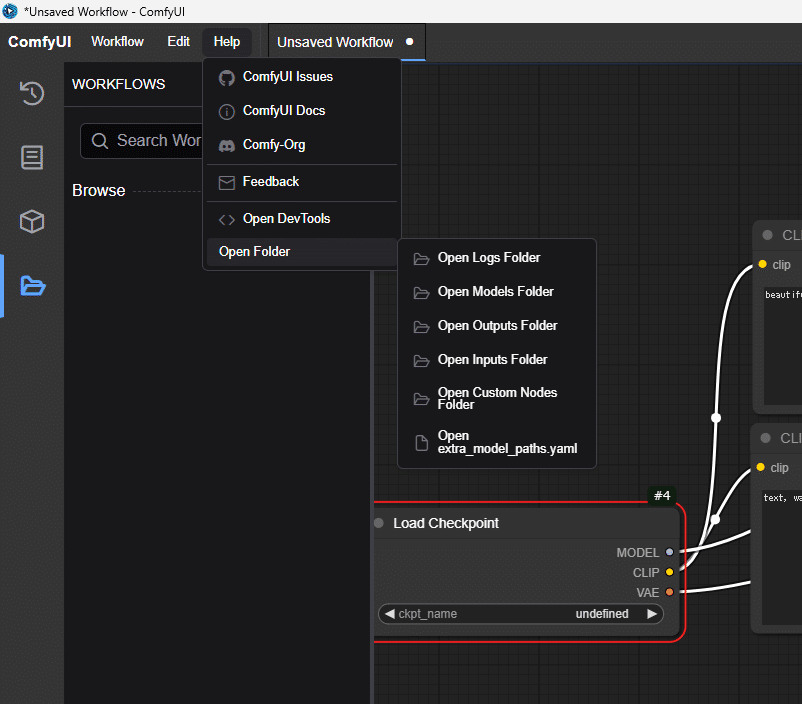

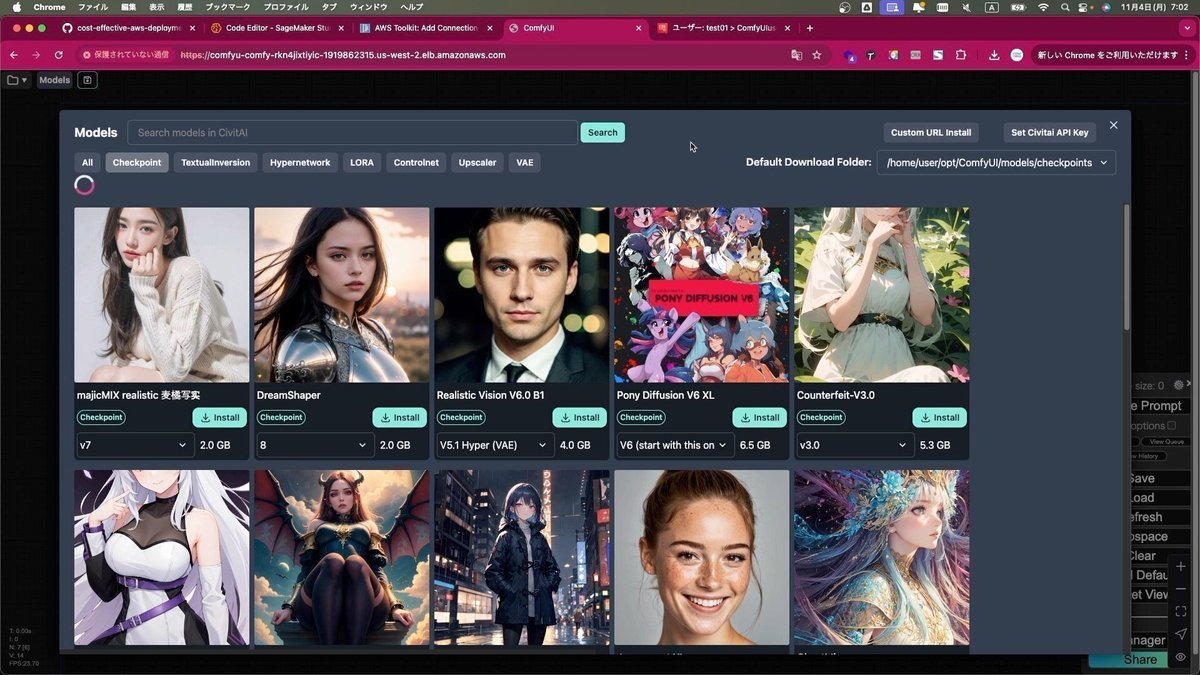

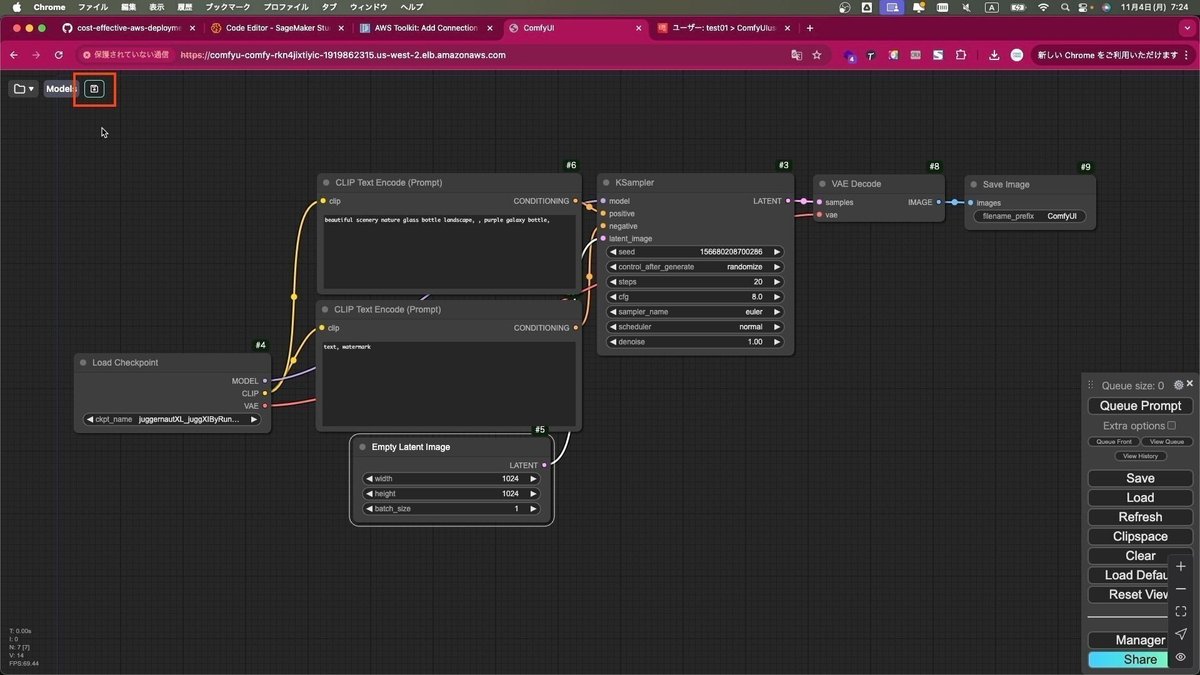

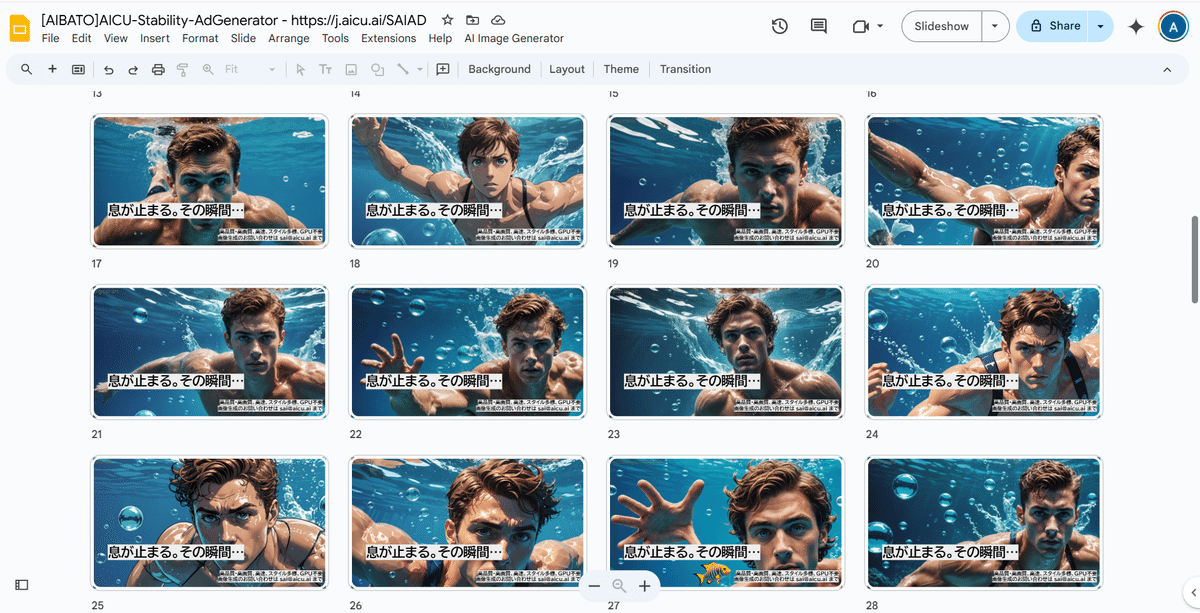

上記のプロンプトエンジンは、あくまでベースモデルとなるStable Diffusion XL (SDXL)での生成となります。このプロンプトをベースに複数のモデルにおいて、適した画像を生成していく方針になります。またSDXLは2023年6月に公開されたモデルであり、ベースモデルとしてオープンに公開されており、また光の表現や構図構成力、解像度などはSD1.5系とは一線を画すレベルですが、指の表現や人物・人種の偏りには難があります。またメモリ消費が大きくローカルGPUでの複数モデル同時利用は現実的ではありません。そのため、近年公開されたSD3系のモデルを複数並列してAPIを経由して利用します。

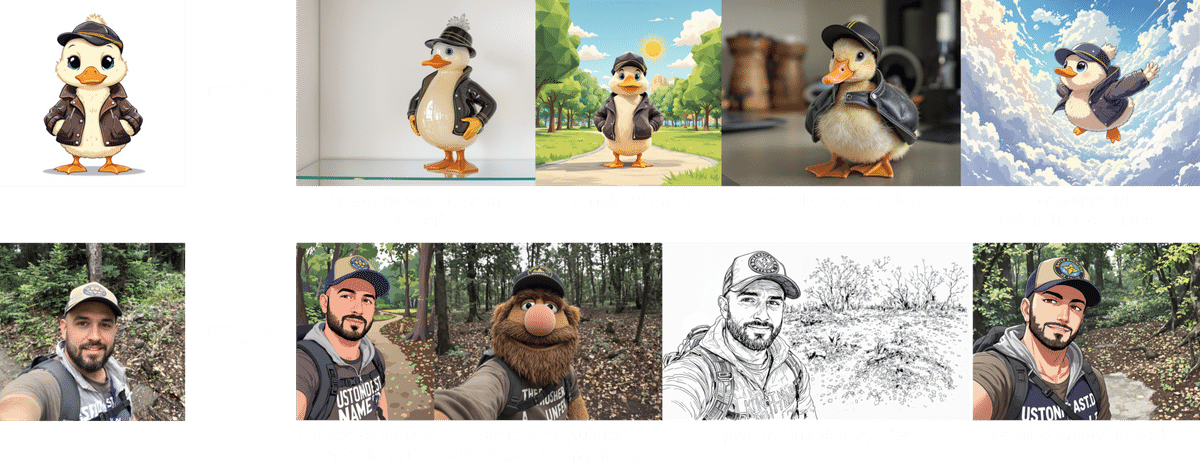

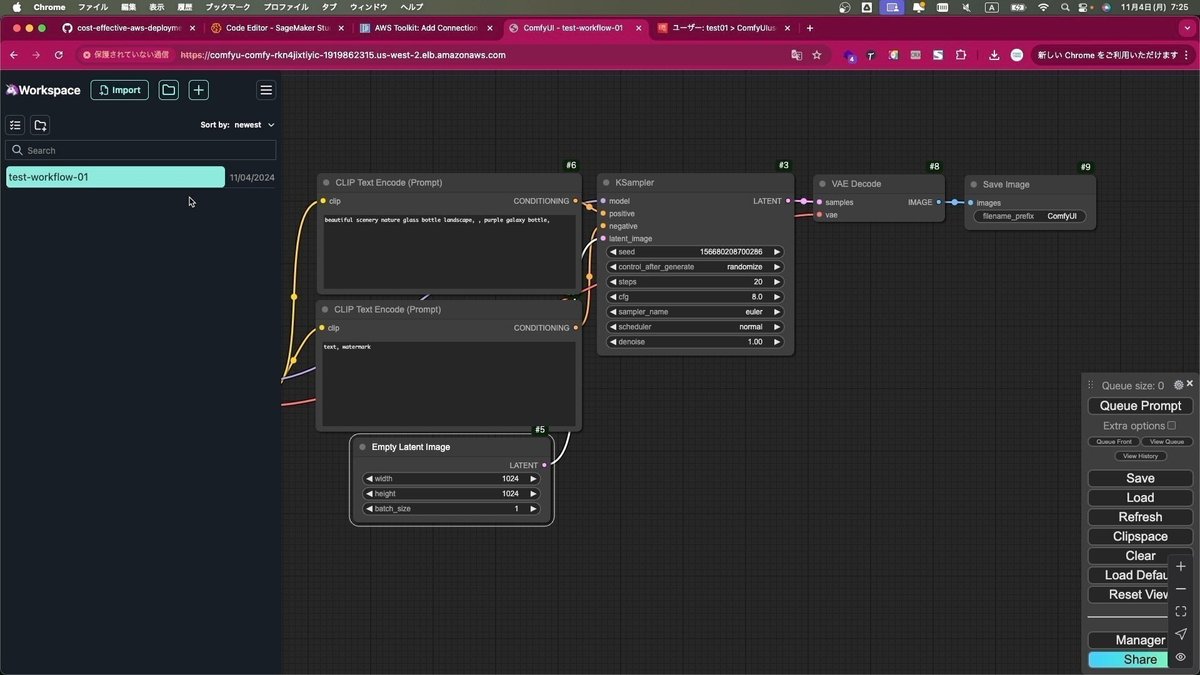

例えばGoogle ColabやGoogle Slides、Windowsのバッチファイルなど、ありとあらゆるインタフェースやツールを使い、並列して再現性高く評価していきます。また同様に、SD3だけでなく、SD3.5やFlux、またそのLoRAなども並列して評価を行っています。

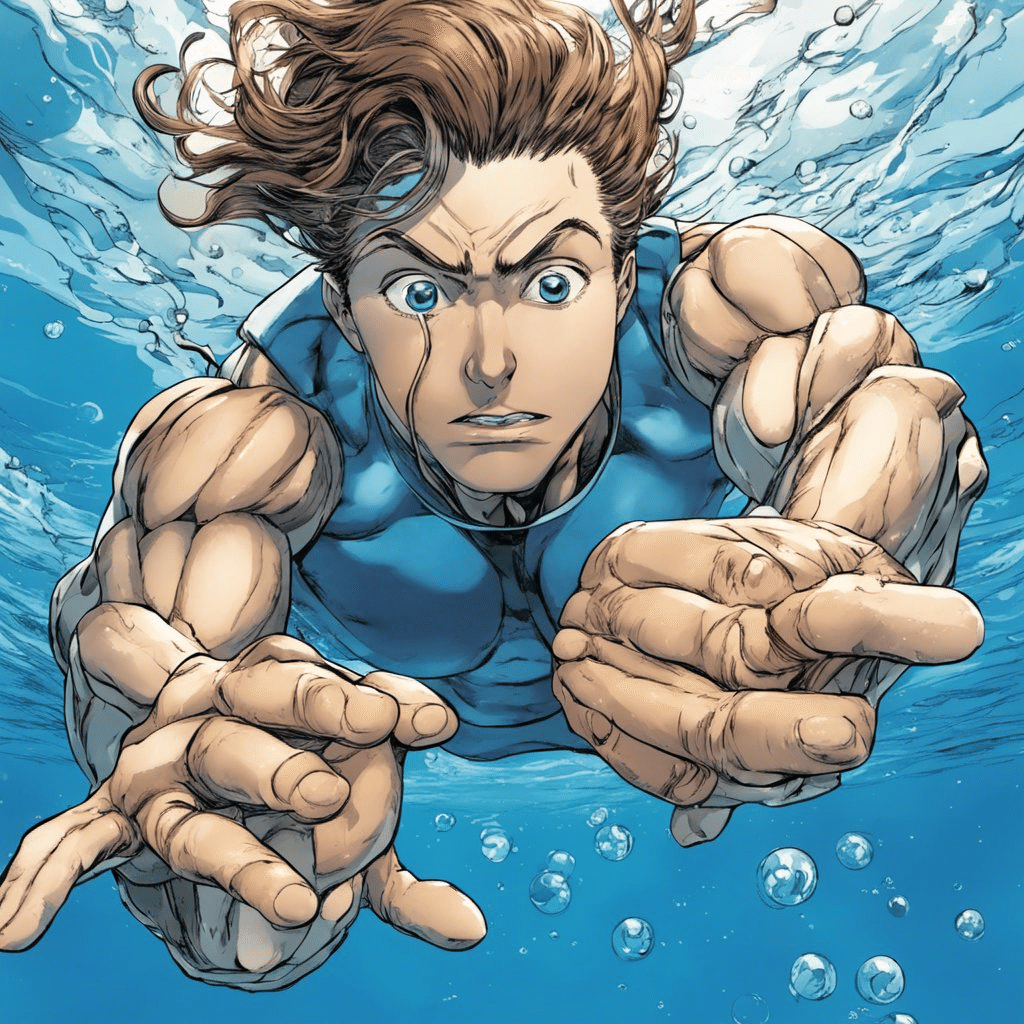

Shot1テーマ: ”息が止まる”

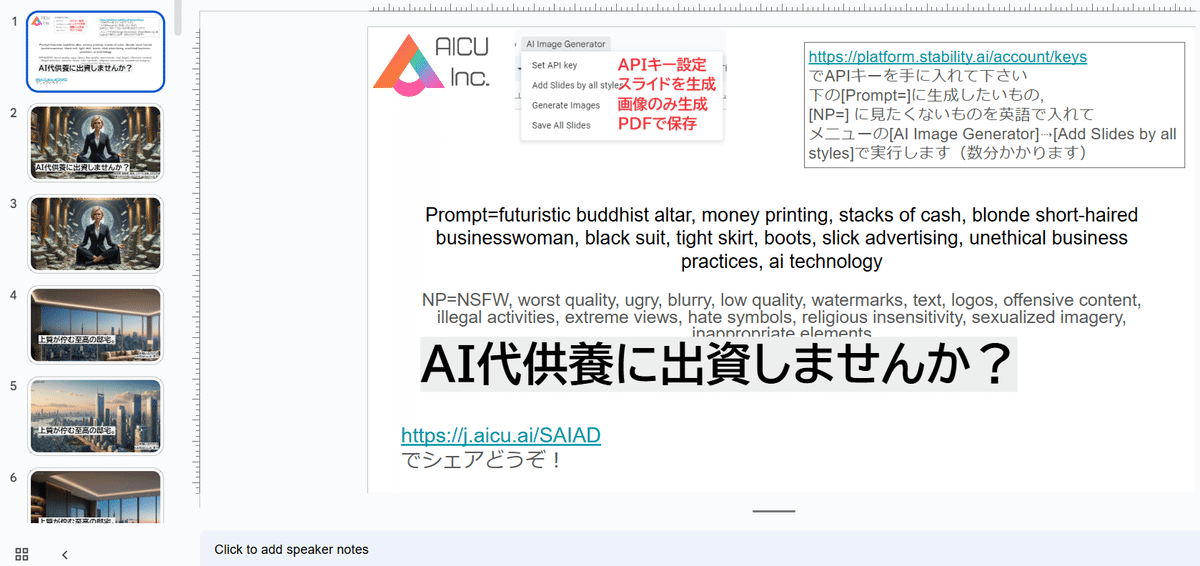

例えばこちらは、Google Slidesでのテストです。

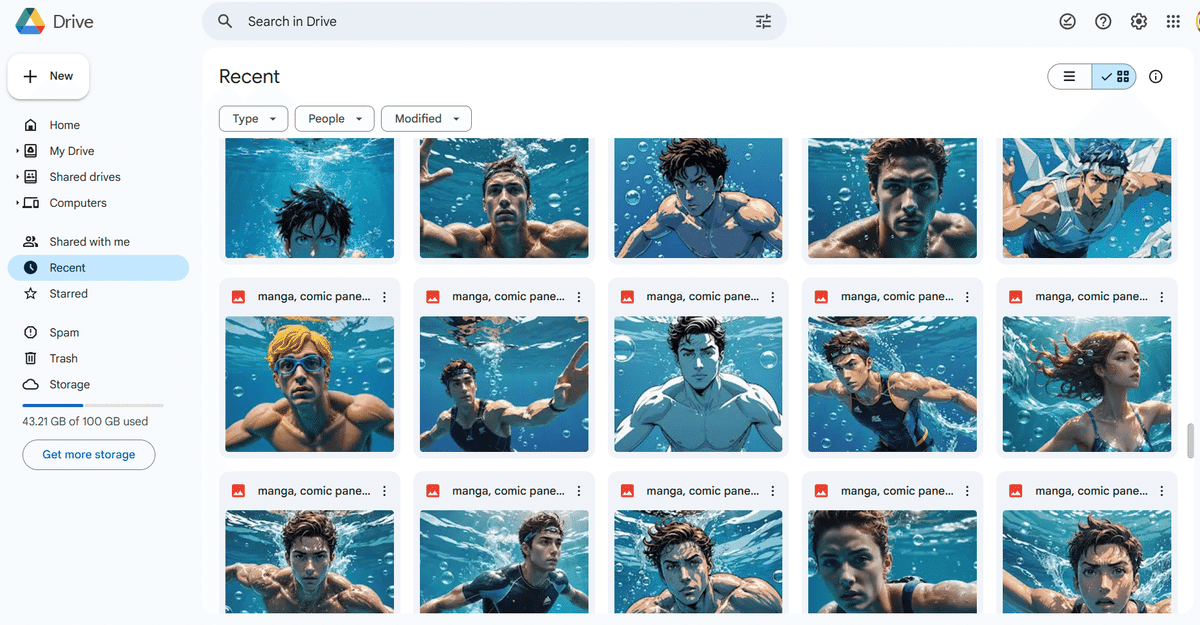

Google Driveに生成された中間生成群です。

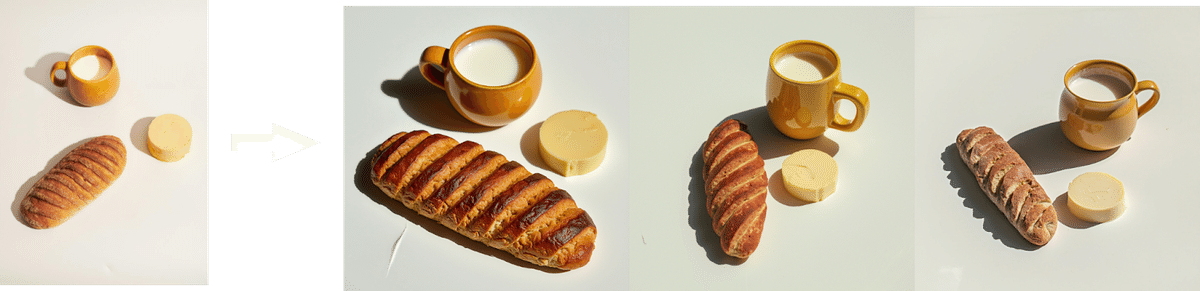

もともと「AIバリエーション広告」(AICU用語で制御高く広告のバリエーションを生成するテクニック、またAIでスタイルを制御しながらA/Bテストなどを準備して入稿するところまでを指すこともあります)のためにStability AIさんの協力でAICUが開発したものです。

実際にお手元のGoogle Slidesでお使いいただけるリンクも紹介します。

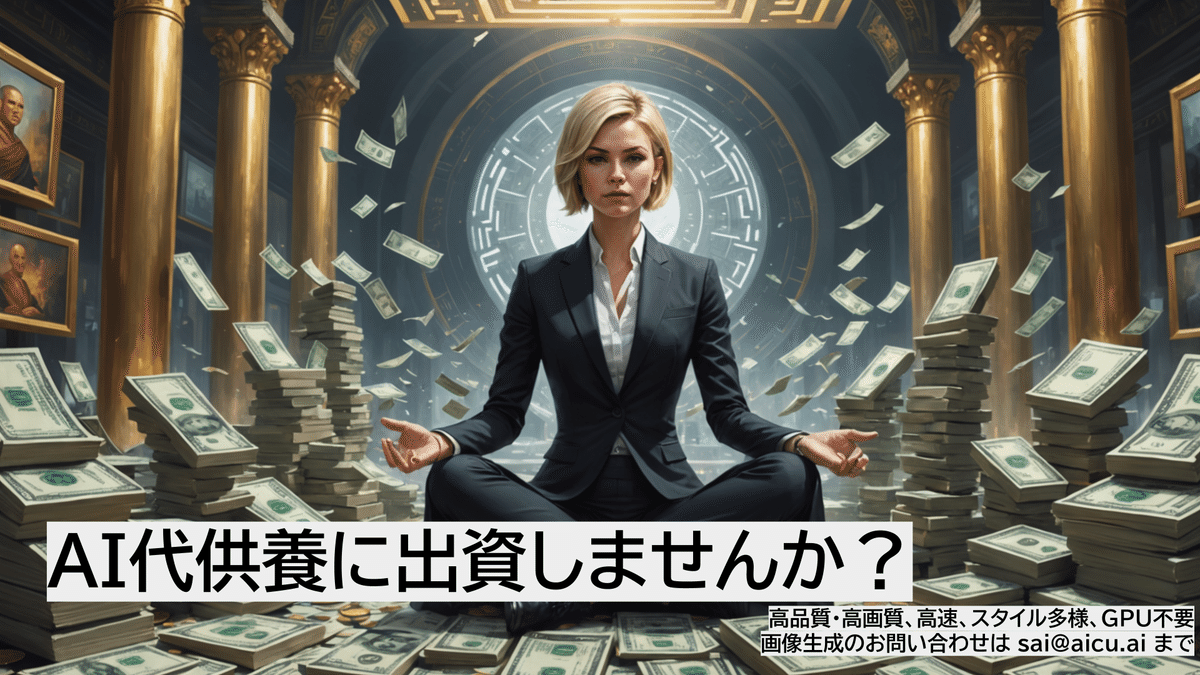

第2テーマは「最新AIツールの広告」

作品「AI代供養に出資しませんか?」、こちらは上記の手法で、Google Slides上でできています。「実況編」にあるとおり、主催の平田茉莉花さんの「AI仏壇」をテーマにキャッチコピーとビジュアルコンセプトを考えたものですが、Google Slidesなので文字のタイプセットやフォント、装飾などもスタイリッシュにテンプレートを作り込むことができます。

処理としても、プロンプトを設定してから数十枚の画像の結果を見るまで、他の処理系や評価に集中できるので、確実に短い時間で、確実に品質の高いアウトプットを、確実に制御性高く出力することができます。

このGoogle Slidesを使ったツール内部はGoogle Apps Scriptで書かれており、一番最初のスライド上の各テキストオブジェクトにプロンプトやパラメータを設定するという風変わりなツールになっています。

これは画像生成AI時代の「ガトリング砲」のような手法であり、プロフェッショナルな画像生成案件において培われたノウハウでもあります。

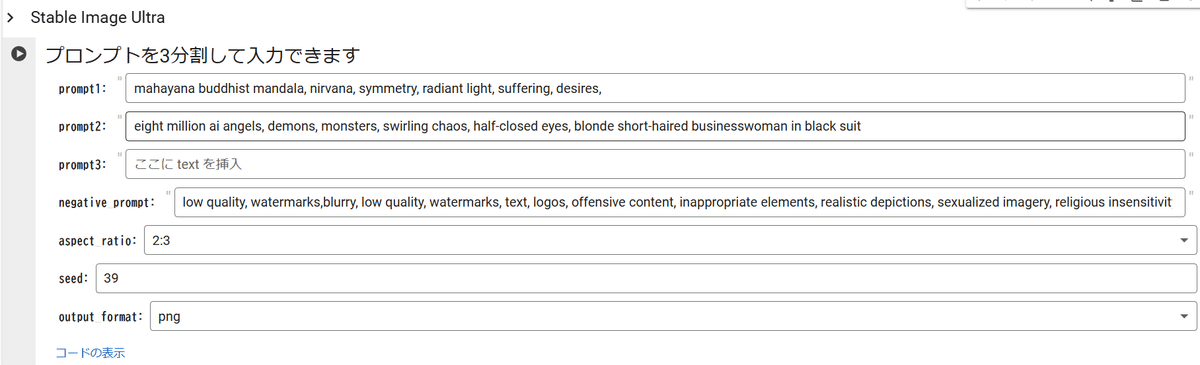

決勝Shot1お題は「ニルヴァーナ」

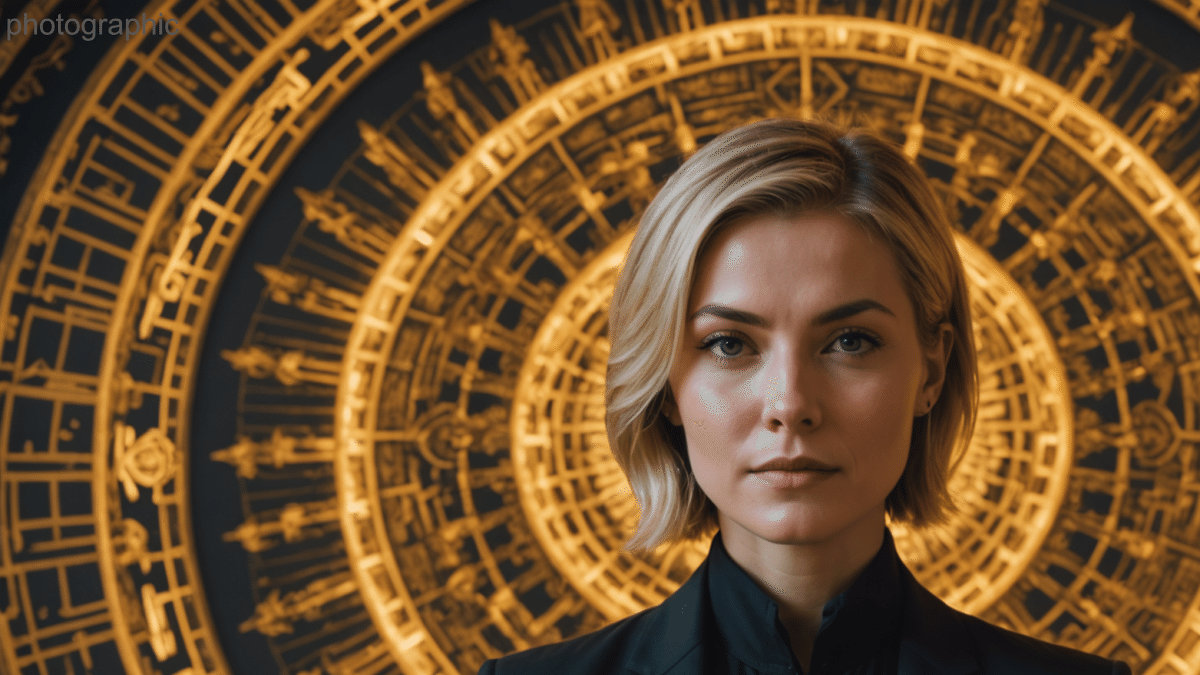

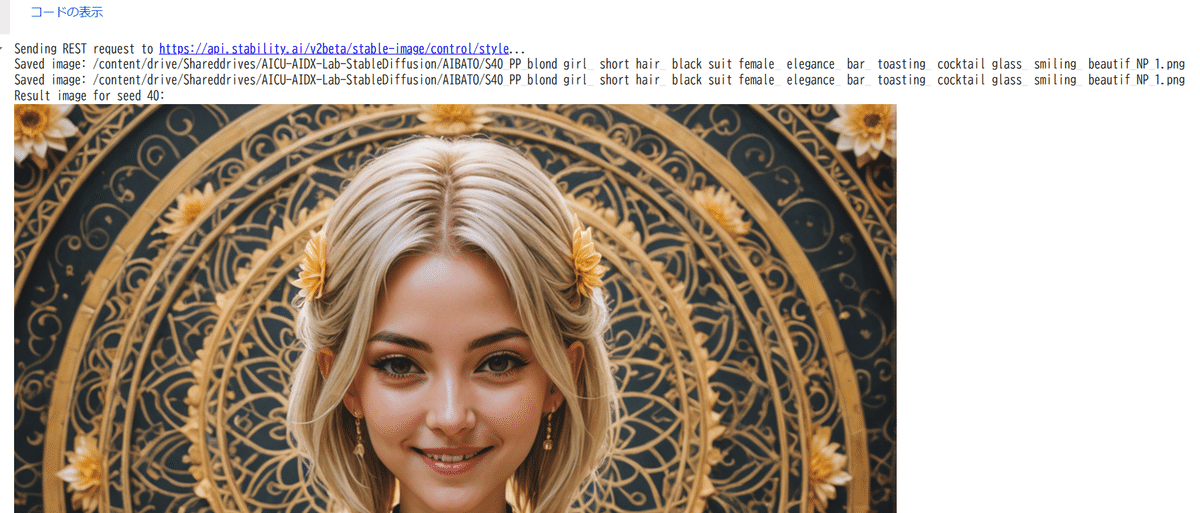

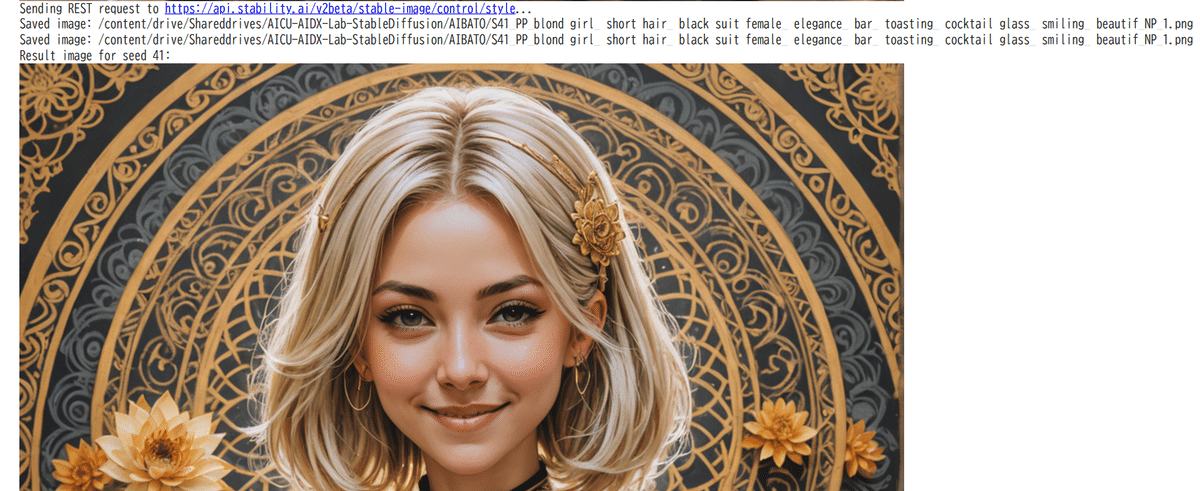

作品「魑魅魍魎曼陀羅」です。同様の手法で作られていますが、仕上げの段階が異なってきます。

AICU-Stability-AdGenerator を使った絵作りの利点として、スライド上での評価が高速に行える点があります。写真を比較して差分を確認して、より良い広告を作るためのノウハウは先に述べたとおりですが、表情やスタイルの違いを横断的に評価できます。またレイアウトも自由に検討できます。

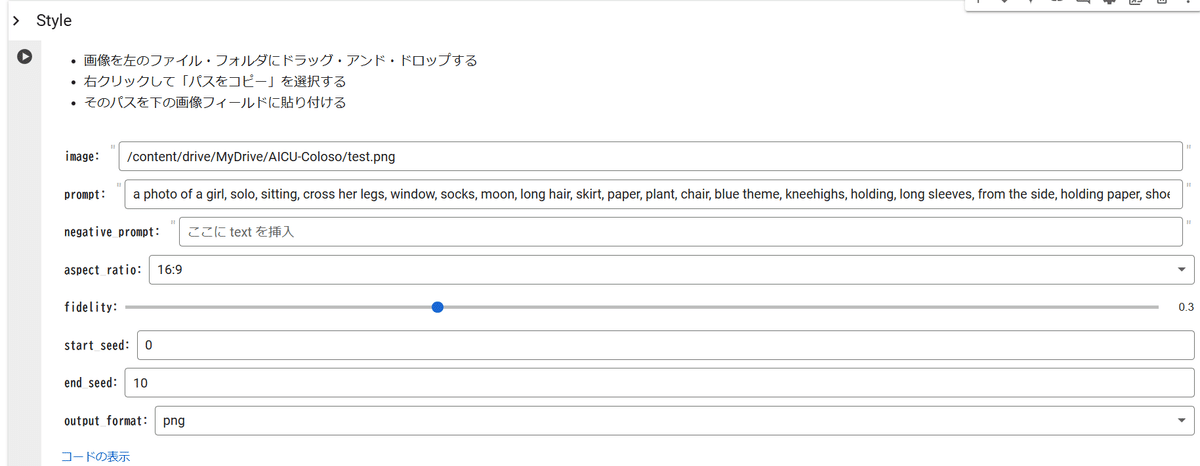

さらにバッチ処理の待ち時間に並行してGoogle Colabを使ったスタイル学習を試しています。

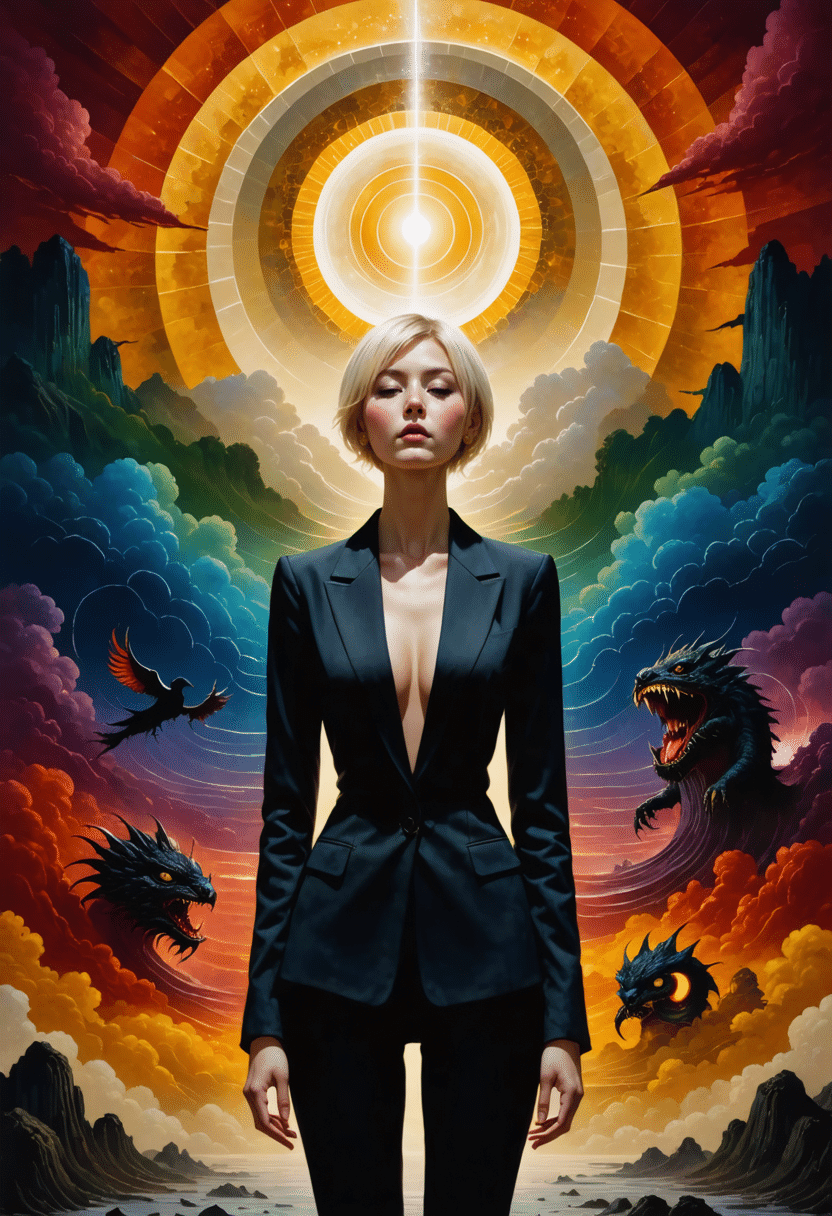

[AIBATO]AICU_Coloso1_Original_Tool.ipynb という Coloso第一弾の購入者向けに開発したツールであり、プロンプトを分割して Stable Image Ultraで生成したり、シードを横断的に指定したり、スタイルを学習させることができます。

例えばこの絵は「ニルヴァーナ感は高いですが、平田茉莉花さんのキャラクターとしては神々しさよりももっと邪悪な狡猾さをきちんと組み込んでいきたいな」といった判断があります。大会レギュレーションに沿うと縦長画像を生成する必要がある一方で、ディスプレイとしては横長であり、PCモニタとディスプレイの色味も異なるので、生成しつつもどちらで勝負するかは考えながら審査表示用の画像やツイートなども準備しています。

ツイートに関しては、勝負を馬鹿にしたり余裕を噛ましているのではなく、「余裕時間や区切りを作っている」というテクニックになります。「時間最後までギリギリにやるぞ」と考えていると、画像生成にかかる時間を逆算できなくなりますので、「最後はツイートまでするぞ」と保存やツイートにかかる時間を逆算しつつ、タイムスタンプとしての時系列を記録しています。また後ほどこの原稿のようにタイムラインを振り返るためにも必要な行為です。こうして、制御性の高いプロフェッショナルの絵作りノウハウが積み重ねられていく、以上が解説になります。

最終テーマは「背水の陣」

以上が基本テクニックです。エンターテインメントとしての生成AIアートバトルを意識して、これまで作ったプロンプトを合体させつつ斬新なコンセプトやウィットの利いたジョークをキャッチコピーと画像のコンセプトに忍ばせつつ、品質の高い制御された絵作りをツイート込みで続けていきます。

最終テーマは「背水の陣」ですが、ここでゼロからの絵作りを勝負するのは良い戦法ではありません。審査員も観客も、すべての手の内を見ておりますので、目も肥えてきます。隠し武器はたくさん持っているのですが、文字通り「背水の陣」であれば、いままで使ってきたテクニックだけでより完成度の高い統合や、世界観、広告としてのエンゲージメントを勝ち取らねばなりません。

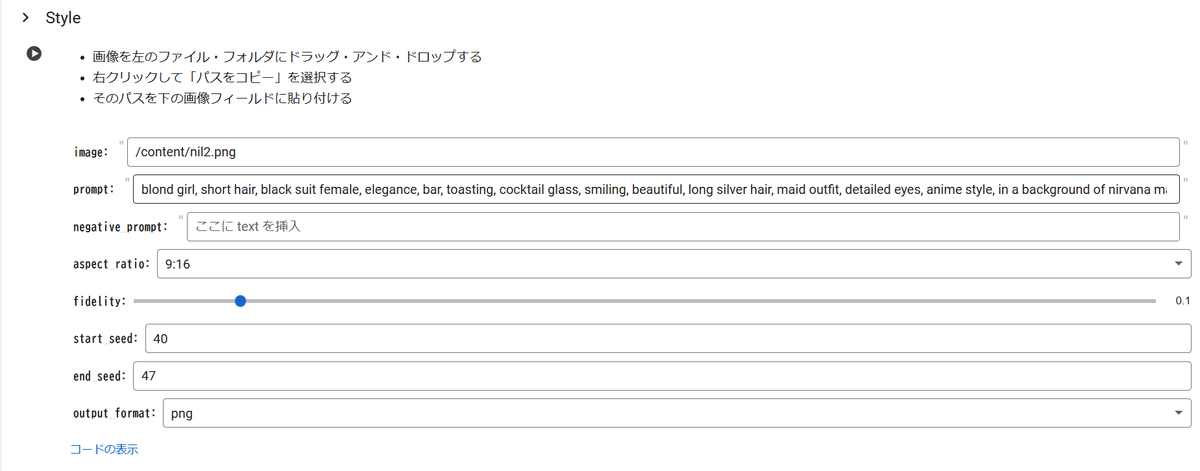

特に世界観を支える背景や、キャラクターデザイン、それを支えるモデルやシードは運ではなく、開発して錬成して制御していく要素なので、短い時間で緊張感のある現場ですが、丁寧にログが残る形でGoogle Colabノートブックで生成しています。

リクエストはREST APIによって行われ、繰り返し構文「For」を使ってシードやフィデリティパラメータを調整していきます。ファイル名にプロンプトやパラメータが残るようになっています。

一見余裕を噛ましているように見えますが、こういうときは「この系は一旦終わりにしよう」という意味でもあります。

息を吐くようにツイートし、写真や漫画やイラストレーションなどで経験があるしらいはかせならではの行動かもしれませんが、絵師さんがツイートするときも同じような気持ちの切り替え行動をしていると想像します。

なお、表情の探求についてはプロンプトとスタイル制御で行います。このあたりは細かいところはColoso動画で紹介しています。

これは「半目閉じ」を指定しつつ、背景に魑魅魍魎が足りなかった、また曼荼羅としての方位を示す要素が甘かった、などで没になった画像です。このような画像の評価もGoogle Colabは便利ではなく、Google DriveやSlidesを使うように連携しています。

最後の方は秒単位まで集中していますので、コピーライティングとしての文字や漢字のトンマナ調整、レイアウトなども整理させていただくとこんな感じになると思います。これもGoogle Slidesでの作業です。

以上が主なツールや技術の紹介になります。

Coloso第一弾企画の復習ですね!

本当に良い講座なので、幅広い人にみてもらいたい。

作品の文字なしクリア素材や中間生成物、ツールなどについては有料パートに置かせていただきます。

ここから先はAICUマガジンの特集の方で公開していく予定ですが、ご質問等はコメントいただけましたら、解説を拡充していきたいと思います。

以上ご報告でした。

今後ともAICU mediaをよろしくお願いいたします。

寄稿・生成AIクリエイター しらいはかせ (@o_ob)

この記事の続きはこちらから https://note.com/aicu/n/n26c3001b2b13

Originally published at https://note.com on Nov 26, 2024.