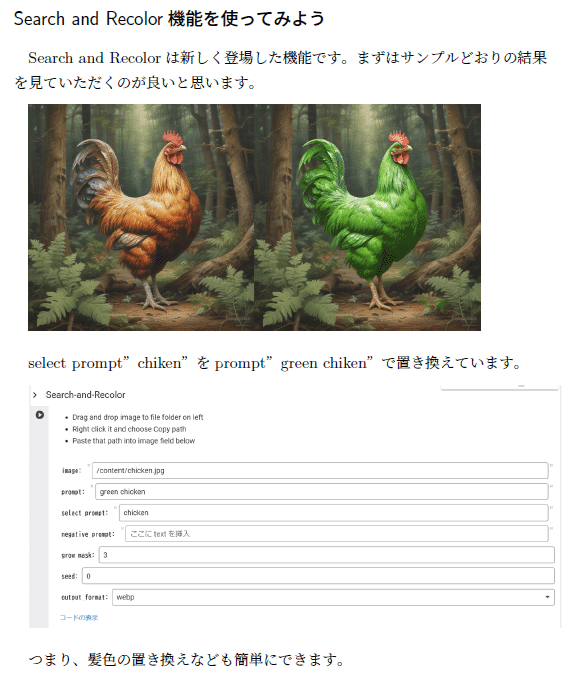

「AIの現物展示をしよう」

「なんかいい」という、「曖昧で深い言葉」、なにか心に引っかかる。

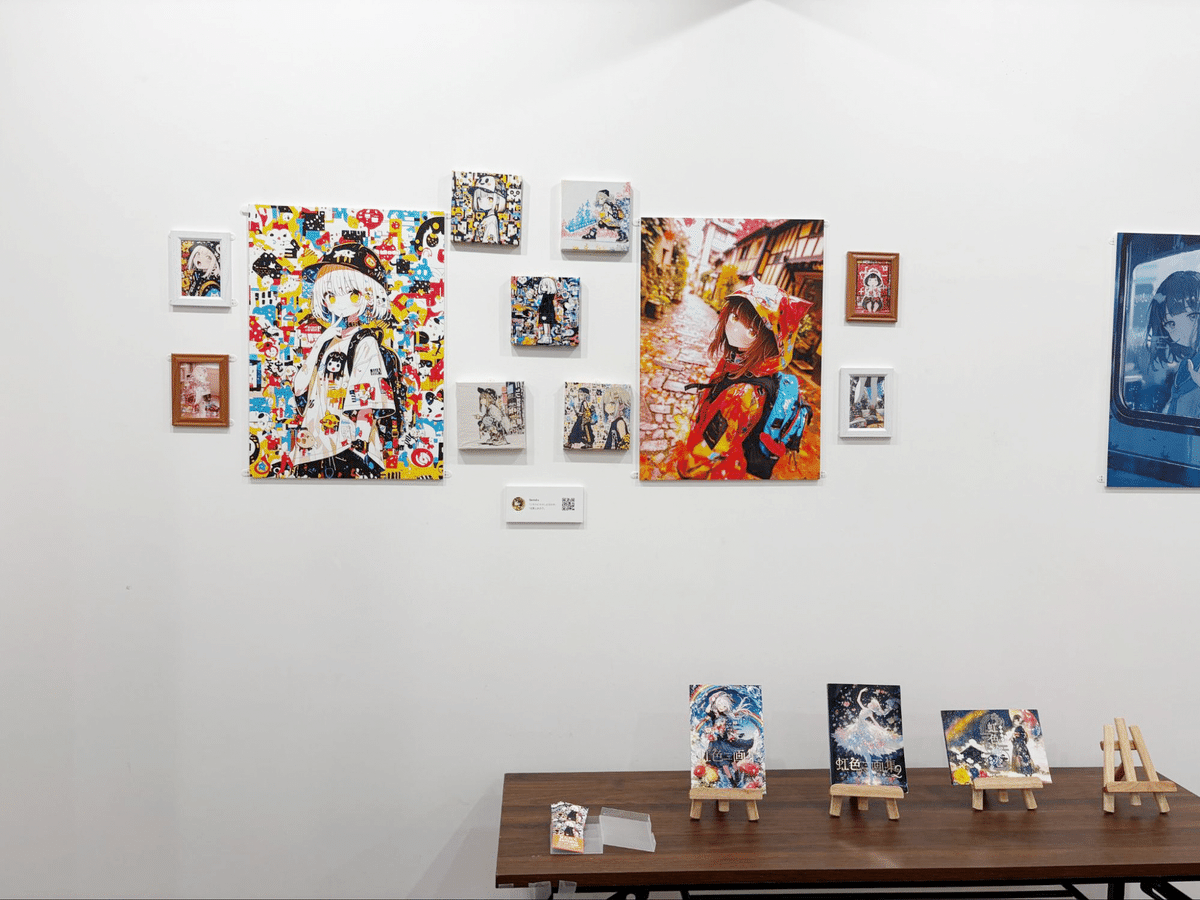

6人のAIイラストレーターが集まって、「なんかいい展」が2024年10月26日に開催されました。

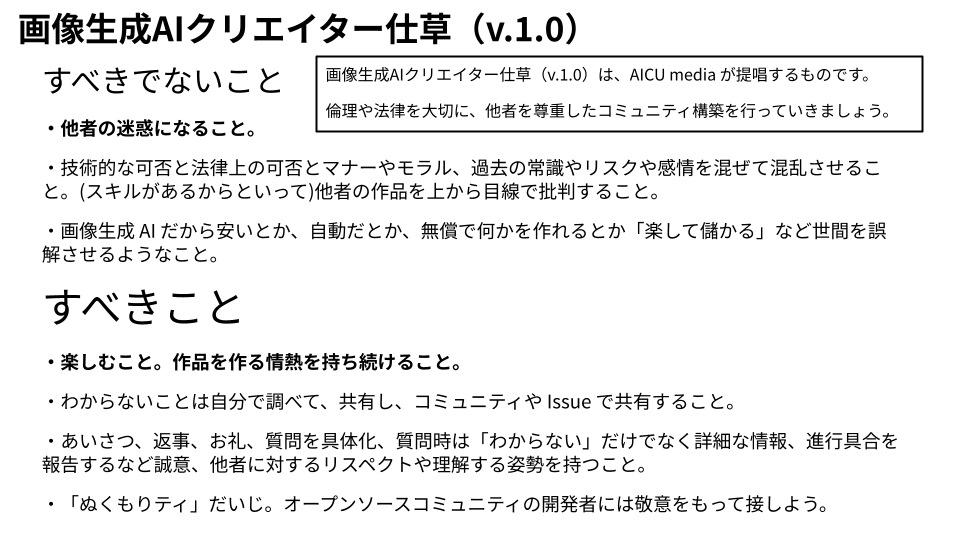

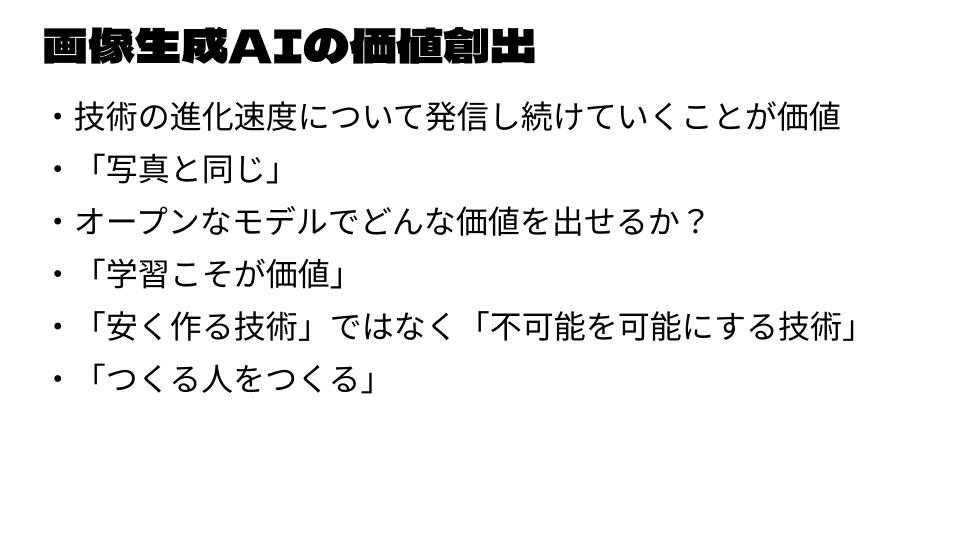

「つくる人をつくる」をビジョンにするAICUでは開催を応援する意味で、参加クリエイターにロングインタビューを実施しました。

各クリエイターの作品や、次回の開催についての情報もあり!

最後まで味わってお読みください。

参加クリエイター3名に1時間半のロングインタビューを実施しました。

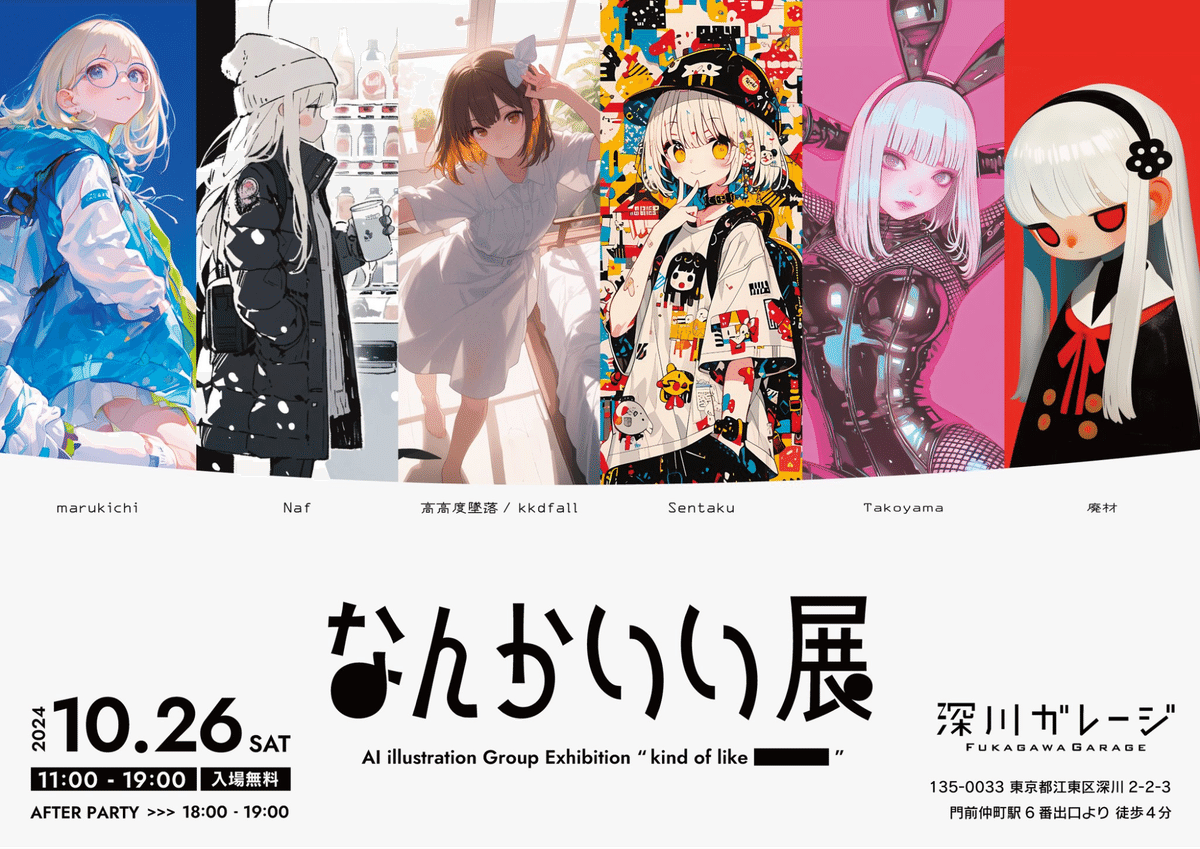

「なんかいい展」

AI illustration group exhibition “kind of like ******”

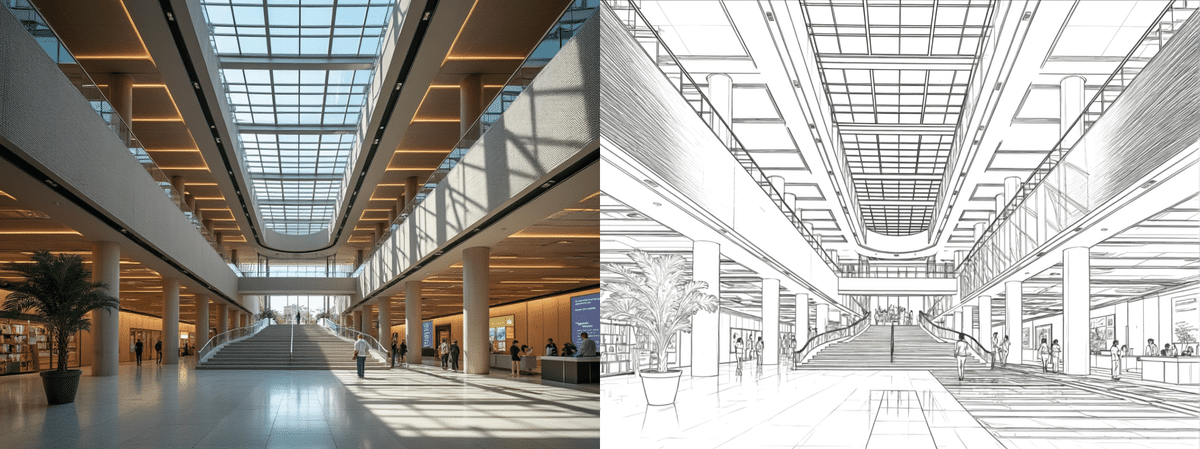

東京の門前仲町で、2024年10月26日に1日だけ開催されました。

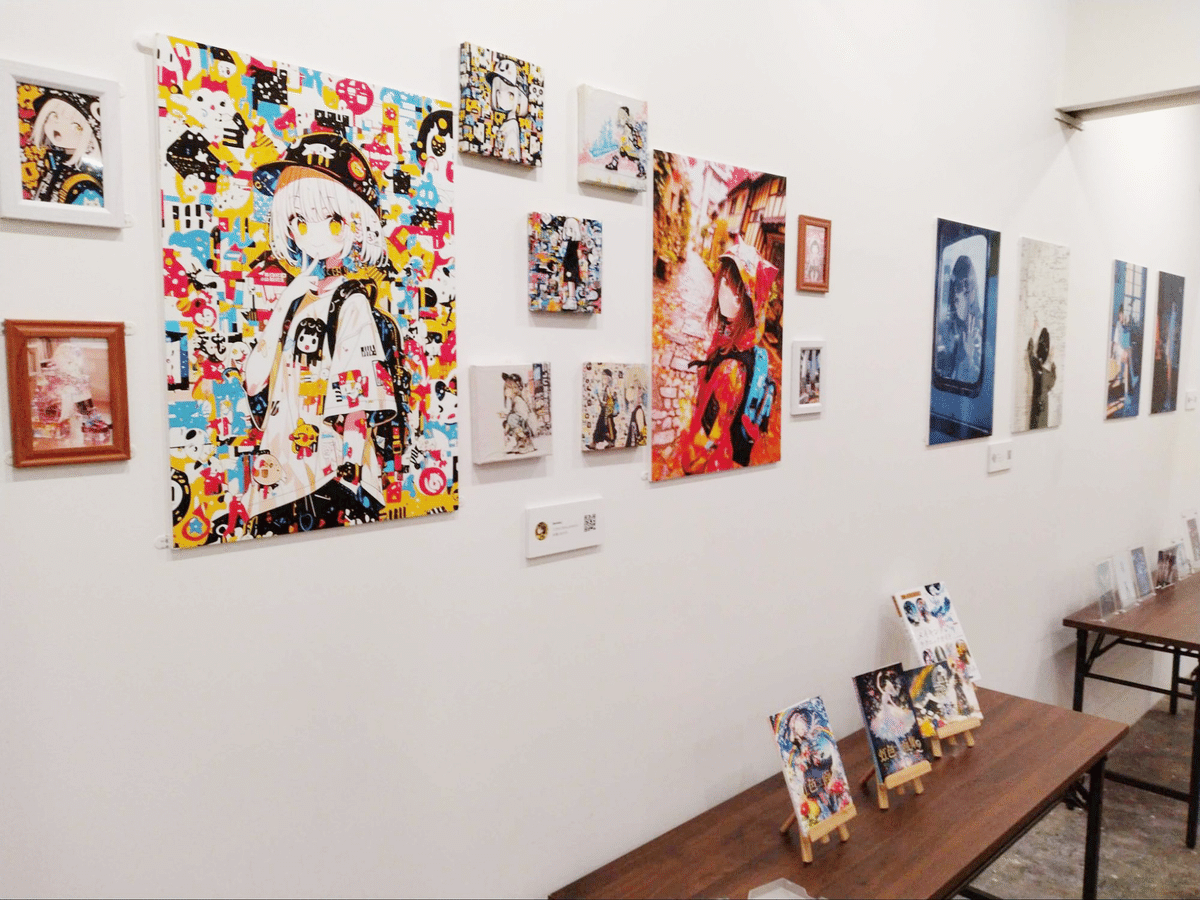

いままで大きな企業や展示会でしか企画されていなかったAI画像祭といった企画を「最初はミニマムに」ということで深川ガレージさんをお借りして小規模に実施したかった、ということです。

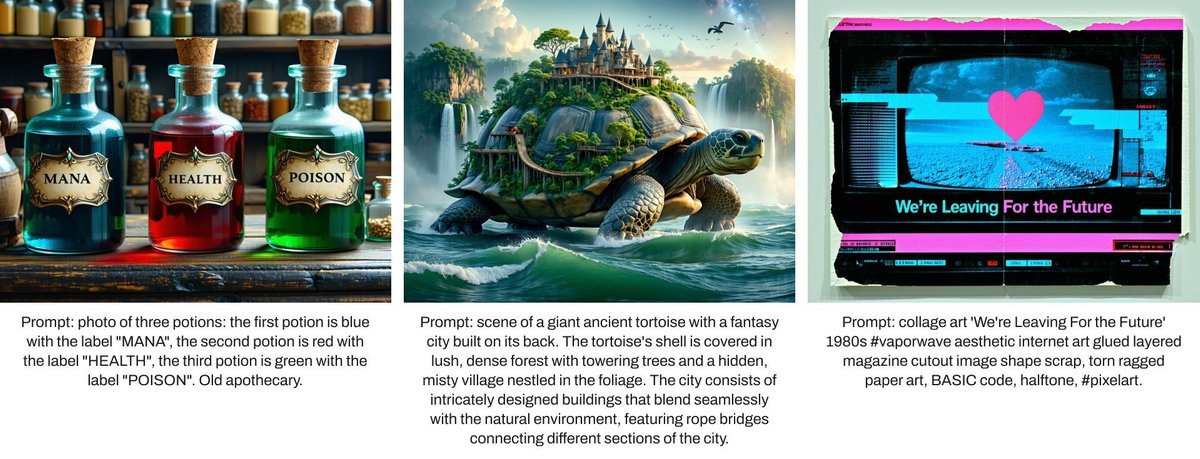

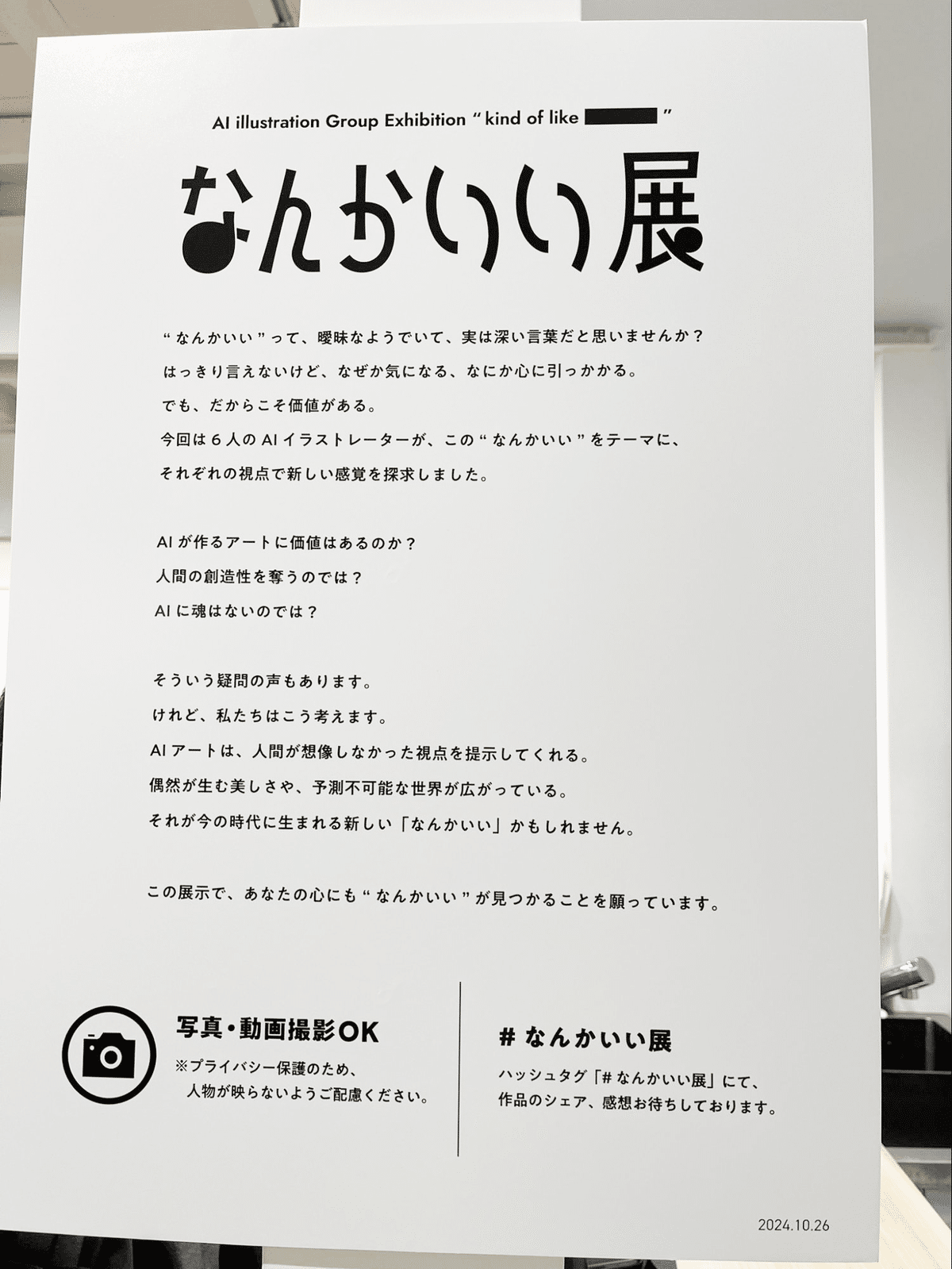

素敵なウェルカムボードをご紹介。

”なんかいい”って、曖昧なようでいて、実は深い言葉だと思いませんか?

はっきり言えないけど、なぜか気になる、なにか心に引っかかる。

でも、だからこそ価値がある。

今回は6人のイラストレーターが、この”なんかいい”をテーマに、

それぞれの視点で新しい感覚を探求しました。

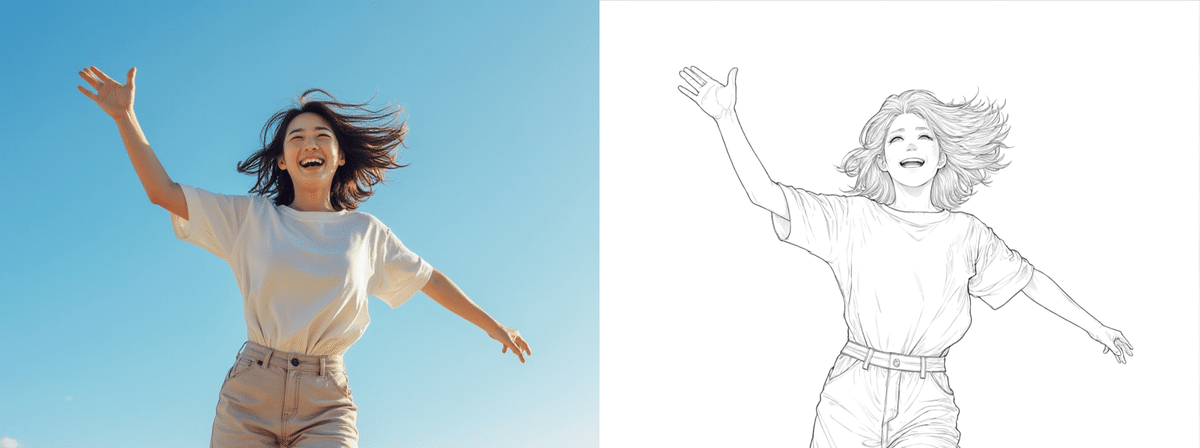

AIが作るアートに価値はあるのか?

人間の創造性を奪うのでは?

AIに魂はないのでは?

そういう疑問の声もあります。

けれど、私達はこう考えます。

AIアートは、人間が想像しなかった視点を提示してくれる。

偶然が生む美しさや、予測不可能な世界が広がっている。

それが今の時代に生まれる新しい「なんかいい」かもしれません。

この展示で、あなたの心にも”なんかいい”が見つかることを願っています。

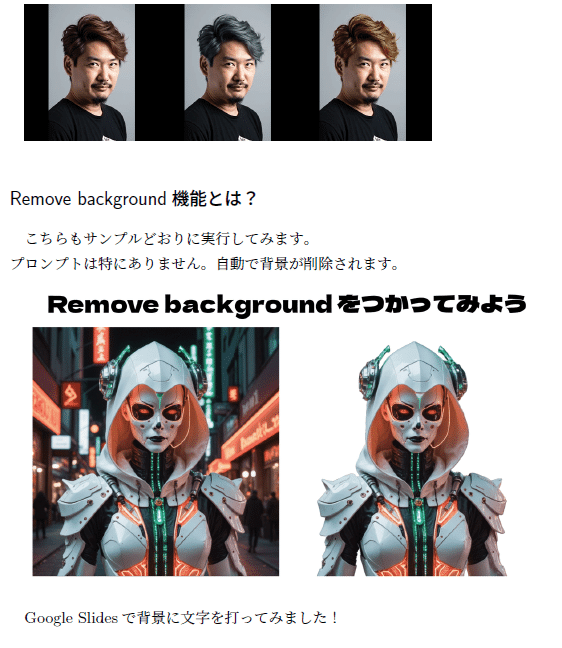

【メンバーの紹介】

集まったメンバー6人は、Sentakuさんの呼びかけにより、SNSもしくはdiscordコミュニティで集まってくれたそうです。

Sentaku(せんたく) さん

Xアカウント:@sentakusound

https://x.com/sentakusound

廃材 さん

Xアカウント:@haiz_ai

https://x.com/haiz_ai

marukichi(まるきち) さん

Xアカウント:@marukichi667944

https://x.com/marukichi667944

☆今回のインタビューに参加できなかったメンバーさんからは、メッセージ・プロフ、作品展示写真をご許諾とともに頂いております。

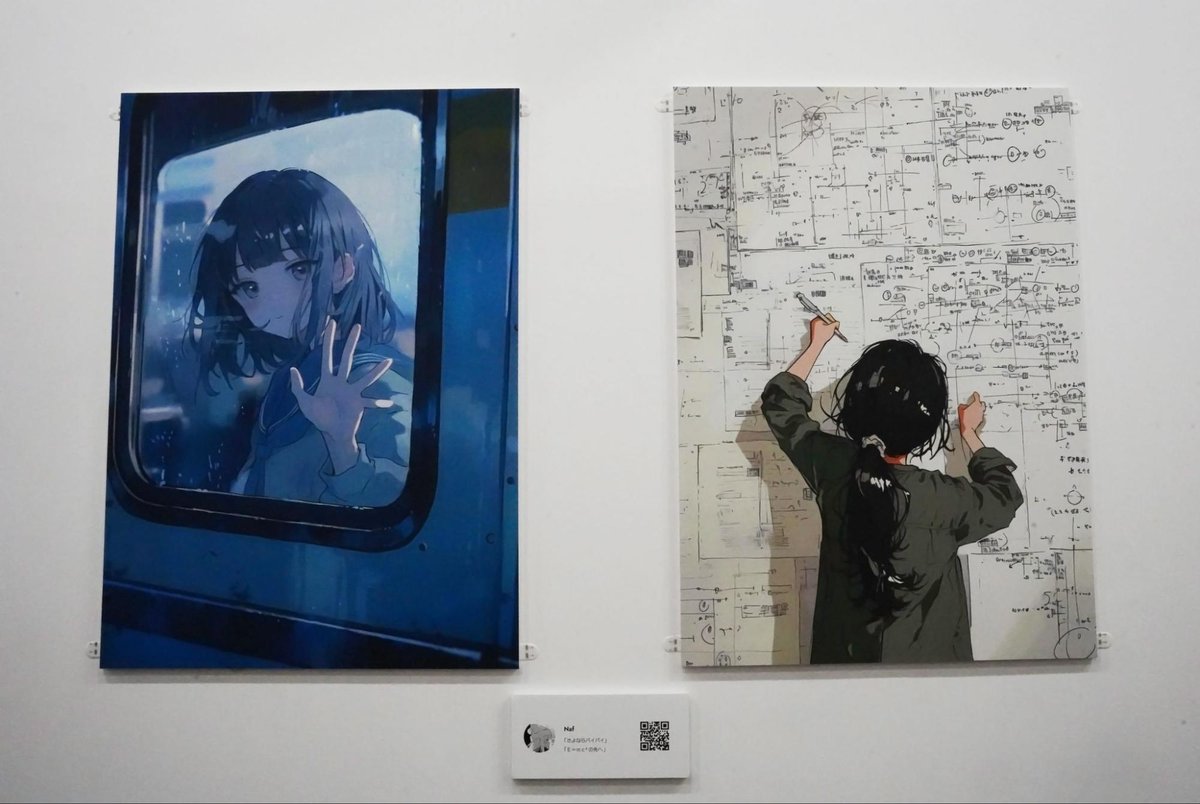

Naf さん

アカウント:@naf_aiart

https://x.com/naf_aiart

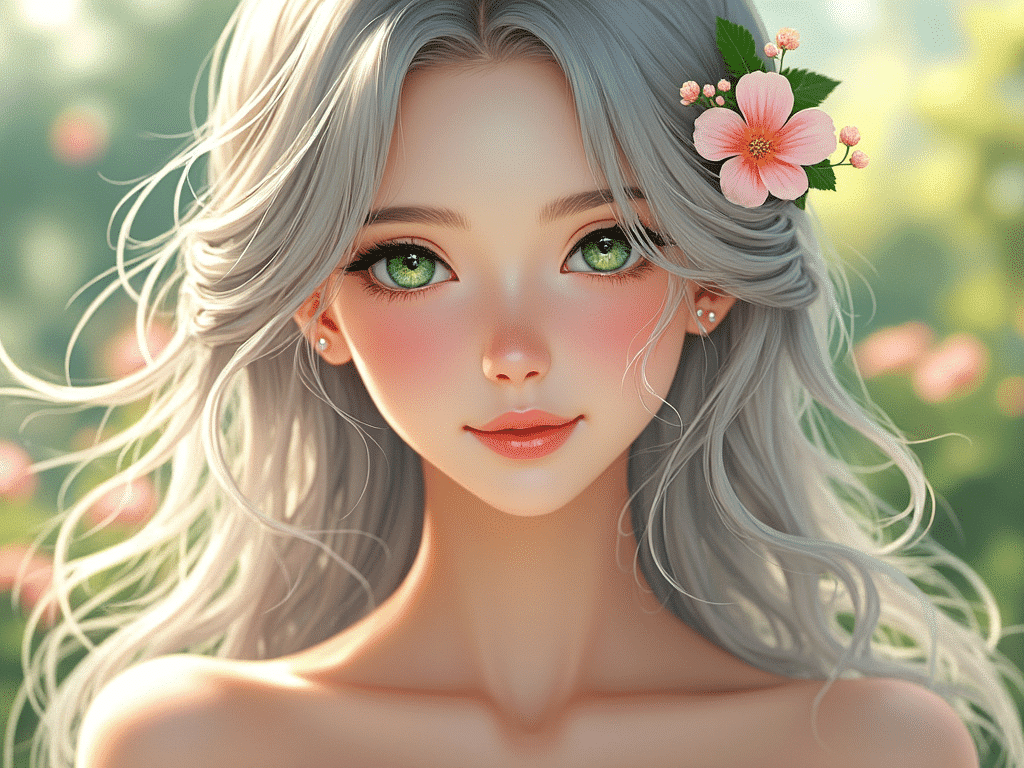

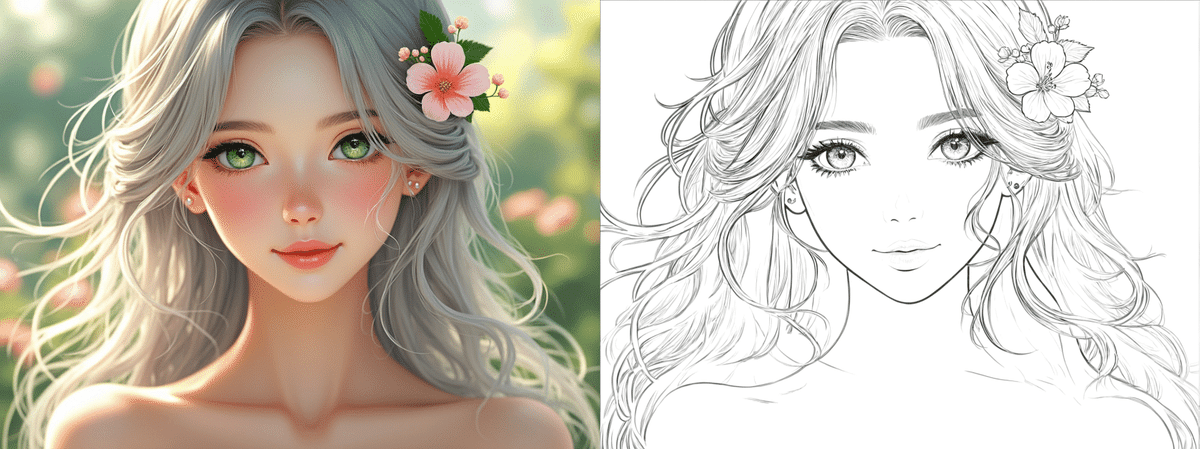

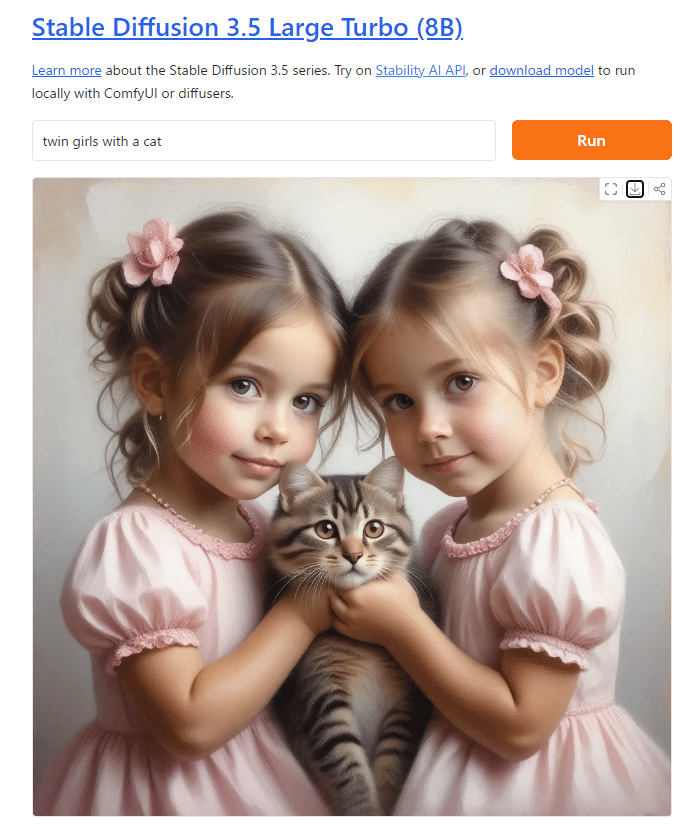

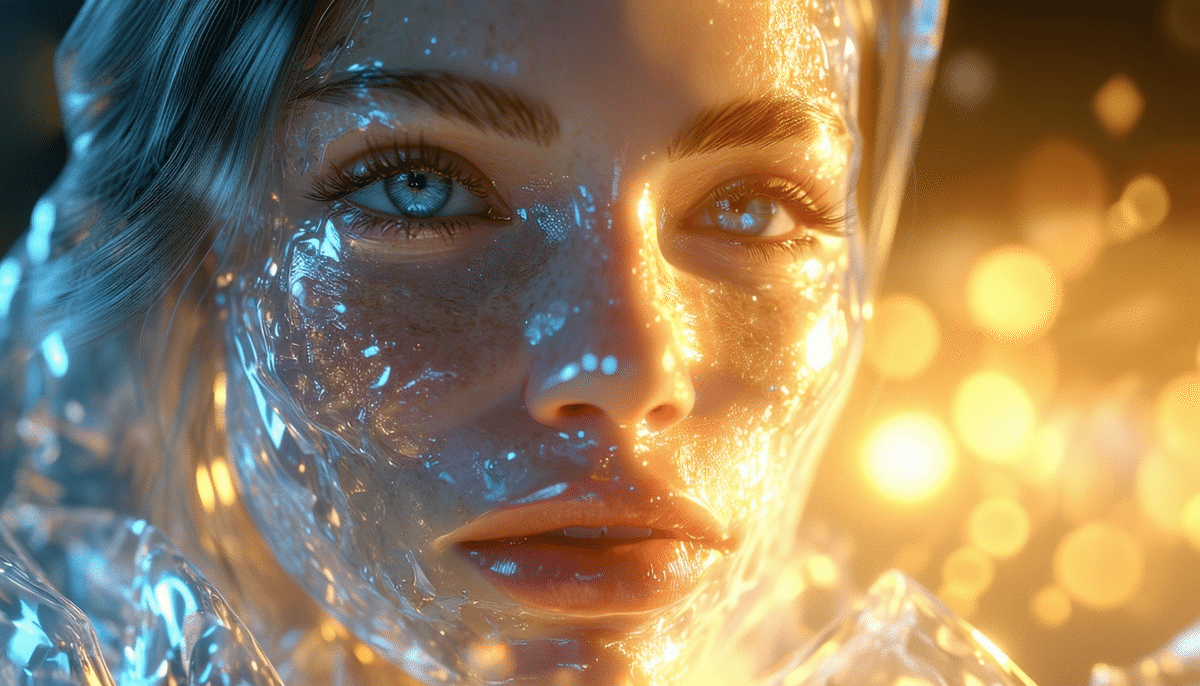

【Naf】

初めまして、Nafです。

AIを使ってイラストを生成しています。

少女というキャラクターを通して

その場の空気や温度を感じられるような

作品を作りたいと思っています。

人には色々な感情があって

背景には必ずその理由があります。

皆さんの目に触れた時に

心に残る何かがあれば幸いです。

高高度墜落/kkdfall さん

アカウント:@kkdfall

https://x.com/kkdfall

【高高度墜落/kkdfall】

aiをツール化したい墜落さんです。あの日見た景色から落下しています。

日常の少し隣にある瞬間を捉えたいと考えて取り組んでいます。

Takoyama さん

アカウント:@takoyama9zo

https://x.com/takoyama9zo

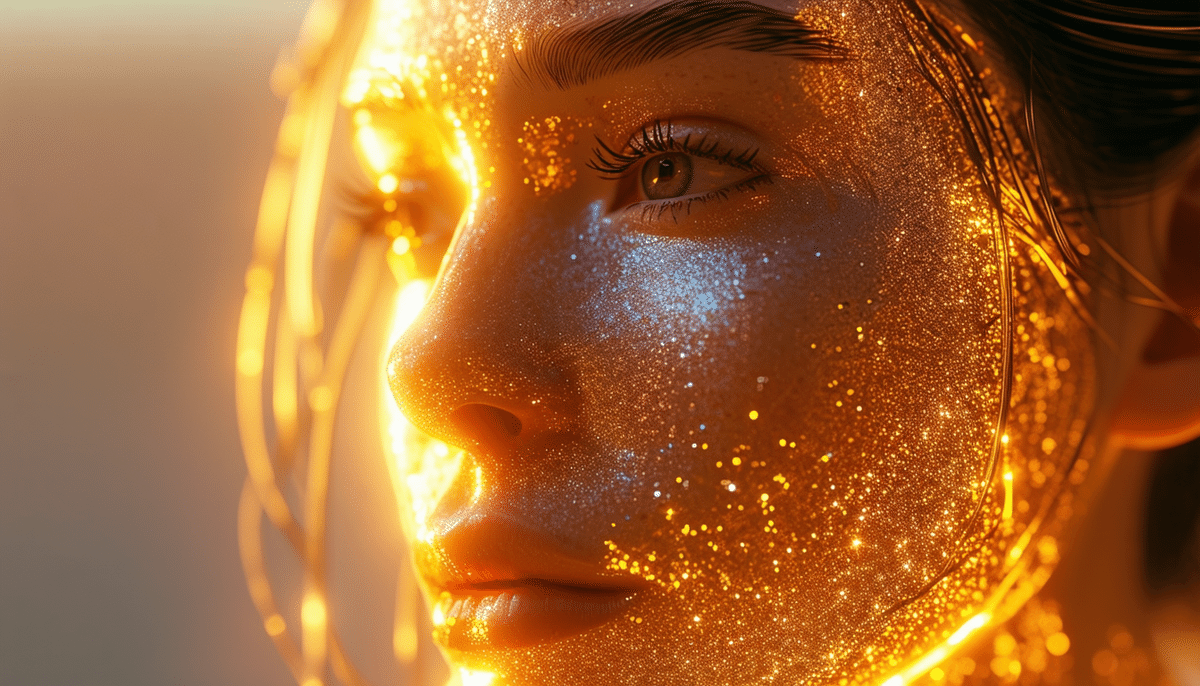

読者のみなさま、はじめましてTakoyamaです。

私は色彩とアルゴリズムの交差点に身を投じ、コードと創造が交わる場所で美しいなにかを見たいと願い、日々模索しています。

AIが考える命の美しさが何かの拍子に現れたらいいなと考えています。

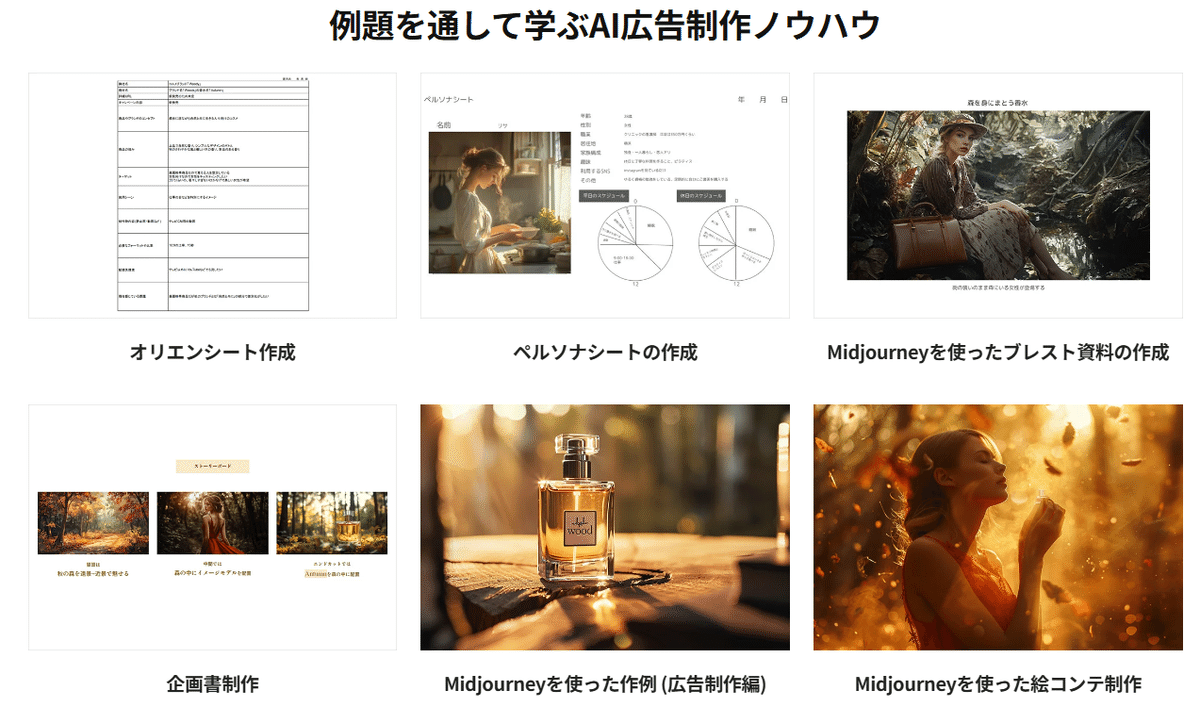

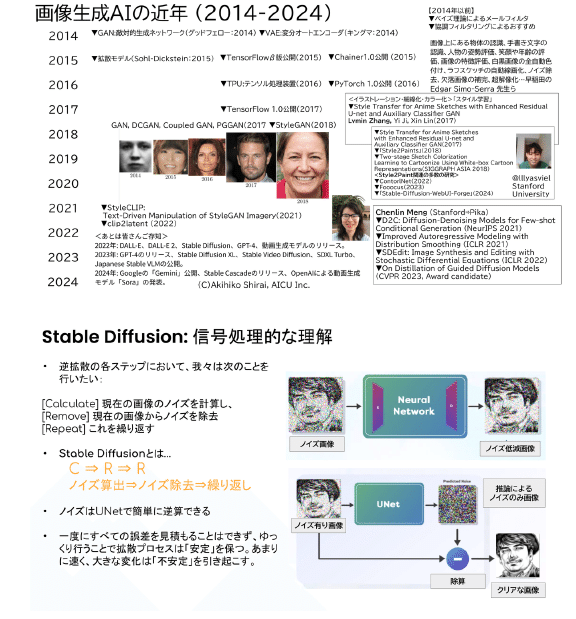

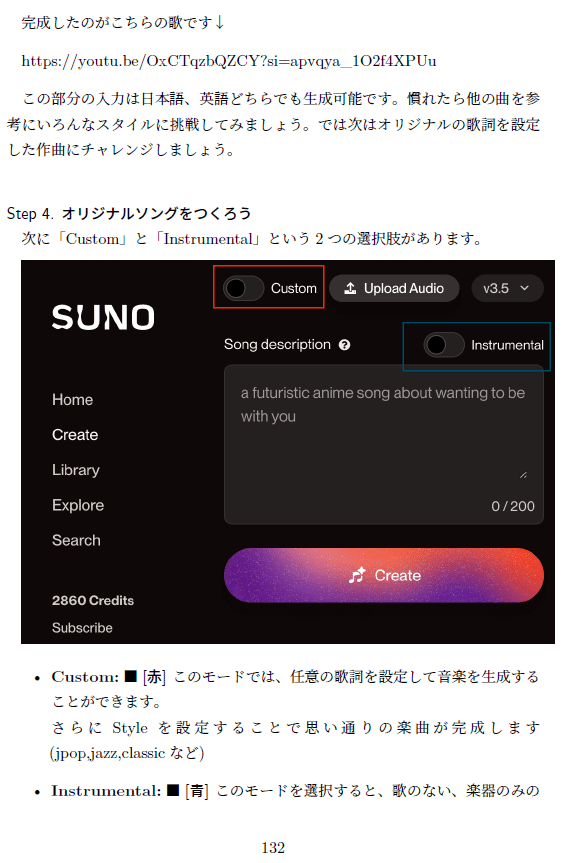

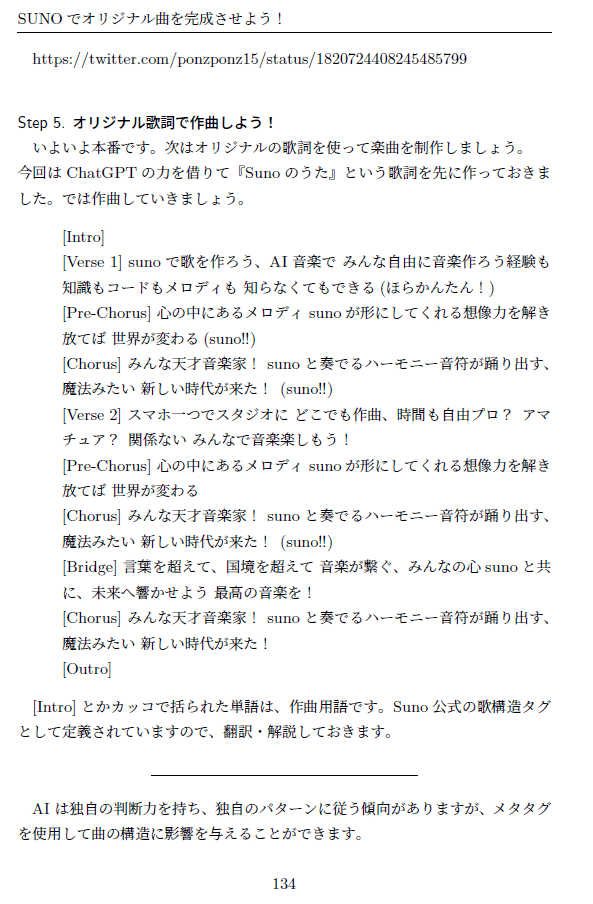

【どうして「なんかいい展」を開催したの?】

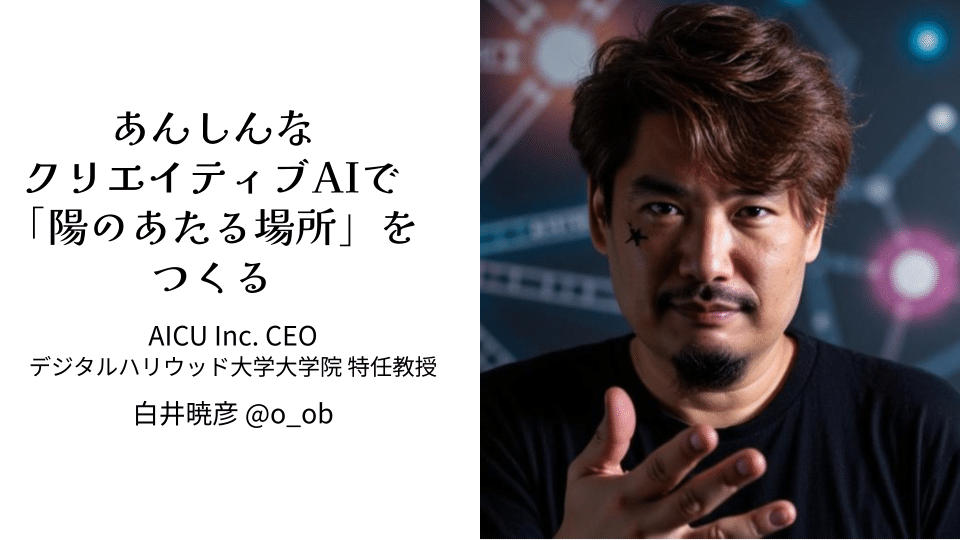

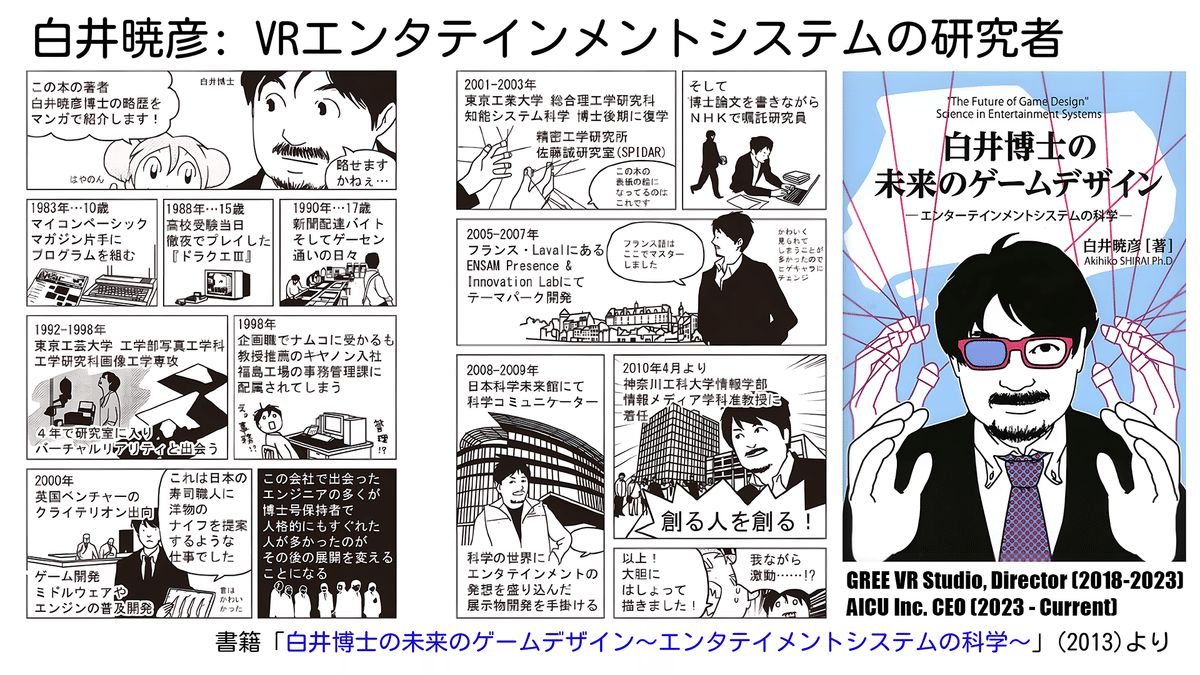

――インタビュワーのAICU media編集長・しらいはかせ です。このたびは「なんかいい展」のご開催おめでとうございます。まずは普段どんな活動をして、何を考えているのか、また何故「なんかいい展」を開催したのかについてお聞かせください。

Sentaku「みんなに会って話したい」

――今回のグループ展の発起人となったSentakuさんですが、どういうモチベーションだったのでしょうか。

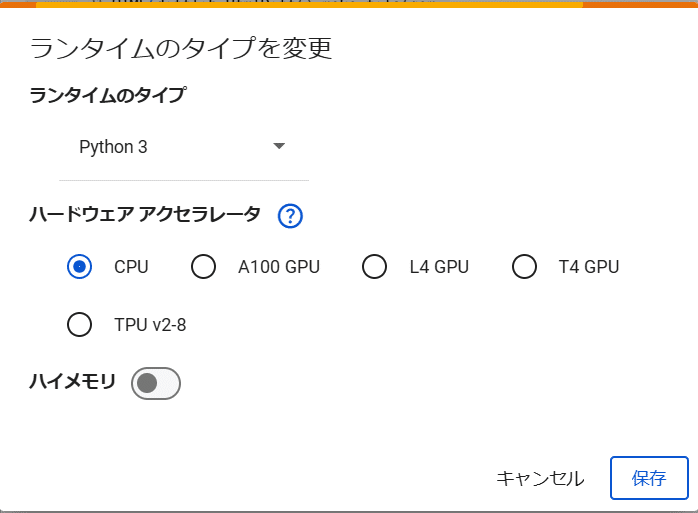

Sentaku:ふだんはテレビ業界のサウンドデザイナをしています。けっこうAIは、この仕事と近いところがあって、自分は「サウンドデザイナーをしているけど楽器はできない」という人材なんです。AIでイラストレーションを作っていくのもとても似ているところがあって。仕事はいつもクライアントワークなので「自分を表現するところが欲しい」とおもってAIアート活動をはじめました。最近は「みんなに会って話したい」、「コミュニティとしてみんなに会ってみたい」と思って企画しました。

――その芽生え……。なるほど興味深いです。楽器とかも結局そうなんですよね。演奏するっていういわゆる演奏家の人がいたとしても、楽器を上手に扱えるか 扱えないかみたいなところの軸も当然あるし、さらにそのお客さんに対しての「商品性がある演奏」とか「楽曲などがやれるかどうか」みたいなところの軸もあって……。運よくそのテレビ業界で生業になり糧なりを得ているんだけれども、やはり「表現したい」、「自分の考えたことを表現したい」と思った、と。道具を使いこなして演奏するみたいなところから、画像生成 AI の演奏家として、ひとりひとりのクリエイターとして成立していて、さらにそれが「他の人たちに会いたい」、「作品を通して人に会いたい」っていうモチベーションに育っていったってことなんですね 。

marukichi「自分の好きなものに”手綱”をとってもらう」

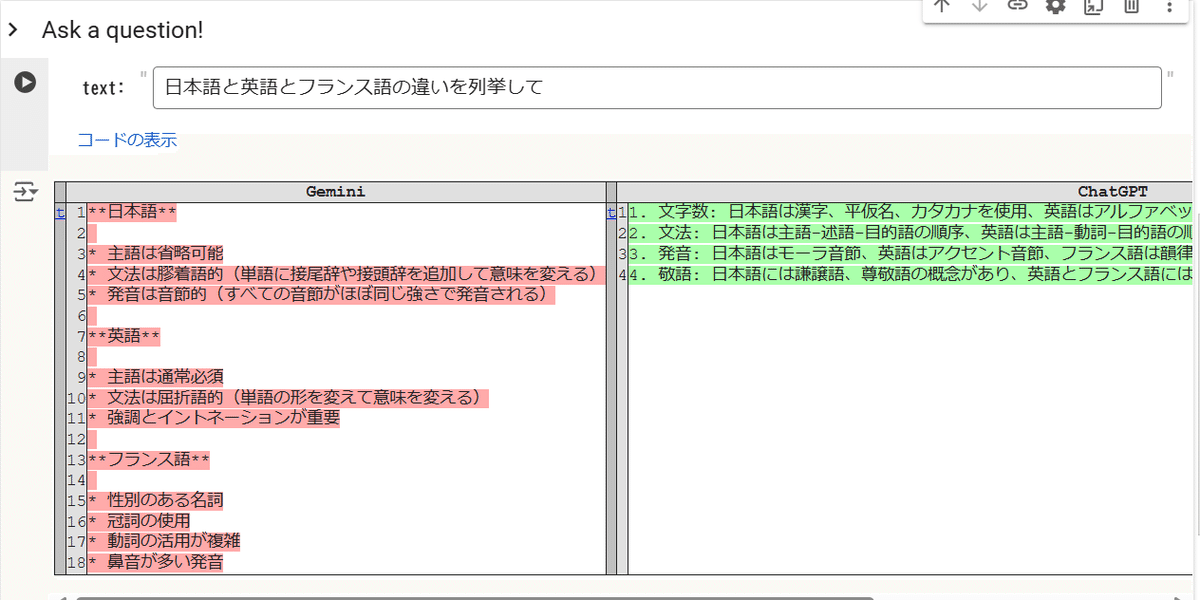

marukichiです。普段はIT系でカスタマーサクセスを担当しています。イラストレーションは我流ですが、画材を使って描いたり、立体造形、工芸などをやってきました。AI画像生成とは MidJourney を2022年夏頃から触っていて、デザイン関係でロゴとかを作ったりして「時短ツール」として使って来ました。いままで作ってきたもの、表現できるようになってきたこともあり、X(Twitter)で公開し始めたのは2023年の7月ぐらい。最初はジャンル問わず出していたのだけど、ここ半年ぐらいは「青とメガネ」にこだわっています。

――「最初はジャンル問わず出していたのだけど」ということなんですが、「AIアートならではのスランプ」みたいなのに入ることってありますよね。なんでも出せちゃうし、みんなとの差も生まれづらいですし。

marukichi:そうなんです。「自分の好きなものに”手綱”をとってもらう」という感じです。

――たしかに、その「好きなものドリブン」って大事ですよね。AICUの所属クリエーター・犬澤某さん(@insbow)も「(個人作品では)オーバーオールを着た犬しか描かない」って言ってシバリを入れてますし、そういう「制約」って、クリエイターにとってはとてもいい挑戦になるんですよね。

廃材「”AIイラストレーター”という表現にも、複雑な想い」

――廃材さんは、どんな活動をされてきたのですか?

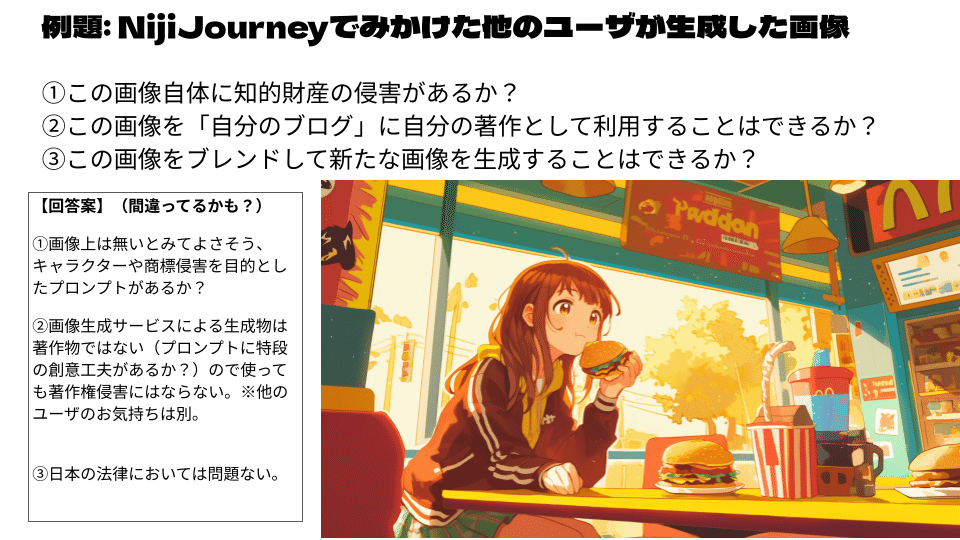

廃材:AIの流行が始まってすぐの頃は、叩かれがちだったり、著作権問題だったりが、重くありました。

その中で自分としては「クリエイティブをネットに廃棄していく」というスタンスで活動してきたんです。いわゆる『AI絵師』と自分は違う、「廃材」として。でも『捨てている』というスタンスを取っている反面、魂を込めて作品を作っているので、『どこかの誰かの心に触れてほしい』という気持ちも長く持ち続けてきました。「なんかいい展」というグループ展を通して、それを感じてみたいと思いました。”AIイラストレーター”という表現にも、複雑な想いがあります。

――いいですね!とても複雑で、いいと思います!AICU mediaも生成AIでの発信活動を2年ぐらい続けて来ましたが、商品としてパブリッシングを行うメディアによって「AI画像生成を”描く”と表現しない」とか、セミリアル、フォトリアルのみを扱い「イラストレーションを扱わない」といった制約を行ったメディアもあります。でも、社会との対話を作品を通して行いたい、という気持ちが芽生えていく姿はとても尊いですね。

【やってみて、どうだった?】

「なんかいい展」は「見に来る人もお金がかからないように」ということで、「来場無料、グッズ販売などもなしで」、というコンセプトで実施されたそうです。

――制作の過程での苦労などをお聞かせください。

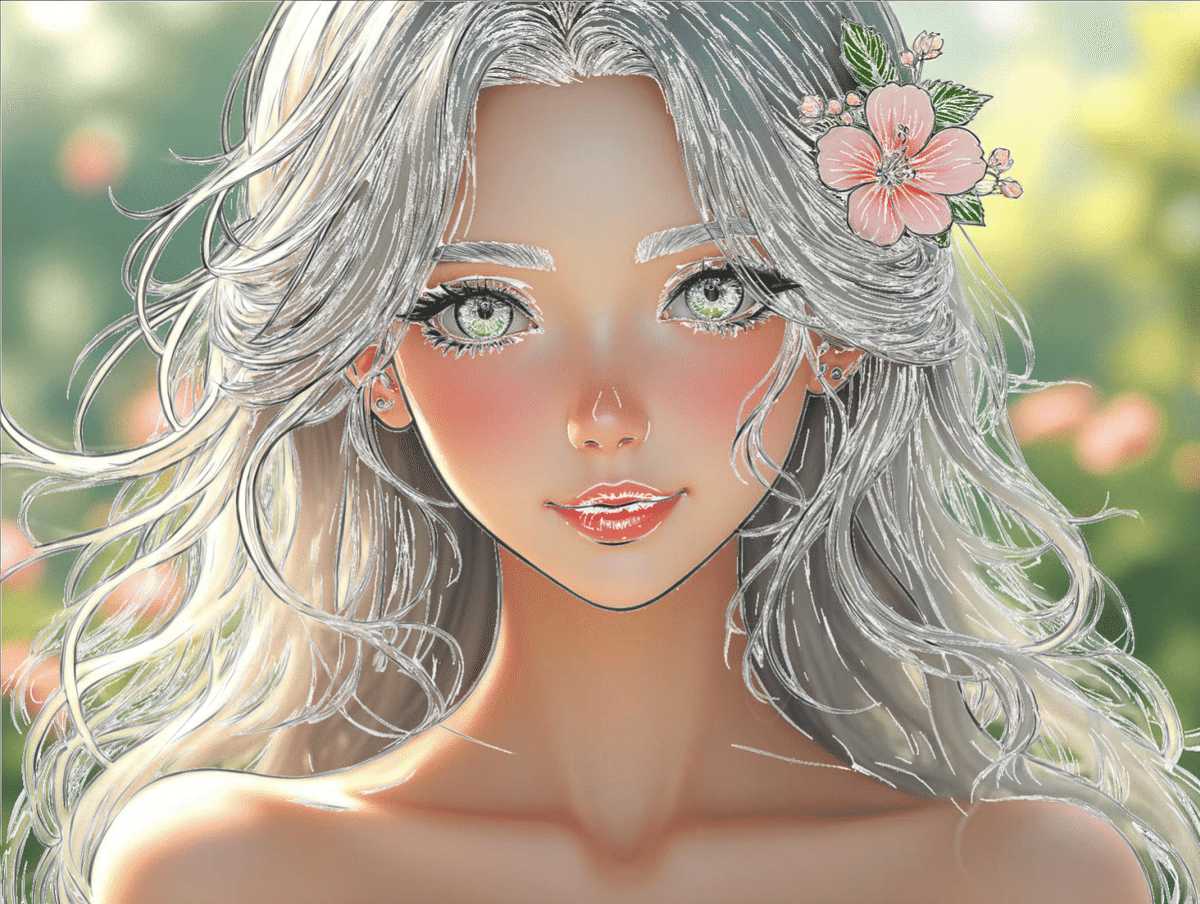

Marukichi:もともと手でアナログアートをやっていたんです。でも時間がかかるので、だんだん、できなくなってきている。それが「AIでイラストを生成できる」という時代がやってきて、「好きなものをトンマナにしよう」と決めて、最近は「青色と眼鏡」でこだわっています。

――ほんとうに!青色と眼鏡、なんですね。ネットでの反応も共感が多く見られますね。

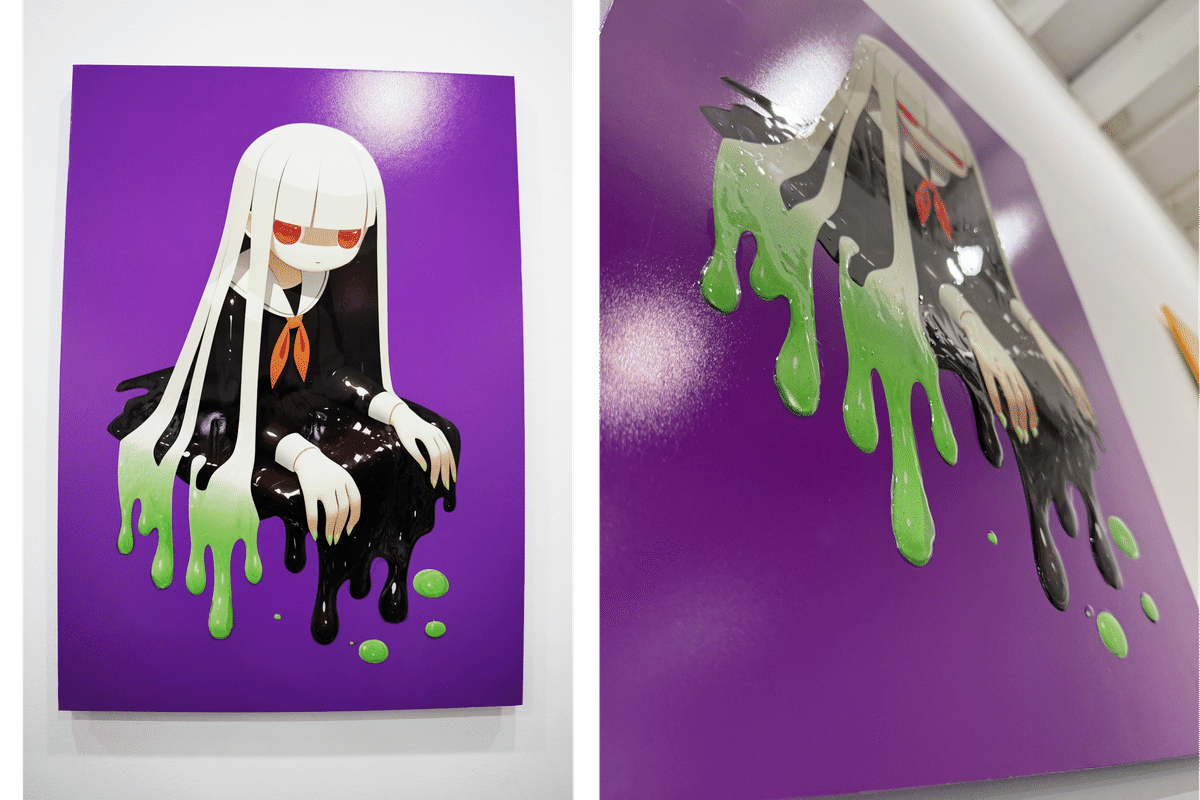

――廃材さんは、”普通のプリントではない作品”なのですね!?

廃材:アクリルの塗料を使って立体感を加えました。キャラクターの眼の部分など。これは、やってみて、お客さんからも反応が良かったです。

――廃材さん、いかがでした?社会に自分の物としての作品を発信してみた、ということなのですが。

廃材:ホント、一人ではできなかったと思うので、Sentakuさんには感謝です。

【お金、どれぐらいかかりました?】

―― 来場無料で開催されているのですが、クリエーター側はどのような費用感なのでしょうか?

Sentaku:ひとりおよそ2万円ぐらいかかっていますね。ギャラリーの場所代が6万円、印刷費用はA2サイズが1枚5,000円、といったところです。

―― ギャラリーも大判印刷もけっこうかかりますからね……。ちなみに印刷所についてもお聞きしていいですか?

Sentaku:今回は「ソクプリ」さんですね https://www.ooban-senmon.com/

廃材さん:私は実はたくさん失敗しているので、もっとかかっていますね。

―― ああ~!でもそれってたぶん「上手になっても何度もプリントして品質あげちゃうやつ」ですよね……僕も写真出身なのでわかります……!!!

やってみる前は「不安」、やってみたら「みんなあたたか」。

―― 来場された方々の反応はいかがでしたか?

Marukichi:一言でいうと、やって見る前は「不安」、やってみたら「みんなあたたか」、という感じです。来場された方々にも、画像生成でイラストレーションを作っている方々も多くいらっしゃって、「こうやってます」と、変に自分を隠す人もいないし、むしろ「アピールされた」という感想があります。作ってる中の人のことを聞きたい、みんな「やりたい人はたくさんいるんだな」、それを肌で感じました。

―― それはおもしろいですね(笑)

Sentaku:AIアートに対する批判もあるかと思ったのだけど、「なんかいい」に共感する方、共通することが多くて。これこそがアートだと思いました。

「なんで呼んでくれなかったんですが」とか、「次は声かけてください」とか言ってくださって。それがうれしかった。みんな表現したいんだ、とか「実物を通して伝わったんだ」と思いました。

―― 一番大変だった事って何ですか?

Sentaku「この企画を、とにかく、成立させるんだ!」……これをメインに考えていましたね。全部が初めてだったので。(お客さんが)AIイラストを見た人がどう感じるのか。AIで、デジタルだったものを、物体化してみんなに見せるってことが一番大変だったことかもしれない。

(僕は仕事柄、AI クリエイターの人たちをたくさん見てるところもあるのですが)ソロでやっている方は「心理的不安」みたいな「まだ同人誌レベルには一般化していないかも」といった不安がある中で、「やる前 、やった後」つまり、やる前は『すげえ 大変だ』と思ったけど、やってみたら『いい話』といったエピソードってありませんか?

廃材:深川ガレージ(Fukagawa Garage)さんが、ギャラリーの道路沿いに大きな看板を出してくださって……これを見て来場された方々がいらっしゃいました。「開催した」ってことに、価値があると思っています。

AIアートがギャラリーイベントを通して社会との接点を得る瞬間をみた

―― 白井:ネットで出会いようのない人たち、「深川ガレージでしかありえなかった出会い」とか、いただいた意外な感想とか 、あれば。

Marukichi:サラリーマン、仕事帰り、という感じの方が写真を撮ってふむふむ、という感じで帰っていた。そういうのもいいとおもいました。

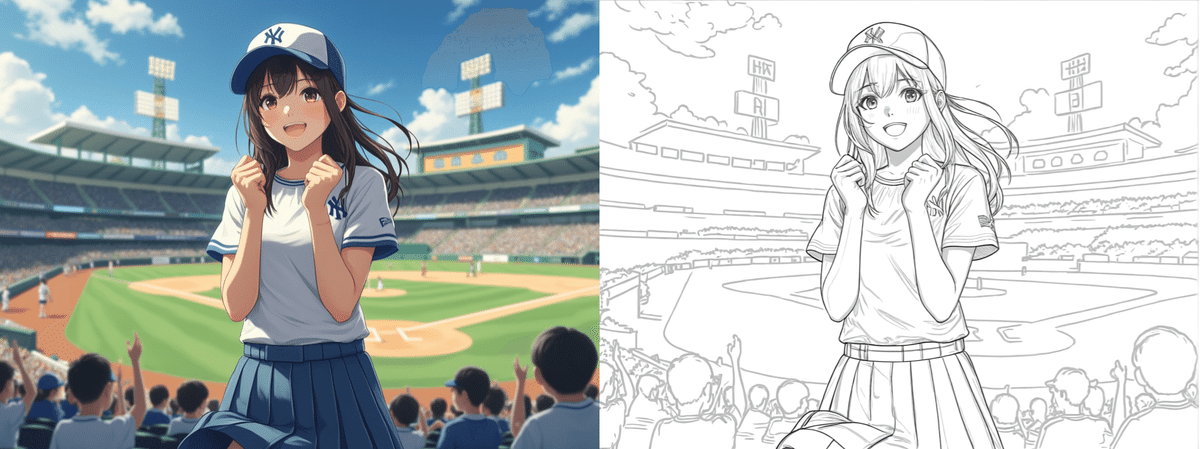

Sentaku:オーナーさんの娘さん(未就学児か小学校低学年ぐらい)が見に来てくれたのが嬉しかったですね。で、「かわいい!」「かわいいけど女の子ばっかり!」って。

―― あるあるですね(笑)!女の子じゃないの モチーフにしたらどうなんだろう? みたいな発想はまさに「社会に作品を出してみて初めて気づく新たなチャレンジ」みたいな感じで尊いですね。

『AIアートがギャラリーイベントを通して社会との接点を得ていく瞬間』みたいな……。

Sentaku:プロジェクターを使ってPCの映像を写して…ということもやっていました。その場でNijiJourneyをいじってみたりしてみました。その後、お客さんが「NijiJourneyはじめました」って言ってくれたりもして。

―― なるほどそういうワークショップとか需要ありそう。AICUとしてはぜひ 提供したいですね。

廃材:スクリーンさえあれば、リアルタイムで飾れるわけですよね。AIアートならではの展示方法もありそう。

―― さいごに告知等ございましたらどうぞ!

Sentaku:Sentaku 、廃材、marukichiの3人が「第3回 オオカミの森」展の東京開催にAIイラストを出品します。販売もあります。

アートで紡ぐ『オオカミ』の新たな物語

https://forest-of-wolf.crywolves.net

🐺第3回「オオカミの森」東京開催🐺

日時:11/5(tue)~11(mon)

場所:西武渋谷展 B館5階

時間:10:00~20:00

『オオカミ』ってこんなにもカッコよくもあり、愛らしい存在だと知ってほしい!

そして、日本から姿を消したオオカミが帰ってこれる森を創っていく。

そんなきっかけになるイベントを目指しています。

オオカミ好きのクリエーターたちが創る、オオカミ関連のアート、グッズ、雑貨などの作品が一堂に集結するPOPUP。

おもしろそうな展示会ですね!しかももうすぐ開催ですね!これは楽しみです。

Sentakuさん、廃材さん、marukichiさん。お忙しいところロングインタビューにご参加いただき本当にありがとうございました!

AICU mediaは「つくる人をつくる」を応援しています。

展示会やクリエイティブAIイベントの告知や開催レポートの掲載ご相談・ご出稿はこちらのフォームか、 X@AICUai までお問い合わせください。

☆こちらの記事はAICU media編集部の方針で期間限定無料配信とさせていただきます

印刷版「AICU Magazine Vol.6」に収録予定です。

https://ja.aicu.ai/mag

もちろん本記事をご購入いただく事は歓迎です!

☆シェアしていただいたほうが嬉しいです☆

この記事の続きはこちらから https://note.com/aicu/n/nb669d5eca8f6

Originally published at https://note.com on Oct 31, 2024.