2024年7月22日、Stability AI が「Stable Audio Open」の研究論文をリリースしました。

「Stable Audio Open」というタイトルで 論文プレプリントサイト arXiV に 7月19日付けで投稿された論文は、

オープンな生成モデルはコミュニティにとって非常に重要であり、ファインチューニングを可能にし、新しいモデルを提示する際のベースラインとして役立ちます。しかし、現在のほとんどのテキスト音声生成モデルは非公開であり、アーティストや研究者がその上に構築することはできません。ここでは、クリエイティブ・コモンズのデータで学習させた新しいオープンウェイトのテキスト音声モデルのアーキテクチャと学習プロセスについて説明します。我々の評価では、このモデルの性能は様々なメトリクスにおいて最先端のものと遜色ないことが示されています。特に、報告されたFDopenl3の結果(世代のリアリズムを測定)は、44.1kHzでの高品質なステレオサウンド合成の可能性を示しています。

https://arxiv.org/abs/2407.14358

Translated by AICU

この研究論文では、Creative Commons データを使用してトレーニングされた Stability AI の新しい”オープンウェイトなテキストオーディオ”(open-weights text-to-audio)モデルのアーキテクチャとトレーニングプロセスについて解説しています。

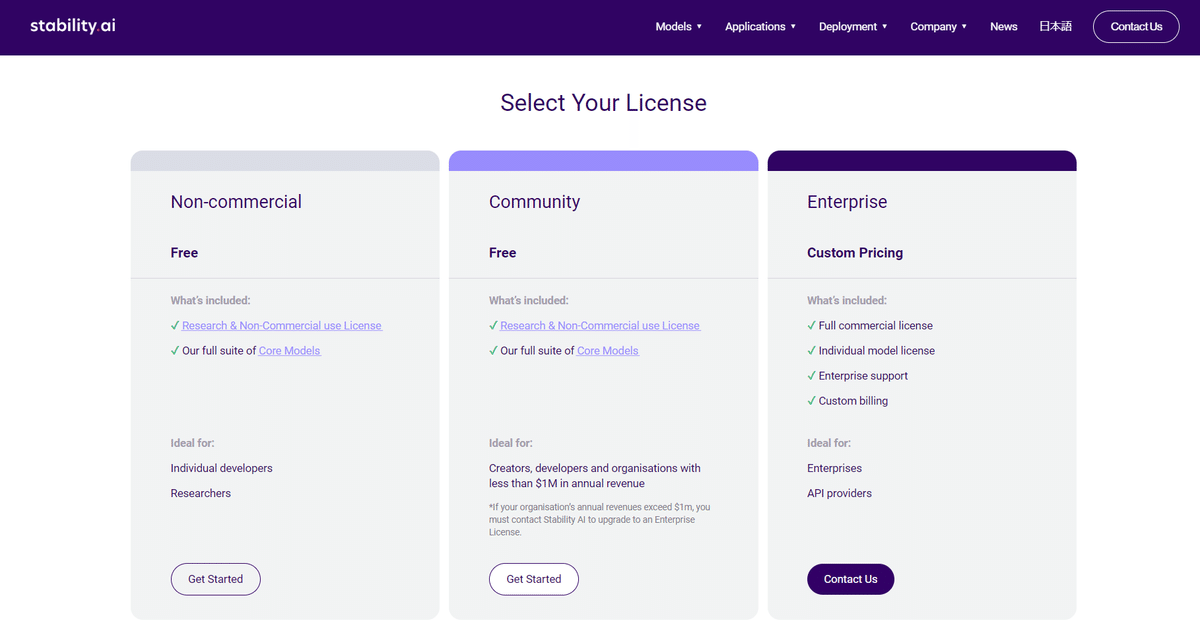

このオープンなモデルは Hugging Faceで公開されています。このモデルは Stability AI Community Licenseに基づいてリリースされており、年間収益(annual revenue)が 100 万ドル以下の個人または組織による非商用および商用利用が可能です(エンタープライズ ライセンスについては問い合わせ)。

・このモデルは、テキスト プロンプトから 44.1kHz の高品質ステレオ オーディオを生成でき、リアルなサウンドやフィールド録音を合成するために使用可能。

・Stable Audio Open はコンシューマーグレードの GPU 上で実行されるため、学術目的や芸術的なユースケースに利用可能。

アーキテクチャ

Stable Audio Openは、3つの主要コンポーネントを備えたテキスト音声モデルを導入しています:

・管理可能なシーケンス長に波形を圧縮するオートエンコーダ

・テキスト調整のためのT5ベースのテキスト埋め込み

・オートエンコーダの潜在空間で動作するトランスフォーマベースの拡散モデル(DiT)。

このモデルは44.1kHz、最大47秒の可変長ステレオ音声を生成します。オートエンコーダは21.5Hzという低い潜在レートを達成し、音楽やオーディオに対応できます。Stable Audio Openは(2024年4月3日に公開された)Stable Audio 2.0の亜種ですが、異なるデータセット(Creative Commonsデータ)で学習されています。このアーキテクチャは似ていますが、CLAPの代わりにT5テキストコンディショニングを使用しています。

学習データ

Stable Audio Openは、CC-0、CC-BY、またはCC-Sampling+でライセンスされた約50万件の録音を使用してトレーニングされました。このデータセットは、Freesoundの472,618件とFree Music Archive (FMA)の13,874件から構成されています。

著作権で保護された素材が含まれていないことを確認するため、このコンテンツは、PANNs audio taggerを使用してFreesoundの音楽サンプルを特定することにより、慎重にキュレーションされました。特定されたサンプルはAudible Magicのコンテンツ検出会社に送られ、データセットから著作権で保護されている可能性のある音楽を確実に削除しました。

ユースケース

Stable Audio Openは、生成されるコンテンツの長さを調整したり、様々な業界やクリエイティブなプロジェクトの正確なニーズを満たすなど、音声生成をカスタマイズするために微調整することができます。ユーザーは、A6000 GPUを使ってローカルでモデルをトレーニングできます。プロンプトの作成については、Stable Audio 2.0のヒントをご覧ください。

ここでは、このモデルをすぐに使用したり、微調整したり、ワークフローに統合したりするためのアプリケーションの例をいくつか紹介します

🎧️ぜひとも公式サイトで音源をきいてみてください📢

https://stability.ai/news/stable-audio-open-research-paper

サウンドデザイン

サウンドエフェクトとフォーリーエフェクト(音効)

足音、ドアのきしみ音、環境音など、映画、テレビ、ビデオゲーム、ゲーム開発に使用できる効果音を生成します。

アンビエントサウンド

シーンのムードや雰囲気に合ったサウンドスケープや背景テクスチャを作成できます。

サンプル作成

音楽トラックを制作するためのドラムループと音楽サンプルを生成します。

商用およびマーケティング用途

オーディオブランディング

広告用のサウンドエフェクトを作成したり、オーディオロゴやブランドサウンドを開発し、カスタムオーディオエレメントを通じてブランドの認知度やアイデンティティを高めます。

教育と研究

学術プロジェクト

オーディオ合成、機械学習、音楽学の研究にこのモデルを使用し、生成されたオーディオの実験と分析を行います。

このデモでは、より多くの例と、Stable Audio Openのパフォーマンスが他のモデルとどのように比較されるかを見ることができます。

Google Colabでの実験

まず Stability AI の非商用/コミュニティライセンスを取得します。

https://stability.ai/community-license

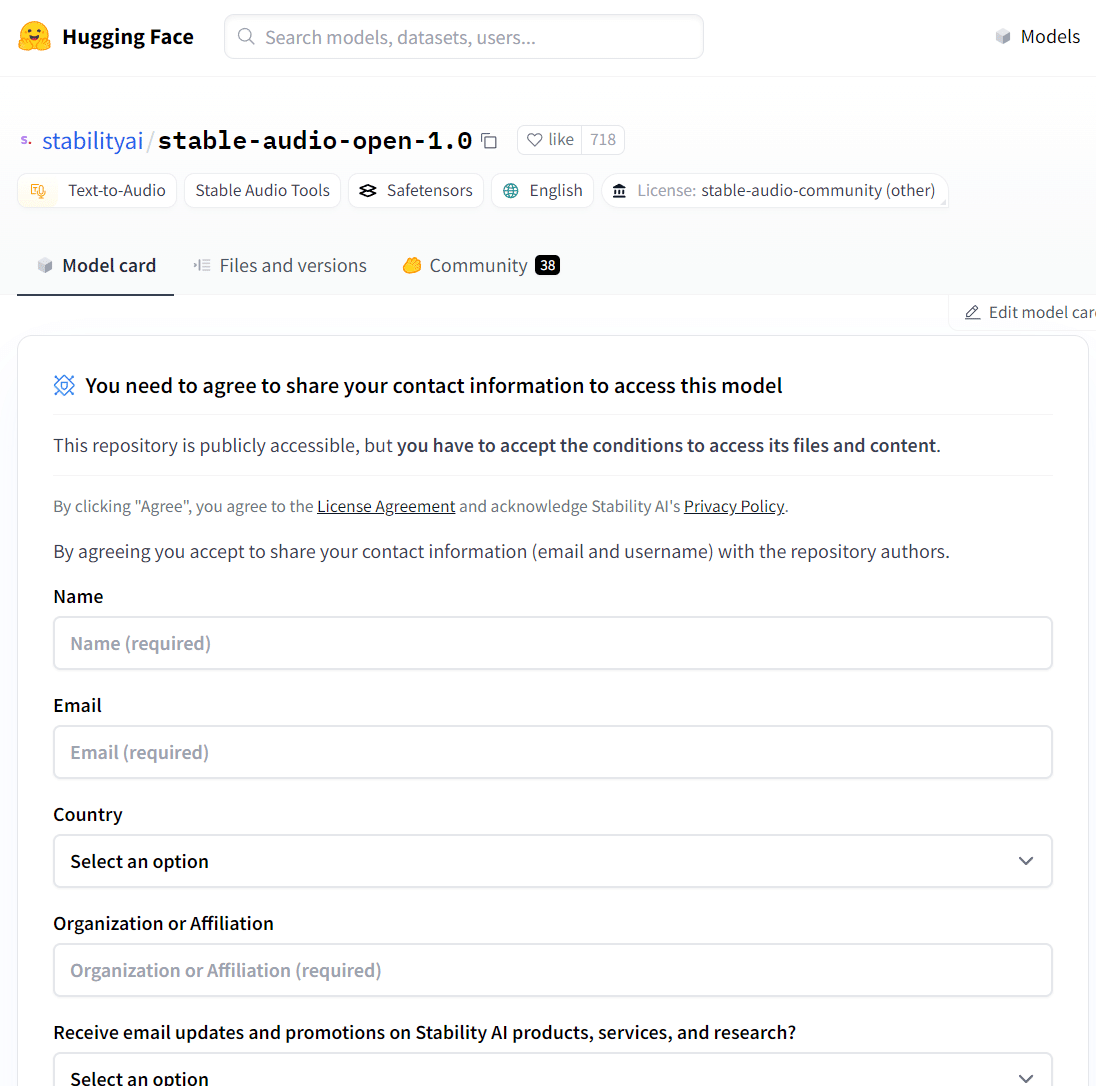

続いて、 Hugging Face 上のStable Audio Open の公開ページでライセンスを取得します。

https://huggingface.co/stabilityai/stable-audio-open-1.0

ご注意:商用利用の場合は、https://stability.ai/license をご参照ください。 sai@aicu.ai でもご相談をお受けいたします。

公式サンプルをGoogle Colab環境で動作確認したAICU版のコードをこちらで公開しています。

https://j.aicu.ai/StableAudioOpen

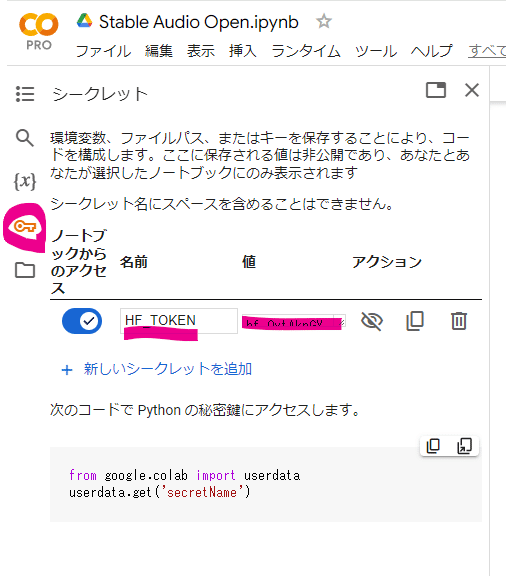

次に Hugging Face のトークンを取得します。

https://huggingface.co/settings/tokens

Google Colabのシークレットに設定します。

あとは実行するだけ!長さや冒頭の空白も設定できます。

# Set up text and timing conditioning

conditioning = [{

“prompt”: “128 BPM tech house drum loop”,

“seconds_start”: 0,

“seconds_total”: 30

}]

サンプルコードのデフォルトプロンプト

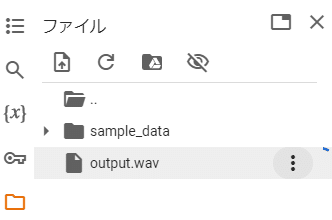

output.wav として生成されているので、ダウンロードして聴いてみましょう。

以下は実際に生成した例です。

“128 BPM NES, 8 bit action game BGM”

https://note.com/api/v2/attachments/download/b514ac0f4d7a059a04bf6e632f0b73c5

“128 BPM techno pop”

https://note.com/api/v2/attachments/download/7b6626ad5756ddc578dd2d64e096afcd

“sound of the rain hitting the roof”

https://note.com/api/v2/attachments/download/4de4c04ba8f4de31f955b71b64fb60a2

“blackbird song in a forest”

https://note.com/api/v2/attachments/download/6d912ec9ae69b5622d5d0e9a80a81478

“chorus lalala…”

https://note.com/api/v2/attachments/download/e9e21ea17beeb981eaa9cf1a70679a98

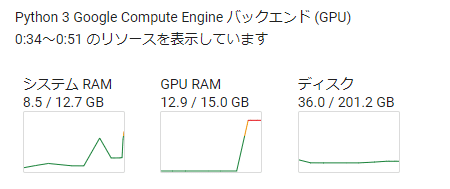

最長生成秒数は47秒のようです。GPU消費は16GB以下です。

学習元が Creative Commons であるということを考えて生成するとよいのかもしれません。それにしても「何回生成しても無料」というのはすごいですね。

まとめ

Stable Audio Openのリリースは、オープンソースのオーディオ生成AIにおける重要な一歩になると考えます。44.1kHzで高品質のステレオサウンドを生成し、コンシューマー規模のGPUで動作し、データの透明性に重点を置いています。このモデルの使いやすさとパフォーマンスにより、研究者とアーティストの両方にとって価値あるツールとなり、オープンなオーディオAIで可能性と限界を押し広げると考えます。

この記事がよかったら、シェアとフォローよろしくお願いいたします!

https://note.com/aicu/m/m6000f560d1db

Originally published at https://note.com on July 22, 2024.